0 引言

传统的目标检测算法,多是使用不同大小的滑动窗口在待检测图片上产生大量候选区域,对每一候选区域提取方向梯度直方图(histogram of oriented gridients,HOG)、尺度不变特征变换(scale-invariant feature transform,SIFT)等特征,最后利用训练完成的分类器进行分类。这种方法提取的特征泛化性不强,且滑动窗口计算开销大,在大量、多类目标检测中效率较低[3]。随着计算机硬件的发展以及大数据时代的到来,卷积神经网络(convolutional neural network,CNN)迎来了发展的高峰。2012年,Krizhevsky等[4]提出的AlexNet使用CNN大幅提高了图像分类的准确率,随后,国内外学者针对扩增网络深度以及解决由此产生的过拟合、计算量大、网络性能退化等问题,提出了VGG,Inception和ResNet等深度卷积网络,在图像分类的应用中得到了很好的反响[5]。

基于CNN在特征提取方面的优越性,有学者提出将其应用于目标检测中。然而,在识别图像中目标种类的同时,还需要用检测框准确标定目标在图像中的位置。为了解决这一问题,Girshick等[6]提出了区域卷积神经网络 (regions with CNN,R-CNN),相比于传统的目标检测算法,检测精度和检测效率都得到了提高,但也存在占用的磁盘空间较大、训练时间成本大、训练步骤繁琐等问题[7]。为此,学者们进行研究并相继提出SPP-Net [8],Fast R-CNN[9]和Faster R-CNN[10]等目标检测方法。R-CNN系列检测方法称为二阶目标检测法,需要先获取候选区域,再对每个候选区域进行分类,尽管在检测精度和检测速度上逐步完善,但是其计算量仍然很大。为了实现实时目标检测,学者们提出并发展了一阶目标检测法,如: YOLO [11]和SSD[12]等,显著提高了检测速度,但在检测精度上难以超越二阶目标检测法的检测水平。目标检测训练过程中正样本数量远小于负样本数量,二阶目标检测法会先区分前景和背景,并采用非极大值抑制算法抑制掉一部分负样本,减小了正负样本数量的差距,但检测速度也因此降低,而一阶目标检测法直接对类别极不平衡的样本进行细分类,容易导致分类器训练失败。文献[13]指出正负样本不平衡是一阶目标检测法在精度上低于二阶目标检测法的主要原因,提出了RetinaNet兼顾了检测精度和检测速度。

高分辨率遥感影像背景复杂且冷却塔的尺度、位置、形态多样,给目标检测带来挑战。本文以RetinaNet为冷却塔目标检测框架,由于原始RetinaNet采用Focal Loss,通过计算所有样本的损失值并赋予不同的权重以解决正负样本不平衡的问题,但是需要较多的超参数调优。为解决该问题,引入文献[14]提出的无采样机制,通过使用初始化策略和调整分类损失权重来保持训练稳定性。

1 改进的RetinaNet冷却塔目标检测

1.1 RetinaNet框架

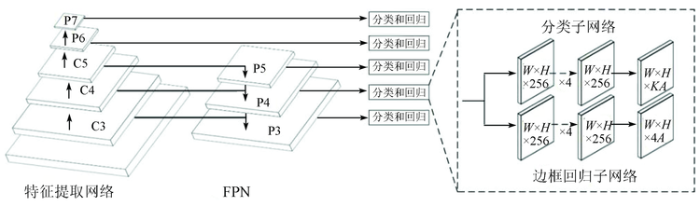

RetinaNet框架如图1所示。RetinaNet由特征提取网络、特征金字塔网络(feature pyramid networks,FPN)、分类子网络和边框回归子网络组成。使用 ResNet[15]作为特征提取网络,将卷积层conv3,conv4和conv5输出的特征图表示为{C3,C4,C5}。在ResNet架构上利用FPN来生成丰富的多尺度卷积特征金字塔,金字塔包括5层特征映射{P3,P4,…,P7},其中P3—P5是通过FPN中的自顶向下和横向连接对ResNet输出的C3—C5进行计算得到的,P6是在C5上进行卷积核为3×3,步长为2的卷积运算得到的,P7是通过在P6上应用ReLU以及卷积核为3×3,步长为2的卷积运算得到的。将低层位置信息与高层语义信息融合,从而增加检测效果的鲁棒性。在金字塔的各层特征图上,对于每个锚点生成尺度为{

图1

1.2 无采样机制

本文算法采用无采样机制,在解决训练中正负样本不平衡问题的同时避免较多的超参数调优,主要包括3个方案。

1.2.1 最优偏置初始化

在正负样本不平衡状态下,为了缓解梯度爆炸问题并加速模型的收敛,将分类子网络最后一层的偏置项b用先验概率

在训练初期,样本的置信度分数接近初始化的先验概率

式中: N为总样本数; Nf为正样本数; C为类别数。公式中第一项为前景,第二项为背景。

为了使

当

1.2.2 指导性损失函数

训练时负样本过多会导致模型倾向于将所有样本估计为负样本以获取极低的损失值。为了避免损失函数被众多负样本所支配,需要对分类损失和回归损失的权重进行调整。由于回归损失只计算正样本,不会受到正负样本不平衡的影响,所以可以通过回归损失来确定分类损失的调整比例r,即

式中:

则所有样本的总损失函数L为:

式中

1.2.3 类别自适应阈值

为了进一步提升模型效果,缓解因正负样本不平衡而引起的置信转移问题,对每个类别采用不同的过滤阈值以保留更多的正样本,第j类的阈值

式中Nj为第j类样本数。

2 实验与分析

2.1 数据集

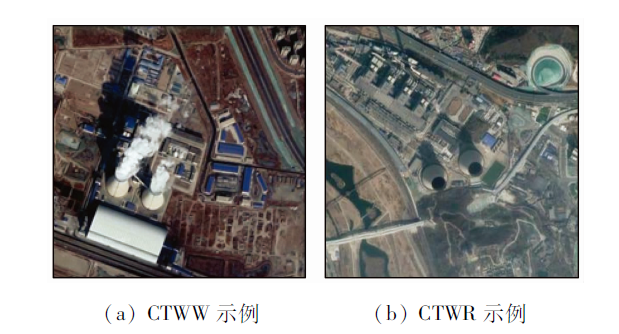

实验数据裁剪自谷歌影像,截取的图片均为双曲线自然通风冷却塔,使用开源图像标注软件LabelImg进行图像标注,标注方法与Pascal VOC数据集一致。数据集共1 200张图像,图像尺寸不一,如图2所示,检测目标包括工作中的冷却塔(cooling tower working,CTWW)和非工作中的冷却塔(cooling tower resting,CTWR)。每张图像包含的目标数不一,数据集中共1 450个CTWW目标,1 344个CTWR目标,目标角度、背景环境各不相同,给检测带来一定难度。

图2

2.2 模型训练

将数据集按8∶2随机划分为训练验证集和测试集。实验基于10 GB内存的I5处理器,结合NVIDIA GTX 1060(6 GB显存)图形处理器(graphics processing unit,GPU),在Ubuntu16.04系统上搭建CUDA9.0和CUDNN7.5的GPU运行环境,采用Pytorch深度学习框架训练模型。训练时先构建基于迁移学习的模型,使用在ImageNet数据集预训练的ResNet50模型对权重进行初始化。在正负样本匹配中,设置重叠率(intersection over union, IoU)阈值生成正负训练样本,把IoU超过0.7的候选框记为正样本,小于0.3的记为负样本。在无采样机制的参数设置中,

2.3 评价指标

本文采用平均准确率(average precision,AP)和平均准确率均值(mean average precision,mAP)作为冷却塔检测精度的评价指标。AP是召回率在0~1之间的准确率均值,可以准确地衡量模型对单类目标的检测效果; mAP是不同类间AP的均值,其数值越接近1说明模型在全类别中的检测性能越好。其中,准确率P和召回率R的定义分别为:

式中: TP为真正样本; FP为假正样本; FN为假负样本。

为了全面评价模型的性能,比较模型在测试集中检测单幅图像的平均检测时间来评估检测速度。

2.4 结果分析

利用本文算法在冷却塔测试集上进行检测,并与其他常用算法对比,包括传统目标检测算法的词袋模型(bag of words,BoW)和HOG算法以及基于CNN的Faster R-CNN,SSD和RetinaNet算法,实验结果如表1所示。

表1 冷却塔目标检测结果对比

Tab.1

| 方法 | AP/% | mAP/% | 速度/ (s·张-1) | |

|---|---|---|---|---|

| CTWW | CTWR | |||

| BoW | 26.51 | 21.12 | 23.82 | 22.402 |

| HOG | 58.51 | 50.46 | 54.49 | 17.180 |

| Faster R-CNN | 97.74 | 90.48 | 94.11 | 0.109 |

| SSD | 90.73 | 89.66 | 90.19 | 0.046 |

| RetinaNet | 97.85 | 92.77 | 95.31 | 0.054 |

| 本文算法 | 98.69 | 93.55 | 96.12 | 0.049 |

由表1可知,对于高分辨率遥感影像冷却塔目标检测,本文算法相比其他算法在保证实时检测的同时提高了检测精度,证明本文算法的有效性。相比BoW和HOG,表1中基于CNN的算法的检测效果都具有明显优势。BoW使用SIFT[17]提取特征,由于冷却塔没有明显的角点,SIFT无法提取有用的特征点,因而BoW检测精度较低; HOG[18]是在网格密集且大小统一的细胞单元内进行计算,并且采用了局部对比度归一化,所以HOG的mAP值比BoW高了1倍多,但对于遥感影像中的复杂背景,2种传统方法的特征提取能力都不及CNN。与Faster R-CNN和SSD的检测效果进行比较,RetinaNet兼顾了检测精度和检测速度,这是因为RetinaNet采用一阶目标检测法中直接在特征图上进行预测的策略,并使用Focal Loss解决训练中正负样本不平衡的问题,在保持一阶目标检测法的速度优势的同时大幅提高了检测精度。相比原始的RetinaNet算法,本文算法的mAP值提升了0.81百分点,检测速度提升了0.005 s,说明无采样机制在提升RetinaNet对正负样本的调节性能的同时可以减少计算损耗。对比表1中各算法对CTWW和CTWR的检测精度,检测CTWW的AP值明显高于CTWR,这是由数据集中各类样本数量不均衡导致的。

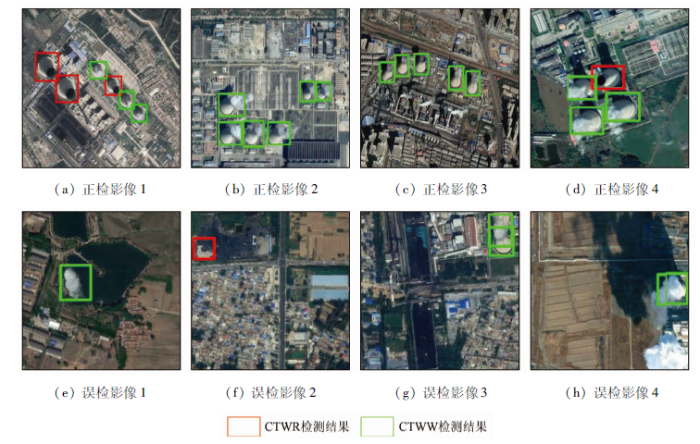

图3

图3

冷却塔测试集上的目标检测结果

Fig.3

Object detection results on the cooling tower test set

图4-1

图4-1

遥感影像冷却塔目标检测结果

Fig.4-1

Results of cooling tower detection in remote sensing images

图4-2

图4-2

遥感影像冷却塔目标检测结果

Fig.4-2

Results of cooling tower detection in remote sensing images

3 结论

为解决传统算法在高分辨率遥感影像目标检测中检测精度不高、检测速度慢等问题,本文提出一种改进的RetinaNet目标检测方法。采用无采样机制替换原始RetinaNet中的Focal Loss,避免了较多超参数的调节并且解决了训练中正负样本不平衡的问题。实验结果表明:

1)CNN相比BoW和HOG等传统方法具有较强的特征提取能力,解决了传统方法提取的特征泛化性不强的问题。

2)RetinaNet结合一阶目标检测法和二阶目标检测法的优势,在冷却塔数据集上取得了不错的检测效果。

3)对于高分辨率遥感影像冷却塔目标检测,本文算法相比其他算法在保证检测速度的同时提高了检测精度,并且在较大图像分辨率的遥感影像中检测效果良好,证明本文算法的有效性和实用性。

本研究还需要继续尝试新算法以优化模型,提高冷却塔检测精度; 同时可以尝试样本优化,减小各类样本的数量差距,使模型在训练中充分学习目标特征,从而提升模型精度。此外,视频卫星[19]技术的出现为区域内冷却塔实时监测提供了新的契机,可基于本实验成果做进一步研究拓展。

参考文献

武汉大气能见度与PM2.5浓度及相对湿度关系的非线性分析及能见度预报

[J].

Study on the nonlinear relationship among the visibility,PM2.5 concentration and relative humidity in Wuhan and the visibility prediction

[J].

大气气溶胶散射吸湿增长特性研究进展

[J].

A review of the effects of relative humidity on aerosol scattering properties

[J].

深度卷积网络卫星图像水泥厂目标检测

[J].

Cement plant detection on satellite images using deep convolution network

[J].

ImageNet classification with deep convolutional neural networks

[C]//

基于Faster R-CNN的高分辨率图像目标检测技术

[J].

Research on high resolution image object detection technology based on Faster R-CNN

[J].

Rich feature hierarchies for accurate object detection and semantic segmentation

[C]//

结合Faster R-CNN的多类型火焰检测

[J].

Multi-type flame detection combined with Faster R-CNN

[J].

Spatial pyramid pooling in deep convo-lutional networks for visual recognition

[J].

DOI:10.1109/TPAMI.2015.2389824

URL

PMID:26353135

[本文引用: 1]

Existing deep convolutional neural networks (CNNs) require a fixed-size (e.g., 224 x 224) input image. This requirement is

Fast R-CNN

[C]//

Faster R-CNN:Towards real-time object detection with region proposal networks

[J].

DOI:10.1109/TPAMI.2016.2577031

URL

PMID:27295650

[本文引用: 1]

State-of-the-art object detection networks depend on region proposal algorithms to hypothesize object locations. Advances like SPPnet [1] and Fast R-CNN [2] have reduced the running time of these detection networks, exposing region proposal computation as a bottleneck. In this work, we introduce a Region Proposal Network (RPN) that shares full-image convolutional features with the detection network, thus enabling nearly cost-free region proposals. An RPN is a fully convolutional network that simultaneously predicts object bounds and objectness scores at each position. The RPN is trained end-to-end to generate high-quality region proposals, which are used by Fast R-CNN for detection. We further merge RPN and Fast R-CNN into a single network by sharing their convolutional features-using the recently popular terminology of neural networks with 'attention' mechanisms, the RPN component tells the unified network where to look. For the very deep VGG-16 model [3] , our detection system has a frame rate of 5 fps (including all steps) on a GPU, while achieving state-of-the-art object detection accuracy on PASCAL VOC 2007, 2012, and MS COCO datasets with only 300 proposals per image. In ILSVRC and COCO 2015 competitions, Faster R-CNN and RPN are the foundations of the 1st-place winning entries in several tracks. Code has been made publicly available.

You only look once:Unified,real-time object detection

[C]//

SSD:Single shot multibox detector

[C]//

Focal loss for dense object detection

[C]//

Is sampling heuristics necessary in training deep object detectors?

[EB/OL] (

Deep residual learning for image reco-gnition

[C]//

基于RetinaNet改进的车辆信息检测

[J].

Vehicle information detection based on RetinaNet

[J].

Distinctive image features from scale-invariant keypoints

[J].

Histograms of oriented gradients for human detection

[C]//

Space object detection in video satellite images using motion information

[J].