0 引言

船企作为卫星影像中的一种具有高阶语义特性的复杂场景,常规遥感分类识别方法无法充分利用船企场景特征,难以取得理想的结果。本文综合了船企的多尺度、多语义特征及空间关系特征进行船企场景充分表达,提出了一种结合空间约束的卷积神经网络多模型多尺度的船企场景识别方法。

1 造船企业特征

利用卷积神经网络识别船企前应先掌握船企的图像特征,建立船企解译标志、统计船企内部地物空间特征并了解船企分布情况,为后续样本集的制作、识别算法的研究提供参考。

1.1 船企解译标志

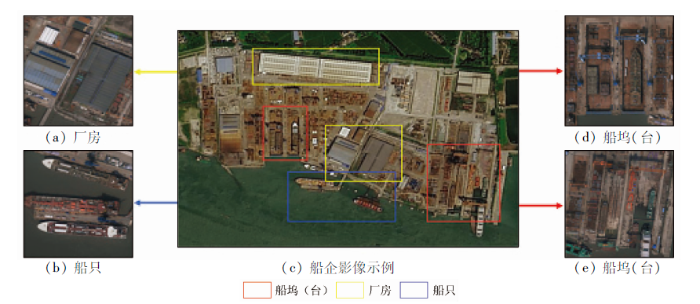

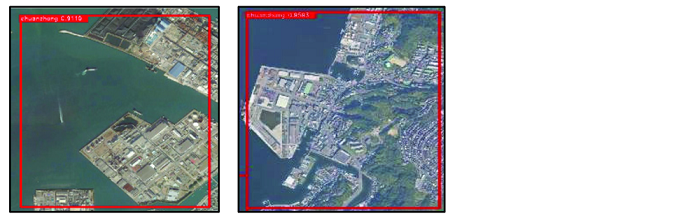

图1

表1 船企内部解译标志

Tab.1

| 地物 类型 | 解译标志 | |

|---|---|---|

| 船坞(台) | 是指修造船的专用场地,坞式或台式建筑物,主要分布在水陆交界的位置 |  |

| 船只 | 位于船坞(台)内或停靠在码头附近,从内部纹理可以明显看出还未构建完整,正在舾装、涂装 |  |

| 厂房 | 蓝色、灰色或白色的矩形建筑,排列整齐,有规则纹理,比普通房屋面积大,周围存在材料堆放 |  |

1.2 船企内部空间特征分析

1)船企建设面积统计。船企面积分布差异较大,最大的船企面积达6.8×106 m2,而最小的船企面积小于1×104 m2,占地面积在7×105 m2以下的船企数目占85%。

2)内部地物占地面积统计。对船坞(台)、厂房、船只3类重要船企内部地物进行分析与统计: 其中船坞(台)占地面积在5×104 m2以内的占97%; 在5×104~1×105 m2之间的为3%。厂房面积在5×104 m2以内占97%,而5×104~1×105 m2之间为3%。

3)内部地物空间距离统计。船坞(台)是船企内最核心的地物,能够反映船企的生产能力,是船企解译中具有唯一性的判别标志。因此,本文在建立内部地物空间关系时,以船坞(台)为基准,对船坞(台)与船只,船坞(台)与厂房的质心间的距离进行近邻分析,计算厂房、船只与船坞(台)质心之间的最近距离。

船坞(台)与厂房距离小于400 m的占93%,距离大于400 m占比7%; 船坞(台)与船只之间的距离小于400 m的占92%,距离大于400 m的占8%。

2 遥感图像船企场景识别理论

2.1 基准网络介绍

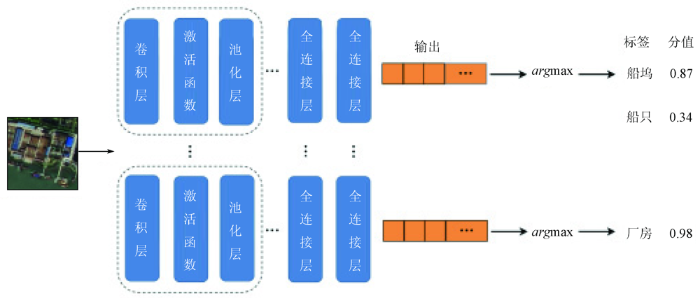

图2

2.2 多模型多尺度检测

船企内部地物之间分布密集,且形状不规则,因此不同类别样本存在重叠和相似。多个具有相似特征的样本一起训练时,会产生特征竞争现象,导致公用特征被某一类别独占,特征难以被充分利用,无法达到预期的类别检测效果。

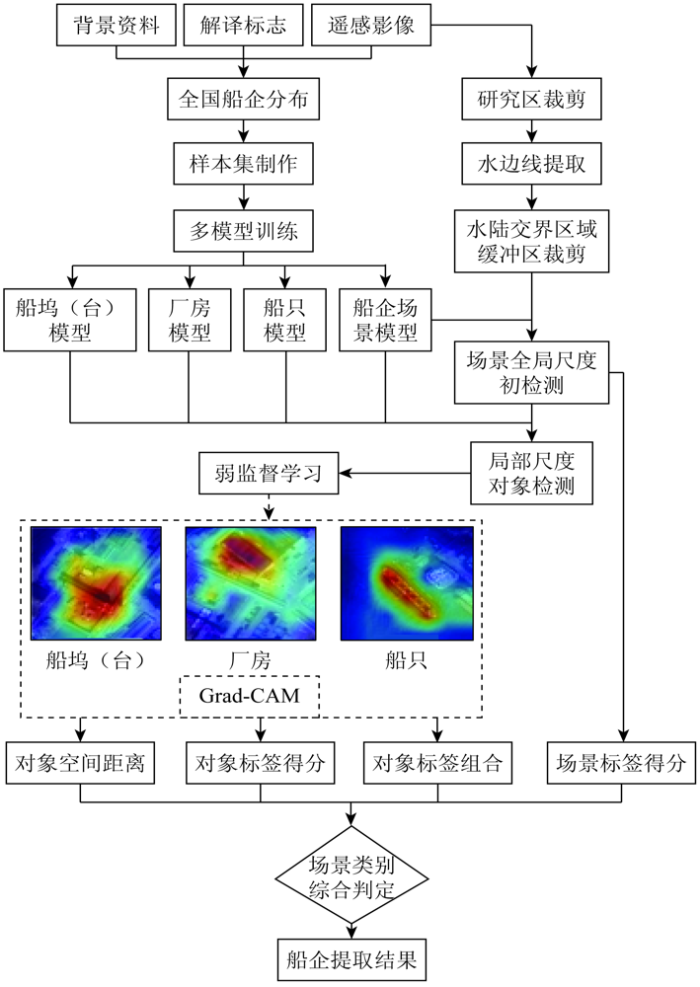

本文提出多模型多尺度船企场景识别方法。该方法基于全局尺度场景样本训练得到船企场景模型,在局部尺度下,分别采用船坞(台)样本、船只样本和厂房样本单独训练多个对象模型,对同一场景采用训练后的多个模型进行检测,避免类别得分被平均而导致漏检,如图3所示。

图3

2.3 多模型多尺度场景识别

本文采用全局尺度模型进行船企场景初检测,获取船企候选区域,并在候选区域内开展局部对象检测,得到各局部对象的粗略位置和语义标签。为提升场景识别的准确性,结合弱监督学习方法精化船坞(台)、船只和厂房在图像中的位置分布,计算各地物间的空间距离。最终结合多尺度模型检测结果、局部对象标签组合方式以及空间距离条件进行船企场景的综合识别。

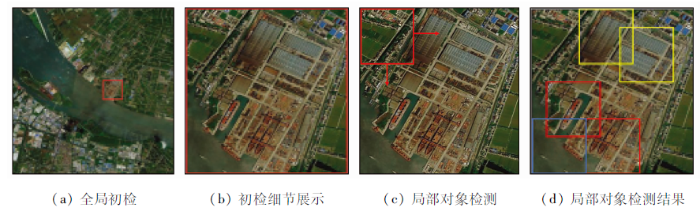

2.3.1 全局尺度初检测

为缩小船企检测范围,首先基于全局尺度船企场景模型在研究区进行初步滑窗检测,获取船企候选区域(图4)。

图4

图4

多模型多尺度船企识别流程

Fig.4

Multi-model and multi-scale shipbuilding enterprise recognition process

2.3.2 局部尺度精检测

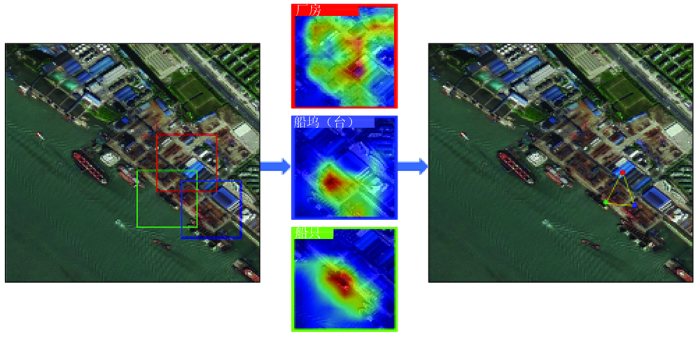

2.3.3 空间距离约束

将船企内部地物空间距离作为约束条件进一步提高船企场景的识别精度。为了获得较为精确的空间距离,应获取船企内部对象的位置信息。目前采用卷积神经网络获取位置信息的成熟算法主要基于强监督学习思想[16],需要提前大量标注目标位置的训练样本。但对于船企这一复杂人工岸线,其具有语义丰富、内部构造复杂、地物边界不清晰、形状不规则等特点,为船企场景样本加上范围和位置标注框的人力成本较高且具有主观性。如果标注者缺乏船企场景的专家知识,则难以保证目标框选的准确性。基于船企提取的实际需求以及样本标注的困难性,考虑到方法的适用性和实用性,强监督学习的目标检测并不是最合适的方法。

式中: z为该特征图中像元数量; yc为对应类别c的分数;

Grad-CAM的优点在于可以不改变网络结构来实现可视化,且应用十分便捷,可以直接扩展到任意训练完成的卷积神经网络中,对网络的训练过程没有要求。

基于深层网络的定位特性和Grad-CAM方法将对象所在的大致像素位置提取出来,开展空间距离约束。具体过程如图5所示,左图为船企初步识别结果。对其内部对象进行检测,分别检出厂房(红色框)、船坞(台)(蓝色框)、船只(绿色框),对检测出的局部对象进行可视化,获取类别响应区域中红色像元所在位置,据此进行船企内部不同地物的空间约束。

图5

2.4 场景综合评判和识别

结合场景多尺度标签得分、局部对象标签组合、局部对象空间距离约束3个决策条件对船企场景进行综合评判,并提取满足3类条件的区域,具体为:

1)多尺度标签得分。通过调低船企场景置信度阈值尽可能提取候选场景以避免漏检,实验中该阈值设置为0.8。设置较高的局部对象检测阈值进一步减少局部对象错检,实验中该阈值为0.95。置信度高于两种阈值的区域,符合船企场景的多尺度标签得分条件。

2)局部对象标签组合条件。局部对象组合方式会为场景分配不同类别标签,只有当场景内同时存在船坞(台)、船只和厂房标签,认为其满足船企标签组合条件。

3)局部对象空间距离约束条件。计算船坞(台)-船只和船坞(台)-厂房的空间距离,依据船企内部地物空间统计规律,当面积和地物之间的距离结果符合时,则认为满足对象空间距离条件。

3 船企场景识别流程

实验中计算机软硬件参数为: CPU为i7-8700,显卡为RTX2070,操作系统为Ubuntu16,框架为Pytorch1.1.0,编程语言为Python。

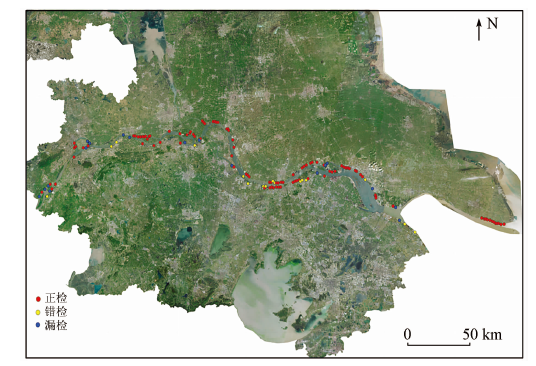

长江沿岸是我国船企集群程度最高的区域,因此,选择我国长江流域江苏段(范围E118°27'~121°57',N31°38'~32°22',总面积6 307 km2)为第一个实验区; 采用2018年资源三号融合后正射影像进行船企识别。为进一步验证方法的适用性,依据空间分辨率2 m左右的卫星影像,分别在日本和韩国选取造船业发达的区域进行识别实验。日本研究区为造船业较为发达的长崎县和爱媛县周边部分区域。其中,长崎县区域(简称日本研究区一)位于E129°42'~130°1',N32°39'~33°7'; 爱媛县区域(简称日本研究区二)位于E132°54'~133°45',N33°53'~34°21'。2个研究区总占地面积为5 472 km2。韩国研究区为木浦市和巨济市周边区域。木浦市区域(简称韩国研究区一),位于E126°13'~126°30',N34°33'~34°55'; 巨济市区域(简称韩国研究区二),位于E128°24'~129°3',N34°47'~35°12'。韩国2个研究区总占地面积为3 738 km2。

船企场景识别流程如图6所示,接下来对船企场景识别的整个实验流程进行介绍。

图6

3.1 样本集制作与影像预处理

首先进行样本集制作,充分利用现有基准数据集AID[19],NWPU-RESISC45[20],选择常见土地覆盖类型作为背景负样本。采用两类卫星遥感数据(资源三号和Google Earth 2 m分辨率遥感影像),依靠人工目视解译识别船企并制作船企正样本,包含全局船企场景样本、局部船坞(台)、厂房、船只样本。船企样本集制作充分考虑全国不同地区、不同格局、不同规模的船企的差异性,依据各地物大小不一,制作的样本大小不同,在输入网络时,进行处理,大小统一为224×224。样本数量如表2所示。对待检测试验区影像进行预处理,由于船企位于水陆交界区域,因此依据水边线进行缓冲区提取,剔除影像中大部分陆地区域。

3.2 多模型多尺度训练

1)样本划分与增强。样本的选取需要保证训练样本的数量,同时应考虑不同地域样本的差异性和多样性。为识别江苏省船企,训练模型时采用除江苏省外的全国船企样本集。国内外船企厂区内部地类具有高度相似性,因此为识别日本和韩国船企,训练模型时采用全国船企样本。在划分训练和测试样本时,按照8∶2的比例随机划分。对样本进行了随机翻转和随机旋转操作,并进行色调变化调整。

2)网络训练参数设置与结果。基础网络采用ResNet50,通过对在ImageNet数据集上训练收敛的ResNet50网络进行微调更新网络相关参数。运用基于动量的随机梯度下降方法,动量因子0.9,批处理大小为64,训练过程中迭代次数为200,采用交叉熵损失函数。学习率初始设置为0.000 1,并根据迭代次数和接近收敛程度调整学习率,每次调整将学习率减小10倍。表3为网络训练收敛后,船企场景、船坞(台)、厂房、船只4类地物的分类精确度、召回率、漏警率和虚警率结果。

表3 网络训练结果

Tab.3

| 指标 | 船企场景 | 船坞(台) | 厂房 | 船只 |

|---|---|---|---|---|

| 精确度 | 99.5 | 96.3 | 98.8 | 97.8 |

| 召回率 | 100 | 99.2 | 99.4 | 98.4 |

| 虚警率 | 0.5 | 3.7 | 1.2 | 2.2 |

| 漏警率 | 0 | 0.8 | 0.6 | 1.6 |

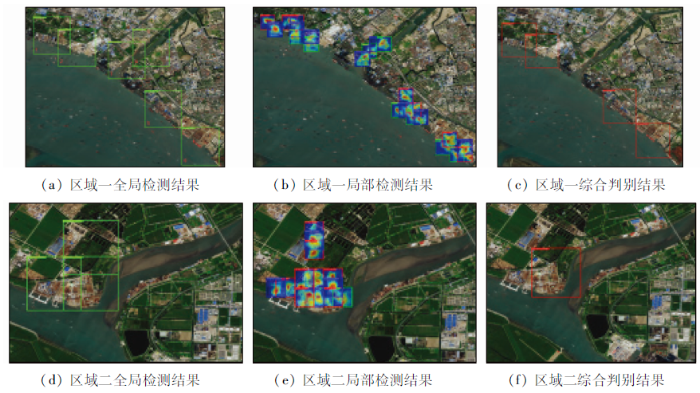

3.3 船企场景识别实验

通过训练获得4类模型: 船企场景模型、船坞(台)模型、船只模型和厂房模型。采用上述多个模型进行船企多模型多尺度检测,并采用弱监督学习的方法计算场景内部地物之间的空间距离,结合多个约束条件进行船企场景的综合评判与识别。图7—9为不同实验区的检测过程和结果。具体步骤如下: 依据1.2节的分析结果,采用2 m分辨率遥感影像进行船企识别时,将船企全局场景检测框长度设置在400~600像素之间; 局部对象检测框长度设置在100~200像素之间。为避免图像块切割导致场景特征被破坏,将滑窗移动步长设置的较小(长度约为局部对象检测框的1/3)。采用非极大值抑制方法将大面积重复的检测框删除。最后,采用结合场景多尺度检测标签得分、对象多标签组合方式和对象空间距离约束进行船企场景综合判别。

图7

图7

江苏省研究区域结果展示

Fig.7

Display of the results of the study area in Jiangsu Province

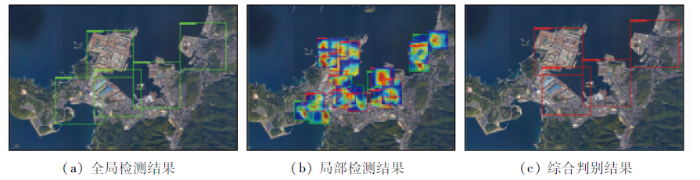

图8

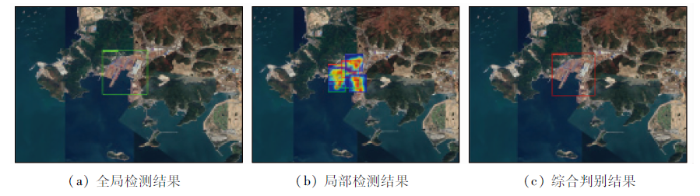

图9

4 实验结果分析

4.1 江苏省结果与精度

表4 基于不同基础网络模型的江苏省船企识别结果

Tab.4

| 基础网络 | AlexNet | VGG16 | ResNet50 |

|---|---|---|---|

| 精确度 | 46.63 | 42.36 | 87 |

| 召回率 | 73.17 | 69.92 | 85 |

| 虚警率 | 53.37 | 57.64 | 13 |

| 漏警率 | 26.83 | 30.08 | 15 |

图10

图10

江苏省船企分布的最终识别结果

Fig.10

Final recognition results of the distribution of shipbuilding enterprises in Jiangsu Province

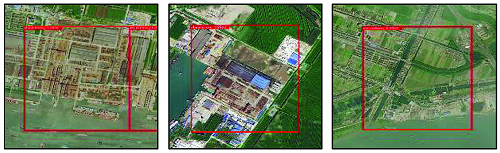

表5 江苏省船企识别结果细节展示

Tab.5

| 正检结果 | 大型船企 | 中型船企 | 滩涂船厂 |

|---|---|---|---|

| |||

| 错检结果 | 港口码头 | 沿海工厂 | 其他 |

| |||

| 漏检结果 | 中型船企 | 小型船企 | 滩涂船企 |

| |||

进一步分析,发现正确识别结果主要包含大中型船企以及特征较为明显的小型船企和滩涂船企; 错检结果主要为港口和沿海工厂; 漏检主要为特征不显著的中小型和滩涂船企。

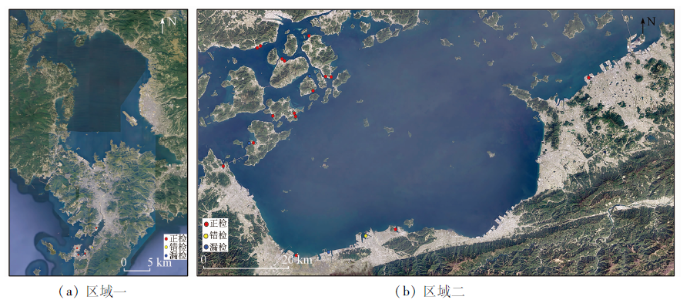

4.2 境外研究区域船企识别结果分析与精度评价

4.2.1 日本研究区域

图11

图11

日本研究区域的船企识别结果

Fig.11

The recognition results of shipbuilding enterprises in Japan study area

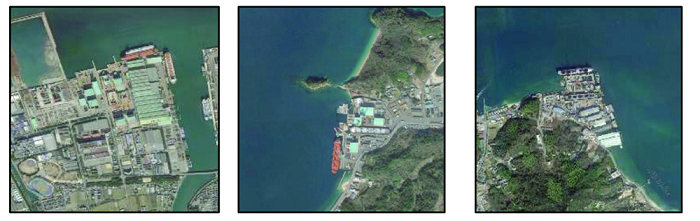

表6 日本研究区船企识别结果细节展示

Tab.6

| 正检结果 | 大型船企 | 中型船企 | 小型船厂 |

|---|---|---|---|

| |||

| 错检结果 | 沿海工厂 | 沿海工厂 | |

| |||

| 漏检结果 | 中型船企 | 小型船企 | 小型船企 |

| |||

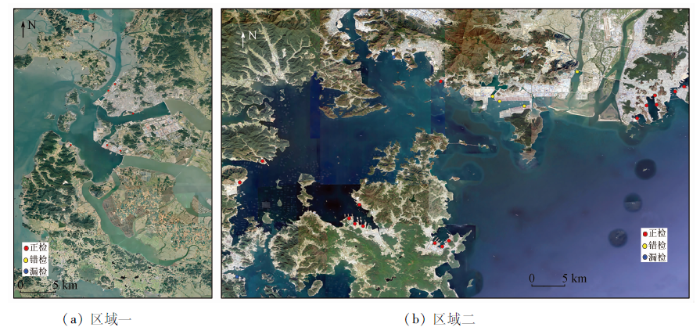

4.2.2 韩国研究区域

表7 韩国研究区船企识别结果细节展示

Tab.7

| 正检结果 | 大型船企 | 中型船企 | 小型船厂 |

|---|---|---|---|

| |||

| 错检结果 | 港口码头 | 沿海工厂 | 其他 |

| |||

| 漏检结果 | 小型船企 | 小型船企 | |

| |||

图12

图12

韩国研究区域的船企识别结果

Fig.12

The recognition results of shipbuilding enterprises in Korea study area

通过对日韩研究区域船企识别的结果分析,可知本文方法可以较好地对日韩区域进行船企识别。漏检和错检主要原因为: 船企内部空间距离、厂房色调等方面与国内存在差异,如国内船企厂房主要为棕色、白色和蓝色,而日本部分船企的厂房呈浅绿色; 同时,日韩研究区中少量船企建在岛屿上,空间布局较为独特。

5 结论

针对船企语义丰富、场景复杂的特点,本文充分利用了场景多尺度、多语义、空间布局信息,提出了一种结合空间距离约束的多模型多尺度船企场景识别方法。将该方法应用于国内外研究区域进行船企识别,实验结果证明了本文方法的可行性和有效性,提取的船企空间分布情况能够为政府产能调控、产业布局提供宏观决策依据。

参考文献

长三角船舶产业集群研究

[D].

Research on the shipbuilding industry cluster in the Yangtze River delta

[D].

中国船舶产业空间布局与发展策略

[J].

Spatial layout and development strategy of the ship-related industry in China

[J].

Multi-instance and multi-label learning

[J].DOI:10.1016/j.artint.2011.10.002 URL [本文引用: 1]

Deep multiple instance convolutional neural networks for learning robust scene representations

[J].DOI:10.1109/TGRS.36 URL [本文引用: 1]

An attribute-based high-level image representation for scene classification

[J].DOI:10.1109/ACCESS.2018.2886597 URL [本文引用: 1]

Graph convolutional network for multi-label VHR remote sensing scene recognition

[J].DOI:10.1016/j.neucom.2019.05.024 URL [本文引用: 1]

Multi-Label Image Recognition with Graph Convolutional Networks

[C]

Learning spatial relations and shapes for structural object description and scene recognition

[J].DOI:10.1016/j.patcog.2018.06.017 URL [本文引用: 1]

Beyond bags of features:Spatial pyramid matching for recognizing natural scene categories

[C]

Randomized spatial partition for scene recognition

[M].

Discovering Class-Specific Spatial Layouts for Scene Recognition

[J].DOI:10.1109/LSP.2016.2641020 URL [本文引用: 1]

Spatial pyramid pooling in deep convolutional networks for visual recognition

[J].DOI:10.1109/TPAMI.2015.2389824 URL [本文引用: 1]

Scene recognition:A comprehensive survey

[J].DOI:10.1016/j.patcog.2020.107205 URL [本文引用: 1]

Deep residual learning for image recognition

[C]

基于卷积神经网络的遥感图像飞机目标识别研究

[D].

Research on airplane target recognition in remote sensing images based on convolutional neural network

[D].

A brief introduction to weakly supervised learning

[J].DOI:10.1093/nsr/nwx106 URL [本文引用: 1]

Grad-CAM:Visual explanations from deep networks via gradient-based localization

[J].DOI:10.1007/s11263-019-01228-7 URL [本文引用: 1]

AID:A benchmark data set for performance evaluation of aerial scene classification

[J].DOI:10.1109/TGRS.2017.2685945 URL [本文引用: 1]

Remote sensing image scene classification:Benchmark and state of the art

[J].DOI:10.1109/JPROC.2017.2675998 URL [本文引用: 1]

ImageNet classification with deep convolutional neural networks

[J].DOI:10.1145/3065386 URL [本文引用: 1]

Very deep convolutional networks for large-scale image recognition

[J].