0 引言

遥感技术自上世纪中期兴起后高速发展,至今已有众多新兴传感器投入应用,遥感影像数据逐渐进入“高分时代”,大量高分数据为经济、国防、生态等各个领域提供数据支持。在遥感成像过程中,传感器、拍摄时间季节、光照条件、大气条件等差异都易导致拍摄影像内部、影像与影像之间出现亮度不均匀,色彩不一致的现象。这些问题不仅影响目视解译,更影响后续生产中影像之间的拼接效果。在实际生产工作中,生产人员往往需要花费大量的时间精力用于处理影像色彩不一致的问题。

目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象。现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] 。加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果。这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] 。确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法。乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] 。例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的。

尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩。这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力。随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求。基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力。目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等。如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾。其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正。与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练。

本文针对地物复杂的城区影像,首次提出一种无监督的自动匀色算法——加入通道注意力机制的循环一致生成对抗色彩网络(channel attention-CycleGAN, CA-CycleGAN),以期能够无监督地自动进行影像色彩改正,从而高效解决大量遥感影像色彩调整的问题。

1 研究方法

1.1 CA-CycleGAN

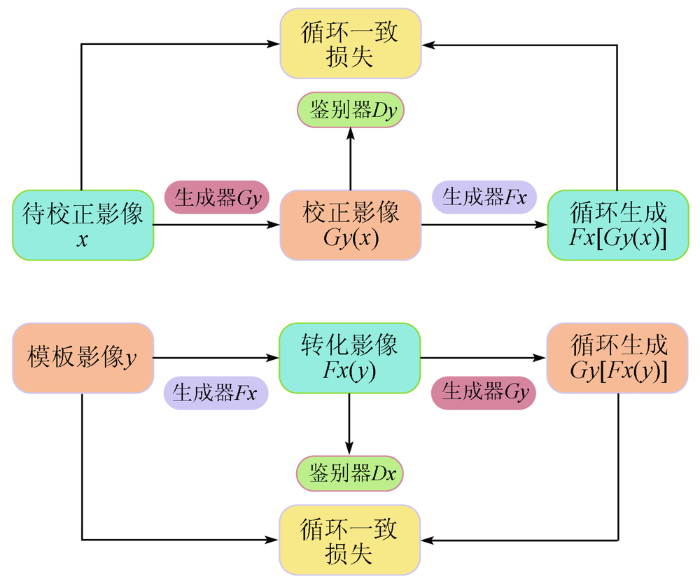

与CycleGAN一致,注意力引导的循环一致生成对抗网络仍然具有2对呈现环形闭合的生成器与鉴别器[28 ] (图1 )。第一阶段待校正影像x 通过生成器Gy 转化为校正影像Gy (x ),此时鉴别器Dy 对校正影像Gy (x )进行鉴别,生成器Gy 与鉴别器Dy 为一对对抗,通过互相对抗学习提高生成器Gy 的生成水平和鉴别器Dy 的鉴定水平。第二阶段通过生成器Fx 生成影像Fx [Gy (x )],待校正影像x 与循环生成影像Fx [G y(x )]之间计算影像的循环一致损失。第一阶段同时模板影像y 也会通过生成器Fx 转化为影像待校正影像域的影像Fx (y ),此时鉴别器Dx 对影像Fx (y )进行鉴别,生成器Fx 与鉴别器Dx 为另一对对抗,通过互相对抗学习提高生成器Fx 的生成水平和鉴别器Dx 的鉴定水平。并在第二阶段继续通过生成器Gy 生成循环影像Gy [Fx (y )],同样的模板影像y 与循环影像Gy [Fx (y )]之间将计算循环一致损失来控制生成和鉴别函数的学习。

图1

图1

注意力引导的CycleGAN原理图

Fig.1

Schematic diagram of attention guided CycleGAN

1.2 通道注意力

为了使网络能够更清晰地理解影像中哪部分信息更重要,在生成器中加入如图2 所示的通道注意力网络,其中Conv表示卷积层,ReLU表示ReLU激活函数。为了有效计算各通道权重,需要对输入的特征图空间维度进行压缩,同时采用平均池化和最大池化可以在对空间信息整合的同时收集到独特的影像特征。同时由于通道注意力网络简单,能够在较少增加网络复杂度的同时取得较好的优化效果,减少训练的时间复杂度。

图2

图2

通道注意力结构

Fig.2

Structure of channel attention

1.3 生成器与鉴别器

如图3 所示,生成器主要由编码器、注意力机制、残差块和解码器构成,其中编码器由3层卷积网络构成,Norm为标准化层,ReLU为激活函数,注意力采用上文介绍的通道注意力。由于本文测试集影像大小为256像素×256像素,残差块一共选用9个。解码器采用反卷积和卷积,将影像输出为与输入通道相同的RGB模式256像素×256像素大小的影像。最后一层激活函数为Tanh,鉴别器网络采用的是5层网络,将输入影像通道数减小,最后再进行平均池化提取影像特征,鉴别器中的激活函数为Leaky ReLU。

图3

图3

生成器和鉴别器网络结构

Fig.3

Network structure of generator and discriminator

1.4 损失函数

1)对抗损失函数。X →Y 与Y →X 的对抗损失分别为:

(1) L G A N ( G , D Y , X , Y ) = E y ~ p d a t a ( y ) [ l n D Y ( y ) ] + E x ~ p d a t a ( x ) { l n ( 1 - D Y [ G ( x ) ] }

(2) L G A N ( F , D X , Y , X ) = E x ~ p d a t a ( x ) [ l n D X ( x ) ] + E y ~ p d a t a ( y ) { l n [ 1 - D X ( F ( y ) ] }

式中: X 为样本数据集; Y 为参考影像域数据集;x ~ p d a t a ( x ) x 服从样本数据集的数据分布p d a t a ( x ) y ~ p d a t a ( y ) y 服从参考影像域数据集的数据分布p d a t a ( y ) X →Y 表示从X 到Y 的生成对抗过程; 在这个过程中,G 生成与参考影像域Y 相似色彩的图像G (x ),而DY 则区分生成的G (x )真实参考色彩样本y ,因此G 的目标是将函数L GAN (G ,DY ,X ,Y )最小化,D 的目标则是使函数L GAN (G ,DY ,X ,Y )最大化,即minG maxDy L GAN (G ,DY ,X ,Y )。

循环一致生成函数中同样存在类似的F (y )函数,因此对于y 向x 生成的过程存在相同原理的对抗损失函数。其中F 的目标是将函数L GAN (F ,DX ,Y ,X )最小化,Dx 则使函数L GAN (F ,DX ,Y ,X )最大化,即minF maxDx L GAN (G ,DY ,Y ,X )。

(3) L c y c ( G , F ) = E x ~ p d a t a ( x ) { ‖ F [ G ( x ) ] - x ‖ 1 } + E y ~ p d a t a ( y ) { ‖ G [ F ( y ) ] - y ‖ 1 }

由于CycleGAN采用的训练方式是无监督训练模式,并且输入样本并需要一一对应,因此能够将x 映射到y 的函数G (x )和能够将y 映射到x 的函数F (y )存在相当多种。循环一致性损失函数的意义在于减少映射函数的其他可能性,控制映射函数是循环一致的,确保训练得到的映射函数G (x )和F (y )不至于太离谱,生成器和鉴别器能够在后续训练中得到更好的优化。如上述公式所述,对于从x 生成G (x )并进一步生成F [G (x )]的过程,尽可能控制x 与F [G (x )]相差不大,约束F [G (x )]与x 的L1范数,即‖F [G (x )]-x ‖。同样地,对于y 生成F (y )并进一步生成G [F (y )]的过程,尽可能使得y 与G (F (y ))相差不大,从而约束生成函数G (x )和F (y ),使生成的影像与原影像差别较小。2部分循环一致性损失汇总则形成影像色彩校正网络的循环一致性损失函数值。

(4) L ( G , F , D X , D y ) = L G A N ( G , D Y , X , Y ) + L G A N ( F , D X , Y , X ) + λ L c y c ( G , F )

将式(1)和式(2)中的对抗损失函数和式(3)中的循环一致性损失函数按一定权重结合起来,就能够实现非成对影像的互相转换。其中λ

2 基于CA-CycleGAN的影像色彩校正实验和分析

2.1 研究数据

本文研究区域为湖南省长沙市部分地区,主要典型地物为房屋、道路、城区内绿化区和未绿化的裸土地等,影像数据选取高分二号(GF-2)2016年3月B3(R),B2(G),B1(B)合成彩色影像数据。研究中的色彩参考影像由原始数据经过直方图拉伸和Photoshop软件人工处理得到。将原始影像和色彩参考影像切割成256像素×256像素大小,并转为JPG数据,为训练做准备。训练样本中原始影像和色彩参考影像共计1 600×2张。验证数据集为遥感影像原始数据,共计12 800张。

2.2 实验和分析

训练集一共包含3 200张影像,分为待校正影像集和色彩参考集各1 600张,影像大小为256像素×256像素; 训练使用PyTorch1.4.0框架搭建深度学习框架。分别使用CycleGAN无监督和CA-CycleGAN对训练集影像进行训练,对比加入注意力机制后网络的改进效果。训练时不将训练集进行色彩偏移或随机翻转,为了提高网络的特征学习能力,无监督训练进行了200轮。经过测试,前100轮固定学习率为0.000 2,后100轮将学习率线性衰减到0,效果较好。为了验证本文方法的优越性,训练过程结束后,分别保存处理模型,并使用模型对待校正影像集和验证数据集分别进行影像校正,便于对比影像校正前和通过不同方法校正后的结果。不同方法色彩校正结果对比如表1 所示。

如表1 所示,无论是CycleGAN还是CA-CycleGAN在小区域内对影像的明暗度和色彩都有较好的改正,但可以看出经过CycleGAN校正的影像色彩较为分明,无论是植被还是黄土都明显有自己独特的颜色风格,并且建筑部分有稍微偏绿的情况。而CA-CycleGAN对影像色彩的校正上则有统一的颜色风格,整体较为协调。因为差距较小,在小范围上无太大影响,然而当小区域影像拼接为一幅大区域影像的时候,CA-CycleGAN整体一致的色彩风格使得影像更加协调统一,拼接痕迹较为不明显。

图4 为不同方法色彩校正后拼接效果示例。由图4 可以看出,影像1中的横向道路在经过CycleGAN色彩校正后,道路两侧由于在匀色过程中被切割成2个小幅影像而产生色差,拼接线明显,而通过CA-CycleGAN色彩校正后,几乎不可见道路两侧的拼接痕迹; 影像2中的纵向道路与第一景影像情况类似,同样在通过CA-CycleGAN色彩校正后,拼接痕迹几乎不可见,达到较为完美的拼接情况。影像3中的红色房子在经过CycleGAN的色彩校正后左右2部分红色明暗不同,而CA-CycleGAN可以完美地将红色房子的左右两侧调整为相同的色彩,仅表现为轻微拼接痕迹。影像4表示CycleGAN在处理较为空旷的地带色彩校正上效果并不稳定,也易出现明显色彩差异,导致拼接后影像有明显块状区域,而本文采用的CA-CycleGAN可以在一定程度上解决这一问题,使得影像不被分割的太明显。

图4

图4

不同方法色彩校正后拼接效果

Fig.4

Mosaic effect drawings after color correction by different methods

图5 为2种方法色彩校正的损失函数,其中D_A表示循环正向过程时的鉴别器损失值,G_A表示循环正向过程时的生成器损失值,cycle_A表示循环正向过程时文中式(3)中的循环损失,idt_A表示循环正向过程时文中式(1)中的对抗损失,D_B表示循环反向过程时的鉴别器损失值,G_B表示循环反向过程时的生成器损失值,cycle_B表示循环反向过程时文中式(3)中的循环损失,idt_B表示循环反向过程时文中式(1)中的对抗损失。

图5

图5

不同方法色彩校正的损失函数

Fig.5

Loss function of color correction by different methods

不仅在色彩调整效果上能直观地看出CA-CycleGAN的效果比CycleGAN优异,根据图5 的损失函数同样可以看出本文采用的CA-CycleGAN方法的损失函数收敛速度更快,整体收敛效果也更好。通过表2 可以看出,CA-CycleGAN在训练的最后一次迭代循环结果中,正向训练和逆向训练的生成器损失值(G_A与G_B)、逆向训练的鉴别器损失值(D_B)、正向训练和逆向训练的循环一致损失值(cycle_A与cycle_B)以及正向训练和逆向训练的单张影像总损失值(idt_A与idt_B)均小于CycleGAN方法的相应损失值,仅在正向训练的鉴别器损失值(D_A)这一项略大于CycleGAN的鉴别器损失值。由此也可认为本文采用的CA-CycleGAN色彩校正方法在影像色彩校正方向对CycleGAN方法有一定的改良。

图6 为使用本文方法进行色彩校正的验证数据集中部分影像,可以看出对于城区影像色彩校正效果较好,影像整体色彩鲜明,便于遥感影像的下一步加工和应用。本文方法不仅效果优秀,还大大提高了遥感影像色彩校正的效率,经过测试,对于单张256像素×256像素大小的影像数据,每分钟可完成约1 000景影像的色彩校正,对于整景空间分辨率约0.8 m,覆盖面积约800 km2 的GF-2数据,每景影像的切割、色彩校正、拼接整体操作时间在5 min以内,有效节约了影像色彩校正的人力成本和时间成本。

图6

图6

验证数据集色彩校正效果示例

Fig.6

Verify the color correction effect of the dataset

3 结论

本研究以长沙市城区GF-2卫星数据为例,提出了一种新的基于生成对抗网络的CA-CycleGAN影像色彩校正方法。

通过在原始CycleGAN的基础上加入通道注意力机制,构成引入注意力的ResNet结构的生成器,而鉴别器则采用pix2pix中的PatchGANs结构,生成器与鉴别器之间采用对抗损失和循环一致性损失进行约束,在处理GF-2城区影像色彩校正中取得较好的成果。

实验结果表明,相比于传统的需要人工操作的匀色方法,本文实现了遥感影像色彩校正的自动化,可以大批量进行影像匀色,节约人力资源。并且通过根据影像参考的季节和地物类型,可分别训练不同季节、不同区域的匀色模型。通过已经训练好的模型进行色彩校正时,对于切割好的256像素×256像素大小影像速度可以达到每分钟1 000景以上,每景GF-2影像的切割、色彩校正和拼接操作总时间小于5 min,大大节省了影像色彩校正时间。

本研究为遥感影像色彩处理方面提出了新的思路和方法,并对于影像去云雾、影像增强等方面也有一定的启发作用。本文所提出的影像色彩校正算法还有进一步的改进空间,所训练的模型仅使用于部分城区,下一步将其他季节以及其他地物类型分别训练不同模型,测试在不同气候、不同地区的情况下本方法的普适性,以及通过更好的色彩模板训练的情况下对本文方法的改进。

参考文献

View Option

[1]

金淑英 , 包更生 , 马洪超 , 等 . 海港海底视频影像的灰度不均匀校正方法的研究

[J]. 武汉测绘科技大学学报 , 2000 , 25 (6 ):531 -536 .

[本文引用: 1]

Jin S Y Bao G S Ma H C , et al . Research on gray nonuniformity correction method of seaport seafloor video image

[J]. Geomatics and Information Science of Wuhan University , 2000 , 25 (6 ):531 -536 .

[本文引用: 1]

[2]

Kim S J Kim N Y Lee B G , et al . Wavelet based uneven illumination compensation for defect detection of flat panel display

[C]// Iasted International Conference on Signal Processing,Pattern Reco-gnition,and Applications.ACTA Press , 2007 :104 -108 .

[本文引用: 1]

[3]

Tan R T . Visibility in bad weather from a single image

[C]// IEEE Conference on Computer Vision and Pattern Recognition,IEEE , 2008 :1 -8 .

[本文引用: 1]

[4]

谭攀 , 吴绍斐 , 苏晓军 , 等 . 基于影像动态分块与HIS结合的匀光算法

[J]. 影像技术 , 2014 , 26 (1 ):55 -56 .

[本文引用: 1]

Tan P Wu S F Su X J , et al . A smoothing algorithm based on dynamic image segmentation and HIS

[J]. Image Technology , 2014 , 26 (1 ):55 -56 .

[本文引用: 1]

[5]

张振 . 光学遥感影像匀光算法研究 [D]. 郑州 : 解放军信息工程大学 , 2010 .

[本文引用: 1]

Zhang Z . Research on dodging methods of optical remotely sensed image [D]. Zhengzhou : Information Engineering University , 2010 .

[本文引用: 1]

[6]

易磊 . 遥感影像色彩一致性处理技术研究 [D]. 郑州 : 解放军信息工程大学 , 2015 .

[本文引用: 2]

Yi L . Research on color consistency processing for remote sensing image [D]. Zhengzhou : Information Engineering University , 2015 .

[本文引用: 2]

[7]

任中杰 . 遥感瓦片影像色彩一致性研究 [D]. 赣州 : 江西理工大学 , 2019 .

[本文引用: 1]

Ren Z J . Research on color consistency of remote sensing tile image [D]. Ganzhou : Jiangxi University of Science and Technology , 2019 .

[本文引用: 1]

[8]

杜神斌 . 数字正射影像镶嵌中色彩一致性方法研究 [D]. 南昌 : 东华理工大学 , 2018 .

[本文引用: 1]

Du S B . Research on color consistency method in digital orthophoto mosaic [D]. Nanchang : East China University of Technology , 2018 .

[本文引用: 1]

[9]

刘晓龙 . 基于影像匹配接边纠正的数字正射影像的镶嵌技术

[J]. 遥感学报 , 2001 , 5 (2 ):104 -109 .

[本文引用: 1]

Liu X L . Image match and overlapping area correction mosaic technology for digital orthophoto maps

[J]. National Remote Sensing Bulletin , 2001 , 5 (2 ):104 -109 .

[本文引用: 1]

[10]

王密 , 潘俊 . 一种数字航空影像的匀光方法

[J]. 中国图象图形学报 , 2004 (6 ):104 -108 ,127.

[本文引用: 2]

Wang M Pan J . A method of removing the uneven illumination for digital aerial image

[J]. Journal of Image and Graphics , 2004 (6 ):104 -108 ,127.

[本文引用: 2]

[11]

刘建涛 . 基于彩色空间变换的航空数码影像自动匀光处理研究 [D]. 西安 : 长安大学 , 2008 .

[本文引用: 1]

Liu T J . Study on dodging of aerial digital image based on color model transform [D]. Xi’an : Chang’an University , 2008 .

[本文引用: 1]

[12]

李治江 . 彩色影像色调重建的理论与实践 [D]. 武汉 : 武汉大学 , 2005 .

[本文引用: 1]

Li Z J . Theory and practice on tone reproduction of color photos [D]. Wuhan : Wuhan University , 2005 .

[本文引用: 1]

[13]

Stumpfel J Jones A Wenger A , et al . Direct HDR capture of the sun and sky

[C]// Proceedings of the 3rd International Conference on Computer Graphics,Virtual Reality,Visualization and Interaction in Africa , 2004 :145 -149 .

[本文引用: 1]

[14]

张振 , 朱宝山 , 朱述龙 . 反差一致性改进的MASK匀光算法

[J]. 测绘科学技术学报 , 2010 (1 ):54 -56 .

[本文引用: 1]

Zhang Z Zhu B S Zhu S L . An improved MASK dodging method based on contrast consistency processing

[J]. Journal of Geomatics Science and Technology , 2010 (1 ):54 -56 .

[本文引用: 1]

[15]

朱述龙 , 朱宝山 , 王红卫 . 遥感影像处理与应用 [M]. 北京 : 科学出版社 , 2006 .

[本文引用: 1]

Zhu S L Zhu B S Wang H W . Remote sensing image processing and application [M]. Beijing : Science Press , 2006 .

[本文引用: 1]

[16]

Orsini G Ramponi G Carrai P , et al . A modified retinex for image contrast enhancement and dynamics control

[C]// International Conference on Image Processing.IEEE , 2003 :III-393 -396 .

[本文引用: 1]

[17]

Lam E Y . Combining gray world and retinex theory for automatic white balance in digital photography

[C]// International Symposium on Consumer Electronics.IEEE , 2005 :134 -139 .

[本文引用: 1]

[18]

Nnolim U Lee P . Homomorphic filtering of colour images using a spatial filter kernel in the HIS colour space

[J]. 2008 , 71 (2 ):1738 -1743 .

[本文引用: 1]

[20]

Xue Z X . Semi-supervised convolutional generative adversarial network for hyperspectral image classification

[J]. IET Image Processing , 2020 , 14 (4 ):709 -719 .

DOI:10.1049/iet-ipr.2019.0869

URL

[本文引用: 1]

[21]

李雪 , 张力 , 王庆栋 , 等 . 多时相遥感影像语义分割色彩一致性对抗网络

[J]. 测绘学报 , 2020 , 49 (11 ):1473 -1484 .

[本文引用: 1]

Li X Zhang L Wang Q D , et al . Multi-temporal remote sensing imagery semantic segmentation color consistency adversarial network

[J]. Acta Geodaetica Cartographica Sinica , 2020 , 49 (11 ):1473 -1484 .

[本文引用: 1]

[22]

王照乾 , 孔韦韦 , 滕金保 , 等 . DenseNet生成对抗网络低照度图像增强方法

[J]. 计算机工程与应用 , 2020 , 58 (8 ):214 -220 .

[本文引用: 1]

Wang Z Q Kong W W Teng J B , et al . Low illumination image enhancement method based on DenseNet GAN

[J]. Computer Engineering and Applications , 2020 , 58 (8 ):214 -220 .

[本文引用: 1]

[23]

Lyu N Ma H X Chen C , et al . Remote sensing data augmentation through adversarial training

[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing , 2020 , 14 :9318 -9333 .

DOI:10.1109/JSTARS.2021.3110842

URL

[本文引用: 1]

[24]

何鎏一 . 基于深度学习的去雾算法设计 [D]. 青岛 : 青岛大学 , 2020 .

[本文引用: 1]

He L Y . Design of defogging algorithm based on deep learning [D]. Qingdao : Qingdao University , 2020 .

[本文引用: 1]

[25]

Hu A Xie Z Xu Y , et al . Unsupervised haze removal for high-resolution optical remote-sensing images based on improved generative adversarial networks

[J]. Remote Sensing , 2020 , 12 (24 ):4162 .

DOI:10.3390/rs12244162

URL

[本文引用: 1]

[26]

冀俭俭 . 基于生成对抗网络的分级联合图像补全方法 [D]. 北京 : 北京林业大学 , 2020 .

[本文引用: 1]

Ji J J . Hierarchical jiont image completion method based on generative adversarial network [D]. Beijing : Beijing Forestry University , 2020 .

[本文引用: 1]

[27]

郑凯 , 李建胜 , 王俊强 , 等 . DCLS-GAN:利用生成对抗网络的天绘一号卫星高原地区影像去云方法

[J]. 测绘学报 , 2021 , 50 (2 ):248 -259 .

[本文引用: 1]

Zheng K Li J S Wang J Q , et al . DCLS-GAN:Cloud removal method for plateau area of TH-1 satellite image

[J]. Acta Geodaetica Cartographica Sinica , 2021 , 50 (2 ):248 -259 .

[本文引用: 1]

[28]

Zhu J Y Park T Isola P , et al . Unpaired image-to-image translation using cycle-consistent adversarial networks

[C]// 2017 IEEE International Conference on Computer Vision.IEEE , 2017 ,17453078.

[本文引用: 1]

海港海底视频影像的灰度不均匀校正方法的研究

1

2000

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

海港海底视频影像的灰度不均匀校正方法的研究

1

2000

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

Wavelet based uneven illumination compensation for defect detection of flat panel display

1

2007

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

Visibility in bad weather from a single image

1

2008

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

基于影像动态分块与HIS结合的匀光算法

1

2014

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

基于影像动态分块与HIS结合的匀光算法

1

2014

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2010

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2010

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

2

2015

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

... [6 -7 ].确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

2

2015

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

... [6 -7 ].确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2019

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2019

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2018

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2018

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

基于影像匹配接边纠正的数字正射影像的镶嵌技术

1

2001

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

基于影像匹配接边纠正的数字正射影像的镶嵌技术

1

2001

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

一种数字航空影像的匀光方法

2

2004

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

... [10 ]提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

一种数字航空影像的匀光方法

2

2004

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

... [10 ]提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2008

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2008

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2005

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2005

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

Direct HDR capture of the sun and sky

1

2004

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

反差一致性改进的MASK匀光算法

1

2010

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

反差一致性改进的MASK匀光算法

1

2010

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2006

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

1

2006

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

A modified retinex for image contrast enhancement and dynamics control

1

2003

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

Combining gray world and retinex theory for automatic white balance in digital photography

1

2005

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

Homomorphic filtering of colour images using a spatial filter kernel in the HIS colour space

1

2008

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

Ratio rule and homomorphic filter for enhancement of digital colour image

1

2006

... 目前国内外对于单幅影像色彩处理的算法有很多,例如金淑英等[1 ] 利用二阶三次多项式拟合的方法通过对像元进行灰度拉伸来改正海底视频和影像的亮度不均匀现象; Kim等[2 ] 提出基于小波变换的光照补偿方法; Tan[3 ] 提出通过归一化增强可视性影像,得到亮度均衡的影像; 谭攀等[4 ] 在HIS模型匀光算法基础上提出一种动态分块的线性拉伸,改善相邻影响块色彩不一致的现象.现在较常见的影像匀光方法根据采用模型的不同可归纳为: 加性模型和乘性模型2类[5 -6 ] .加性模型的原理是将遥感影像看作亮度均匀的前景影像与亮度不均的背景影像加和,通过一系列处理将背景影像去除而达到匀光的效果.这一类算法的重点问题是确定背景影像,背景影像的好坏很大程度上决定了匀光的效果[6 -7 ] .确定背景影像的方法大体上有2类,第一类是通过数学模型来模拟原片[8 ] ,ERDAS Imagine的色彩平衡功能提供了4种数学模型模拟影像亮度变化[9 ⇓ -11 ] ,李治江[12 ] 和Stumpfel等[13 ] 各提出了一种基于局部均值的自适应匀光模板; 第二类是基于信号处理来确定背景影像,王密等[10 ] 提出了基于MASK差值匀光法,张振等[14 ] 提出了反差一致性MASK匀光算法.乘性模型匀光算法将不均匀的影像看成是景物受到的照度和景物反射率的乘积[15 ] .例如Orsini等[16 ] 和Lam[17 ] 采用Retinex方法处理亮度和反差不均匀的影像; Nnolim等[18 ] 和Seow等[19 ] 采用同态滤波的方法增强影像高频信息达到匀光的目的. ...

Semi-supervised convolutional generative adversarial network for hyperspectral image classification

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

多时相遥感影像语义分割色彩一致性对抗网络

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

多时相遥感影像语义分割色彩一致性对抗网络

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

DenseNet生成对抗网络低照度图像增强方法

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

DenseNet生成对抗网络低照度图像增强方法

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

Remote sensing data augmentation through adversarial training

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

Unsupervised haze removal for high-resolution optical remote-sensing images based on improved generative adversarial networks

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

1

2020

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

DCLS-GAN:利用生成对抗网络的天绘一号卫星高原地区影像去云方法

1

2021

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

DCLS-GAN:利用生成对抗网络的天绘一号卫星高原地区影像去云方法

1

2021

... 尽管国内外学者已经提出大量图像匀色方法,但主要为通过人工方式,借助图像处理软件进行调节影像色彩.这种利用人工调色的方法容易受到主观因素影像,并且在实际生产过程中耗时耗力.随着影像分辨率的逐渐提高,数据量呈几何级数增长,人工调色难以快速、准确完成大量数据的调色需求.基于深度学习方法的生成对抗网络可作为遥感影像匀色的处理手段,与传统算法相比,采用图像色彩风格迁移的方法改正影像色彩只需要在训练阶段输入参考影像,在色彩校正中不依赖色彩底图,应用场景更加广泛,校正过程更加省时省力.目前已有学者尝试基于生成对抗网络的影像分类、影像增强、影像去云雾和影像修补等.如Xue[20 ] 采用一种半监督的卷积生成对抗网络对高光谱影像进行分类信息提取; 李雪等[21 ] 采用注意力引导的色彩一致生成对抗网络进行建筑物语义分割; 王照乾等[22 ] 通过DenseNet生成对抗网络增强低照度图像; Lyu等[23 ] 通过对抗性训练,对遥感影像进行增强; 何鎏一[24 ] 和Hu等[25 ] 分别利用条件生成对抗网络和改进的循环一致生成网络来对影像进行去雾操作; 冀俭俭[26 ] 提出了一种基于生成对抗网络的分级联合图像补全方法; 郑凯等[27 ] 通过DCLS生成对抗网络去除高原地区卫星影像云雾.其中国内学者李雪在建筑物语义分割前利用生成对抗网络方法进行了一定的色彩校正.与其他生成对抗网络相比,循环一致生成对抗网络(cycle generative adversarial networks, CycleGAN)的环形结构能够有效将2类数据相互转换,不仅保证了能够实现非成对影像的互相转换,更能有效地限制生成器函数,使其更能向其有效方向继续迭代训练. ...

Unpaired image-to-image translation using cycle-consistent adversarial networks

1

2017

... 与CycleGAN一致,注意力引导的循环一致生成对抗网络仍然具有2对呈现环形闭合的生成器与鉴别器[28 ] (图1 ).第一阶段待校正影像x 通过生成器Gy 转化为校正影像Gy (x ),此时鉴别器Dy 对校正影像Gy (x )进行鉴别,生成器Gy 与鉴别器Dy 为一对对抗,通过互相对抗学习提高生成器Gy 的生成水平和鉴别器Dy 的鉴定水平.第二阶段通过生成器Fx 生成影像Fx [Gy (x )],待校正影像x 与循环生成影像Fx [G y(x )]之间计算影像的循环一致损失.第一阶段同时模板影像y 也会通过生成器Fx 转化为影像待校正影像域的影像Fx (y ),此时鉴别器Dx 对影像Fx (y )进行鉴别,生成器Fx 与鉴别器Dx 为另一对对抗,通过互相对抗学习提高生成器Fx 的生成水平和鉴别器Dx 的鉴定水平.并在第二阶段继续通过生成器Gy 生成循环影像Gy [Fx (y )],同样的模板影像y 与循环影像Gy [Fx (y )]之间将计算循环一致损失来控制生成和鉴别函数的学习. ...