0 引言

随着空间分辨率的不断提高,光学遥感图像越来越广泛地应用于农业监测、资源勘察、城市规划以及环境灾害预防等各种领域。然而,光学遥感图像容易受到天气因素的影响,其中云雾对图像的干扰非常明显,被薄云遮挡的图像会信息损失、细节模糊,影响图像后续解译与应用。因此,薄云去除是光学遥感图像重要的一个预处理步骤。

近年来,学者们开始针对光学遥感图像特点的研究薄云去除网络。Li等[5]提出了一种基于卷积神经网络的端到端图像去模糊处理方法,将几个未知参数统一为一个参数,利用多尺度卷积神经网络估计未知参数,以提高高空间分辨率遥感图像的清晰度。Pan[6]提出了一种名为空间注意生成对抗网络的模型 (spatial attention generative adversarial network,SPAGAN),该模型通过识别和聚焦云区域,生成质量良好的无云图像; Li等[7]提出了一种基于生成对抗网络和云失真物理模型的半监督方法,用于去除来自不同区域的未配对图像的薄云; Zi等[8]提出一种多光谱图像薄云去除方法,通过U-Net估计多云图像的参考薄云厚度图,再利用Slope-Net 的卷积神经网络估计每个波段的薄云厚度系数以获得不同波段的薄云厚度图,最后从多云图像中减去薄云厚度图以得到恢复的清晰图像; Luo等[9]提出了一种基于慢速特征分析的空间-光谱自适应方法来去除遥感影像中的薄云。

虽然这些方法在遥感图像薄云去除方面取得了一些成果,但是算法大多只关注薄云均匀分布、地景相似的遥感图像。实际遥感图像由于覆盖范围广、大气环境复杂,云层厚度和空间分布往往呈现出非均匀特性,即图像中同时存在无云和有云区域,薄云区域的光学厚度存在非均匀性。这些特性造成传统算法对于非均匀薄云分布遥感图像的去云结果往往存在校正不足或在无云区域出现颜色失真的情况。为了解决上述问题,本文提出了加入图像特征融合模块的注意力端到端薄云去除网络。一方面,针对薄云的非均匀分布特性,构建注意力特征融合子网络,该网络由3个相同的注意力特征融合模块构成。每个模块在通道注意力和空间注意力子模块中间,设计加入一个融合模块,以便在有效提取薄云信息的同时过滤无云区域; 另一方面,为提高图像保真度,网络加入处理图像颜色和边缘信息的损失函数,以确保去云结果的颜色和细节保真性。基于人工合成图像以及真实图像的实验结果表明,本文提出的注意力特征融合网络对不同场景的均匀和非均匀薄云遥感图像均具有较好的去云效果。

1 研究方法

1.1 网络框架

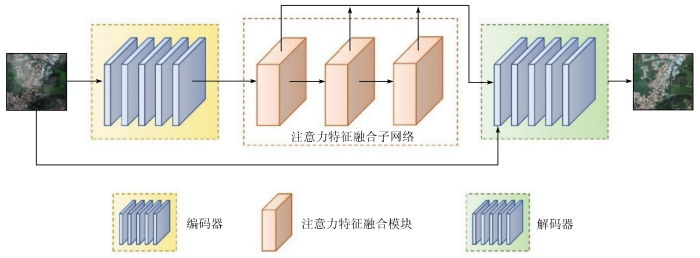

本文提出的基于注意力特征融合的薄云去除网络整体框架如图1所示。网络由编码器、解码器和注意力特征融合子网络组成。首先,输入的薄云光学遥感图像进入编码器生成特征图,送入由3个注意力特征融合模块组成的子网络。网络中,3个注意力模块紧密连接,前一模块的输出作为后一模块的输入。将3个模块分别提取的薄云特征信息共同作为输出,传向解码器,最终输出一张RGB无云图像。

图1

1.2 编码器和解码器

通过图1所示,网络的编码器由5个卷积层组成,在保持特征图像大小不变的情况下,编码器的卷积层通过增加一倍通道数的方式将输入特征图像逐步由3通道增加至128通道。这样使得输入的图像信息能够逐步增加特征信息量,而不至于单次特征通道数量增加过多使训练效果降低。且到达第5个卷积层时,通道数达到128,对于轻量级网络来说,已能提取丰富的信息,无需再增多卷积层导致网络的训练效率降低。为与编码器相互对应,解码器同样由5个卷积层组成,压缩整理网络的特征信息,将融合后的128通道特征图逐步降为3通道,输出彩色无云遥感图像。

1.3 注意力特征融合子网络

如图1所示,注意力特征融合子网络由3个结构相同的注意力特征融合模块级联构成。前一模块的输出作为后一模块的输入,递进地提取图像特征。同时网络将3个模块各自的输出连接在一起,共同传向解码器部分,保证信息完整性。

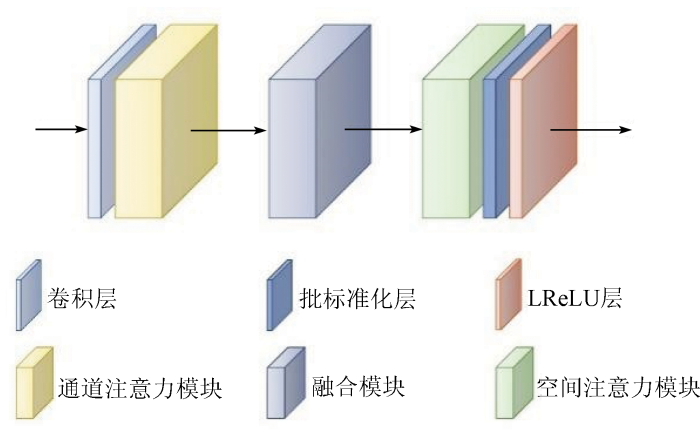

每个注意力特征融合模块的内部结构如图2所示,包括: 卷积层、通道注意力模块、融合模块、空间注意力模块、批标准化层和Leaky ReLU(LReLU)层。该模块用于过滤图像中无云区域的信息,促使网络聚焦图像中薄云区域进行信息提取与重建。

图2

图3

通道注意力特征图

式中: σ为Sigmoid函数;

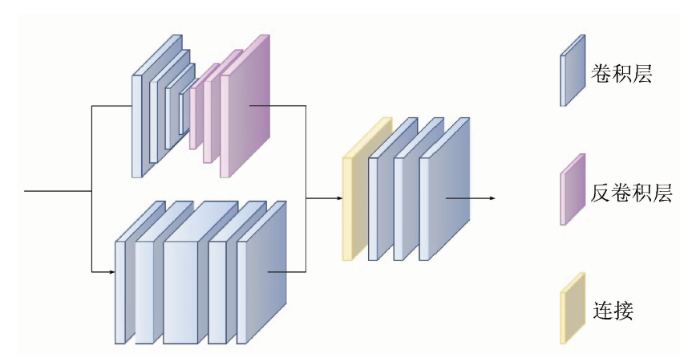

为了提高特征信息的提取能力,在通道注意力和空间注意力模块中间设计增加了一个融合模块,其结构如图4所示。模块分为2个分支,上分支保持特征图的通道数不变,将512像素×512像素大小的特征图进行3次步长为2的下采样提取特征图的局部信息,得到64像素×64像素大小的特征图,再将下采样后的特征图通过3个反卷积层上采样为原特征图大小,以此获取特征图局部特征。下分支保持特征图像大小不变,仅改变特征图像通道数,每次2倍提高特征图的通道数,再以相反的方法将特征图减小到128通道以获取特征图全局特征。将2个分支分别获取的特征接入连接层,通过3个不变卷积层整合特征信息输出到下一环节。融合模块能够整合通道注意力模块输出的通道差异化特征信息,生成具有丰富细节的特征图像传输给空间注意力模块,便于后续对薄云区域信息进行重建。

在模块结尾将激活函数由ReLU改为LReLU[11],2个激活函数分别为:

式中k∈[0,1]。通过对比可以看出,LReLU在ReLU的基础上,对小于0的负值一定程度的保留,减少负轴信息的丢失。

图4

1.4 损失函数

本文中设计的损失函数L为:

式中: Lh为Huber损失函数[12],用于评估增强网络去除薄云能力;

Lh损失函数为:

式中: J为真实无云图像;

Ls损失函数为:

式中: SJ和

由于薄云覆盖在地物上方,导致薄云图像整体泛白,对比度降低,且对于非均匀分布薄云图像云边界颜色过渡生硬。为还原图像的颜色保真度及对比度,本文引入余弦角函数作为损失函数的一部分。

Lc损失函数为:

式中: i为图像的单位像素; K为图像的像素总数。

2 实验结果与分析

2.1 参数设置

实验环境通过Tensorflow[13]框架构建本网络,CPU为Intel(R) Core(TM) i7-8700,GPU为Nvidia GeForce RTX2080,显存大小为16 GB。模型的轮数设置为80,设置优化器Adam 的学习率为0.001,批大小为16的梯度下降。

2.2 数据集

2.3 实验结果评价

本文方法与DCP[1]方法、Ren等[17]开发的多尺度卷积神经网络 (multi-scale convolutional neural network, MSCNN)、Dhara等[18]提出的自适应大气光细化与非线性色彩平衡去云算法 (adaptive airlight refinement and non-linear color balancing, AARNCB)、Cho等[19]提出的模型辅助的多波段融合算法 (model-assisted multiband fusion, MAMF) 以及SPAGAN[7]方法共5种薄云去除方法进行实验对比。为了客观进行实验对比,利用本文建立的数据集重新对SPAGAN模型进行了训练。

表1 RICE数据集薄云去除结果对比

Tab.1

| 序号 | 有云图像 | DCP | MSCNN | AARNCB | MAMF | SPAGAN | 本文方法 | 无云图像 |

|---|---|---|---|---|---|---|---|---|

| 1 |  | |||||||

| 2 |  | |||||||

| 3 |  | |||||||

| 4 |  | |||||||

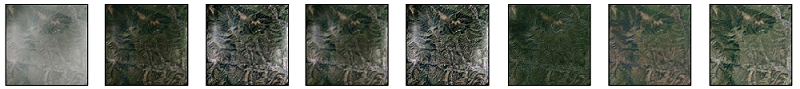

表2为本文人工合成薄云图像去云结果。其中图像1和图像2为均匀薄云覆盖图像,图像3和图像4为非均匀薄云覆盖图像。对于均匀覆盖的薄云图像,所有方法都能对图像还原。然而MSCNN和AARNCB方法处理后的图像颜色失真,锐化过度; MAMF方法处理后的图像颜色偏移严重; DCP方法预测出的结果亮度较低; SPAGAN方法去云效果明显,但是颜色还原不准确。对于非均匀薄云图像,DCP方法有较好的去云效果,但是由于暗通道中无极小值,导致预测出的图像相比于原图亮度低,损失细节; MSCNN和MAMF方法无法去除云较厚的部分,过度增强图像对比度,此外MSCNN方法还会出现偏色问题; SPAGAN方法去云效果好,但纹理细节有所损失; AARNCB方法与本文方法结果相似,但仍有部分云残留。通过对比可知,本文方法在颜色保真度、清晰度以及薄云去除效果都有较好的表现,更接近于真实图像。

表2 厚度分布不同情况薄云图像输出结果对比

Tab.2

| 序号 | 有云图像 | DCP | MSCNN | AARNCB | MAMF | SPAGAN | 本文方法 | 无云图像 |

|---|---|---|---|---|---|---|---|---|

| 1 |  | |||||||

| 2 |  | |||||||

| 3 |  | |||||||

| 4 |  | |||||||

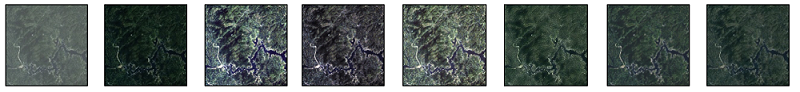

表3 真实薄云图像输出结果对比

Tab.3

| 序号 | 有云图像 | DCP | MSCNN | AARNCB | MAMF | SPAGAN | 本文方法 |

|---|---|---|---|---|---|---|---|

| 1 |  | ||||||

| 2 |  | ||||||

| 序号 | 有云图像 | DCP | MSCNN | AARNCB | MAMF | SPAGAN | 本文方法 |

| 3 |  | ||||||

| 4 |  | ||||||

表4 不同方法处理结果评价指标对比

Tab.4

| 方法 | PSNR/dB | SSIM | BRISQUE |

|---|---|---|---|

| DCP | 19.21 | 0.81 | 31.56 |

| MSCNN | 16.93 | 0.72 | 31.89 |

| AARNCB | 20.56 | 0.79 | 32.22 |

| MAMF | 16.86 | 0.69 | 31.48 |

| SPAGAN | 21.59 | 0.85 | 25.15 |

| 本文方法 | 23.74 | 0.90 | 23.62 |

2.4 实验分析

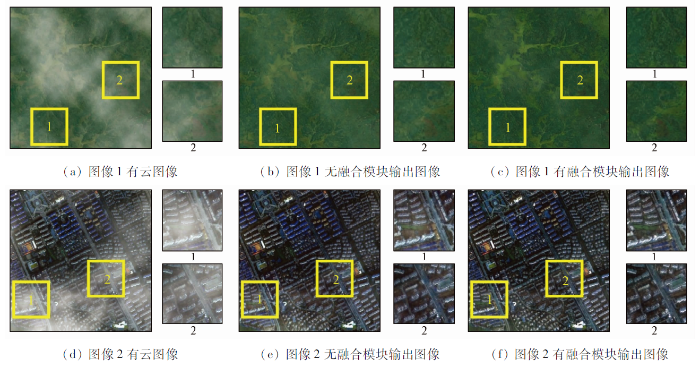

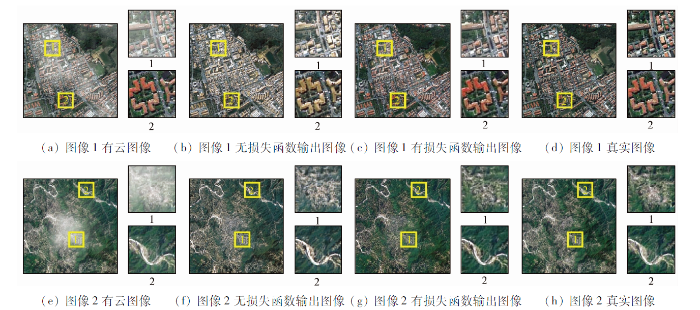

为验证本文提出的融合模块的作用,本文设计了该模块的消融实验,实验结果如图5所示。

图5

图像上黄色框为有云无云的过度区域,图像右侧为黄色框1和2的放大细节。从整体来看,在图像1山丘中,没有信息融合模块的输出结果去云效果不好,厚云处出现泛白现象,输出图像过度不自然。从局部来看,在图像2城市中,无信息融合模块的输出结果有云与无云的边界感明显,且楼房区域对比度较低。而有融合模块的2张输出图像整体细节充足,颜色恢复效果好,明暗过度平滑,对比度强。

为验证本文设计的细节损失函数

图6

图6

调整损失函数消融实验

Fig.6

Ablation experiment of color loss function and sharpening loss function

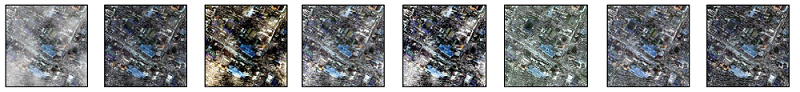

为进一步验证网络的有效性,将清晰无云图像输入网络进行测试,结果如图7所示。输出结果与原图在视觉评价上非常接近。农业区和城市区图像的SSIM定量评价指标均为0.92。值得注意的是,本文方法并未引入无云图像进行模型训练,这表明本文提出的注意力子网络能够有效关注薄云特征,忽略无云特征,模型具有很好的鲁棒性。

图7

3 结论

本文搭建了注意力特征融合子网络,并加入颜色损失函数和锐化损失函数,提出基于注意力特征融合的光学遥感图像薄云去除网络。

大量实验结果表明,该模型对于非均匀覆盖图像,不仅具有良好的去云效果,而且输出图像的颜色保真度高、细节丰富度、亮度和平滑度等方面均优于其他对比方法。在定量分析上,本文方法随机抽取图像测得的PSNR为23.74 dB,SSIM为0.90,BRISQUE为23.62,均为所有方法中的最优指标。最后,模型将无云图像输入网络,其输出结果不会进行图像压暗和薄云去除等操作,表明模型的鲁棒性强。

然而,对于地物有大片接近云亮度的部分,网络有时会误判成云,进而对该部分误去云。并且本文数据集为可见光波段合成的RGB真彩色图像,无多波段或雷达等多源数据。这些问题将是后续研究以及数据处理的重点。

参考文献

Single image haze removal using dark channel prior

[J].DOI:10.1109/TPAMI.2010.168 URL [本文引用: 3]

Contrast restoration of weather degraded images

[J].DOI:10.1109/TPAMI.2003.1201821 URL [本文引用: 1]

Haze and thin cloud removal via sphere model improved dark channel prior

[J].DOI:10.1109/LGRS.2018.2874084 URL [本文引用: 1]

A novel thin cloud removal method based on multiscale dark channel prior (MDCP)

[J].

An end-to-end system for unmanned aerial vehicle high-resolution remote sensing image haze removal algorithm using convolution neural network

[J].DOI:10.1109/Access.6287639 URL [本文引用: 1]

Cloud removal for remote sensing imagery via spatial attention generative adversarial network

[J/OL].

Thin cloud removal in optical remote sensing images based on generative adversarial networks and physical model of cloud distortion

[J].DOI:10.1016/j.isprsjprs.2020.06.021 URL [本文引用: 2]

Thin cloud removal for multispectral remote sensing images using convolutional neural networks combined with an imaging model

[J].DOI:10.1109/JSTARS.2021.3068166 URL [本文引用: 1]

A spatial-spectral adaptive thin-cloud removal method based on slow feature analysis

[J].DOI:10.1080/2150704X.2022.2079387 URL [本文引用: 1]

Cbam:Convolutional block attention module

[C]//

激活函数的发展综述及其性质分析

[J].

Overview of the development of activation function and its nature analysis

[J].

Robust regularized extreme learning machine with asymmetric Huber loss function

[J].DOI:10.1007/s00521-020-04741-w [本文引用: 1]

Deep learning with tensorflow:A review

[J].

DOI:10.3102/1076998619872761

[本文引用: 1]

This review covers the core concepts and design decisions of TensorFlow. TensorFlow, originally created by researchers at Google, is the most popular one among the plethora of deep learning libraries. In the field of deep learning, neural networks have achieved tremendous success and gained wide popularity in various areas. This family of models also has tremendous potential to promote data analysis and modeling for various problems in educational and behavioral sciences given its flexibility and scalability. We give the reader an overview of the basics of neural network models such as the multilayer perceptron, the convolutional neural network, and stochastic gradient descent, the most commonly used optimization method for neural network models. However, the implementation of these models and optimization algorithms is time-consuming and error-prone. Fortunately, TensorFlow greatly eases and accelerates the research and application of neural network models. We review several core concepts of TensorFlow such as graph construction functions, graph execution tools, and TensorFlow's visualization tool, TensorBoard. Then, we apply these concepts to build and train a convolutional neural network model to classify handwritten digits. This review is concluded by a comparison of low- and high-level application programming interfaces and a discussion of graphical processing unit support, distributed training, and probabilistic modeling with TensorFlow Probability library.

A remote sensing image dataset for cloud removal

[J/OL].

No-reference assessment on haze for remote-sensing images

[J].DOI:10.1109/LGRS.2016.2614890 URL [本文引用: 1]

The mathematic magic of Photoshop blend modes for image processing

[C]//

Single image dehazing via multi-scale convolutional neural networks with holistic edges

[J].DOI:10.1007/s11263-019-01235-8 [本文引用: 1]

Color cast dependent image dehazing via adaptive airlight refinement and non-linear color balancing

[J].DOI:10.1109/TCSVT.2020.3007850 URL [本文引用: 1]

Model-assisted multiband fusion for single image enhancement and applications to robot vision

[J].DOI:10.1109/ROBOT.1996.506590 URL [本文引用: 1]

图像质量评价方法研究进展

[J].

Overview on image quality assessment methods

[J].

No-reference image quality assessment in the spatial domain

[J].

DOI:10.1109/TIP.2012.2214050

PMID:22910118

[本文引用: 1]

We propose a natural scene statistic-based distortion-generic blind/no-reference (NR) image quality assessment (IQA) model that operates in the spatial domain. The new model, dubbed blind/referenceless image spatial quality evaluator (BRISQUE) does not compute distortion-specific features, such as ringing, blur, or blocking, but instead uses scene statistics of locally normalized luminance coefficients to quantify possible losses of "naturalness" in the image due to the presence of distortions, thereby leading to a holistic measure of quality. The underlying features used derive from the empirical distribution of locally normalized luminances and products of locally normalized luminances under a spatial natural scene statistic model. No transformation to another coordinate frame (DCT, wavelet, etc.) is required, distinguishing it from prior NR IQA approaches. Despite its simplicity, we are able to show that BRISQUE is statistically better than the full-reference peak signal-to-noise ratio and the structural similarity index, and is highly competitive with respect to all present-day distortion-generic NR IQA algorithms. BRISQUE has very low computational complexity, making it well suited for real time applications. BRISQUE features may be used for distortion-identification as well. To illustrate a new practical application of BRISQUE, we describe how a nonblind image denoising algorithm can be augmented with BRISQUE in order to perform blind image denoising. Results show that BRISQUE augmentation leads to performance improvements over state-of-the-art methods. A software release of BRISQUE is available online: http://live.ece.utexas.edu/research/quality/BRISQUE_release.zip for public use and evaluation.