0 引言

图像融合是按照某种规则将单一传感器或多个传感器对同一场景的图像信息进行整理综合,尽力消除图像信息间的冗余性,充分利用图像信息间的互补性,从而获得信息更精确、更全面的融合图像[1 ] 。遥感数字图像中,全色图像空间分辨率高,但只有单个波段,缺乏光谱信息; 而多光谱图像具有多个光谱波段,光谱信息丰富,但空间分辨率低,清晰度差。因此,将全色图像与多光谱图像进行融合,有利于综合全色图像丰富的细节信息和多光谱图像较好的光谱信息,从而提高图像信息的利用率[2 ] 。目前,遥感图像融合已广泛应用于军事图像处理、智能交通运输、土地利用调查等多个不同的领域[3 ⇓ -5 ] 。

全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合。该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] 。CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法。该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] 。该类方法虽然简单,但融合效果较差。其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度。MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换(a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等。其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] 。其中,ATWT法采用平移不变的离散小波“a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息。

脉冲耦合神经网络(pulse coupled neural networks, PCNN)是Eckhorn等[16 ] 于20世纪末根据猫、猴视觉皮层脉冲同步发放实验而提出的一种生物神经网络,其良好的全局耦合和同步脉冲特性在图像融合中扮演着极其重要的角色。李凯[17 ] 提出了一种基于简化型PCNN和采用梯度能量作为清晰度度量标准的分块融合的多聚焦图像融合算法,实验取得了不错的效果,但多聚焦图像融合与多光谱遥感图像全色锐化原理不同,很难应用于遥感图像融合。

为此,本文综合NSCT和PCNN的特性,提出了一种结合NSCT和PCNN的全色与多光谱图像融合新算法。该算法利用多尺度多方向NSCT金字塔分解与重构以获取全色图像细节信息的同时,还通过PCNN模拟人眼视觉特性对多光谱图像进行非规则区域分割,针对遥感图像非规则区域特点进行加权细节的注入以获得全色锐化融合结果。实验结果表明,融合后的图像在保持多光谱图像光谱信息的同时,空间信息也得到了一定程度提高,融合评价指标均优于传统融合算法。

1 NSCT和PCNN理论

1.1 NSCT

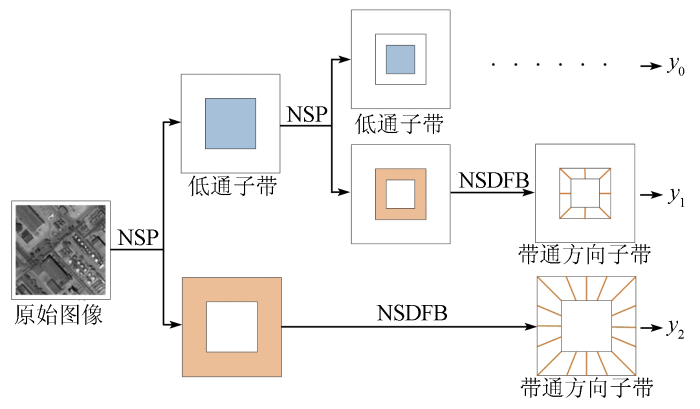

NSCT通过双通道非下采样二维滤波器组来实现,其中非下采样金字塔(nonsubsampled pyramid, NSP)滤波器组保证了多尺度特性,非下采样方向滤波器组(nonsubsampled direction filter bank, NSDFB)提供了方向特性[18 ] ,如图1 所示。首先原始图像经过NSP处理,得到一个低通子带图像和一个带通子带图像,然后将带通子带用NSDFB处理,得到一系列的带通方向子带图像,得到的低通子带可以重复NSP和NSDFB操作,实现图像的多尺度和多方向分解。当某一层的方向分解级数为l 时,图像被分解成2l [19 ] 。

图1

图1

NSCT分解示意图

Fig.1

Schematic diagram of NSCT decomposition

1.2 PCNN模型

PCNN是一种生物型非训练反馈神经网络模型,PCNN基本单元是神经元,每个神经元由3部分组成: 接收输入域、连接调制域和脉冲产生域,如图2 所示。图2 中,索引ij 和索引kl 分别代表当前神经元和邻域神经元,F 为反馈输入,L 为连接输入,U 为内部活动项,Y 为脉冲输出值,E 为动态门阀阈值。I 在图像处理应用中为输入的数字图像,Ykl 为邻域神经元脉冲输出值。V F ,V L 和V E 分别为放大系数,α F ,α L 和α E 分别为衰减时间常数,β 为连接强度系数,M 和W 分别为反馈输入F 和连接输入L 神经元之间的连接矩阵,设置M =W 。一旦邻域内有神经元被激发,则神经元间的突触M 和W 加权结果会随之改变,进而影响当前神经元的接收输入域的2种输入F 和L ,从而内部活动项U 也会随之增大,当U >E 时,神经元会产生一个脉冲,称为点火,与此同时,动态门阀阈值E 也会增大,导致刚点火的神经元在接下来的较长时间内不会再次点火,随着迭代的进行,动态门阀阈值E 会逐渐衰减,直到内部活动项U 超过动态门阀阈值E 时,该神经元才会再次点火。

图2

图2

PCNN单个神经元模型

Fig.2

PCNN single neuron model

(1) Fij (n )= e - α F ij (n-1)+VF ∑ k l ijkl Ykl (n-1)+Iij ,

(2) Lij (n )= e - α L ij (n-1)+VL ∑ k l ijkl Ykl (n-1),

(3) Uij (n )=Fij (n )[1+βLij (n )],

(4) Yij (n )= 1 U i j ( n ) > E i j ( n ) 0 其 他

(5) Eij (n +1)= e - α E ij (n)+VE Yij (n),

PCNN由于其独特结构,使其具有同步脉冲发放、阈值动态变化、无训练机制和并行处理等有益于图像融合的特性。在进行图像融合时,PCNN是一个二维单层横向连接型神经网络。PCNN的一个神经元对应待处理的图像的一个像素,且每个神经元与其周围的8个神经元都有连接[20 ] 。

2 基于NSCT和PCNN的全色锐化融合算法

本文算法利用NSCT变换分解全色图像,用均值提取全色图像细节,将多光谱图像进行PCNN非规则区域分割,按照MRA法模型进行融合得到融合图像。

2.1 细节提取

将全色图像进行NSCT变换,得到低通子带和带通子带,低通子带表示图像的近似分量,带通子带表示图像的细节和纹理分量。为了提取全色图像中真正的细节,计算每个带通子带绝对值的均值,将带通子带中大于1.5倍均值的系数置为0,并进行NSCT重构。用原始全色图像减去低分辨率的全色图像就可以获得全色图像细节。其数学描述为:

(6) P $P \stackrel{\text { NSCT 分解 }}{\longrightarrow} y_{0}+\sum_{l=1}^{L} y_{l}$,

(7) J Z l l )], l=1,2,3,…,L,

(8) y l 0 y l ( i , j ) > 1.5 J Z l ( i , j ) y l ( i , j ) 其 他

(9) $y_{0}+\sum_{l=1}^{L} y_{l} \stackrel{\text { NSCT 重构 }}{\longrightarrow} P_{\mathrm{L}}$,

(10) P d =P -P L ,

式中: P 为全色图像; y 0 为低通子带; yl 为带通方向子带; L 为方向分解的总子带数; JZl 为每个带通子带的均值; mean 2( )为二维图像均值; abs ( )为绝对值; (i ,j )为带通子带像素的每个像素值; P d 为全色图像中的细节; P L 为低分辨率的全色图像。

2.2 非规则区域权重计算

PCNN的全局耦合、脉冲同步发放特点将多光谱图像分割为几个具有相似灰度值的非规则区域,在每个区域上,用PCNN点火结果、协方差和标准差来衡量多光谱图像和低分辨率全色图像之间的相关性,相关性越大,注入系数值越大,反之,注入系数值越小。计算公式为:

(11) CR [n ]= C o v [ M S u k ( i , j ) , P L ( i , j ) ] C o v [ P L ( i , j ) , P L ( i , j ) ] Y i j [ n ] = 1 0 其 他

(12) gk [n ]= S t d [ M S u k ( i , j ) ] S t d [ P L ( i , j ) ] C R [ n ] > 0 Y i j [ n ] = 1 0 其 他

式中: M S k u k 为多光谱的第k 个波段; gk 为注入系数; Cov (m ,n )为m 和n 的协方差; Std (q )为q 的标准差。

2.3 细节注入

本文全色图像细节是基于MRA法注入到多光谱图像中,MRA法的模型为:

(13) MSk =M S u k k (P-PL ), k=1,2,…,K,

式中: MSk 为融合后的高空间分辨率的多光谱图像; K 为总的波段数。

图3

图3

本文算法锐化融合流程

Fig.3

Sharpening fusion process algorithm in this paper

1)对原始多光谱图像进行上采样,得到采样后的多光谱图像M S k u M S k u

2)将全色图像复制为K 个波段,与M S k u

3)将匹配后的全色图像进行NSCT分解,得到分解后的全色图像。其中,NSP滤波器和NSDFB滤波器分别为“maxflat”和“dmaxflat7”,方向级数从“细”到“粗”依次为[2,3,3]。

4)分解后的全色图像有1个低通子带和20个带通方向子带,分别计算每个带通子带绝对值的均值,然后将大于1.5倍均值的带通方向子带系数置0,得到置0后的图像。

5)将置0后的全色图像进行NSCT逆变换,得到逆变换的图像P L 。

6)用原始全色图像减去逆变换的全色图像P L ,得到全色图像的细节P d 。

7)将归一化的多光谱图像进行PCNN分割,根据式(11)和式(12)计算每个不规则区域的注入系数gk 。

8)更新gk 和n ,保证所有的神经元(图像像素点)都被激发。

3 实验结果与分析

3.1 实验数据

为验证本文所提出算法的有效性,本文分别在WorldView-2和高分二号(GF-2)2组数据集上进行融合实验。

第1组全色图像和多光谱图像来自于WorldView-2卫星,截取的是城市地区,多光谱图像和全色图像大小分别是256像素×256像素、1 024像素×1 024像素。多光谱图像有蓝光、绿光、红光和近红外4个波段,空间分辨率为2 m,全色图像的空间分辨率为0.5 m。

第2组全色图像和多光谱图像来自于GF-2卫星,截取的是山地地区,多光谱图像和全色图像大小分别是256像素×256像素、1 024像素×1 024像素。多光谱图像有蓝光、绿光、红光和近红外4个波段,空间分辨率为3.4 m,全色图像的空间分辨率为0.85 m。

3.2 PCNN参数设置

输入图像数据集进行PCNN变换前均进行了归一化处理。PCNN参数中,初始迭代次数n =1,神经元连接矩阵M 和W 都设置为[0.5,1,0.5; 1,0,1; 0.5,1,0.5],α F = 0.1,α L = 1,α E = 0.62,V F =0.5,V L = 0.2,V E = 20,β = 0.1。一旦某个神经元发生了点火,将该神经元阈值放大系数V E 设置为一个较大的值,以保证每个神经元只被激活一次,以保证非规则区域分割的唯一性。

3.3 结果评估分析

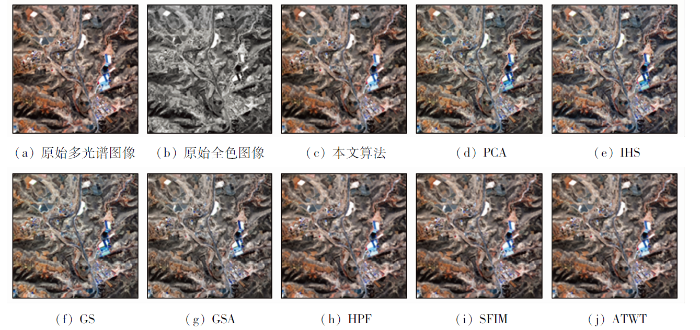

图4 和图5 分别为WorldView-2和GF-2数据集不同融合方法的融合对比结果,其中图4(a) 和图5(a) 分别为2个传感器多光谱遥感图像,图4(b) 和图5(b) 分别为2个传感器的全色图像。图4(c) 和图5(c) 分别为本文算法针对不同数据集融合结果。为验证本文算法有效性,将本文算法分别与PCA,IHS,GS,GSA,HPF,SFIM,ATWT等7种融合算法进行了定性分析与定量指标对比,其中PCA,IHS,GS,GSA属于CS法,HPF,SFIM,ATWT属于MRA法。图4(d) —(j) 分别为WorldView-2数据集分别使用这7种方法得到的融合结果图像,图5(d) —(j) 分别为GF-2数据集分别使用这7种方法得到的融合结果图像。

图4

图4

WorldView-2数据集的全色锐化结果

Fig.4

Pansharpening results of WorldView-2 dataset

图5

图5

GF-2数据集的全色锐化结果

Fig.5

Pansharpening results of GF-2 dataset

由图4 和图5 可见,所有7种全色锐化方法融合后的图像都比原始的多光谱图像增加了更多高分辨率细节信息,但CS类融合图像明显比本文算法、HPF,SFIM和ATWT这4种融合算法的光谱偏差更大。其中IHS和GSA融合算法光谱扭曲较大。IHS和GSA算法结果中,在图4 中WorldView-2数据集中的白色圆顶建筑物的屋顶,以及图5 中GF-2数据集中间房屋和左侧山体的颜色都出现了严重的光谱扭曲。这是因为CS法是直接将全色图像代替多光谱图像的某一个分量,使得全色图像的全部细节都注入到多光谱图像中,带来了较大的光谱误差。相较而言,本文算法融合结果图4(c) 的左上角房屋轮廓更为清晰,符合PCNN的点火特性; 图5(c) 中,山脊的颜色更贴近于原始多光谱图像,且没有重影现象,具有良好的视觉效果。

在定量指标评价中,本文进行了全分辨率指标评价和降分辨率指标评价。全分辨率评价是直接在原始图像上进行融合,融合后的图像为与原始全色图像空间分辨率一致的多波段图像,融合指标没有参考图像,但达到提高融合图像分辨率的目的; 降分辨率评价是按照多光谱图像与全色图像的分辨率比值,预先对原始图像进行降分辨率处理,最终得到与原始多光谱图像空间分辨率一致的图像,融合指标以原始多光谱图像作为参考图像,但本质上没有提高原始多光谱的空间分辨率。为衡量融合图像的光谱保持能力,本文分别采用四元数指标Q 4 、每个波段四元数指标的平均值Q_avg 、光谱失真度ERGAS、光谱扭曲度D λ Q 4 和Q_avg 表示融合图像与参考图像之间的相关性,其值越大,说明融合图像与参考图像相关性越大,光谱保持越好,理想值为1; ERGAS 和D λ D S 来衡量融合图像的空间细节注入程度,该指标描述融合图像与原始全色图像纹理细节的相似性,其值越小,两者之间纹理细节越相似,融合效果越好。除此之外,本文还选择了一个综合指标: 无参考质量指标QNR ,它是由D λ D S 共同组成,其值越高,融合图像质量越好,理想值为1。

WorldView-2数据集和GF-2数据集的全分辨率指标评价和降分辨率指标评价结果分别如表1 和表2 所示。从表1 和表2 可以看出: PCA,IHS,GS和GSA这4种CS类方法的Q 4 和Q_avg 指标偏低,但ERGAS 指标偏高,说明CS类方法的光谱失真较大,同时它们的D S 指标高,但综合指标QNR 指标低,说明了CS类方法融合图像与原始全色图像纹理细节的相似性小; HPF,SFIM和ATWT这3种MRA类方法的ERGAS 指标明显比CS类方法低,且Q 4 和Q_avg 指标比CS类方法高,说明MRA类方法比CS类方法光谱保真度好,由D λ D S 和QNR 指标值可以看出,MRA类方法的D λ D S 较小、QNR 较大,这说明了MRA类方法光谱失真小、空间细节注入较多; 不管是光谱一致性指标还是空间细节保持指标,本文算法都取得了最优值。因此,本文融合算法得到的融合图像光谱保持更好、空间细节纹理信息更加丰富,验证了本文多光谱图像与全色图像锐化融合算法的有效性。

4 结论

本文提出了一种结合NSCT和PCNN的多光谱与全色遥感图像锐化融合新算法。该算法充分利用了NSCT多尺度、多方向分解以提取全色图像细节特征。同时,在细节注入过程中,充分考虑PCNN获得的非规则区域差异,采用加权统计方式提高多光谱图像的空间分辨率信息。从主观定性评价来看,本文算法融合结果有良好的视觉效果,颜色自然,纹理丰富清晰; 从客观定量评价来看,本文算法在注入空间细节的同时,也尽可能保持了更多原始多光谱图像的光谱信息。

但对于不同的图像,设置不同的PCNN参数,PCNN图像分割不同,进而导致融合图像质量受到一定影响。因此,如何让PCNN自适应融合图像,设置PCNN融合自适应参数将是团队下一步工作。

参考文献

View Option

[1]

[本文引用: 1]

Yang L P Ma M Xie W , et al . Fusion algorithm evaluation of Landsat8 panchromatic and multispetral images in arid regions

[J]. Remote Sensing for Land and Resources , 2019 , 31 (4 ):11 -19 .doi:10.6046/gtzyyg.2019.04.02 .

[本文引用: 1]

[2]

Vivone G Mura M D Garzelli A , et al . A new benchmark based on recent advances in multispectral pansharpening:Revisiting pansharpening with classical and emerging pansharpening methods

[J]. IEEE Geoscience and Remote Sensing Magazine , 2020 , 9 (1 ):53 -56 .

DOI:10.1109/MGRS.6245518

URL

[本文引用: 2]

[3]

[本文引用: 1]

Liu W J Gao J K Qu H C , et al . Ship detection based on multi-scale feature enhancement of remote sensing images

[J]. Remote Sensing for Natural Resources , 2021 , 33 (3 ):97 -106 .doi:10.6046/zrzyyg.2020372 .

[本文引用: 1]

[4]

Li H F Song D Z Liu Y , et al . Automatic pavement crack detection by multi-scale image fusion

[J]. IEEE Transactions on Intelligent Transportation Systems , 2018 , 20 (6 ):2025 -2031 .

DOI:10.1109/TITS.6979

URL

[本文引用: 1]

[5]

宋亚萍 . 基于多源影像融合和面向对象的土地利用分类技术研究 [D]. 石河子 : 石河子大学 , 2020 .

[本文引用: 1]

Song Y P . Research on land use classification technology based on multi-source image fusion and object-oriented [D]. Shihezi : Shihezi University , 2020 .

[本文引用: 1]

[6]

Kahraman S Erturk A . Review and performance comparison of pansharpening algorithms for RASAT images

[J]. Istanbul University-Journal of Electrical and Electronics Engineering , 2018 , 18 (1 ):109 -120 .

DOI:10.5152/iujeee.

URL

[本文引用: 1]

[7]

Wady S Bentoutou Y Bengermikh A , et al . A new IHS and wavelet based pansharpening algorithm for high spatial resolution satellite imagery

[J]. Advances in Space Research , 2020 , 66 (7 ):1507 -1518 .

DOI:10.1016/j.asr.2020.06.001

URL

[本文引用: 1]

[8]

Du C Gao S . Remote sensing image fusion based on nonlinear IHS and fast nonsubsampled contourlet transform

[J]. Journal of the Indian Society of Remote Sensing , 2018 , 46 (6 ):2023 -2032 .

DOI:10.1007/s12524-018-0859-y

[本文引用: 1]

[9]

Wu Z Huang Y Zhang K . Remote sensing image fusion method based on PCA and Curvelet transform

[J]. Journal of the Indian Society of Remote Sensing , 2018 , 46 (5 ):687 -689 .

DOI:10.1007/s12524-017-0736-0

URL

[本文引用: 1]

[10]

张涛 , 刘军 , 杨可明 , 等 . 结合Gram-Schmidt变换的高光谱影像谐波分析融合算法

[J]. 测绘学报 , 2015 , 44 (9 ):1042 -1047 .

DOI:10.11947/j.AGCS.2015.20140637

[本文引用: 1]

针对高光谱影像谐波分析融合(HAF)算法在影像融合时不顾及地物光谱曲线整体反射率这一缺陷,提出了结合Gram-Schmidt变换的高光谱影像谐波分析融合(GSHAF)改进算法。GSHAF算法可在完全保留融合前后像元光谱曲线波形形态的基础上,将高光谱影像融合简化为各像元光谱曲线的谐波余相组成的二维影像与高空间分辨率影像之间的融合。它是在原始高光谱影像光谱曲线被谐波分解为谐波余项、振幅和相位后,首先将其谐波余项与高空间分辨率影像进行GS变换融合,这样便可有效地修正融合后像元光谱曲线的反射率特征,随后再利用该融合影像与谐波振幅、相位进行谐波逆变换,完成高光谱影像谐波融合。本文最后利用Hyperion高光谱遥感影像与ALI高空间分辨率影像对GSHAF算法进行可行性分析,再以HJ-1A等卫星数据对其进行普适性验证,试验结果表明,GSHAF算法不仅可以完全地保留光谱曲线波形形态,而且融合后影像的地物光谱曲线反射率更接近真实地物。

Zhang T Liu J Yang K M , et al . Harmonic analysis fusion algorithm for hyperspectral image combining Gram-Schmidt transform

[J]. Journal of Surveying and Mapping , 2015 , 44 (9 ):1042 -1047 .

[本文引用: 1]

[11]

Aiazzi B Baronti S Selva M . Improving component substitution pansharpening through multivariate regression of MS+Pan data

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2007 , 45 (10 ):3230 -3239 .

DOI:10.1109/TGRS.2007.901007

URL

[本文引用: 1]

[12]

Nunez J Otazu X Fors O , et al . Multiresolution-based image fusion with additive wavelet decomposition

[J]. IEEE Transactions on Geoscience and Remote Sensing , 1999 , 37 (3 ):1204 -1211 .

DOI:10.1109/36.763274

URL

[本文引用: 1]

[13]

Ma D Lai H C . Remote sensing image matching based improved ORB in NSCT domain

[J]. Journal of the Indian Society of Remote Sensing , 2019 , 47 (5 ):801 -807 .

DOI:10.1007/s12524-019-00958-y

[本文引用: 1]

Aiming at the problem that the ORB algorithm has no scale invariance and low matching accuracy in image matching, an improved ORB algorithm is proposed on the basis of SURF algorithm. Based on the flexibility of NSCT in image decomposition and the effectiveness of the improved ORB algorithm in remote sensing image matching, an improved ORB algorithm based on NSCT domain is proposed for remote sensing image matching. The image to be matched and the reference image are decomposed by NSCT. Two corresponding low-frequency images are obtained. Then, to reduce the influence of high-frequency noise on matching results, two low-frequency images are inputted to the improved ORB algorithm to obtain initial match results. The RANSAC algorithm is adopted to eliminate the mismatching points and complete the image matching. The experimental results show that the algorithm can make up the problem that the ORB algorithm has no scale invariance, and effectively improve the matching speed and accuracy of scale and rotation changes between two images. Meanwhile, the algorithm is more robust than classical methods in many complex situations such as image blur, field of view change, and noise interference.

[14]

王密 , 何鲁晓 , 程宇峰 , 等 . 自适应高斯滤波与SFIM模型相结合的全色多光谱影像融合方法

[J]. 测绘学报 , 2018 , 47 (1 ):82 -90 .

DOI:10.11947/j.AGCS.2018.20170421

[本文引用: 1]

全色-多光谱影像融合技术可以显著提高遥感影像的地物判别能力,但是空间信息融入度与光谱信息保真度是相互矛盾的一组性质,一般方法往往无法平衡这两方面。SFIM算法具有良好的光谱信息保持能力,但是其空间信息融入度较差,影响了整体的融合效果。为此,本文分析了SFIM模型的原理与特点,提出一种自适应高斯滤波与SFIM模型相结合的全色多光谱影像融合方法(AGSFIM)。以均值调整后的多光谱整体平均梯度为标准来计算高斯滤波的最优参数,将下采样全色影像的清晰度调整至同样水平,以保证融合结果的空间信息融入度与光谱信息保真度之间的平衡。利用6种融合算法对“北京二号”(Beijing-2)、“资源三号”02星(ZY-3 02)数据进行对比试验,表明在良好的光谱保持能力的前提下,改进方法可以有效克服SFIM算法空间信息融入不足的缺点。

Wang M He L X Cheng Y F , et al . Panchromatic multispectral image fusion method based on adaptive Gaussian filter and SFIM model

[J]. Journal of Surveying and Mapping , 2018 , 47 (1 ):82 -90 .

[本文引用: 1]

[15]

Cunha A L Zhou J Do M N , et al . The nonsubsampled Contourlet transform:Theory,design,and applications

[J]. IEEE Transactions on Image Processing , 2006 , 15 (10 ):3089 -3101 .

DOI:10.1109/TIP.2006.877507

URL

[本文引用: 1]

[16]

Eckhorn R Frien A Bauer R , et al . High frequency (60-90 Hz) oscillations in primary visual cortex of awake monkey

[J]. Neuroreport , 1993 , 4 (3 ):243 -246 .

PMID:8477045

[本文引用: 2]

It has been proposed that synchronized oscillations play a key role in perceptual feature linking and sensory integration. This idea was supported by the discovery of strongly synchronized stimulus-specific oscillations in the visual cortex of anaesthetized cats. The 'synchronization hypothesis' was controversial because in the visual cortex of awake monkeys either only weak or no oscillations were found. We have now recorded high amplitude synchronized oscillation at the level of spike activity and local field potential from the primary visual cortex of an awake monkey. The dominant frequencies (70-80 Hz) were considerably higher than those observed previously in cats and monkeys (30-50 Hz). However, stimulus specificities of the oscillations were comparable to and amplitudes even higher than those in cats.

[17]

李凯 . 基于PCNN和图像分块融合法的多聚焦图像融合算法研究 [D]. 昆明 : 云南大学 , 2013 .

[本文引用: 1]

Li K . Research on multi-focus image fusion algorithm based on PCNN and image block fusion method [D]. Kunming : Yunnan University , 2013 .

[本文引用: 1]

[18]

Ding S Zhao X Hui X , et al . NSCT-PCNN image fusion based on image gradient motivation

[J]. IET Computer Vision , 2018 , 12 (4 ):377 -383 .

DOI:10.1049/cvi2.v12.4

URL

[本文引用: 1]

[19]

马冯 . 基于NSCT变换的遥感图像融合算法研究 [D]. 西安 : 长安大学 , 2019 .

[本文引用: 1]

Ma F . Research on remote sensing image fusion algorithm based on NSCT transform [D]. Xi’an : Chang’an University , 2019 .

[本文引用: 1]

[20]

闫利 , 向天烛 . NSCT域内结合边缘特征和自适应PCNN的红外与可见光图像融合

[J]. 电子学报 , 2016 , 44 (4 ):761 -766 .

DOI:10.3969/j.issn.0372-2112.2016.04.002

[本文引用: 1]

针对传统的基于多尺度变换的红外与可见光图像融合,对比度不高,边缘等细节信息保留不充分等问题,结合NSCT变换的多分辨率、多方向特性和PCNN全局耦合、脉冲同步激发等优点,提出一种基于NSCT变换结合边缘特征和自适应PCNN红外与可见光图像融合算法.对于低频子带,采用一种基于边缘的融合方法;对于高频方向子带,采用方向信息自适应调节PCNN的链接强度,使用改进的空间频率特征作为PCNN的外部激励,根据脉冲点火幅度融合子带系数.实验结果验证了该算法的有效性.

Yan L Xiang T Z . Infrared and visible image fusion based on edge feature and adaptive PCNN in NSCT domain

[J]. Journal of Electronics , 2016 , 44 (4 ):761 -766 .

[本文引用: 1]

干旱区Landsat8全色与多光谱数据融合算法评价

1

2019

... 图像融合是按照某种规则将单一传感器或多个传感器对同一场景的图像信息进行整理综合,尽力消除图像信息间的冗余性,充分利用图像信息间的互补性,从而获得信息更精确、更全面的融合图像[1 ] .遥感数字图像中,全色图像空间分辨率高,但只有单个波段,缺乏光谱信息; 而多光谱图像具有多个光谱波段,光谱信息丰富,但空间分辨率低,清晰度差.因此,将全色图像与多光谱图像进行融合,有利于综合全色图像丰富的细节信息和多光谱图像较好的光谱信息,从而提高图像信息的利用率[2 ] .目前,遥感图像融合已广泛应用于军事图像处理、智能交通运输、土地利用调查等多个不同的领域[3 ⇓ -5 ] . ...

干旱区Landsat8全色与多光谱数据融合算法评价

1

2019

... 图像融合是按照某种规则将单一传感器或多个传感器对同一场景的图像信息进行整理综合,尽力消除图像信息间的冗余性,充分利用图像信息间的互补性,从而获得信息更精确、更全面的融合图像[1 ] .遥感数字图像中,全色图像空间分辨率高,但只有单个波段,缺乏光谱信息; 而多光谱图像具有多个光谱波段,光谱信息丰富,但空间分辨率低,清晰度差.因此,将全色图像与多光谱图像进行融合,有利于综合全色图像丰富的细节信息和多光谱图像较好的光谱信息,从而提高图像信息的利用率[2 ] .目前,遥感图像融合已广泛应用于军事图像处理、智能交通运输、土地利用调查等多个不同的领域[3 ⇓ -5 ] . ...

A new benchmark based on recent advances in multispectral pansharpening:Revisiting pansharpening with classical and emerging pansharpening methods

2

2020

... 图像融合是按照某种规则将单一传感器或多个传感器对同一场景的图像信息进行整理综合,尽力消除图像信息间的冗余性,充分利用图像信息间的互补性,从而获得信息更精确、更全面的融合图像[1 ] .遥感数字图像中,全色图像空间分辨率高,但只有单个波段,缺乏光谱信息; 而多光谱图像具有多个光谱波段,光谱信息丰富,但空间分辨率低,清晰度差.因此,将全色图像与多光谱图像进行融合,有利于综合全色图像丰富的细节信息和多光谱图像较好的光谱信息,从而提高图像信息的利用率[2 ] .目前,遥感图像融合已广泛应用于军事图像处理、智能交通运输、土地利用调查等多个不同的领域[3 ⇓ -5 ] . ...

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

多尺度特征增强的遥感图像舰船目标检测

1

2021

... 图像融合是按照某种规则将单一传感器或多个传感器对同一场景的图像信息进行整理综合,尽力消除图像信息间的冗余性,充分利用图像信息间的互补性,从而获得信息更精确、更全面的融合图像[1 ] .遥感数字图像中,全色图像空间分辨率高,但只有单个波段,缺乏光谱信息; 而多光谱图像具有多个光谱波段,光谱信息丰富,但空间分辨率低,清晰度差.因此,将全色图像与多光谱图像进行融合,有利于综合全色图像丰富的细节信息和多光谱图像较好的光谱信息,从而提高图像信息的利用率[2 ] .目前,遥感图像融合已广泛应用于军事图像处理、智能交通运输、土地利用调查等多个不同的领域[3 ⇓ -5 ] . ...

多尺度特征增强的遥感图像舰船目标检测

1

2021

... 图像融合是按照某种规则将单一传感器或多个传感器对同一场景的图像信息进行整理综合,尽力消除图像信息间的冗余性,充分利用图像信息间的互补性,从而获得信息更精确、更全面的融合图像[1 ] .遥感数字图像中,全色图像空间分辨率高,但只有单个波段,缺乏光谱信息; 而多光谱图像具有多个光谱波段,光谱信息丰富,但空间分辨率低,清晰度差.因此,将全色图像与多光谱图像进行融合,有利于综合全色图像丰富的细节信息和多光谱图像较好的光谱信息,从而提高图像信息的利用率[2 ] .目前,遥感图像融合已广泛应用于军事图像处理、智能交通运输、土地利用调查等多个不同的领域[3 ⇓ -5 ] . ...

Automatic pavement crack detection by multi-scale image fusion

1

2018

... 图像融合是按照某种规则将单一传感器或多个传感器对同一场景的图像信息进行整理综合,尽力消除图像信息间的冗余性,充分利用图像信息间的互补性,从而获得信息更精确、更全面的融合图像[1 ] .遥感数字图像中,全色图像空间分辨率高,但只有单个波段,缺乏光谱信息; 而多光谱图像具有多个光谱波段,光谱信息丰富,但空间分辨率低,清晰度差.因此,将全色图像与多光谱图像进行融合,有利于综合全色图像丰富的细节信息和多光谱图像较好的光谱信息,从而提高图像信息的利用率[2 ] .目前,遥感图像融合已广泛应用于军事图像处理、智能交通运输、土地利用调查等多个不同的领域[3 ⇓ -5 ] . ...

1

2020

... 图像融合是按照某种规则将单一传感器或多个传感器对同一场景的图像信息进行整理综合,尽力消除图像信息间的冗余性,充分利用图像信息间的互补性,从而获得信息更精确、更全面的融合图像[1 ] .遥感数字图像中,全色图像空间分辨率高,但只有单个波段,缺乏光谱信息; 而多光谱图像具有多个光谱波段,光谱信息丰富,但空间分辨率低,清晰度差.因此,将全色图像与多光谱图像进行融合,有利于综合全色图像丰富的细节信息和多光谱图像较好的光谱信息,从而提高图像信息的利用率[2 ] .目前,遥感图像融合已广泛应用于军事图像处理、智能交通运输、土地利用调查等多个不同的领域[3 ⇓ -5 ] . ...

1

2020

... 图像融合是按照某种规则将单一传感器或多个传感器对同一场景的图像信息进行整理综合,尽力消除图像信息间的冗余性,充分利用图像信息间的互补性,从而获得信息更精确、更全面的融合图像[1 ] .遥感数字图像中,全色图像空间分辨率高,但只有单个波段,缺乏光谱信息; 而多光谱图像具有多个光谱波段,光谱信息丰富,但空间分辨率低,清晰度差.因此,将全色图像与多光谱图像进行融合,有利于综合全色图像丰富的细节信息和多光谱图像较好的光谱信息,从而提高图像信息的利用率[2 ] .目前,遥感图像融合已广泛应用于军事图像处理、智能交通运输、土地利用调查等多个不同的领域[3 ⇓ -5 ] . ...

Review and performance comparison of pansharpening algorithms for RASAT images

1

2018

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

A new IHS and wavelet based pansharpening algorithm for high spatial resolution satellite imagery

1

2020

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

Remote sensing image fusion based on nonlinear IHS and fast nonsubsampled contourlet transform

1

2018

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

Remote sensing image fusion method based on PCA and Curvelet transform

1

2018

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

结合Gram-Schmidt变换的高光谱影像谐波分析融合算法

1

2015

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

结合Gram-Schmidt变换的高光谱影像谐波分析融合算法

1

2015

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

Improving component substitution pansharpening through multivariate regression of MS+Pan data

1

2007

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

Multiresolution-based image fusion with additive wavelet decomposition

1

1999

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

Remote sensing image matching based improved ORB in NSCT domain

1

2019

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

自适应高斯滤波与SFIM模型相结合的全色多光谱影像融合方法

1

2018

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

自适应高斯滤波与SFIM模型相结合的全色多光谱影像融合方法

1

2018

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

The nonsubsampled Contourlet transform:Theory,design,and applications

1

2006

... 全色锐化(pansharpening)是指将全色图像与多光谱图像进行锐化融合.该方法主要可分为成分替换(component substitution, CS)法和多分辨率分析(multiresolution analysis, MRA)法[6 ] .CS类方法是将多光谱图像变换到另一个空间,分离出其光谱分量和空间细节分量,然后用全色图像替代部分分量,再变换回原空间的一类方法.该类融合方法中常见的算法有IHS法[7 -8 ] 、主成分分析(principal component analysis, PCA)法[9 ] 、Gram-Schmidt(GS)法[10 ] 、自适应Gram-Schmidt(Gram-Schmidt adaptive, GSA)法[11 ] .该类方法虽然简单,但融合效果较差.其中,传统IHS法仅适用于三波段的图像; PCA法和GS法光谱扭曲较大; GSA法在GS法基础上,通过线性回归模型估计各个波段的权重系数,进而生成融合结果,该方法虽然在一定程度上改善了融合质量,但却增加了计算复杂度.MRA方法是将全色图像进行多分辨率分解,将分解出来的细节注入到多光谱图像中,融合效果较好,常见的分解方法有多孔小波变换( a ` [12 ] 和非下采样轮廓波变换(nonsubsampled Contourlet transform, NSCT)法[13 ] 等.其他采用细节注入方法还有高通滤波(high pass filtering, HPF)法[2 ] 和基于平滑滤波器的强度调制(smoothing filter-based intensity modulation, SFIM)法[14 ] .其中,ATWT法采用平移不变的离散小波“ a ` [15 ] 提出的NSCT法,在保持小波变换的多分辨率和时频局部特性的同时,省去了小波的采样环节,克服了轮廓波等存在的伪吉布斯现象,可以更好地反映出图像的纹理信息. ...

High frequency (60-90 Hz) oscillations in primary visual cortex of awake monkey

2

1993

... 脉冲耦合神经网络(pulse coupled neural networks, PCNN)是Eckhorn等[16 ] 于20世纪末根据猫、猴视觉皮层脉冲同步发放实验而提出的一种生物神经网络,其良好的全局耦合和同步脉冲特性在图像融合中扮演着极其重要的角色.李凯[17 ] 提出了一种基于简化型PCNN和采用梯度能量作为清晰度度量标准的分块融合的多聚焦图像融合算法,实验取得了不错的效果,但多聚焦图像融合与多光谱遥感图像全色锐化原理不同,很难应用于遥感图像融合. ...

... PCNN的数学描述[16 ] 为: ...

1

2013

... 脉冲耦合神经网络(pulse coupled neural networks, PCNN)是Eckhorn等[16 ] 于20世纪末根据猫、猴视觉皮层脉冲同步发放实验而提出的一种生物神经网络,其良好的全局耦合和同步脉冲特性在图像融合中扮演着极其重要的角色.李凯[17 ] 提出了一种基于简化型PCNN和采用梯度能量作为清晰度度量标准的分块融合的多聚焦图像融合算法,实验取得了不错的效果,但多聚焦图像融合与多光谱遥感图像全色锐化原理不同,很难应用于遥感图像融合. ...

1

2013

... 脉冲耦合神经网络(pulse coupled neural networks, PCNN)是Eckhorn等[16 ] 于20世纪末根据猫、猴视觉皮层脉冲同步发放实验而提出的一种生物神经网络,其良好的全局耦合和同步脉冲特性在图像融合中扮演着极其重要的角色.李凯[17 ] 提出了一种基于简化型PCNN和采用梯度能量作为清晰度度量标准的分块融合的多聚焦图像融合算法,实验取得了不错的效果,但多聚焦图像融合与多光谱遥感图像全色锐化原理不同,很难应用于遥感图像融合. ...

NSCT-PCNN image fusion based on image gradient motivation

1

2018

... NSCT通过双通道非下采样二维滤波器组来实现,其中非下采样金字塔(nonsubsampled pyramid, NSP)滤波器组保证了多尺度特性,非下采样方向滤波器组(nonsubsampled direction filter bank, NSDFB)提供了方向特性[18 ] ,如图1 所示.首先原始图像经过NSP处理,得到一个低通子带图像和一个带通子带图像,然后将带通子带用NSDFB处理,得到一系列的带通方向子带图像,得到的低通子带可以重复NSP和NSDFB操作,实现图像的多尺度和多方向分解.当某一层的方向分解级数为l 时,图像被分解成2l [19 ] . ...

1

2019

... NSCT通过双通道非下采样二维滤波器组来实现,其中非下采样金字塔(nonsubsampled pyramid, NSP)滤波器组保证了多尺度特性,非下采样方向滤波器组(nonsubsampled direction filter bank, NSDFB)提供了方向特性[18 ] ,如图1 所示.首先原始图像经过NSP处理,得到一个低通子带图像和一个带通子带图像,然后将带通子带用NSDFB处理,得到一系列的带通方向子带图像,得到的低通子带可以重复NSP和NSDFB操作,实现图像的多尺度和多方向分解.当某一层的方向分解级数为l 时,图像被分解成2l [19 ] . ...

1

2019

... NSCT通过双通道非下采样二维滤波器组来实现,其中非下采样金字塔(nonsubsampled pyramid, NSP)滤波器组保证了多尺度特性,非下采样方向滤波器组(nonsubsampled direction filter bank, NSDFB)提供了方向特性[18 ] ,如图1 所示.首先原始图像经过NSP处理,得到一个低通子带图像和一个带通子带图像,然后将带通子带用NSDFB处理,得到一系列的带通方向子带图像,得到的低通子带可以重复NSP和NSDFB操作,实现图像的多尺度和多方向分解.当某一层的方向分解级数为l 时,图像被分解成2l [19 ] . ...

NSCT域内结合边缘特征和自适应PCNN的红外与可见光图像融合

1

2016

... PCNN由于其独特结构,使其具有同步脉冲发放、阈值动态变化、无训练机制和并行处理等有益于图像融合的特性.在进行图像融合时,PCNN是一个二维单层横向连接型神经网络.PCNN的一个神经元对应待处理的图像的一个像素,且每个神经元与其周围的8个神经元都有连接[20 ] . ...

NSCT域内结合边缘特征和自适应PCNN的红外与可见光图像融合

1

2016

... PCNN由于其独特结构,使其具有同步脉冲发放、阈值动态变化、无训练机制和并行处理等有益于图像融合的特性.在进行图像融合时,PCNN是一个二维单层横向连接型神经网络.PCNN的一个神经元对应待处理的图像的一个像素,且每个神经元与其周围的8个神经元都有连接[20 ] . ...