0 引言

随着航天技术的不断进步,成像卫星陆续发射,获取的卫星图像也越来越多。遥感图像数据可以分为2大类: 高光谱信息低空间信息的多光谱(multi-spectral, MS)图像和高空间信息低光谱信息的全色(panchromatic, PAN)图像。由于硬件基础的限制,成像卫星无法直接获取高光谱信息和高空间信息(multi-spectral with high-spatial resolution, HRMS)遥感图像。为此,研究人员采用全色锐化方法,将MS图像中的高光谱信息与PAN图像中的高空间信息进行融合,得到HRMS图像,为后续的识别与检测提供基础。

近年来,研究人员提出大量的遥感图像全色锐化算法,这些算法可以分为4类: 分量替换法(component substitution, CS),多分辨率分析法(multi-resolution analysis, MRA),变分优化法(variational optimization, VO)和基于深度学习(deep learning, DL)算法。CS算法的核心思想是利用MS图像和PAN图像的联系,提取PAN图像的高频部分,然后将高频部分注入到上采样的MS图像中,获得最终的融合图像HRMS。常用的CS算法有强度-色彩-饱和度转换(intensity-hue-saturation transformations,IHS) [1]和施密特正交化方法(Gram-Schmidt,GS)[2]等,这类算法获得的融合图像结构信息比较完整,但是会损失一些光谱信息。与CS算法不同,MRA算法使用滤波器或者滤波算子提取PAN图像的高频信息,然后将这些信息注入上采样的MS图像中,获取融合图像HRMS。如抽取或非抽取小波变换[3]和拉普拉斯金字塔法[4]等,这类算法可以避免一些光谱失真,但是在滤波过程中会损失一些结构信息。VO算法是基于变分模型的方法,这类模型包含光谱保真项、结构保真项和先验项。 Ballester 等[5]提出第一个VO算法,该算法假设融合图像所有通道的结构信息与PAN相同,获取的融合图像有很好的光谱表现,但是很难建立一个精确的模糊核,融合图像的结构保护项表现较差,容易产生边缘模糊。为了提高边缘细节,Fang 等[6]基于引导滤波函数构建变分模型的结构保护项,该算法在保护图像的边缘细节同时最小化融合图像的光谱失真; Fu等[7]采用局部梯度约束的方法提升模型的结构提取能力。这类算法基于合理的假设,构建线性模型获取融合图像,难以平衡融合图像的光谱质量和空间结构质量,同时VO需要迭代,融合图像所需时间较长。为了克服线性模型的局限性,大量研究人员尝试使用非线性的DL网络获取遥感融合图像。Masi等[8]首次将卷积神经网络(convolutional neural network,CNN)用于遥感图像全色锐化的网络模型PNN,但是该模型只有3层卷积,不能学习到深层的图像信息,在此基础上出现了越来越多的DL算法。

针对以上算法中存在的问题,本文结合VO算法和DL算法提出了一种新的多尺度端到端的遥感图像全色锐化算法。针对DL算法泛化性较弱提出具有光谱保护和结构保护的多深度神经网络算法,减小网络的深度,防止网络模型过拟合,提高模型泛化性能; 使用高频滤波得到结构保护模块的输入信息,减小网络中的冗余信息,提高运算效率,增加模型的泛化能力; 使用卷积层对PAN升维,与MS图像进行残差,增加图像不同通道间的联系,提高模型结构提取能力; 针对DL算法光谱信息失真问题使用残差结构将光谱信息与结构保护模块输出结合,减少光谱信息丢失,提高算法的光谱保护能力。

1 研究方法

1.1 基于VO的遥感全色锐化算法

本文用yP和yMS分别表示输入的PAN和MS图像,融合后的HRMS图像用x表示。VO算法将遥感图像全色锐化问题看成一个优化问题,主要包括能量函数的构造和优化求解2部分。根据理想融合图像与退化观测值之间的观测模型来构建能量函数,它们之间的关系表示为:

式中: yupM为上采样的MS图像; k为模糊核[10]; *为卷积符号。变分算法普遍假设PAN图像和HRMS图像有相同的结构信息,例如P+XS算法在图像域保护结构信息,它的结构保护项为:

1.2 基于神经网络的遥感全色锐化算法

近年来,CNN已成为遥感图像全色锐化最有效的工具之一。主要思路为: 设计一个网络模型,把MS图像和PAN图像作为网络输入,以端到端方式从数据中学习特征信息,最终获取HRMS图像。公式为:

式中: f()为一个深度神经网络;

2 基于高频域多深度网络模型的全色锐化算法

2.1 网络结构

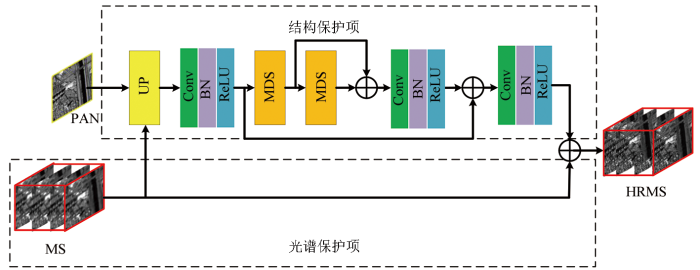

图1

本文在光谱保护项和结构保护项这2方面做了改进:

1)光谱保护项。为了保护光谱信息,本文将MS图像上采样到与HRMS图像大小相同,使用一个跳跃连接,将它链接到结构保护项的输出,与式(2)方法相比,本文没有使用模糊核,将HRMS图像退化,而是强制HRMS图像和MS图像共享光谱信息,利用深度网络自动纠正HRMS图像和MS图像的差异。

2)结构保护项。1.1节中介绍,很多VO算法假设HRMS图像的结构信息在PAN图像中可以获取,忽略MS图像中的一些结构信息,本文的结构保护项采用一个高频域多尺度残差网络,获取融合图像的结构信息。

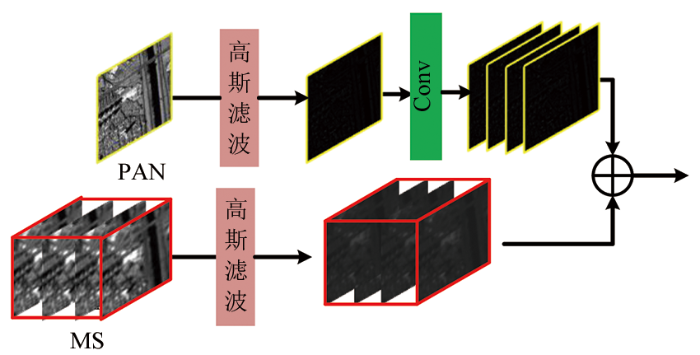

2.2 高频域输入模块

图2

表达式为:

式中: UP为高频域输入; R()为激活函数; sum为残差函数; H()为高斯滤波;

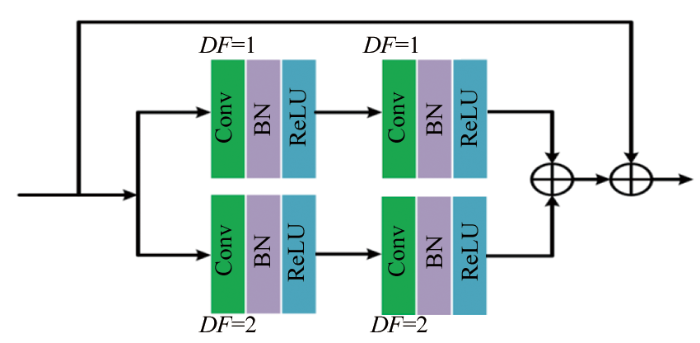

2.3 MDS模块

本文网络模型采用MDS模块来提取图像的结构信息,多深度模块减小网络模型的深度,有效避免过拟合的风险,同时可以提高模型的泛化性能。多尺度模块还可以提取多个位置的结构信息,增加网络的细节提取能力。MDS模块的表达式为:

图3

1)空洞卷积层。本文采用不同感受野的卷积核提取图像多尺度信息,传统卷积层中,通过采用不同大小卷积核来实现网络的多尺度提取,在同一个网络中采用不同大小的卷积核,可能会提高网络的计算负担,不同卷积核的网络层之间不能进行残差操作。本文用空洞卷积层实现网络的多尺度结构,它可以不改变卷积核大小,有效地提高卷积层的感受野,实现多尺度提取信息的目的,也不会增加网络的复杂度和计算负担,可以实现不同层之间的残差。空洞卷积层通过改变扩张因子的大小改变感受野,DF=1表示常规卷积层,DF=2表示一个5×5的卷积层。

2)归一化层。随着卷积层数的增加,计算负担增加,网络收敛需要更多的运行时间,归一化层旨在减少训练的收敛时间。归一化层可以通过层输入的固定均值和方差来减少内部协变量偏移,以加速训练,减少训练时间; 同时归一化层通过减少梯度对参数大小或其初始值的依赖,提高网络的泛化能力。

3)残差学习。随着卷积层数的增加,CNN可以实现更复杂的非线性映射,并且会导致训练精度变差。为了克服这个问题,残差学习被提出来引入一个相等的快速连接来解决梯度消失的问题。 残差学习在图像任务中具有突出的表现[25]。

4)激活函数层。激活函数可增加神经网络模型的非线性能力。本文使用的激活函数是ReLU函数。

3 实验与分析

3.1 实验设置

本文使用QuickBird(QB)卫星图像作为数据集,QB卫星中PAN图像空间分辨率为0.6 m; MS图像包括红光、绿光、蓝光和近红外波段,其空间分辨率为2.4 m。由于原始卫星数据中不存在网络训练需要的参考图像,本文遵循Wald协议建立训练数据集,具体过程如下: 对MS图像和PAN图像进行下采样操作,将原始的MS图像作为参考图像,下采样后的PAN图像作为网络的输入图像,下采样的比例是MS图像和PAN图像的空间分配率之比,同时在下采样之前使用一个高斯滤波器减少信息混叠。本文网络输入时,输入图像尺寸是一样的,所以下采样后的MS图像使用双三次插值法进行上采样。本文用于网络训练的数据集图像大小为32像元×32像元,用于实验测试的图像大小为200像元×200像元。实验中显示的是融合图像红绿蓝3通道的结果图。

本次实验数据集为6万多组数据其中10%为测试数据,一共迭代150个周期(大约20多万次),网络的训练数据批量输入块为32,的测试数据批量输入块为16。权重衰减为0.000 01,动量设置为0.9。最初的学习率设置为0.1,迭代次数每增加总迭代次数的1/10次学习率就更新为0.5倍。本次网络训练是在windows系统中的caffe框架下进行,使用GPU加速,网络模型的测试是在MATLAB2018a基础上使用caffe软件实现的。本次实验处理器为 Intel Core i7-8700 CPU @3.20 GHz,16 GB内存,显卡为NVIDIA GeForce GTX 1080 Ti。

3.2 实验结果与分析

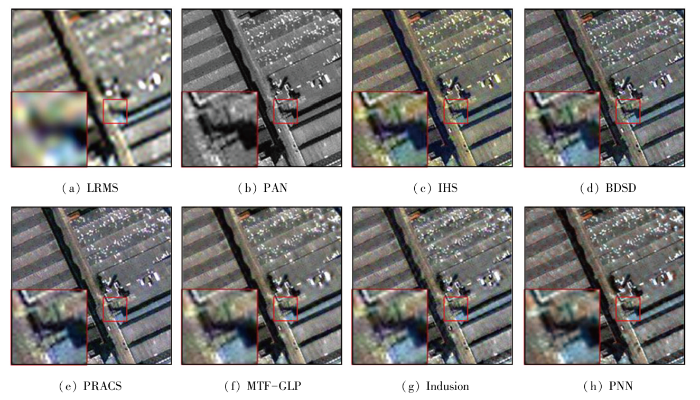

为了验证本文方法的有效性,选取多个对比算法,包括3个CS法(IHS[1],BDSD[26],PRACS[20]),2个MRA(MTF-GLP[27],Indusion[28]),2个DL算法(PNN[8],DMDP[19]),1个VO算法(GND[11])。为了客观地评价试验结果,实验采用5个有参考评价指标评价模拟实验结果,它们分别是: 通用图像质量指数(universal image quality index,Q),Q的4波段扩展(4 band extension of Q,Q4),相关系数(spacial correlation coefficient, SCC),光谱角映射(spectral angle mapper,SAM)和相对无量纲全局误差(erreur relative globale adimensionnelle de synthèse,ERGAS),其中SAM和ERGAS理想值为0,Q,SCC和Q4的理想值为1。在真实情况下,使用3个无参考评价指标: 量化空间失真

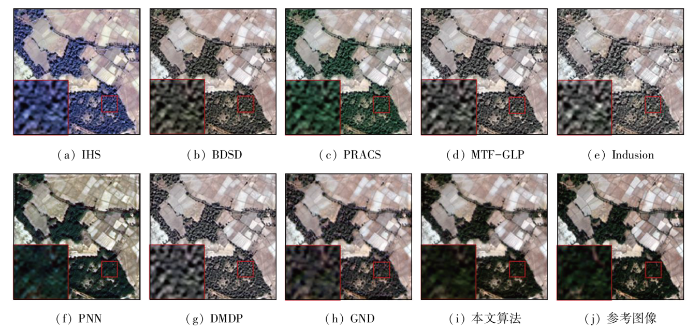

3.2.1 模拟图像实验

模拟数据集由100组遥感图像构成,图4为在QB模拟数集的主观测试结果,表1是有参考评价指标的平均结果,其中加粗的表示对比算法中的最优结果,加下划线的表示第二优结果。如图4所示,IHS和PRACS的融合图像在光谱变换时LRMS图像的光谱信息丢失,导致严重的光谱失真; MTF-GLP,Indusion和DMDP在变化域提取图像的结构信息,但是滤波器不能准确地过滤PAN图像和LRMS图像的重叠的结构信息,导致融合图像过增,同时牺牲了图像的光谱信息; PNN网络层过浅,在卷积时容易忽略一下信息,融合图像产生严重的光谱失真; BDSD的融合系数不够合理,导致融合图像丢失一些光谱信息; GND和本文方法都有不错的表现,但是GND的融合图像光谱有些失真,本文方法的光谱信息更接近于参考图像。从表1也可以看出,在测试数据集上,本文方法的指标优于其他对比算法。

图4

表1 模拟数据集客观评价指标

Tab.1

| 算法 | Q | SCC | Q4 | SAM | ERGAS |

|---|---|---|---|---|---|

| IHS | 0.834 6 | 0.910 6 | 0.806 8 | 3.549 1 | 3.241 0 |

| BDSD | 0.922 8 | 0.940 7 | 0.910 7 | 2.822 5 | 2.206 3 |

| PRACS | 0.919 5 | 0.935 3 | 0.911 5 | 2.927 9 | 2.217 6 |

| MTF-GLP | 0.914 8 | 0.934 8 | 0.906 6 | 2.815 7 | 2.322 0 |

| Indusion | 0.841 9 | 0.879 7 | 0.829 0 | 3.274 9 | 3.494 2 |

| PNN | 0.922 9 | 0.945 6 | 0.880 7 | 3.197 0 | 2.221 6 |

| DMDP | 0.911 2 | 0.924 3 | 0.887 8 | 2.661 3 | 2.395 2 |

| GND | 0.936 1 | 0.954 9 | 0.918 4 | 2.277 0 | 1.916 1 |

| 本文算法 | 0.945 5 | 0.961 5 | 0.932 5 | 2.175 2 | 1.743 9 |

| 理想值 | 1 | 1 | 1 | 0 | 0 |

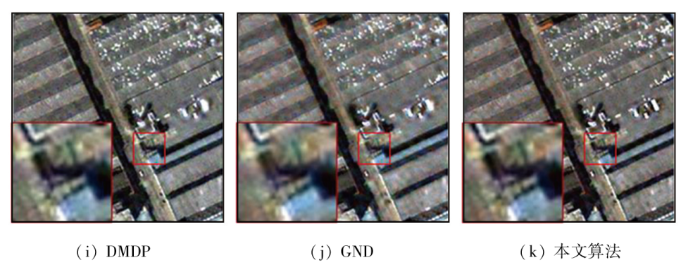

3.2.2 真实图像实验

真实数据集由50组遥感图像组成,图5是一组在QB真实数集的主观测试结果,表2是无参考评价指标的平均结果,其中加粗的表示对比算法中的最优结果,加下划线的表示第二优结果。如图5所示,IHS,PRACS和PNN的融合结果空间信息保护的相对完好,但是与LRMS图像相比,它们的光谱信息存在比较严重的失真; MTF-GLP和Indusion的融合结果光谱相对完整,它们的边缘细节,如白色厂房的边缘信息存在较多的伪影; DMDP和GND同样存在结构细节丢失问题; BDSD和本文方法空间信息和光谱信息的保护结果都很好,但是BDSD的融合图像光谱表现比本文方法略差。从表2也可以看出,在测试数据集上,本文方法的指标优于其他对比算法。

图5-1

图5-2

表2 真实数据集客观评价指标

Tab.2

| 算法 | QNR | ||

|---|---|---|---|

| IHS | 0.141 6 | 0.255 3 | 0.639 6 |

| BDSD | 0.065 4 | 0.179 9 | 0.767 1 |

| PRACS | 0.087 9 | 0.228 2 | 0.713 9 |

| MTF-GLP | 0.121 5 | 0.220 7 | 0.685 5 |

| Indusion | 0.113 9 | 0.603 0 | 0.350 6 |

| PNN | 0.068 5 | 0.603 5 | 0.368 3 |

| DMDP | 0.085 2 | 0.168 8 | 0.761 1 |

| GND | 0.073 8 | 0.110 5 | 0.822 7 |

| 本文算法 | 0.050 6 | 0.121 6 | 0.833 7 |

| 理想值 | 0 | 0 | 1 |

3.2.3 泛化实验

为了验证本文模型的泛化能力,直接使用QB卫星的遥感数据训练的模型测试IKONOS的遥感数据,实验结果如图6所示。IHS,PNN和GND融合图像的空间结构信息相对完整,在融合过程中丢失太多的光谱信息,导致严重的光谱失真; MTF-GLP,Indusion和DMDP融合结果的光谱保护相对完整,它们的空间结构信息出现过度增强,边缘有伪影; PRACS 融合图像空间结构缺失,边缘模糊; BDSD和本文方法的融合图像效果都很好,但是本文方法的光谱表现比BDSD好一些。

图6

3.2.4 消融实验

为了验证模型的有效性,对其进行消融测试,分为3部分: -UP表示利用常规的输入代替本文提出的UP模块; -MS表示使用级联空洞积层代替宽度学习模块; -DS表示使用普通卷积层代替MDS中的空洞卷积。在模拟图像数据集上对3种算法进行测试,实验结果如表3所示,本文提出的算法在各方面都优于3种变体算法(-UP,-MS,-DS)。

表3 消融实验客观评价指标

Tab.3

| 测试方案 | Q | SCC | Q4 | SAM | ERGAS |

|---|---|---|---|---|---|

| -UP | 0.944 0 | 0.942 8 | 0.937 1 | 3.176 0 | 2.523 1 |

| -MS | 0.9434 | 0.934 6 | 0.936 1 | 3.316 9 | 2.625 3 |

| -DS | 0.947 8 | 0.934 6 | 0.941 1 | 3.215 9 | 2.543 3 |

| 本文算法 | 0.948 6 | 0.940 3 | 0.941 5 | 3.156 1 | 2.482 2 |

| 理想值 | 1 | 1 | 1 | 0 | 0 |

4 结论

本文对传统遥感图像全色锐化算法通常出现的光谱失真或者结构失真问题,和DL算法泛化性较低问题,基于VO框架模型,提出一个新的遥感图像全色锐化算法。该算法将深度网络分为光谱保护和结构保护2部分,通过网络学习得到最终的融合结果。在结构保护网络模块: 预处理采用高频滤波,得到PAN和MS图像的高频,在高频域处理结构信息,可以增加模型的泛化能力; 对PAN图像升维,然后与MS图像相加,有助于网络提取不同通道的LRMS图像和PAN图像的共同特征,增加模型特征提取能力; 采用多尺度残差模块,防止浅层信息消失,增加模型提取不同位置特征的能力,为融合图像提供丰富的结构信息; 采用光谱保护模块,使用一个跳跃连接,将它链接到结构保护项的输出,避免人为估算模糊核导致的误差,减小融合图像的光谱失真。

实验结果表明,本文方法可以有效地平衡光谱与空间结构信息,减小光谱失真和空间结构的丢失,相对于对比算法,本文采用的模型泛化性能更强。下一步研究会尝试对PAN图像升维,同时加入注意力机制,增加图像通道间的内在联系,并且改进多尺度模块,降低模型的计算复杂度,在保证网络性能的同时提高模型的效率。

参考文献

The use of intensity-hue-saturation transformations for merging SPOT panchromatic and multispectral image data

[J].

A context-driven pansharpening method using superpixel based texture analysis

[J].

A variational model for P+XS image fusion

[J].

A variational approach for pan-sharpening

[J].

A variational pan-sharpening with local gradient constraints

[C]//

Pansharpening by convolutional neural networks

[J].

High-quality Bayesian pansharpening

[J].

An efficient and high-quality pansharpening model based on conditional random fields

[J].

Pan-sharpening via a gradient-based deep network prior

[J].

Bayesian pan-sharpening with multiorder gradient-based deep network constraints

[J].

Going deeper with densely connected convolutional neural networks for multispectral pansharpening

[J].

Framelet based pan-sharpening via a variational method

[J].

Target-adaptive CNN-based pansharpening

[J].

A multiscale and multidepth convolutional neural network for remote sensing imagery pan-sharpening

[J].

Shallow-deep convolutional network and spectral-discrimination-based detail injection for multispectral imagery pan-sharpening

[J].

Pan-sharpening via multiscale dynamic convolutional neural network

[J].

Deep multiscale detail networks for multiband spectral image sharpening

[J].

A new adaptive component-substitution-based satellite image fusion by using partial replacement

[J].

融合多尺度特征的国产光学影像辐射异常分类检测

[J].

Classification and detection of radiation anomalies in Chinese optical satellite images by integrating multi-scale features

[J].

Dropout vs.batch normalization:An empirical study of their impact to deep learning

[J].

Rectified linear units improve restricted boltzmann machines

[C]//

基于残差网络特征融合的高光谱图像分类

[J].

Classification of hyperspectral image based on feature fusion of residual network

[J].

Multiple improved residual networks for medical image super-resolution

[J].

Optimal MMSE pan sharpening of very high resolution multispectral images

[J].

Comparison of pansharpening algorithms:Outcome of the 2006 GRS-S data-fusion contest

[J].

Indusion:Fusion of multispectral and panchromatic images using the induction scaling technique

[J].