0 引言

建筑物是人类生产生活的重要场所,当地震发生时,建筑物发生损坏甚至倒塌,对人类的生命财产安全造成极大的威胁。据国家应急管理部信息,2022年全国自然灾害造成1.12亿人次受灾,倒塌房屋4.7万间,不同程度损坏79.6万间[1]。由于地震具有突发性,带来的危害无法完全预防,因此,灾后救援和灾情评估工作的效率亟待提高。

遥感技术是一种全面、快速开展震后损毁建筑物评估的手段[2]。随着高分辨率遥感影像的获取便捷性和使用普及度不断提高,基于遥感影像进行场景识别和分类的研究也得到了广泛关注。深度学习在基于遥感影像的灾情评估中发挥了巨大的作用[3],深度学习是一种能够从数据中自动学习特征并进行预测的机器学习方法,它已经被成功应用于基于遥感影像的场景分类[4-5]。数据和算法是提高深度学习模型性能的2个关键因素,目前大部分研究集中在设计更复杂和更先进的算法上,但这类研究已经达到相对饱和。相比之下,数据研究未得到足够重视。数据是遥感场景图片分类任务的基础和驱动力,图片样本集的质量会直接影响到场景分类结果,因此,构建高质量的遥感场景图片样本集是实现高精度场景分类结果的重要前提[6]。

构建高质量的损毁建筑遥感场景图片样本集是遥感研究领域的一项难题。在过去的研究中,一些公开的遥感场景图片样本集已经被广泛使用,如UC Merced Land-Use12[7]和NWPU-RESISC453[8],它们拥有丰富的场景类型和庞大的数据规模,然而因其在损毁类别上的空缺,它们并无法应用于灾情评估这样特殊的场景。为解决这一不足,各种损毁建筑遥感场景图片样本集被陆续提出。Xie等[9]利用DigitalGlobe提供的开源灾难图像构建了2010年海地地震的损毁建筑数据集; Chen等[10]基于2017年美国飓风哈维过后的休斯顿地区构建了一个用于受损建筑检测的基准数据集。但这些数据集都是为了满足特定的研究课题而构建的,没有形成统一的标准和规范,也没有考虑在其他场景中应用的可能性。为克服以上局限性,卡内基梅隆大学的学者构建了xBD数据集[11],它是迄今为止最大的建筑物损毁评估数据集,涵盖15个国家的数据,在超过4.5万km2的影像中标注了超过80万个的建筑注释。但是,xBD数据集并非专门为评估地震灾情而构建,它还覆盖了其他灾害类型,如飓风、海啸和火山喷发等,地震灾害的数据占比只有18%。由此可见,目前用于震后损毁评估的遥感场景图片样本非常有限。

如何在有限的数据下构建高质量的样本集,是提升场景图片分类结果的关键。目前优化样本集的方案主要有数据清洗、数据增强和数据生成等,它们偏重于对已有样本集的纯化与扩增,没有在样本创建之初对场景图片进行有效的优化。为了从根本上改善样本集的质量,有必要在样本创建阶段设计优化策略,传统的样本创建方法一般基于固定大小进行裁剪,没有充分利用遥感数据中的潜在信息。在场景图片分类中,上下文信息的利用可以提高数据的挖掘效率。遥感领域的上下文信息一般指单个目标与周围地物之间存在的某种联系[12],它是遥感影像解译的重要依据,可以为目标推断提供有用的线索[13]。目前已有许多研究证明上下文信息对遥感影像分析的积极影响,张路等[14]通过引入邻域像元间的空间距离作为上下文信息来改进算法,从而提高了模糊聚类的精度; 陈丁等[15]采用上下文信息模块来增强模型的感受野,提出了一种基于多层特征和上下文信息相结合的光学遥感影像目标检测方法; Wang等[16]通过上下文信息增强了损毁建筑物的特征表达,从而提高了目标检测模型的准确性。由此可见,上下文信息的引入有利于提高场景分类精度。但是,有学者表示引入过多的上下文信息会造成大量无关的背景信息进入分类器[17],增加场景图片分类的难度,从而对判别结果产生负面影响。因此,场景图片中的上下文信息占比需要在合理范围内调整,以平衡样本集的线索丰富度和信息冗余度。目前,遥感场景图片样本集的构建方法中,缺乏对上下文信息合适比例的研究。

本文针对损毁建筑遥感场景图片样本集的构建方法,探讨样本集中合理的上下文信息比例设置范围,总结具有普适性的样本构建规律,以便充分利用有限的震后损毁建筑遥感影像,构建更加优质的样本集。本文构建了6组不同上下文信息占比的场景图片样本集,通过卷积神经网络(convolutional neural network,CNN)模型进行图片分类实验,评估不同模型的分类性能和不同比例的上下文信息对场景图片分类的影响,最终得到构建样本集的最佳上下文信息比例设置范围,以期为损毁建筑遥感影像场景样本集的构建和优化提供有价值的参考。

1 研究方法

1.1 CNN网络

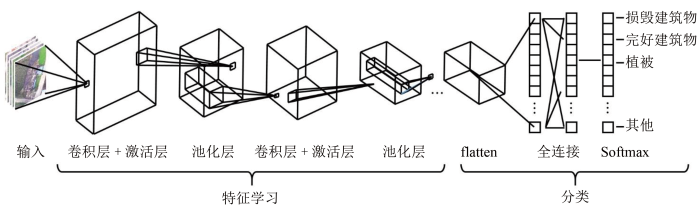

图1

图1

基于CNN网络进行遥感场景图片分类的一般框架

Fig.1

A general framework of remote sensing scene image classification based on CNN

随着计算机视觉领域的发展,CNN经历了从简单到复杂、从浅层到深层、从单核到多核、从串行到并行等多个阶段,在众多领域实现了广泛应用,并催生了许多新的网络结构和模块。本研究选择5种经典模型进行实验,分别是: AlexNet,VGGNet,GoogLeNet,ResNet和SqueezeNet。这5个模型代表了不同层次和结构的CNN网络,具备不同的参数量和计算复杂度,通过它们可以验证研究得到的规律是否具有普适性,从而保证实验的稳定性,避免使用单一模型受到特定性能的影响。

需要注意的是,本文的重点不在于选择最优的网络模型或追求更高的分类准确率,而是探讨不同上下文信息占比对损毁建筑遥感场景图片样本集构建的影响规律,模型种类的选择对于实验结论无显著影响。但相比于更复杂、高级的CNN模型,本文选择的模型具有一定实操优势: 从应用角度来看,本研究选择的模型已经在丰富的场景下得到验证与应用,具有较高的可迁移性,而过于复杂的CNN模型一般是针对特定任务设计的,不具备对多样化图片分类任务的泛化能力; 从验证成本来看,本研究选择的网络相对基础、高效与稳定,能在有限的资源和时间条件下达到较好的效果,而过于复杂的CNN模型会带来更高的计算复杂度和训练难度。由此可见,选择经典的CNN模型并不会影响研究的结论,反而可以更好地保证实验的可控性和稳定性,提高研究的可重复性和可信度。

1.2 实验数据处理方法

1.2.1 数据介绍

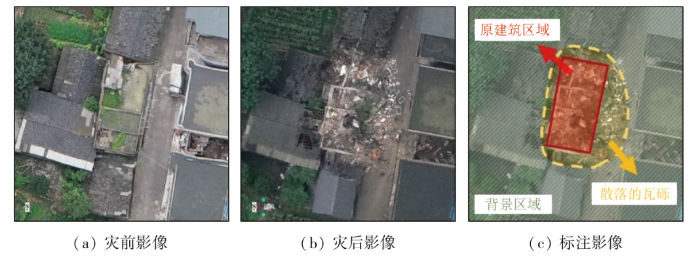

图2

1.2.2 数据预处理

本研究采用ENVI软件对震前震后的影像进行配准。在进行影像配准时,使用Image to Image Re-gistration工具,将震后遥感影像设置为基准影像,将震前遥感影像设置为待配准影像。由于2张影像之间存在时间差异、数据源差异和分辨率差异等问题,自动匹配的特征点较少,需要手动添加特征点。通过手动添加特征点的方式进行影像配准,能够使得2张影像的绝大多数地物处于相同的空间位置上。

在进行地物标记时,选择ROI工具中的多边形绘制功能进行损毁建筑物轮廓的勾绘。然而,由于损毁建筑物形态各异,轻度损毁和完好的建筑物具有非常相似的外观,而倒塌建筑物很难找到清晰的边缘,因此,在绘制多边形之前需要参考震前遥感影像,以确定建筑物的位置和轮廓,对绘制区域的位置、大小、形状等进行必要的调整。

为了提高损毁建筑遥感场景图片样本集的多样性和可靠性,本研究除了标注损毁建筑物外,还另外标注了4种地物类别,分别是: 完好建筑物、植被、不透水地面和裸地。这有助于模型学习不同地物场景之间的特征和差异,进而提高分类准确性和模型泛化能力。最终,本文得到5种场景类别共1 977个标注。

1.3 场景图片中上下文信息占比的调整方法

1.3.1 损毁建筑物的上下文信息

在遥感场景图片样本中,损毁建筑物的上下文信息通常应该包括:

1)散落物。损毁建筑物周围可能会出现脱落的瓦砾或碎石,这些散落物的状况可以辅助判断建筑物损毁的程度。例如,完全倒塌的建筑物往往伴随着更大规模的破坏,而部分倒塌的建筑物则可能只影响局部区域。

2)周边环境。损毁建筑物周边的地物可以辅助判断建筑物所属的类型和功能。例如,如果目标建筑物周围有工厂、仓库或者农田,说明该建筑物可能是用于生产和存储的; 如果目标建筑物周围有学校、医院或商场,说明该建筑物可能是用于教育、医疗或消费的。不同功能的建筑物对应不同的灾后抢险优先级。

3)建筑群类型。损毁建筑物所处的建筑群类别可以辅助判别建筑物的抗震级别。例如,居民住宅区的楼房通常具有更好的抗震能力,因为住宅区多采用钢筋混凝土的框架结构,而部分老旧城镇或农村中未经抗震设防的土木、砖木、石木等房屋更容易受损。

在图3所展示的遥感场景中,可以观察出该建筑物位于一个农村住宅区域,周边房屋类型主要为未经抗震设防的砖混结构房屋。在灾后的影像中,损毁建筑物周围散落的碎石和瓦砾甚至占据了部分道路区域。这些细节信息都能够作为损毁建筑场景图片的重要上下文信息。

图3

图3

损毁建筑遥感场景图片中上下文信息的示例

Fig.3

An example of contextual information in a remote sensing image of damaged building

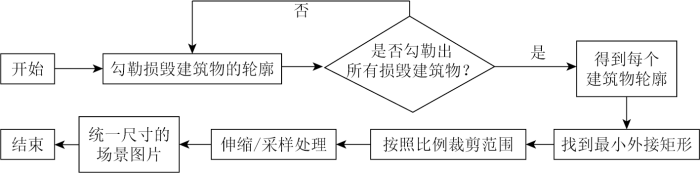

1.3.2 基于不同上下文信息占比的图片裁剪方法

为了调整损毁建筑遥感场景图片中的上下文信息占比,本文提出了一种根据预设比例,向外拓展最小外接矩形的图片裁剪方法。以损毁建筑物类别为例,图片裁剪的流程如图4所示。首先,对震后影像中所有损毁建筑物的轮廓进勾绘,将每个轮廓作为一个独立的多边形进行处理。接着,确定每个多边形的最小外接矩形,并按照所需的比例对其进行等比扩展,得到新的矩形范围。最后,对原影像进行裁剪,并通过采样处理调整为统一的尺寸,获得特定比例上下文信息的场景图片样本。

图4

图4

裁剪多组遥感场景图片样本的大致流程

Fig.4

General process of cutting multiple sets of remote sensing scene images

具体的思路可以用如下数学方式进行描述: 假设整张遥感影像的左上角坐标为(0, 0),影像的单位长度为1。对一个损毁建筑物轮廓进行处理,获取不规则多边形的顶点坐标:

新区域的左上角坐标为

在计算裁剪图片顶点坐标的过程中,本研究令最小外接矩形与裁剪矩形的面积比值为

为保证裁剪区域包含完整的损毁建筑物信息,裁剪区域需要在最小外接矩形的基础上向外扩展,则

最终,裁剪区域的顶点坐标为:

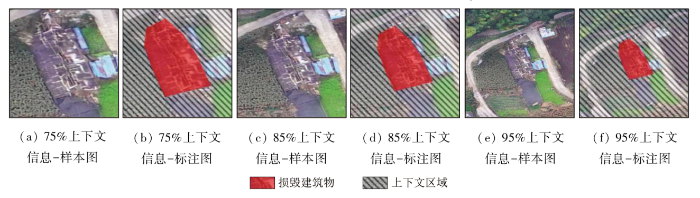

图5展示了3种不同上下文信息占比的样本,分别对应75%,85%,95%这3个比例,其中,标红区域为损毁建筑物区域,划线区域为样本的上下文区域。可以看出,当上下文信息占比越高时,场景图片中信息会越多,但中心地物的面积比例也随之下降。

图5

图5

不同上下文信息占比的场景图片示例

Fig.5

Examples of scene images with different context information proportions

2 实验分析与讨论

2.1 实验设计

本研究旨在通过实验找到损毁建筑遥感场景图片样本集中上下文信息比例的最佳设置范围,从而为样本集的构建提供建议。同时,本文也通过比较多个CNN模型的性能,为基于损毁建筑物的遥感场景图片分类的模型选择提供了参考和建议。实验步骤概括如下:

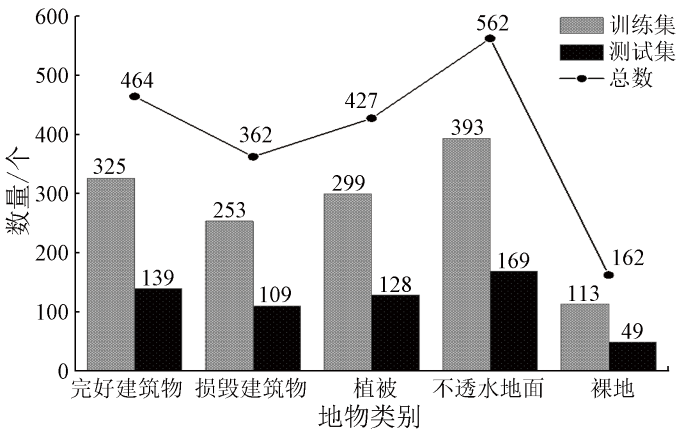

1)多个损毁建筑遥感场景图片样本集的构建。按照70%,75%,80%,85%,90%和95%的上下文信息占比,对无人机影像进行裁剪和采样,得到6组尺寸为256像素×256像素的样本。每个样本有5个类别,分别是: 完好建筑物、损毁建筑物、植被、不透水地面和裸地。本文从每个类别中随机选取70%作为训练集,其余30%作为测试集,图片样本的具体数量分布如图6所示。

图6

图6

每个数据集中不同地物类别的分布情况

Fig.6

Distribution of different land cover types in each dataset

2)多个场景图片样本集的分类实验。本研究采用5种CNN模型在6个样本集上进行3轮实验,所有模型均使用预训练的权重参数,训练集和测试集的比例为7∶3,学习率为0.001,批量大小为10,训练迭代次数为100个epoch,最后对3轮实验的测试准确率计算平均值并作为最终的测试结果,消除偶然因素的影响。

3)多个模型和数据集的评估。本文使用准确率(accuracy)指标作为模型性能的评价标准,它表示分类器正确分类的样本数占总样本数的比例。具体的评估工作包括2个步骤: ①计算每个模型在所有上下文信息比例下的平均分类准确率,评估不同模型在研究中的适应性; ②计算每种上下文信息比例在所有模型下的平均分类准确率,对比不同上下文信息占比对场景图片分类结果的影响。

2.2 实验结果及分析

本文采用AlexNet,VGGNet,GoogLeNet,ResNet和SqueezeNet这5种经典CNN模型对6组样本集进行3轮实验,并计算3轮实验的平均值作为实验结果,如表1所示。通过计算,本文得到了5个模型在不同上下文信息比例下的平均准确率,分别为: 90.27%,92.18%,93.13%,89.62%和90.66%。同时,本文也计算了70%,75%,80%,85%,90%和95%这6种上下文信息比例在所有模型下的平均准确率,分别为: 92.11%,92.16%,92.22%,91.18%,90.33%和89.03%。

表1 分类实验结果表

Tab.1

| 模型 | 模型平均 | 上下文信息占比 | |||||

|---|---|---|---|---|---|---|---|

| 70 | 75 | 80 | 85 | 90 | 95 | ||

| AlexNet | 90.27 | 90.40 | 90.40 | 90.52 | 90.63 | 90.40 | 89.28 |

| VGGNet | 92.18 | 92.42 | 92.20 | 92.59 | 92.42 | 92.14 | 91.30 |

| GoogLeNet | 93.13 | 93.99 | 94.22 | 93.99 | 93.21 | 92.20 | 91.19 |

| ResNet | 89.62 | 91.75 | 91.98 | 91.81 | 88.78 | 86.92 | 86.48 |

| SqueezeNet | 90.66 | 91.98 | 91.98 | 92.20 | 90.85 | 90.01 | 86.92 |

| 上下文信息占比平均 | — | 92.11 | 92.16 | 92.22 | 91.18 | 90.33 | 89.03 |

对上述CNN模型在损毁建筑遥感场景图片分类问题中的表现进行分析,可得:

1)不同模型在不同上下文信息占比下的表现有所不同,范围在86.48%~94.22%。

2)同一模型在不同上下文信息占比下的表现也存在一定差异。例如,SqueezeNet在80%的上下文信息占比下的准确率为92.20%,而在95%的上下文信息占比下的准确率为86.92%。

3)不同模型的最高准确率对应的上下文信息比例不一定相同。例如AlexNet模型的最高准确率为90.63%,最佳上下文比例为85%; VGGNet和SqueezeNet模型的最高准确率分别为92.59%和92.20%,最佳上下文比例为80%; 而GoogLeNet和ResNet模型的最高准确率分别为94.22%和91.98%。最佳上下文比例为75%。

4)通过模型的平均准确率来看,GoogLeNet和VGGNet模型的性能表现较好,而ResNet的分类性能表现较差,这可能与网络结构与任务类型有关,另外,本研究采用的是预训练的权重参数,对模型性能会产生一定影响,因此,后续研究可以通过微调模型参数来减小实验误差。

观察每种上下文信息比例下各个模型的表现,可以看出:

1)当上下文比例信息为70%的时候,所有模型的分类准确率已经处于比较高的水平,随着上下文信息比例的增加,模型的分类准确率又有所提高,在使用80%的上下文信息时,模型的表达最好,达到了92.22%的平均准确率。

2)当上下文信息比例过高时,准确率并没有提升,甚至出现了下降的情况,在上下文信息比例为95%的时候,所有模型的分类准确率都比较低。因此,本研究认为最佳上下文信息量的比例在70%~80%之间,可以在构建损毁建筑样本的时候参考该比例范围进行设定。

2.3 讨论

本文以优化损毁建筑遥感场景图片样本集的构建方法为目标,探讨了不同占比的上下文信息对样本集构建质量的影响,并通过CNN进行场景图片分类实验来寻找合理的上下文信息比例设置范围。由于本文旨在探索上下文信息占比对样本集构建质量和分类性能的影响规律,选择更复杂的CNN模型会带来更高的计算复杂度和训练难度,不利于研究的可重复性和迁移性,因此本文采用经典CNN模型,在验证规律普适性与稳定性的基础上,让实验效率和成本得到最大程度优化。

本文的创新点在于: 相较于其他构建样本集的方法,本文充分利用了遥感数据中的潜在信息,在样本创建阶段设计了优化策略来提高样本集的质量。本文得到以下2点优化意见:

1)在构建损毁建筑遥感场景图片样本集时,将上下文信息的占比设置在70%~80%可以获得较好的分类性能。实验发现,上下文信息占比会影响损毁建筑遥感场景图片分类性能: 当上下文信息占比在80%~95%时,计算复杂度和噪声干扰会随着上下文信息比例增加而增加,分类准确率逐渐下降; 当上下文信息占比在70%~80%时,场景图片分类准确度会保持在较高的水平。

2)在进行损毁建筑遥感场景图片分类时,使用GoogLeNet具有较好的泛化能力。实验发现,不同CNN对不同上下文信息占比的样本集处理性能存在差异: ResNet和SqueezeNet对上下文信息占比变化敏感,准确率波动大; AlexNet和VGGNet对于上下文信息占比的变化较鲁棒,准确率波动小; GoogLeNet对上下文信息占比变化适应性强,准确率保持在较高水平。

本研究存在一些局限性:

1)本研究采用人工标注的方法勾勒地物轮廓,受主观判断影响大、效率低、易造成数据标注偏差,未考虑其他更高效和准确的数据标注方式;

2)本研究只采用四川泸定的地震影像构建了1 977张场景图片,数据源单一,样本规模较小,未考虑不同地区、时间、损毁程度等因素对损毁建筑遥感场景图片特征的影响;

3)本研究只采用准确率作为模型评估指标,未使用其他模型评估指标。

3 结论与展望

3.1 结论

1)本研究针对损毁建筑遥感场景图片样本集构建过程,提出一种调节上下文信息占比的图片裁剪方法,即通过预设比例向外拓展最小外接矩形,在保证目标类别完整的前提下获取不同上下文信息占比的场景图片。该方法解决了数据增强等传统方法不能充分利用遥感数据潜在信息的问题,填补了样本集优化方法在样本初始创建阶段的空白。该方法为自然灾害评估的遥感场景图片样本集提供了新的构建思路,适用于需要结合上下文信息分析受灾区域和程度的场景图片,如地震、火山、泥石流等灾情图片。

2)本研究通过多个经典CNN模型进行场景图片分类实验,发现了上下文信息占比对场景图片分类性能的普适性影响规律,即在构建损毁建筑遥感场景图片样本集时,将上下文信息占比设置在70%~80%可以获得较好的分类性能。该结论可以帮助研究者更好地构建遥感场景图片样本集,防止过多或过少的上下文信息影响分类器的学习效果,该结论不仅适用损毁建筑遥感场景图片,还可以为其他类型的场景图片构建提供参考和借鉴,为深度学习的模型训练和优化提供更有效的数据支持。

3.2 展望

针对本文的实验结果,未来有2方面值得深入探讨:

1)更多类型的场景图片样本构建。本研究以损毁建筑物为例进行实验,本研究的方法同样适用于其他类型的图片样本集,特别是需要结合上下文信息综合分析的场景图片,未来可以进一步探究不同场景类型图片中上下文信息占比的影响规律和最佳的占比范围。

2)更合理的上下文信息调整策略。本研究为保证场景图片包含完整的地物信息,默认裁剪的范围不小于损毁区域的最小外接矩形,在保留一定上下文信息的基础上,增加相邻区域的上下文信息,未来研究可以探索更加灵活的上下文信息调整方法,比如根据建筑物的损毁程度,动态调整裁剪范围和上下文信息的比例。

针对本研究的局限性,未来还有以下几方面值得改进:

1)数据标注方式。本研究采用人工方式标记地物,未来可以采用更多元化的数据标注方法,例如合成标注、程序化标注、外包等。

2)数据集质量。本研究的数据仅包含四川泸定地震的遥感影像,未来可以考虑加入其他地点的震后遥感数据,扩展遥感场景图片样本集的规模和多样性。

3)模型评估指标。本研究只采用准确率作为模型评估指标,未来可以考虑使用更加全面和客观的评估指标,如召回率、精确率和F1值等。

参考文献

遥感技术在震后建筑物损毁检测中的应用

[J].

Application of remote sensing technology in earthquake-induced building damage detection

[J].

Deep learning-based change detection in remote sensing images:A review

[J].

Error-tolerant deep learning for remote sensing image scene classification

[J].

Deep learning in remote sensing scene classification:A data augmentation enhanced convolutional neural network framework

[J].

遥感影像样本数据集研究综述

[J].

A review for sample datasets of remote sensing imagery

[J].

Bag-of-visual-words and spatial extensions for land-use classification

[C]//

Building disaster damage assessment in satellite imagery with multi-temporal fusion

[J/OL].

Damaged building detection from post-earthquake remote sensing imagery considering heterogeneity characteristics

[J].

Benchmark dataset for automatic damaged building detection from post-hurricane remotely sensed imagery

[J/OL].

Creating xBD:A dataset for assessing building damage from satellite imagery

[C]//

基于深度学习的小目标检测方法综述

[J].

Survey of small object detection methods based on deep learning

[J].

基于多尺度整体嵌套池化语义的装甲目标检测

[J].

An improve multi-scale holistically-nested pooling semantics for object detection

[J].

一种顾及上下文的遥感影像模糊聚类

[J].

Contextual fuzzy clustering of remote sensing imagery

[J].

多层特征与上下文信息相结合的光学遥感影像目标检测

[J].

DOI:10.11947/j.AGCS.2019.20180431

[本文引用: 1]

目标检测是遥感影像分析的基础和关键。针对光学遥感影像中目标尺度多样、小目标居多、相似性及背景复杂等问题,本文提出一种将卷积神经网络(CNN)和混合波尔兹曼机(HRBM)相结合的遥感影像目标检测方法。首先设计细节—语义特征融合网络(D-SFN)提取卷积神经网络低层和高层融合特征,提升目标特征的判别力,特别是小目标;其次考虑上下文信息对目标检测的影响,结合上下文信息进一步加强目标表征的准确性,提升检测精度。在NWPU数据集上试验表明,本文方法能够显著提升目标检测精度且具有一定程度的稳健性。

Object detection in optical remote sensing images based on combination of multi-layer feature and context information

[J].

DOI:10.11947/j.AGCS.2019.20180431

[本文引用: 1]

Object detection is the basic and key step of remote sensing image analysis. In optical remote sensing images, object detection faced many challenges such as multi-scale and small objects, appearance ambiguity and complicated background. To address these problems, a new method of object detection based on convolutional neural networks (CNN) and hybrid restricted boltzmann machine (HRBM) is proposed. Firstly, the detail-semantic feature fusion network (D-SFN) is designed to extract fusion features from low-level and high-level CNNs, which can make the target representation more distinguishable, especially for small objects. Secondly, context information is incorporated to further boost feature discrimination, which also improves the detection accuracy. Experiments on NWPU datasets show that the proposed method can significantly improve the accuracy of object detection and has certain robustness.

Earthquake-damaged buildings detection in very high-resolution remote sensing images based on object context and boundary enhanced loss

[J].

A contextual bidirectional enhancement method for remote sensing image object detection

[J].

Backpropagation applied to handwritten zip code recognition

[J].

四川泸定6.8级地震导致房屋道路等基础设施受损严重

[EB/OL].

The 6.8-magnitude earthquake in Luding,Sichuan caused serious damage to houses,roads and other infrastructure

[EB/OL].

四川泸定6.8级地震已造成93人遇难、25人失联

[EB/OL].

The 6.8-magnitude earthquake in Luding,Sichuan has caused 93 deaths and 25 missing

[EB/OL].