0 引言

遥感图像目标检测技术在城市交通管理、森林资源检测、自然灾害营救等领域都有着广泛的应用。传统遥感图像目标检测方法的特征表达通过人工提取,存在计算复杂度高和复杂场景下鲁棒性差的缺陷[1 ] ,并且强烈依赖于数据本身的特征。随着深度学习在目标检测的应用[2 ] , 基于深度学习的遥感图像目标检测方法也被广泛应用,相比于传统遥感图像目标检测方法,其具有适应性强、泛化能力广、在复杂条件下鲁棒性更好的优势[3 ] ,但因遥感图像具有多尺度且小目标多信息少等特点,当前的检测性能仍有提升的空间,如何有效提取小目标语义特征,降低小目标的误检、漏检与提高检测实时性是该领域亟须解决的问题[4 ] 。

目前以卷积神经网络(convolutional neural network, CNN)为主的目标检测方法分为2类: 一类是两阶段目标检测算法,如Girshick等提出的R-CNN[5 ] ,Fast R-CNN[6 ] ,Faster R-CNN[7 ] ,这类算法首先生成候选区域,将检测问题转化为建议区域内的局部图片的分类问题,具有准确率高,但检测速度慢的特点。另一类是单阶段目标检测算法,如YOLO(you only look once)系列模型[8 11] 、单次多框检测(single shot multibox detector, SSD)[12 ] 和CenterNet[13 ] 等,这类算法不需要生成候选区域,而是直接对目标的类别和位置分别进行回归,具有准确率相对略低,但计算速度快的特点。

针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化。Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量。

本文针对遥感图像场景信息复杂、目标多尺度、小目标检测困难和检测效率低等问题,提出了一种轻量化的YOLOv7-tiny遥感图像小目标检测算法。首先,在颈部使用组混洗卷积(group shuffle convolution, GSConv)[23 ] 卷积和VoV-GSCSP模块来降低网络模型的计算量并保持准确性,以实现更高的检测效益; 其次,采用结合注意力机制的动态预测头(dynamic head, DyHead) [24 ] ,在不增加计算量的同时显著提升模型目标检测头的表达能力; 最后,采用基于Wasserstein距离的小目标检测评估方法(normalized Wasserstein distance, NWD) [25 ] 结合基于最小点距离的边界框回归损失函数(minimum points distance intersection over union, MPDIoU)[26 ] ,替换原网络模型中的基于完全交并比的损失函数(complete intersection over union, CIoU)[27 ] ,增强对小目标检测的鲁棒性。

1 YOLOv7-tiny模型

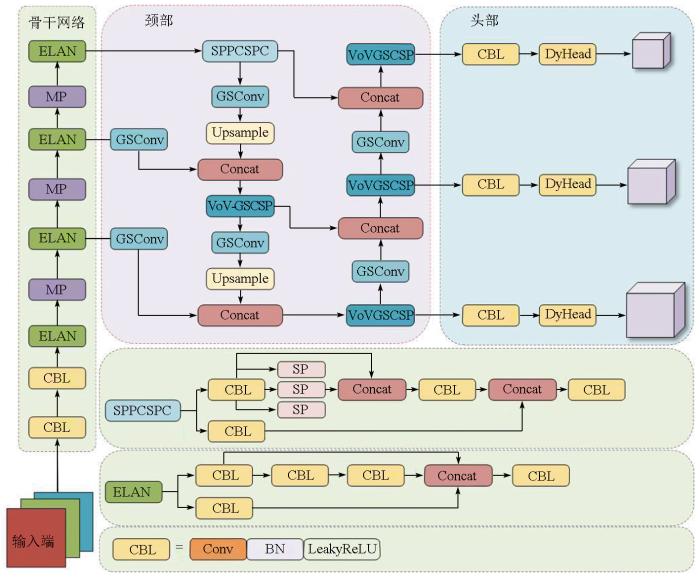

YOLOv7-tiny是在YOLOv7的基础上进行结构简洁化的模型,它采用级联的模型缩放策略,在保证检测精度的同时拥有更少的参数量和更快的检测速度,是一种轻量级目标检测算法。尽管YOLOv7-tiny在速度和轻量性方面具有优势,但该算法仍有不足之处。首先,在主干网络及特征融合网络中都采用高效层聚合网络(efficient layer aggregation networks, ELAN)层,容易出现特征冗余,导致精度下降; 其次,在检测头部分,虽然融入了大、中、小3种目标尺寸的 IDetect 检测头,但仍缺乏检测小目标的能力。本文基于YOLOv7-tiny算法,对以上问题进行优化,提高模型检测性能,使模型更加适合检测遥感图像目标。该网络结构由输入端、骨干网络、颈部、头部4部分组成,具体结构如图1 所示。

图1

图1

优化的YOLOv7-tiny网络结构

Fig.1

Optimized structure of YOLOv7-tiny network

1)输入端采用了Mosaic数据增强[28 ] ,通过随机裁剪、色域变化、缩放、排列等方式将4张图片进行拼接,作为新的样本输入,以此丰富数据集和泛化训练特征,使网络的鲁棒性更好,同时减少内存消耗; 并增加自适应图像调整策略,自适应地映射出增强后样本目标的位置。

2)骨干网络由普通卷积模块(convolutional-batchnormal-ReLU, CBL)、ELAN层和最大池化(maxpool, MP)层构成。其中CBL模块用来提取特征; ELAN模块通过控制最短和最长的梯度路径,使网络能够学习到更多的特征; MP模块进行下采样。

3)颈部采用了一种特征融合方法“改进空间金字塔池化(spatial pyramid pooling,SPP)[29 ] -路径聚合网络(path aggregation network,PANet)[30 ] ”结构,其中SPP改进后的跨阶段部分通道SPP(SPP cross stage partial connections,SPPCSPC)模块能够增大感受野,使算法适应不同的分辨率图像,更加精确地捕捉目标特征,并且该模块减少了计算量,在提升精度的同时速度变得更快; PANet将自顶向下得到的强语义信息和自底向上得到的强定位信息融合在一起,实现多尺度学习,提高检测准确率。在此结构上引入GSConv卷积和VoV-GSCSP模块进行特征聚合,相较于基线网络YOLOv7-tiny,优化后的网络能够综合考虑全局和局部特征信息,更好地捕捉节点的上下文信息。

4)头部使用IDetect检测头并衔接标准卷积来做通道数变化,但特征图在经过多次下采样后会失去大量特征信息和位置信息,因此引入带有注意力机制的DyHead来实现模型更好的特征表达能力。

2 研究方法

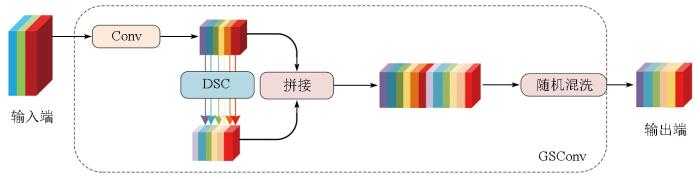

2.1 针对轻量化模型优化的Slim-Neck结构

观察众多网络,能够发现随着精度的提升,网络的复杂度也会增加,由此带来的是检测速度的下降。随着Xception[31 ] ,MobileNets[32 ] ,ShuffleNet[33 ] 这类轻量化模型的出现,提高了检测的速度,但由于这些模型都使用深度可分离卷积(depthwise separable convolution, DSC)操作,DSC输入图像的通道信息在计算过程中是分离的,导致DSC的特征提取能力比标准卷积(convolution, Conv)低,所以模型在精度上有较大的缺陷。为了达到降低模型参数量的同时不损失模型性能的目标,本文引入GSConv模块,如图2 所示,GSConv使用一个Conv进行下采样,再使用DSC,并将2个卷积的结果按通道拼接在一起,最后随机排列将Conv生成的信息渗透到DSC生成的特征信息的每个模块中。Conv,DSC,GSConv计算量公式分别为:

(1) P C o n v = W × H × K 1 × K 2 × C 1 × C 2

(2) P D S C = W × H × K 1 × K 2 × 1 × C 2

(3) P GSConv =W ×H ×K 1 ×K 2 × C 2 2 C 1

图2

图2

GSConv模块

Fig.2

GSConv module

式中: P 为计算量; W ,H 分别为输出特征图的宽和高; K 1 ,K 2 为卷积核的大小; C 1 ,C 2 分别为输入、输出特征图的通道数量。由公式可知,增大输入特征通道数,GSConv的计算量近似为标准卷积的一半,但其特征提取能力和后者相同。因此,该方法使模型的准确性得到了保证,同时降低了计算成本。

值得注意的是,只在网络颈部使用GSConv效果更好,如果在模型的骨干网络也使用GSConv,会导致模型的网络层加深,增加模型的复杂性,进而影响检测速度。

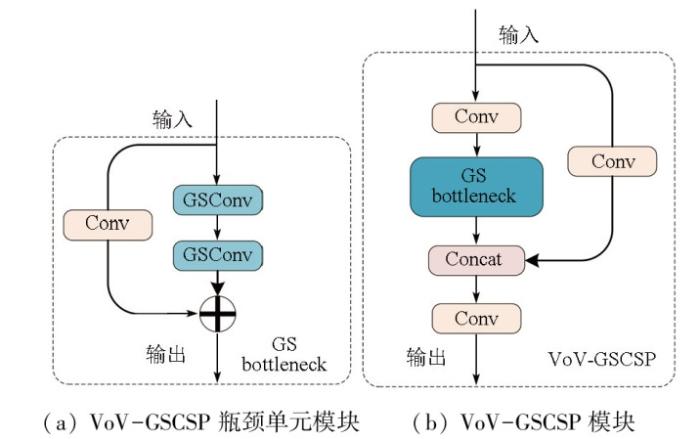

在GSConv基础上,引入了GS瓶颈单元模块(bottleneck),如图3(a) 所示。之后用一次性聚合方法设计出VOV-GSCSP模块,如图3(b) 所示。该模块在加快模型推理时间的同时保持了精度。本文使用GSConv卷积模块代替颈部的标准卷积,用VoV-GSCSP模块代替颈部中的ELAN层,以降低原模型的参数量,使模型取得更好的轻量化效果,能够更好地应用在遥感图像目标检测任务中。

图3

图3

VoV-GSCSP瓶颈单元模块与VoV-GSCSP模块

Fig.3

VoV-GSCSP bottleneck unit module and VoV-GSCSP module

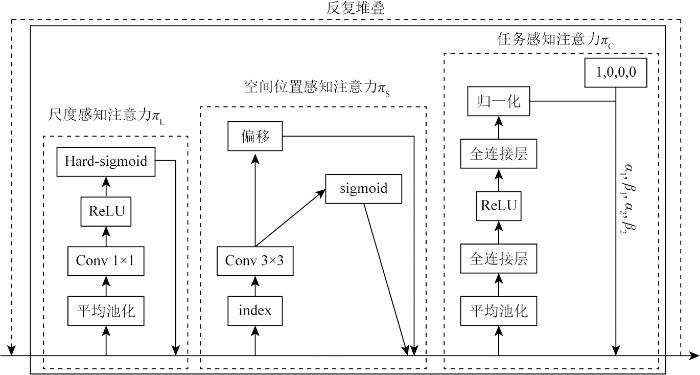

2.2 针对多尺度目标检测引入的DyHead注意力检测头

由于遥感图像目标尺度变化大,目标特征信息少,且下采样后更会导致特征图的位置信息与特征信息丢失,影响检测精度,本文引入了DyHead,通过尺度感知、空间感知和任务感知3个不同的角度分别运用注意力机制,并将可同时实现3种感知注意力的目标检测头进行统一,更准确地定位和识别目标。具体为将注意力函数转换为3个序列注意力,其中每个序列注意力只聚焦于其中一个维度,构造为一个嵌套注意力函数,其公式为:

(4) W (F )=π C (π S (π L (F )·F )·F )·F ,

式中: W 为注意力函数; F 为一个L ×S ×C 的三维特征张量; L 为特征图的层级; S 为特征图的宽高乘积; C 为特征图的通道数; π L (·),π S (·),π C (·)分别为尺度感知注意力模块、空间感知注意力模块和任务感知注意力模块。因遥感图像检测目标的大小各不相同,相应的特征图尺度也不相同,通过引入尺度感知注意力,根据不同尺度的语义重要性动态融合不同尺度的特征,尺度感知注意力表达式为:

(5) π L (F )·F =σ f 1 S C ∑ s = 1 S ∑ c = 1 C F F ,

式中: f (·)为近似于1×1卷积层所实现的线性函数; σ (x )为Hard-sigmoid函数。遥感图像目标可能出现在图像的不同位置,用空间感知注意力模块来关注空间位置和特征层之间一致共存的判别区域,提高检测头对于不同位置的特征图的空间感知能力,空间感知注意力表达式为:

(6) π S (F )·F = 1 L ∑ l = 1 L ∑ k = 1 K ωl , k F (l ; pk +Δpk ; c )·Δmk ,

式中: K 为稀疏采样位置数; pk +Δpk 为偏移后的位置; Δmk 为位置pk 的重要程度。不同的检测目标可能有不同的任务信息表征,任务感知注意力动态切换特征的开启和关闭通道,以此来支持不同的任务,任务感知注意力表达式为:

(7) π C (F )·F =max (α 1 (F )·FC +β 1 (F ),α 2 (F )·FC +β 2 (F )),

式中: θ (·)=[ α 1 , α 2 , β 1 , β 2 ] T FC 为第C 个通道的特征切片。顺序应用以上3种注意机制,且反复堆叠,以实现一个有效的DyHead框架,通过对遥感图像目标进行多尺度处理,联系上下文时既关注全局信息,又关注局部的重点特征信息,解决了遥感图像目标多尺度、特征信息少的问题。单个DyHead块的结构如图4 所示,其中index指根据不同尺度的特征图使用不同的卷积。

图4

图4

DyHead结构

Fig.4

DyHead structure

2.3 针对小目标检测改进的损失函数

2.3.1 NWD度量

由于在遥感图像中包含许多小目标,针对小目标像素小和YOLOv7-tiny原本的损失函数对于小目标的位置偏差非常敏感,检测性能较低的问题,本文采用NWD方法来度量边界框之间的相似度。该方法将检测边框建模为二维高斯分布,并通过它们对应的高斯分布计算预测的边界框与真实目标边界框之间的相似度。设(c x ,c y )为中心坐标; w ,h 分别为宽度和高度,则水平边界框R =(c x ,c y ,w ,h )可以被建模为二维高斯分布N (μ ,Σ),表达式为:

(8) μ = c x c y Σ = w 2 / 4 0 0 h 2 / 4

对于预测框A =(c xa ,c ya ,w a ,h a )和真实框B =(c xb ,c yb ,w b ,h b )建模的高斯分布N a 和N b ,两者之间的二阶Wasserstein距离可定义为:

(9) W 2 2 N a ,N b )= c x a , c y a , w a 2 , h a 2 T , c x b , c y b , w b 2 , h b 2 T 2 2

将W 2 2 ( N a ,N b )的指数形式归一化,得到NWD度量,表达式为:

(10) NWD (N a ,N b )=exp - W 2 2 N a , N b r

式中r 为与数据集密切相关的超参数。进一步得到,基于NWD的损失函数定义为:

(11) LNWD =1-NWD 。

NWD对小目标的感知度强,能平衡小目标的位置偏差,因此更适合于处理遥感图像复杂场景和小目标检测。

2.3.2 MPDIoU损失函数

通过实验发现,在所用数据集上仅采用NWD度量,虽精度有所提高,但收敛速度变慢,由此本文采用NWD度量结合基于交并比的方式,改进损失函数。由于原网络模型的CIoU损失函数,虽然同时考虑了真实边界框与预测边界框之间的中心点距离和纵横比,但CIoU中定义的纵横比是相对值,而不是绝对值,不能很好地代表长和宽的真实差异。针对这一问题,Zhang等[34 ] 提出了EIoU,然而当预测边界框和真实边界框具有相同的宽高比,但宽度和高度值不同时,EIoU损失函数将失去有效性,这将限制收敛速度和精度。为了提高边界框回归效率和精度,本文采用一种基于最小点距离的边界框相似性比较度量MPDIoU,具体来说,MPDIoU损失是通过最小化预测边界框和真实边界框之间的左上和右下点距离,来更好地训练目标。对于预测边界A ,(x 1 A y 1 A ) 和(x 2 A y 2 A ) 表示A 的左上和右下点坐标; 真实边界B ,(x 1 B y 1 B ) 和(x 2 B y 2 B ) 表示B 的左上和右下点坐标,MPDIoU的公式可表示为:

(12) MPDIoU = A ⋂ B A ⋃ B ( x 1 A - x 1 B ) 2 + ( y 1 A - y 1 B ) 2 w 2 + h 2 ( x 2 A - x 2 B ) 2 + ( y 2 A - y 2 B ) 2 w 2 + h 2

式中w ,h 分别为输入图像的宽度和高度。在模型训练时,通过最小化损失函数,将模型预测的每个边界框B prd =[ x p r d , y p r d , w p r d , h p r d ] T B gt =[ x g t , y g t , w g t , h g t ] T

(13) |C |=[max(x 2 g t x 2 p r d x 1 g t x 1 p r d y 2 g t y 2 p r d y 1 g t y 1 p r d

(14) x c g t = ( x 1 g t + x 2 g t ) / 2 y c g t = ( y 1 g t + y 2 g t ) / 2

(15) x c p r d = ( x 1 p r d + x 2 p r d ) / 2 y c p r d = ( y 1 p r d + y 2 p r d ) / 2

(16) w g t = x 2 g t - x 1 g t h g t = y 2 g t - y 1 g t

(17) w p r d = x 2 p r d - x 1 p r d h p r d = y 2 p r d - y 1 p r d

式中: |C |为覆盖B gt 和B prd 的最小封闭矩形面积; (x c g t y c g t ) 和(x c p r d y c p r d ) 分别为真实边界框和预测边界框中心点的坐标; w gt 和h gt 分别为真实边界框的宽度和高度; w prd 和h prd 分别为预测边界框的宽度和高度。这表明MPDIoU不仅考虑全面,同时还简化了计算过程,能够获得更快的收敛速度和更准确的回归结果。且当预测边界框和真实边界框具有相同的宽高比,但宽度和高度值不同时,唯有MPDIoU损失函数可以对不同的预测框进行区分,较其他损失函数更具优异性。根据MPDIoU的定义,基于MPDIoU的损失函数L 定义为:

(18) L =1-MPDIoU 。

(19) Loss =(1-D )(1-NWD )+D (1-MPDIoU ),

式中D 为超参数,减小D ,则增大NWD 度量比例,能有效提高小目标检测精度。通过实验分析,该损失函数有效提高了遥感图像小目标检测精度,且本文中D =0.5时,结合后的损失函数使得模型有最佳效果。

3 实验及分析

3.1 数据集

为了验证本文所提出的方法具有有效性,在公开数据集DIOR[35 ] 上进行消融实验,同时在DIOR数据集和RSOD数据集[36 ] 上使用一些经典目标检测方法和本文提出的方法进行对比实验。DIOR和RSOD数据集基本情况见表1 。

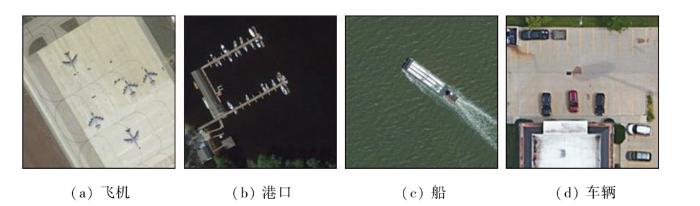

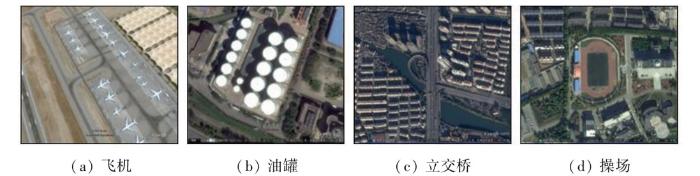

DIOR数据集样例如图5 所示; RSOD数据集样例如图6 所示。按照6∶2∶2的比例把2个数据集分别划分为训练集、验证集和测试集。

图5

图5

DIOR数据集

Fig.5

DIOR dataset

图6

图6

RSOD数据集

Fig.6

RSOD dataset

3.2 实验环境及实验参数

本实验环境基于Windows11操作系统,CPU为Intel Corei5-12400F,运行内存为16 GB,图形处理器(graphics processing unit,GPU)为NVIDIA GeForce RTX 3060,显存为12 GB,CUDA为11.6,深度学习框架为pytorch1.12.1。本文实验模型的输入图像尺寸为640×640×3,batchsize设置为8,epoch设置为300,初始学习率为0.01,动量参数和权重衰减系数分别为0.937和0.000 5。

3.3 评价指标

针对本文遥感图像目标检测算法,采用平均均值精度(mean average precision,mAP)、每秒检测帧率(frames per second,FPS)、模型参数量3个评价指标来评价本文模型的性能。其中mAP由召回率R 和精确率P 得到,二者公式为:

(20) R = T P T P + F N

(21) P = T P T P + F P

式中: TP 为将正类预测为正类的个数; FP 为将负类预测为正类的个数; FN 为将正类预测为负类的个数。

以精确率P 为纵轴、召回率R 为横轴作P-R曲线图,P-R曲线下的面积定义为每个类别的平均精度(average precision, AP),各类别AP相加取平均值即mAP,计算公式为:

(22) mAP = ∑ i = 1 n ∫ 0 1 P ( R ) d R n

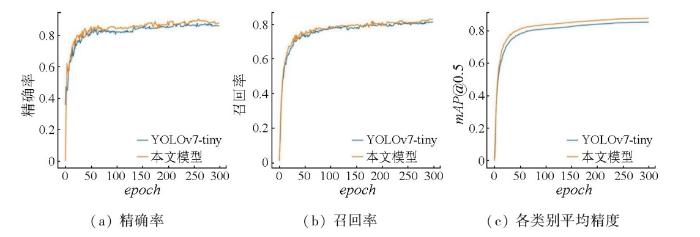

式中n 为目标检测的类别数。对于mAP,将阈值为0.5时的mAP即mAP@0.5作为主要评价指标,显然,mAP的值越高,检测算法效果越好。训练对比精确率、召回率、mAP@0.5如图7 所示。可以看到,训练300个epoch时,无论是精确率、召回率、还是mAP@0.5,改进后的模型都优于YOLOv7-tiny模型。

图7

图7

YOLOv7-tiny改进前后的精确率、召回率和mAP曲线

Fig.7

Precision, recall, mAP curve of the YOLOv7-tiny before and after improvement

3.4 实验结果及分析

3.4.1 消融试验及结果分析

为验证改进后的模型对于遥感图像目标检测的有效性,本文在DIOR数据集上进行了一系列消融实验,为保证实验结果的准确性,训练过程中使用相同参数,实验结果如表所示。由表2 可知,把损失函数改进为NWD结合MPDIoU的损失函数后,参数量不变,mAP @0.5提升了0.7百分点; 在颈部把原卷积改进为GSConv并加入VoV-GSCSP模块后,参数量下降0.5×106 个,mAP @0.5相比原始模型提升了1.2百分点; 加入基于注意力机制的检测头Dyhead后,参数量下降0.3×106 个,精度提升上带来的效果更为明显,mAP @0.5提升了2.0百分点; 把所有的改进方法同时加入原YOLOv7-tiny模型后,参数量下降约0.7×106 个,mAP @0.5提升了2.7百分点,达到87.7 %。由此可得到,改进后的模型比原模型更轻量、检测精度更高,更满足实时性检测的需求。

3.4.2 本文方法与其他方法的比较

为进一步验证本文算法相比其他算法的有效性,将本文算法与其他主流目标检测算法模型进行对比实验,实验结果如表3 和表4 所示。

表3 实验结果表明,检测DIOR数据集时,本文算法的mAP @0.5为87.7 %,相较于其余YOLO系列算法(YOLOv3,YOLOv5s,YOLOv7,YOLOv7-tiny和YOLOv8s),分别提升了10.1,1.9,0.6,2.7和1.1百分点;而相较于Faster R-CNN,SSD和RetinaNet算法,分别提升了11.9,23.6和15.3百分点。对于FPS,本文算法与表现最优的YOLOv8s算法相差不大,但在参数量上远远低于YOLOv8s;相较于原算法YOLOv7-tiny,本文算法的FPS 提高了12.2%;相较于Faster R-CNN和RetinaNet算法,本文算法的FPS 分别高出3.95倍和2.34倍,对比SSD算法,FPS 则提高了30.4%。表4 实验结果表明,检测RSOD数据集时,本文算法的mAP @0.5为94.7%,相较于其余YOLO系列算法分别提升了8.6,4.1,0.5,5.1和0.9百分点;而相较于Faster R-CNN,SSD和RetinaNet算法,本文算法的mAP @0.5分别提升了10.3,12.1和8.2百分点。对于FPS,本文算法同样是YOLO系列算法中表现最佳的算法,相较于原算法YOLOv7-tiny提高了11.9%。综上,本文算法在遥感场景下的检测精度和实时性上都达到了整体更优的表现。

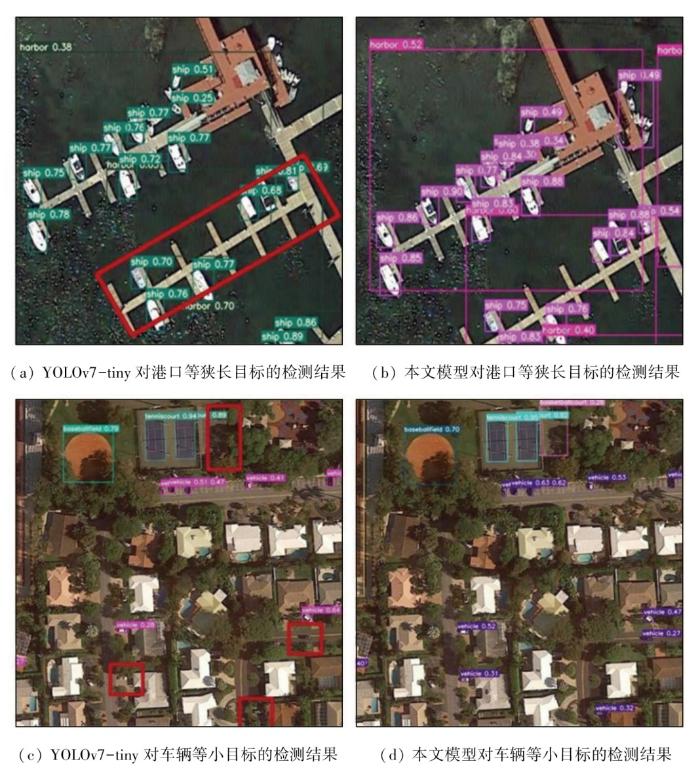

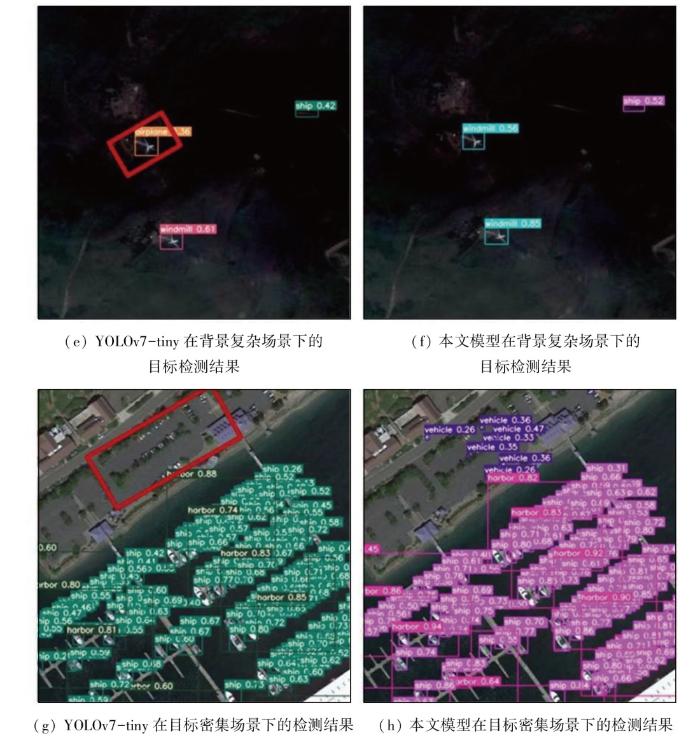

将YOLOv7-tiny模型与本文模型进行可视化,如图8 所示,其中包括狭长目标、小目标、背景复杂场景、目标密集场景下的检测结果。由图可知,优化后的模型具有以下优势:

图8-1

图8-1

所提算法与YOLOv7-tiny在DIOR数据集上检测结果对比

Fig.8-1

Comparison of detection results between the proposed algorithm and YOLOv7-tiny on the DIOR dataset

图8-2

图8-2

所提算法与YOLOv7-tiny在DIOR数据集上检测结果对比

Fig.8-2

Comparison of detection results between the proposed algorithm and YOLOv7-tiny on the DIOR dataset

1)对于狭长目标的检测,优化后的模型能够更准确地捕捉目标的形状和细节特征,解决了原模型对于形状特征不明显的目标,检测性能不佳的问题。如图8(a) 和(c) 中,原模型漏检了(a)中红框标识的港口和(c)中最上方红框标识的篮球场,而优化后的模型能准确无误地识别该港口目标和篮球场目标(图8(b) 和(d) )。

2)对于小目标的检测,NWD更好地度量了边界框之间的相似度,降低了模型对于小目标位置偏差的敏感度,以此提升了对小目标的检测能力。如图8(c) 和(d) 中,原模型漏检了图中下方3个红框标识的车辆,而优化模型能准确识别到目标,且优化模型整体上提升了图中小目标的检测精确率。

3)对于复杂背景和密集场景下的检测,通过加入Dyhead模块,利用统一的注意力机制解决了尺度感知、空间感知、任务感知3个难点,帮助模型同时关注不同尺度的特征,提高局部特征的捕获率,增强细节特征的表示能力。如图8(e)—(h) ,原模型在复杂场景下误把风车检测成飞机,在密集场景下检测不到车辆,而优化模型无论是在复杂场景还是密集场景下,都能准确地检测到目标。

总的来说,优化后的模型有效降低了目标的误检率和漏检率,在小目标的识别方面表现出明显的性能提升,能适应多种场景下的小目标检测,有效提高检测精度和实时性。

4 结论

针对遥感图像目标检测低精度和低实时性的问题,本文提出了轻量化YOLOv7-tiny遥感图像检测算法。首先,在颈部,引入轻量级卷积方法GSConv和VoV-GSCSP模块,由此来减轻模型的计算量和网络结构的复杂; 其次,在头部引入DyHead来统一目标检测头和注意力,提高目标检测头的性能; 最后,使用度量标准NWD结合MPDIoU,替换原网络模型中CIoU来优化损失函数,增强对小目标检测的鲁棒性。通过DIOR数据集和RSOD数据集上的一系列实验结果表明,改进后的YOLOv7-Tiny模型在遥感图像小目标检测中的综合性能有明显提升,解决了大量漏检误检问题,提升了检测精度,同时降低了模型的参数量,由此表明本文算法在提升遥感图像小目标检测精确性和满足实时性需求上具有一定参考意义。

实际场景中的目标分布要更为复杂,会出现更多遮挡目标和小目标,下一步研究将以实际场景数据集为基础,提高在实际场景下对更多目标的检测能力,继续探索更轻量级特征提取网络,实现遥感图像小目标检测高实时性和高精度的平衡,进而实现模型在实际场景中的应用价值。

参考文献

View Option

[1]

Zou Z Chen K Shi Z et al . Object detection in 20 years:A survey

[J]. Proceedings of the IEEE , 2023 , 111 (3 ):257 -276 .

[本文引用: 1]

[2]

Dai J Li Y He K et al . R-FCN:Object detection via region-based fully convolutional networks

[J]. Advances in neural information processing systems , 2016 , 29:379 -387 .

[本文引用: 1]

[3]

Zaidi S S A Ansari M S Aslam A et al . A survey of modern deep learning based object detection models

[J]. Digital Signal Processing , 2022 , 126:103514.

[本文引用: 1]

[4]

付涵 , 范湘涛 , 严珍珍 , 等 . 基于深度学习的遥感图像目标检测技术研究进展

[J]. 遥感技术与应用 , 2022 , 37 (2 ):290 -305 .

DOI:10.11873/j.issn.1004-0323.2022.2.0290

[本文引用: 1]

目标检测是遥感图像信息提取领域中的研究热点之一,具有广泛的应用前景。近些年来,深度学习在计算机视觉领域的发展为海量遥感图像信息提取提供了强大的技术支撑,使得遥感图像目标检测的精确度和效率均得到了很大提升。然而,由于遥感图像目标具有多尺度、多种旋转角度、场景复杂等特点,在高质量标记样本有限的情况下,深度学习在遥感图像目标检测应用中仍面临巨大挑战。从尺度不变性、旋转不变性、复杂背景干扰、样本量少和多波段数据检测5个角度出发,总结了近几年基于深度学习的遥感图像目标检测方法。此外,对典型遥感图像目标的检测难点和方法进行分析和总结,并对公开的遥感图像目标检测数据集进行概述。最后阐述了遥感图像目标检测研究的未来趋势。

Fu H Fan X T Yan Z Z et al . Progress of object detection in remote sensing images based on deep learning

[J]. Remote Sensing Technology and Application , 2022 , 37 (2 ):290 -305 .

[本文引用: 1]

[5]

Girshick R Donahue J Darrell T et al . Rich feature hierarchies for accurate object detection and semantic segmentation

[C]// 2014 IEEE Conference on Computer Vision and Pattern Recognition.June 23-28,2014,Columbus,OH,USA.IEEE, 2014 : 580 -587 .

[本文引用: 1]

[6]

Girshick R Fast R-CNN

[C]// 2015 IEEE International Conference on Computer Vision (ICCV).December 7-13, 2015 : 1440 -1448 .

[本文引用: 1]

[7]

Ren S He K Girshick R et al . Faster R-CNN:Towards real-time object detection with region proposal networks

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2017 , 39 (6 ):1137 -1149 .

[本文引用: 1]

[8]

Redmon J Divvala S Girshick R et al . You only look once:Unified,real-time object detection

[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).June 27-30,2016,Las Vegas,NV,USA.IEEE, 2016: 779 -788 .

[本文引用: 1]

[9]

Redmon J Farhadi A YOLO9000:Better,faster,stronger

[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE, 2017: 6517 -6525 .

[11]

Wang C Y Yeh I H Mark Liao H Y YOLOv9:Learning what you want toLearn using programmable gradient information

[C]// Computer Vision-ECCV 2024 . Cham : Springer Nature Switzerland , 2025: 1 -21 .

[本文引用: 1]

[12]

Liu W Anguelov D Erhan D et al . SSD:single shot MultiBox detector [M]// Computer Vision-ECCV 2016.Cham : Springer International Publishing , 2016: 21 -37 .

[本文引用: 1]

[14]

Shamsolmoali P Zareapoor M Yang J et al . Enhanced single-shot detector for small object detection in remote sensing images

[C]// IGARSS 2022-2022 IEEE International Geoscience and Remote Sensing Symposium . IEEE , 2022: 1716 -1719 .

[本文引用: 1]

[15]

张路青 , 郭莹 . 基于卷积神经网络的遥感图像目标检测识别

[J]. 舰船电子工程 , 2023 , 43 (5 ):49 -53 .

[本文引用: 1]

Zhang L Q Guo Y Remote sensing image object detection and reco-gnition based on convolutional neural network

[J]. Ship Electronic Engineering , 2023 , 43 (5 ):49 -53 .

[本文引用: 1]

[16]

Cao S Wang T Li T et al . UAV small target detection algorithm based on an improved YOLOv5s model

[J]. Journal of Visual Communication and Image Representation , 2023 , 97:103936.

[本文引用: 1]

[17]

Li X Wei Y Li J et al . Improved YOLOv7 algorithm for small object detection in unmanned aerial vehicle image scenarios

[J]. Applied Sciences , 2024 , 14 (4 ):1664 .

[本文引用: 1]

[18]

Wang C Y Bochkovskiy A Liao H M YOLOv7:Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors

[C]// 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).IEEE, 2023: 7464 -7475 .

[本文引用: 1]

[19]

Tan M Pang R Le Q V EfficientDet:Scalable and efficient object detection

[C]// 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).IEEE, 2020: 10781 -10790 .

[本文引用: 1]

[20]

李安达 , 吴瑞明 , 李旭东 . 改进YOLOv7的小目标检测算法研究

[J]. 计算机工程与应用 , 2024 , 60 (1 ):122 -134 .

DOI:10.3778/j.issn.1002-8331.2307-0004

[本文引用: 1]

随着深度学习在国内目标检测的不断应用,常规的大、中目标检测已经取得惊人的进步,但由于卷积网络本身的局限性,针对小目标检测依然会出现漏检、误检的问题,以数据集Visdrone2019和数据集FloW-Img为例,对YOLOv7模型进行研究,在网络结构上对骨干网的ELAN模块进行改进,将Focal NeXt block加入到ELAN模块的长短梯度路径中融合来强化输出小目标的特征质量和提高输出特征包含的上下文信息含量,在头部网络引入RepLKDeXt模块,该模块不仅可以取代SPPCSPC模块来简化模型整体结构还可以利用多通道、大卷积核和Cat操作来优化ELAN-H结构,最后引入SIOU损失函数取代CIOU函数以此提高该模型的鲁棒性。结果表明改进后的YOLOv7模型参数量减少计算复杂性降低并在小目标密度高的Visdrone 2019数据集上的检测性能近似不变,在小目标稀疏的FloW-Img数据集上涨幅9.05个百分点,进一步简化了模型并增加了模型的适用范围。

Li A D Wu R M Li X D Research on improving YOLOv7’s small target detection algorithm

[J]. Computer Engineering and Applications , 2024 , 60 (1 ):122 -134 .

DOI:10.3778/j.issn.1002-8331.2307-0004

[本文引用: 1]

With the continuous application of deep learning in domestic object detection, conventional large and medium object detection has made astonishing progress. However, due to the limitations of convolutional networks themselves, there are still issues of missed and false detections in small object detection. Taking dataset Visdrone 2019 and dataset FloW-Img as examples, the YOLOv7 model is studied, and the ELAN module of the backbone network is improved in the network structure. The Focal NeXt block is integrated into the long and short gradient paths of the ELAN module to enhance the feature quality of small targets and improve the contextual information content contained in the output features. The RepLKDeXt module is introduced into the head network, which not only replaces the SPPCSPC module to simplify the overall structure of the model, but also optimizes the ELAN-H structure using multi-channel, large convolutional kernels, and Cat operations. Finally, the SIOU loss function is introduced to replace the CIOU function to improve the robustness of the model. The results show that the improved YOLOv7 model reduces the number of parameters and computational complexity, and its detection performance remains approximately unchanged on the Visdrone 2019 dataset with high small target density. It increases by 9.05 percentage points on the sparse FloW-Img dataset with small targets, further simplifying the model and increasing its applicability.

[21]

Gevorgyan Z SIoU loss: More powerful learning for bounding box regression

[EB/OL]. 2022 : 2205.12740. https://arxiv.org/abs/2205.12740v1.

URL

[本文引用: 1]

[22]

Qi Z Ren Y Long J et al . Application of YOLOv7 in remote sen-sing image target detection

[C]// 2023 42nd Chinese Control Conference (CCC).IEEE, 2023: 7603 -7608 .

[本文引用: 1]

[23]

Li H Li J Wei H et al . Slim-neck by GSConv: A lightweight-design for real-time detector architectures

[EB/OL]. 2022 : 2206.02424. https://arxiv.org/abs/2206.02424v3.

URL

[本文引用: 1]

[24]

Dai X Chen Y Xiao B et al . Dynamic head:Unifying object detection heads with attentions

[C]// 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).IEEE, 2021: 7369 -7378 .

[本文引用: 1]

[25]

Wang J Xu C Yang W et al . A normalized Gaussian Wasserstein distance for tiny object detection

[EB/OL]. 2021 : 2110.13389. https://arxiv.org/abs/2110.13389v2.

URL

[本文引用: 1]

[26]

Ma S Xu Y Ma S et al . MPDIoU: A loss for efficient and accurate bounding box regression

[EB/OL]. 2023 : 2307.07662. https://arxiv.org/abs/2307.07662v1.

URL

[本文引用: 1]

[27]

Zheng Z Wang P Liu W et al . Distance-IoU loss:Faster and better learning for bounding box regression

[J]. Proceedings of the AAAI Conference on Artificial Intelligence , 2020 , 34 (7 ):12993 -13000 .

[本文引用: 1]

[28]

Bochkovskiy A Wang C Y Liao H M YOLOv4:Optimal speed and accuracy of object detection

[EB/OL]. 2020 : 2004.10934. https://arxiv.org/abs/2004.10934v1.

URL

[本文引用: 1]

[29]

He K Zhang X Ren S et al . Spatial pyramid pooling in deep convolutional networks for visual recognition

[C]// Computer Vision-ECCV 2014 . Cham : Springer International Publishing , 2014: 346 -361 .

[本文引用: 1]

[30]

Lin T Y Goyal P Girshick R et al . Focal loss for dense object detection

[C]// 2017 IEEE International Conference on Computer Vision (ICCV).IEEE, 2017: 2999 -3007 .

[本文引用: 1]

[31]

Chollet F Xception: Deep learning with depthwise separable convolutions

[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE, 2017: 1800 -1807 .

[本文引用: 1]

[33]

Zhang X Zhou X Lin M et al . ShuffleNet:An extremely efficient convolutional neural network for mobile devices

[C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.IEEE, 2018: 6848 -6856 .

[本文引用: 1]

[34]

Zhang Y F Ren W Zhang Z et al . Focal and efficient IOU loss for accurate bounding box regression

[J]. Neurocomputing , 2022 , 506:146 -157 .

[本文引用: 1]

[35]

Li K Wan G Cheng G et al . Object detection in optical remote sensing images:A survey and a new benchmark

[J]. ISPRS Journal of Photogrammetry and Remote Sensing , 2020 , 159:296 -307 .

[本文引用: 1]

[36]

Xiao Z Liu Q Tang G et al . Elliptic Fourier transformation-based histograms of oriented gradients for rotationally invariant object detection in remote-sensing images

[J]. International Journal of Remote Sensing , 2015 , 36 (2 ):618 -644 .

[本文引用: 1]

Object detection in 20 years:A survey

1

2023

... 遥感图像目标检测技术在城市交通管理、森林资源检测、自然灾害营救等领域都有着广泛的应用.传统遥感图像目标检测方法的特征表达通过人工提取,存在计算复杂度高和复杂场景下鲁棒性差的缺陷[1 ] ,并且强烈依赖于数据本身的特征.随着深度学习在目标检测的应用[2 ] , 基于深度学习的遥感图像目标检测方法也被广泛应用,相比于传统遥感图像目标检测方法,其具有适应性强、泛化能力广、在复杂条件下鲁棒性更好的优势[3 ] ,但因遥感图像具有多尺度且小目标多信息少等特点,当前的检测性能仍有提升的空间,如何有效提取小目标语义特征,降低小目标的误检、漏检与提高检测实时性是该领域亟须解决的问题[4 ] . ...

R-FCN:Object detection via region-based fully convolutional networks

1

2016

... 遥感图像目标检测技术在城市交通管理、森林资源检测、自然灾害营救等领域都有着广泛的应用.传统遥感图像目标检测方法的特征表达通过人工提取,存在计算复杂度高和复杂场景下鲁棒性差的缺陷[1 ] ,并且强烈依赖于数据本身的特征.随着深度学习在目标检测的应用[2 ] , 基于深度学习的遥感图像目标检测方法也被广泛应用,相比于传统遥感图像目标检测方法,其具有适应性强、泛化能力广、在复杂条件下鲁棒性更好的优势[3 ] ,但因遥感图像具有多尺度且小目标多信息少等特点,当前的检测性能仍有提升的空间,如何有效提取小目标语义特征,降低小目标的误检、漏检与提高检测实时性是该领域亟须解决的问题[4 ] . ...

A survey of modern deep learning based object detection models

1

2022

... 遥感图像目标检测技术在城市交通管理、森林资源检测、自然灾害营救等领域都有着广泛的应用.传统遥感图像目标检测方法的特征表达通过人工提取,存在计算复杂度高和复杂场景下鲁棒性差的缺陷[1 ] ,并且强烈依赖于数据本身的特征.随着深度学习在目标检测的应用[2 ] , 基于深度学习的遥感图像目标检测方法也被广泛应用,相比于传统遥感图像目标检测方法,其具有适应性强、泛化能力广、在复杂条件下鲁棒性更好的优势[3 ] ,但因遥感图像具有多尺度且小目标多信息少等特点,当前的检测性能仍有提升的空间,如何有效提取小目标语义特征,降低小目标的误检、漏检与提高检测实时性是该领域亟须解决的问题[4 ] . ...

基于深度学习的遥感图像目标检测技术研究进展

1

2022

... 遥感图像目标检测技术在城市交通管理、森林资源检测、自然灾害营救等领域都有着广泛的应用.传统遥感图像目标检测方法的特征表达通过人工提取,存在计算复杂度高和复杂场景下鲁棒性差的缺陷[1 ] ,并且强烈依赖于数据本身的特征.随着深度学习在目标检测的应用[2 ] , 基于深度学习的遥感图像目标检测方法也被广泛应用,相比于传统遥感图像目标检测方法,其具有适应性强、泛化能力广、在复杂条件下鲁棒性更好的优势[3 ] ,但因遥感图像具有多尺度且小目标多信息少等特点,当前的检测性能仍有提升的空间,如何有效提取小目标语义特征,降低小目标的误检、漏检与提高检测实时性是该领域亟须解决的问题[4 ] . ...

基于深度学习的遥感图像目标检测技术研究进展

1

2022

... 遥感图像目标检测技术在城市交通管理、森林资源检测、自然灾害营救等领域都有着广泛的应用.传统遥感图像目标检测方法的特征表达通过人工提取,存在计算复杂度高和复杂场景下鲁棒性差的缺陷[1 ] ,并且强烈依赖于数据本身的特征.随着深度学习在目标检测的应用[2 ] , 基于深度学习的遥感图像目标检测方法也被广泛应用,相比于传统遥感图像目标检测方法,其具有适应性强、泛化能力广、在复杂条件下鲁棒性更好的优势[3 ] ,但因遥感图像具有多尺度且小目标多信息少等特点,当前的检测性能仍有提升的空间,如何有效提取小目标语义特征,降低小目标的误检、漏检与提高检测实时性是该领域亟须解决的问题[4 ] . ...

Rich feature hierarchies for accurate object detection and semantic segmentation

1

2014

... 目前以卷积神经网络(convolutional neural network, CNN)为主的目标检测方法分为2类: 一类是两阶段目标检测算法,如Girshick等提出的R-CNN[5 ] ,Fast R-CNN[6 ] ,Faster R-CNN[7 ] ,这类算法首先生成候选区域,将检测问题转化为建议区域内的局部图片的分类问题,具有准确率高,但检测速度慢的特点.另一类是单阶段目标检测算法,如YOLO(you only look once)系列模型[8 11 ] 、单次多框检测(single shot multibox detector, SSD)[12 ] 和CenterNet[13 ] 等,这类算法不需要生成候选区域,而是直接对目标的类别和位置分别进行回归,具有准确率相对略低,但计算速度快的特点. ...

Fast R-CNN

1

2015

... 目前以卷积神经网络(convolutional neural network, CNN)为主的目标检测方法分为2类: 一类是两阶段目标检测算法,如Girshick等提出的R-CNN[5 ] ,Fast R-CNN[6 ] ,Faster R-CNN[7 ] ,这类算法首先生成候选区域,将检测问题转化为建议区域内的局部图片的分类问题,具有准确率高,但检测速度慢的特点.另一类是单阶段目标检测算法,如YOLO(you only look once)系列模型[8 11 ] 、单次多框检测(single shot multibox detector, SSD)[12 ] 和CenterNet[13 ] 等,这类算法不需要生成候选区域,而是直接对目标的类别和位置分别进行回归,具有准确率相对略低,但计算速度快的特点. ...

Faster R-CNN:Towards real-time object detection with region proposal networks

1

2017

... 目前以卷积神经网络(convolutional neural network, CNN)为主的目标检测方法分为2类: 一类是两阶段目标检测算法,如Girshick等提出的R-CNN[5 ] ,Fast R-CNN[6 ] ,Faster R-CNN[7 ] ,这类算法首先生成候选区域,将检测问题转化为建议区域内的局部图片的分类问题,具有准确率高,但检测速度慢的特点.另一类是单阶段目标检测算法,如YOLO(you only look once)系列模型[8 11 ] 、单次多框检测(single shot multibox detector, SSD)[12 ] 和CenterNet[13 ] 等,这类算法不需要生成候选区域,而是直接对目标的类别和位置分别进行回归,具有准确率相对略低,但计算速度快的特点. ...

You only look once:Unified,real-time object detection

1

... 目前以卷积神经网络(convolutional neural network, CNN)为主的目标检测方法分为2类: 一类是两阶段目标检测算法,如Girshick等提出的R-CNN[5 ] ,Fast R-CNN[6 ] ,Faster R-CNN[7 ] ,这类算法首先生成候选区域,将检测问题转化为建议区域内的局部图片的分类问题,具有准确率高,但检测速度慢的特点.另一类是单阶段目标检测算法,如YOLO(you only look once)系列模型[8 11 ] 、单次多框检测(single shot multibox detector, SSD)[12 ] 和CenterNet[13 ] 等,这类算法不需要生成候选区域,而是直接对目标的类别和位置分别进行回归,具有准确率相对略低,但计算速度快的特点. ...

YOLO9000:Better,faster,stronger

0

YOLOv6:A single-stage object detection framework for industrial applications

0

2022

YOLOv9:Learning what you want toLearn using programmable gradient information

1

... 目前以卷积神经网络(convolutional neural network, CNN)为主的目标检测方法分为2类: 一类是两阶段目标检测算法,如Girshick等提出的R-CNN[5 ] ,Fast R-CNN[6 ] ,Faster R-CNN[7 ] ,这类算法首先生成候选区域,将检测问题转化为建议区域内的局部图片的分类问题,具有准确率高,但检测速度慢的特点.另一类是单阶段目标检测算法,如YOLO(you only look once)系列模型[8 11 ] 、单次多框检测(single shot multibox detector, SSD)[12 ] 和CenterNet[13 ] 等,这类算法不需要生成候选区域,而是直接对目标的类别和位置分别进行回归,具有准确率相对略低,但计算速度快的特点. ...

1

... 目前以卷积神经网络(convolutional neural network, CNN)为主的目标检测方法分为2类: 一类是两阶段目标检测算法,如Girshick等提出的R-CNN[5 ] ,Fast R-CNN[6 ] ,Faster R-CNN[7 ] ,这类算法首先生成候选区域,将检测问题转化为建议区域内的局部图片的分类问题,具有准确率高,但检测速度慢的特点.另一类是单阶段目标检测算法,如YOLO(you only look once)系列模型[8 11 ] 、单次多框检测(single shot multibox detector, SSD)[12 ] 和CenterNet[13 ] 等,这类算法不需要生成候选区域,而是直接对目标的类别和位置分别进行回归,具有准确率相对略低,但计算速度快的特点. ...

Objects as points

1

2019

... 目前以卷积神经网络(convolutional neural network, CNN)为主的目标检测方法分为2类: 一类是两阶段目标检测算法,如Girshick等提出的R-CNN[5 ] ,Fast R-CNN[6 ] ,Faster R-CNN[7 ] ,这类算法首先生成候选区域,将检测问题转化为建议区域内的局部图片的分类问题,具有准确率高,但检测速度慢的特点.另一类是单阶段目标检测算法,如YOLO(you only look once)系列模型[8 11 ] 、单次多框检测(single shot multibox detector, SSD)[12 ] 和CenterNet[13 ] 等,这类算法不需要生成候选区域,而是直接对目标的类别和位置分别进行回归,具有准确率相对略低,但计算速度快的特点. ...

Enhanced single-shot detector for small object detection in remote sensing images

1

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

基于卷积神经网络的遥感图像目标检测识别

1

2023

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

基于卷积神经网络的遥感图像目标检测识别

1

2023

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

UAV small target detection algorithm based on an improved YOLOv5s model

1

2023

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

Improved YOLOv7 algorithm for small object detection in unmanned aerial vehicle image scenarios

1

2024

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

YOLOv7:Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors

1

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

EfficientDet:Scalable and efficient object detection

1

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

改进YOLOv7的小目标检测算法研究

1

2024

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

改进YOLOv7的小目标检测算法研究

1

2024

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

SIoU loss: More powerful learning for bounding box regression

1

2022

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

Application of YOLOv7 in remote sen-sing image target detection

1

... 针对遥感图像目标检测领域现存的问题,学者们将基于深度学习的2种方法改进后应用于遥感图像目标检测中,实现了不同程度的优化.Shamsolmoali等[14 ] 提出改进的SSD,利用单次检测器与图像金字塔网络相结合,帮助模型提取语义强的特征,提升了检测精度; 张路青等[15 ] 在Faster R-CNN基础上,通过多层次候选区域提取技术改善了小尺度目标的漏检问题; Cao等[16 ] 优化了YOLOv5的目标检测头,使模型更容易检测到小目标,但检测精度仍较低; Li等[17 ] 在YOLOv7[18 ] 中引入双向加权特征金字塔(bi-directional feature pyramid network,BiFPN)[19 ] 结构,提高了多尺度特征图的融合效果,但因额外增加了自底向上的路径流,给模型带来了更多的参数量; 李安达等[20 ] 在YOLOv7基础上使用SIoU[21 ] 来优化损失函数,增加了模型的鲁棒性,但SIoU用来检测遮挡目标会存在较大误差; Qi等[22 ] 将多头自注意力(multi-head self-attention, MHSA)集成到主干网络中,更好地区分了背景信息,但MHSA同时也增加了计算量. ...

Slim-neck by GSConv: A lightweight-design for real-time detector architectures

1

2022

... 本文针对遥感图像场景信息复杂、目标多尺度、小目标检测困难和检测效率低等问题,提出了一种轻量化的YOLOv7-tiny遥感图像小目标检测算法.首先,在颈部使用组混洗卷积(group shuffle convolution, GSConv)[23 ] 卷积和VoV-GSCSP模块来降低网络模型的计算量并保持准确性,以实现更高的检测效益; 其次,采用结合注意力机制的动态预测头(dynamic head, DyHead) [24 ] ,在不增加计算量的同时显著提升模型目标检测头的表达能力; 最后,采用基于Wasserstein距离的小目标检测评估方法(normalized Wasserstein distance, NWD) [25 ] 结合基于最小点距离的边界框回归损失函数(minimum points distance intersection over union, MPDIoU)[26 ] ,替换原网络模型中的基于完全交并比的损失函数(complete intersection over union, CIoU)[27 ] ,增强对小目标检测的鲁棒性. ...

Dynamic head:Unifying object detection heads with attentions

1

... 本文针对遥感图像场景信息复杂、目标多尺度、小目标检测困难和检测效率低等问题,提出了一种轻量化的YOLOv7-tiny遥感图像小目标检测算法.首先,在颈部使用组混洗卷积(group shuffle convolution, GSConv)[23 ] 卷积和VoV-GSCSP模块来降低网络模型的计算量并保持准确性,以实现更高的检测效益; 其次,采用结合注意力机制的动态预测头(dynamic head, DyHead) [24 ] ,在不增加计算量的同时显著提升模型目标检测头的表达能力; 最后,采用基于Wasserstein距离的小目标检测评估方法(normalized Wasserstein distance, NWD) [25 ] 结合基于最小点距离的边界框回归损失函数(minimum points distance intersection over union, MPDIoU)[26 ] ,替换原网络模型中的基于完全交并比的损失函数(complete intersection over union, CIoU)[27 ] ,增强对小目标检测的鲁棒性. ...

A normalized Gaussian Wasserstein distance for tiny object detection

1

2021

... 本文针对遥感图像场景信息复杂、目标多尺度、小目标检测困难和检测效率低等问题,提出了一种轻量化的YOLOv7-tiny遥感图像小目标检测算法.首先,在颈部使用组混洗卷积(group shuffle convolution, GSConv)[23 ] 卷积和VoV-GSCSP模块来降低网络模型的计算量并保持准确性,以实现更高的检测效益; 其次,采用结合注意力机制的动态预测头(dynamic head, DyHead) [24 ] ,在不增加计算量的同时显著提升模型目标检测头的表达能力; 最后,采用基于Wasserstein距离的小目标检测评估方法(normalized Wasserstein distance, NWD) [25 ] 结合基于最小点距离的边界框回归损失函数(minimum points distance intersection over union, MPDIoU)[26 ] ,替换原网络模型中的基于完全交并比的损失函数(complete intersection over union, CIoU)[27 ] ,增强对小目标检测的鲁棒性. ...

MPDIoU: A loss for efficient and accurate bounding box regression

1

2023

... 本文针对遥感图像场景信息复杂、目标多尺度、小目标检测困难和检测效率低等问题,提出了一种轻量化的YOLOv7-tiny遥感图像小目标检测算法.首先,在颈部使用组混洗卷积(group shuffle convolution, GSConv)[23 ] 卷积和VoV-GSCSP模块来降低网络模型的计算量并保持准确性,以实现更高的检测效益; 其次,采用结合注意力机制的动态预测头(dynamic head, DyHead) [24 ] ,在不增加计算量的同时显著提升模型目标检测头的表达能力; 最后,采用基于Wasserstein距离的小目标检测评估方法(normalized Wasserstein distance, NWD) [25 ] 结合基于最小点距离的边界框回归损失函数(minimum points distance intersection over union, MPDIoU)[26 ] ,替换原网络模型中的基于完全交并比的损失函数(complete intersection over union, CIoU)[27 ] ,增强对小目标检测的鲁棒性. ...

Distance-IoU loss:Faster and better learning for bounding box regression

1

2020

... 本文针对遥感图像场景信息复杂、目标多尺度、小目标检测困难和检测效率低等问题,提出了一种轻量化的YOLOv7-tiny遥感图像小目标检测算法.首先,在颈部使用组混洗卷积(group shuffle convolution, GSConv)[23 ] 卷积和VoV-GSCSP模块来降低网络模型的计算量并保持准确性,以实现更高的检测效益; 其次,采用结合注意力机制的动态预测头(dynamic head, DyHead) [24 ] ,在不增加计算量的同时显著提升模型目标检测头的表达能力; 最后,采用基于Wasserstein距离的小目标检测评估方法(normalized Wasserstein distance, NWD) [25 ] 结合基于最小点距离的边界框回归损失函数(minimum points distance intersection over union, MPDIoU)[26 ] ,替换原网络模型中的基于完全交并比的损失函数(complete intersection over union, CIoU)[27 ] ,增强对小目标检测的鲁棒性. ...

YOLOv4:Optimal speed and accuracy of object detection

1

2020

... 1)输入端采用了Mosaic数据增强[28 ] ,通过随机裁剪、色域变化、缩放、排列等方式将4张图片进行拼接,作为新的样本输入,以此丰富数据集和泛化训练特征,使网络的鲁棒性更好,同时减少内存消耗; 并增加自适应图像调整策略,自适应地映射出增强后样本目标的位置. ...

Spatial pyramid pooling in deep convolutional networks for visual recognition

1

... 3)颈部采用了一种特征融合方法“改进空间金字塔池化(spatial pyramid pooling,SPP)[29 ] -路径聚合网络(path aggregation network,PANet)[30 ] ”结构,其中SPP改进后的跨阶段部分通道SPP(SPP cross stage partial connections,SPPCSPC)模块能够增大感受野,使算法适应不同的分辨率图像,更加精确地捕捉目标特征,并且该模块减少了计算量,在提升精度的同时速度变得更快; PANet将自顶向下得到的强语义信息和自底向上得到的强定位信息融合在一起,实现多尺度学习,提高检测准确率.在此结构上引入GSConv卷积和VoV-GSCSP模块进行特征聚合,相较于基线网络YOLOv7-tiny,优化后的网络能够综合考虑全局和局部特征信息,更好地捕捉节点的上下文信息. ...

Focal loss for dense object detection

1

... 3)颈部采用了一种特征融合方法“改进空间金字塔池化(spatial pyramid pooling,SPP)[29 ] -路径聚合网络(path aggregation network,PANet)[30 ] ”结构,其中SPP改进后的跨阶段部分通道SPP(SPP cross stage partial connections,SPPCSPC)模块能够增大感受野,使算法适应不同的分辨率图像,更加精确地捕捉目标特征,并且该模块减少了计算量,在提升精度的同时速度变得更快; PANet将自顶向下得到的强语义信息和自底向上得到的强定位信息融合在一起,实现多尺度学习,提高检测准确率.在此结构上引入GSConv卷积和VoV-GSCSP模块进行特征聚合,相较于基线网络YOLOv7-tiny,优化后的网络能够综合考虑全局和局部特征信息,更好地捕捉节点的上下文信息. ...

Xception: Deep learning with depthwise separable convolutions

1

... 观察众多网络,能够发现随着精度的提升,网络的复杂度也会增加,由此带来的是检测速度的下降.随着Xception[31 ] ,MobileNets[32 ] ,ShuffleNet[33 ] 这类轻量化模型的出现,提高了检测的速度,但由于这些模型都使用深度可分离卷积(depthwise separable convolution, DSC)操作,DSC输入图像的通道信息在计算过程中是分离的,导致DSC的特征提取能力比标准卷积(convolution, Conv)低,所以模型在精度上有较大的缺陷.为了达到降低模型参数量的同时不损失模型性能的目标,本文引入GSConv模块,如图2 所示,GSConv使用一个Conv进行下采样,再使用DSC,并将2个卷积的结果按通道拼接在一起,最后随机排列将Conv生成的信息渗透到DSC生成的特征信息的每个模块中.Conv,DSC,GSConv计算量公式分别为: ...

MobileNets: Efficient convolutional neural networks for mobile vision applications

1

2017

... 观察众多网络,能够发现随着精度的提升,网络的复杂度也会增加,由此带来的是检测速度的下降.随着Xception[31 ] ,MobileNets[32 ] ,ShuffleNet[33 ] 这类轻量化模型的出现,提高了检测的速度,但由于这些模型都使用深度可分离卷积(depthwise separable convolution, DSC)操作,DSC输入图像的通道信息在计算过程中是分离的,导致DSC的特征提取能力比标准卷积(convolution, Conv)低,所以模型在精度上有较大的缺陷.为了达到降低模型参数量的同时不损失模型性能的目标,本文引入GSConv模块,如图2 所示,GSConv使用一个Conv进行下采样,再使用DSC,并将2个卷积的结果按通道拼接在一起,最后随机排列将Conv生成的信息渗透到DSC生成的特征信息的每个模块中.Conv,DSC,GSConv计算量公式分别为: ...

ShuffleNet:An extremely efficient convolutional neural network for mobile devices

1

... 观察众多网络,能够发现随着精度的提升,网络的复杂度也会增加,由此带来的是检测速度的下降.随着Xception[31 ] ,MobileNets[32 ] ,ShuffleNet[33 ] 这类轻量化模型的出现,提高了检测的速度,但由于这些模型都使用深度可分离卷积(depthwise separable convolution, DSC)操作,DSC输入图像的通道信息在计算过程中是分离的,导致DSC的特征提取能力比标准卷积(convolution, Conv)低,所以模型在精度上有较大的缺陷.为了达到降低模型参数量的同时不损失模型性能的目标,本文引入GSConv模块,如图2 所示,GSConv使用一个Conv进行下采样,再使用DSC,并将2个卷积的结果按通道拼接在一起,最后随机排列将Conv生成的信息渗透到DSC生成的特征信息的每个模块中.Conv,DSC,GSConv计算量公式分别为: ...

Focal and efficient IOU loss for accurate bounding box regression

1

2022

... 通过实验发现,在所用数据集上仅采用NWD度量,虽精度有所提高,但收敛速度变慢,由此本文采用NWD度量结合基于交并比的方式,改进损失函数.由于原网络模型的CIoU损失函数,虽然同时考虑了真实边界框与预测边界框之间的中心点距离和纵横比,但CIoU中定义的纵横比是相对值,而不是绝对值,不能很好地代表长和宽的真实差异.针对这一问题,Zhang等[34 ] 提出了EIoU,然而当预测边界框和真实边界框具有相同的宽高比,但宽度和高度值不同时,EIoU损失函数将失去有效性,这将限制收敛速度和精度.为了提高边界框回归效率和精度,本文采用一种基于最小点距离的边界框相似性比较度量MPDIoU,具体来说,MPDIoU损失是通过最小化预测边界框和真实边界框之间的左上和右下点距离,来更好地训练目标.对于预测边界A ,( x 1 A y 1 A ) 和( x 2 A y 2 A ) 表示A 的左上和右下点坐标; 真实边界B ,( x 1 B y 1 B ) 和( x 2 B y 2 B ) 表示B 的左上和右下点坐标,MPDIoU的公式可表示为: ...

Object detection in optical remote sensing images:A survey and a new benchmark

1

2020

... 为了验证本文所提出的方法具有有效性,在公开数据集DIOR[35 ] 上进行消融实验,同时在DIOR数据集和RSOD数据集[36 ] 上使用一些经典目标检测方法和本文提出的方法进行对比实验.DIOR和RSOD数据集基本情况见表1 . ...

Elliptic Fourier transformation-based histograms of oriented gradients for rotationally invariant object detection in remote-sensing images

1

2015

... 为了验证本文所提出的方法具有有效性,在公开数据集DIOR[35 ] 上进行消融实验,同时在DIOR数据集和RSOD数据集[36 ] 上使用一些经典目标检测方法和本文提出的方法进行对比实验.DIOR和RSOD数据集基本情况见表1 . ...