0 引言

随着卫星技术的发展,研究人员可以通过卫星传感器获取大量的遥感图像。遥感图像包含丰富的空间信息和光谱信息,因此可以为观测区域的观察任务和处理任务提供依据,例如,城市规划[1 ] 、环境保护[2 ] 、植被覆盖分类[3 ] 和国防监测[4 ] 等。然而,受到卫星传感器本身的限制,光学遥感卫星只能获得全色图像(panchromatic images,PAN)和低空间分辨率高光谱图像(low spatial resolution hyperspectral images,LR-HSI)。PAN空间分辨率很高,但是只含一个波段,缺乏光谱信息; LR-HSI虽有很多个波段,富含丰富的光谱信息,但空间分辨率低,缺乏空间信息。因此,为了得到高分辨率的高光谱图像,遥感图像的全色锐化技术融合PAN和LR-HSI得到高空间分辨率的高光谱图像(high spatial resolution hyperspectral images,HR-HSI),是常采用的手段之一。

当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法。传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] 。传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高。近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化。例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI。此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] 。此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大。以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系。郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法。但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制。

除此之外,还有很多基于无监督方法的研究,如Ma等[18 ] 提出一种新的基于生成对抗网络(generative adversarial network,GAN)的无监督全色锐化框架,称为PAN-GAN,该框架在网络训练过程中不需要真实的训练标签,生成器分别于光谱鉴别器和空间鉴别器建立对抗,以保持多光谱图像的丰富光谱信息和PAN的空间信息; Zhou等[19 ] 设计一种新的生成多对抗网络的全色锐化框架,通过使用双流生成器分别从PAN和多光谱图像中提取模态特定特征; Qu等[20 ] 将研究良好的全色锐化观测模型显式编码为无督展开迭代对抗性网络,构建一种新的可解释的无监督端到端的全色锐化网络; Rui等[21 ] 将扩散模型与低秩矩阵分解技术相结合,提出了一种无监督的全色锐化方法,并且推导了一种简单有效的方法来从观测到的光谱图像中预估计系数矩阵。但这些方法由于没有地面真值标签作为参考,其最终生成图像的质量有待改善,并且训练过程的稳健性有待提高。

随着注意力机制和Transformer的出现,越来越多的研究者将这些算法用到遥感图像全色锐化中,Bandara等[22 ] 设计了一种称为HyperTransformer的网络架构,该架构通过多头特征软注意机制将PAN的HR纹理特征与LR-HSI光谱特征相结合,生成HR-HSI。HyperTransformer首次巧妙地解决了利用2个输入进行多头注意力计算的问题,使其特征提取更加具有指导性,但是上下采样的方式会极大破坏PAN空间像素的分布,进而损失空间信息。

本文针对上述基于以上问题,本文提出一种基于特征增强和三流Transformer的高光谱图像全色锐化方法。首先,从多尺度处理的角度出发,利用特征增强模块(feature enhancement module,FEM)在3个尺度上分别对提取到的光谱特征和空间细节进行增强; 其次,利用多尺度信息融合模块(multi-scale information fusion module,MIFM)将PAN和LR-HSI的信息特征进行融合,进而生成增强的HSI; 再次,将增强的HSI与PAN输入到信息融合网络,采用Transformer多头注意力机制,指导PAN中空间细节信息与增强的HSI光谱信息的提取; 最后,利用MIFM更好地融合遥感图像的空间信息与光谱信息,生成更加真实的HR-HSI。

1 网络模型与方法

1.1 网络整体架构

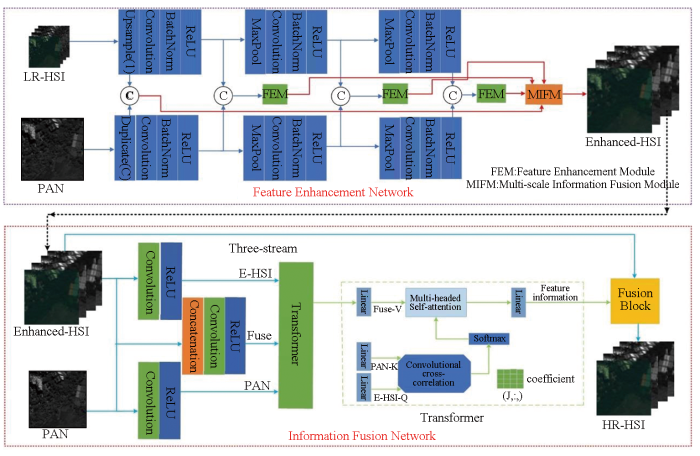

本文提出的算法与网络整体架构如图1 所示,整体网络架构分为2个阶段。网络第一行为FEN,首先将LR-HSI采样到与PAN相同的尺寸上,再将PAN复制到与LR-HSI相同的通道上,分别输入到各自的特征提取器中,特征提取器由卷积、归一化处理以及激活函数组合而成,通过最大池化实现不同尺度上的特征信息的提取; 之后,通过FEM实现不同尺度上的信息增强; 最后,通过MIFM实现不同尺度上的信息融合与增强,以生成增强的高光谱遥感图像。整体网络的第二行作为信息融合网络(information fusion network,IFN),将增强的HSI与PAN为网络的输入,分别经过卷积和激活函数作为光谱流和空间流,再将2类图像拼接作为融合流。之后,将这3种流输入到Transformer模块中,进行多头注意力机制计算,将光谱流作为查询矩阵(Q ),空间流作为键矩阵(K ),融合流作为值矩阵(V )。最后,将融合生成的增强信息特征图与增强光谱图像送入融合模块,生成更加贴近真实的HR-HSI图像。

图1

图1

整体网络结构图

Fig.1

Overall network structure diagram

1.2 特征增强模块

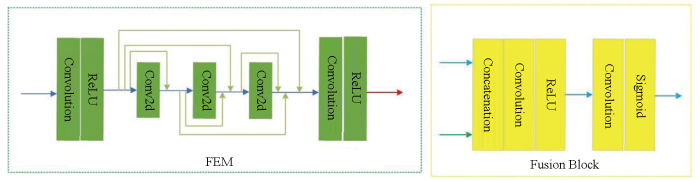

在整体网络架构中,FEM在不同尺度的特征图下使用,用来增强与提取不同尺度下的光谱信息与空间信息,具体模块架构如图2 所示。该模块采取稠密神经网络的思想对输入的特征图信息进行增强,主要分成3个部分,前后2个部分都为卷积层加激活函数,中间部分由3个卷积层相互稠密跳连形成,该设计能够极大地提升网络的学习与泛化能力。

图2

图2

特征增强模块和融合模块

Fig.2

Feature enhancement module and fusion module

1.3 多尺度信息融合模块

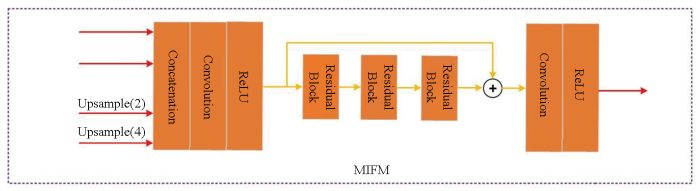

多尺度信息融合模块具体架构如图3 所示,该模块的输入有4个,其中3个是不同尺度信息特征图,1个是原始的由LR-HSI与PAN拼接而成的信息特征图。该模块先将这4个特征图拼接,接着送入卷积层和激活函数层,再经过3个残差块进行特征信息的增强与融合,通过卷积加激活函数输出。将特征增强模块和多尺度信息融合模块等构成的图像处理网络称作特征增强网络,记为${f}_{\mathrm{F}\mathrm{E}\mathrm{N}}$

(1) ${I}_{\mathrm{E}-\mathrm{H}\mathrm{S}\mathrm{I}}={f}_{\mathrm{F}\mathrm{E}\mathrm{N}}({I}_{\mathrm{L}\mathrm{R}-\mathrm{H}\mathrm{S}\mathrm{I}},{L}_{\mathrm{P}\mathrm{A}\mathrm{N}})$

式中: ${I}_{\mathrm{E}-\mathrm{H}\mathrm{S}\mathrm{I}}$ ${I}_{\mathrm{L}\mathrm{R}-\mathrm{H}\mathrm{S}\mathrm{I}}$ ${L}_{\mathrm{P}\mathrm{A}\mathrm{N}}$

图3

图3

多尺度信息融合模块

Fig.3

Multi-scale information fusion module

1.4 Transformer模块

在整个大网络的第二阶段,将3种流(PAN流、E-HSI流、Fuse流)分别经过线性层输出Q 、K 和V ,具体过程见图1 ,其公式为:

(2) ${I}_{\mathrm{F}\mathrm{u}\mathrm{s}\mathrm{e}}=\mathrm{C}\mathrm{o}\mathrm{n}\mathrm{c}\mathrm{a}\mathrm{t}({I}_{\mathrm{E}-\mathrm{H}\mathrm{S}\mathrm{I}},{I}_{\mathrm{P}\mathrm{A}\mathrm{N}})$

(3) $Q={f}_{\mathrm{l}\mathrm{i}\mathrm{n}\mathrm{e}\mathrm{a}\mathrm{r}}\left\{\mathrm{C}\mathrm{o}\mathrm{n}\mathrm{v}\right[\mathrm{R}\mathrm{e}\mathrm{l}\mathrm{u}\left({I}_{\mathrm{E}-\mathrm{H}\mathrm{S}\mathrm{I}}\right)\left]\right\}$

(4) $K={f}_{\mathrm{l}\mathrm{i}\mathrm{n}\mathrm{e}\mathrm{a}\mathrm{r}}\left\{\mathrm{C}\mathrm{o}\mathrm{n}\mathrm{v}\right[\mathrm{R}\mathrm{e}\mathrm{l}\mathrm{u}\left({I}_{\mathrm{P}\mathrm{A}\mathrm{N}}\right)\left]\right\}$

(5) $V={f}_{\mathrm{l}\mathrm{i}\mathrm{n}\mathrm{e}\mathrm{a}\mathrm{r}}\left\{\mathrm{C}\mathrm{o}\mathrm{n}\mathrm{v}\right[\mathrm{R}\mathrm{e}\mathrm{l}\mathrm{u}\left({I}_{\mathrm{F}\mathrm{u}\mathrm{s}\mathrm{e}}\right)\left]\right\}$

式中: ${f}_{\mathrm{l}\mathrm{i}\mathrm{n}\mathrm{e}\mathrm{a}\mathrm{r}}$ ${I}_{\mathrm{F}\mathrm{u}\mathrm{s}\mathrm{e}}$ ${I}_{\mathrm{E}-\mathrm{H}\mathrm{S}\mathrm{I}}$ Attention 的公式如下:

(6) ${Attention}({Q},{K},{V})=\mathrm{S}\mathrm{o}\mathrm{f}\mathrm{t}\mathrm{m}\mathrm{a}\mathrm{x}\left(\frac{{Q}{K}^{\mathrm{T}}}{\sqrt{\mathrm{b}}}\right)$

(7) $\boldsymbol{C}_{i}=\operatorname{MatMul}\left\{\left[\boldsymbol{Q}_{i}^{\prime}-\operatorname{mean}\left(\boldsymbol{Q}_{i}^{\prime}\right)\right],\left[\boldsymbol{K}_{i}^{\prime}-\operatorname{mean}\left(\boldsymbol{K}_{i}^{\prime}\right)^{\mathrm{T}}\right]\right\}$

式中: Softmax()为归一化指数函数; b 为V 的列数; MatMul()为互相关计算; mean()为均值计算; T为转置运算; Ci 为特征互相关矩阵; Q'i 为Qi 调换2个维度之后的第i 列; K'i 为指Ki 调换2个维度之后的第i 列。3种流都经过Transformer模块,进行多头注意力计算,进而生成包含丰富的空间信息与光谱信息的特征图。特征注意力是为了识别LR-HSI的波段相似和空间细节纹理优越的特征表示,该特征表示被设计的三流Transformer进一步用于全色锐化的HR-HSI。因此,本文使用时多头特征注意力运算,而不是单头注意,同时,实验结果也表明,多头注意力比单头注意力的全色锐化效果更好。最后,对多头的数量进行消融实验研究。

1.5 融合模块

从Transformer模块中输出的信息特征图与原始的增强的HSI一起被送入到融合模块(具体架构如图2 所示),通过拼接、卷积激活函数等操作,最终生成空间信息与光谱信息更加丰富的HR-HSI,其公式如下:

(8) $\tilde{H}={f}_{\mathrm{f}\mathrm{u}\mathrm{s}\mathrm{i}\mathrm{o}\mathrm{n}}({I}_{\mathrm{T}},{I}_{\mathrm{E}-\mathrm{H}\mathrm{S}\mathrm{I}})$

式中: ${f}_{\mathrm{f}\mathrm{u}\mathrm{s}\mathrm{i}\mathrm{o}\mathrm{n}}$ IT 为经过Transformer输出的信息特征图; $\tilde{H}$

1.6 损失函数

损失函数包含2个部分,对应于整个网络的2个阶段。整个损失函数公式为:

(9) ${L}_{1}=\frac{1}{CWH}{‖{I}_{\mathrm{E}-\mathrm{H}\mathrm{S}\mathrm{I}}-{I}_{\mathrm{G}\mathrm{T}}‖}_{F}^{2}$

(10) ${L}_{2}=\frac{1}{CWH}{‖\tilde{H}-{I}_{\mathrm{G}\mathrm{T}}‖}_{F}^{2}$

(11) $L=\lambda {L}_{1}+\mu {L}_{2}$

式中: L1 和L2 是网络第一阶段(特征增强网络)和第二阶段(信息融合网络)的损失; C 、W 和H 分别为图像的通道数、宽度和长度; $\lambda $ $\mu $ $\lambda $ $\mu $ $\left|\right|.|{|}_{F}^{2}$ IGT 是人工制造的数据集所提供的地面真值标签。

2 实验研究及结果分析

2.1 数据集与评价指标

在本实验中,为了验证所提出方法的性能,使用3个公开的高光谱遥感图像数据集,分别是Pavia Center(102×1 096×715)[23 ] ,Botswana(145×1 476×145)[24 ] 和Chikusei(128×2 517×2 335)[25 ] 。由于遥感图片尺寸较大,根据相关文献[26 -27 ] ,3个数据集分别被裁剪后的大小尺寸为24×102×160×160,24×145×120×120和210×128×160×160,数字含义为N ×C ×H ×W ,其中,C 为遥感数据集中的波段数量,N 为被裁剪之后图片的数量。接着,采用Wald协议[28 -29 ] 从HR-HSI生成PAN和LR-HSI,主要就是使用8×8高斯滤波器,再使用缩放因子为4的下采样算子为3个数据集生成LR-HSI图像,而PAN图像就是HR-HSI其中一个波段。随机选择80%的图片组作为每个数据集的训练集,其余的20%用于形成测试集。在可视化展示图片的过程中,Pavia Center数据集是以第10,30,60波段作为蓝绿红光谱波段,Botswana数据集是以第10,35,61作为蓝绿红光谱波段,Chikusei数据集是以第12,20,29作为蓝绿红光谱波段。

为了定量评估所提出的全色锐化方法的质量,根据有关文献 [25 -26 ,30 -31 ] 使用不同空间和光谱角度的评价指标,包括互相关(cross-correlation,CC)、光谱角映射(spectral angle mapping,SAM)、均方根误差(root mean square errors,RMSE)、相对无量纲全局误差(errur relative globale adimensionnelle desynthese,ERGAS)和峰值信噪比(peak signal to noise ratio,PSNR)。这些评价指标已在高光谱遥感图像处理领域广泛运用,也适用于评估光谱和空间分辨率的融合质量评价。所有实验都是在高性能计算机上进行的,该计算机搭配Intel(R)Xeon(R)Silver 4210R CPU@2.40 GHz 2.39 GHz、NVIDIA Quadro RTX 5000和64 GB RAM内存。

2.2 降低分辨率下对比实验与结果分析

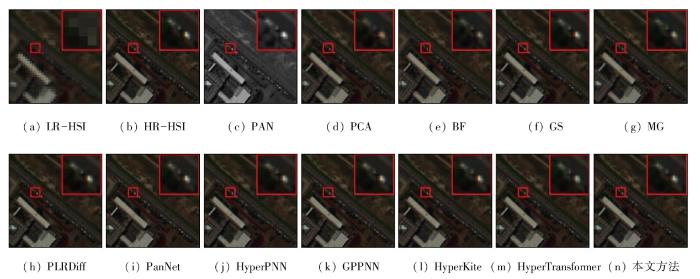

为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较。常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法。

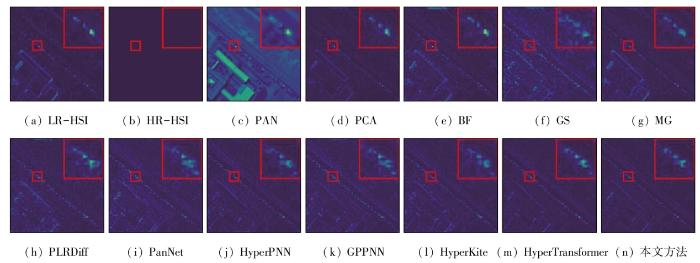

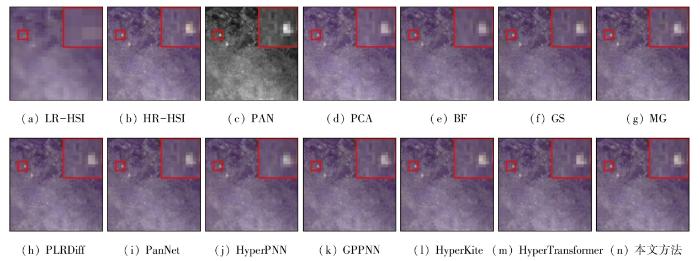

在Pavia Center和Botswana数据集上进行了降低分辨率下的实验,定量实验结果如表1 和表2 所示(其中加粗的为最佳值),定性可视化实验结果如图4 —7 所示。从定量实验结果可以看出,本文提出的三流Transformer在这2个数据集中取得了最好的效果。由于高光谱遥感图像的空间分辨率较低,很难通过整个图像来直观地评估其性能。因此,本文从测试图像中随机选择一个图像进行可视化展示,并进行局部放大显示,以更准确地评估各种全色锐化方法的性能。例如,对于其中一张的测试图像,来源于Pavia Center数据集,如图3 所示,三流Transformer更接近真实的HR-HSI,而BF,MG,PLRDiff,PanNet和HyperPNN等方法均有一定程度的光谱畸变。此外,PCA还有一定的空间畸变。由HR-HSI和地面实况HR-HSI之间的差异生成的残差图,如图4 所示,进一步证实了本文方法全色锐化效果最好这一结论。

图4

图4

Pavia Center 数据集上的可视化实验结果(降低分辨率)

Fig.4

Visualization experiment results on the Pavia Center dataset (reduced-resolution)

图5

图5

Pavia Center数据集对应图像的残差可视化结果(降低分辨率)

Fig.5

Residual visualization results of images corresponding to the Pavia Center dataset (reduced-resolution)

图6

图6

Botswana 数据集上的可视化实验结果(降低分辨率)

Fig.6

Visualization experiment results on the Botswana dataset (reduced-resolution)

图7

图7

Botswana 数据集对应图像的残差可视化结果(降低分辨率)

Fig.7

Residual visualization results of images corresponding to the Botswana dataset (reduced-resolution)

对于Botswana数据集,如图5 所示,由于其较小的尺寸和像素级的融合,很难从视觉上区分这些方法的结果,而图6 所示的残差图像可以发现全色锐化方法三流Transformer明显优于传统的全色锐化算法和当前基于深度学习的全色锐化方法。

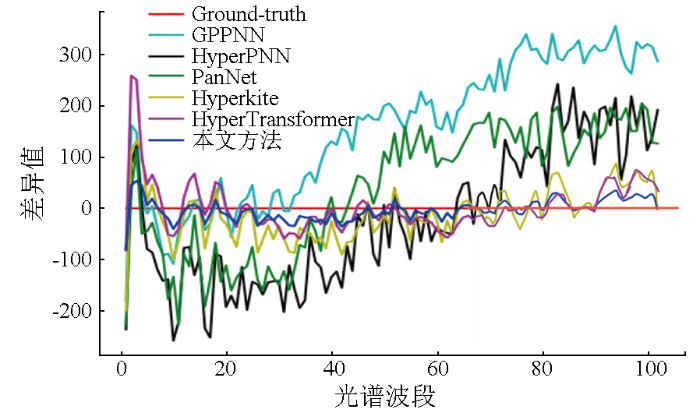

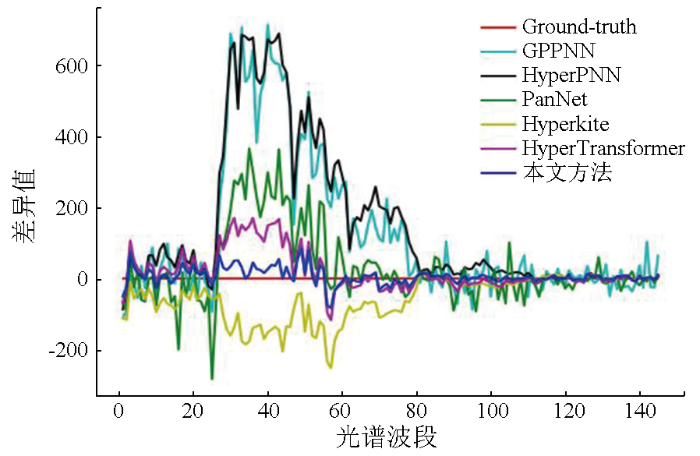

为了进一步评估不同HSI全色锐化方法的光谱保存能力,从2个数据集中随机选择一个像素,并绘制其光谱差异曲线,如图8 、图9 所示。显然,本文提出的全色锐化方法具有最好的性能,其次是Hyper Transformer。本文方法在大多数波段误差较低,这也表明其能更好地重建HR-HSI。

图8

图8

Pavia Center(100,100)数据集上不同网络方法全色锐化结果与地面真值之间的差异

Fig.8

Differences between panchromatic sharpening results and ground truth values using different network methods on the Pavia Center (100,100) dataset

图9

图9

Botswana(30,30)数据集上不同网络方法的全色锐化结果与地面真值之间的差异

Fig.9

Differences between panchromatic sharpening results and ground truth values using different network methods on the Botswana (30,30) dataset

2.3 网络的参数量与运行速度对比

除了上述实验外,本研究还对不同全色锐化网络模型的参数和运行效率进行了比较实验,在Pavia Center数据集上进行实验,具体对比参数实验如表3 所示。

从表3 中可以发现,本文方法与PanNet,HyperPNN,GPPNN和Hyperkit相比参数数量略有增加,但定量评估指标PSNR显著提高。此外,本文方法的参数计数小于HyperTransformer,但PSNR优于HyperTransformer。表3 中时间代表平均训练每一个epoch所需要的时间,本文方法比HyperTransformer运行得更快,虽然具有大量的参数,但依赖于GPU的并行操作,其运行速度并不劣于PanNet、GPPNN和Hyperkit,并且本文方法获得了最好的PSNR。

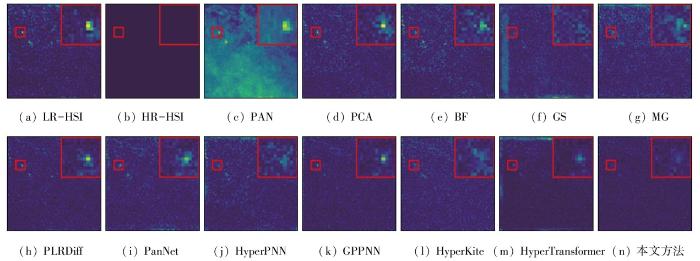

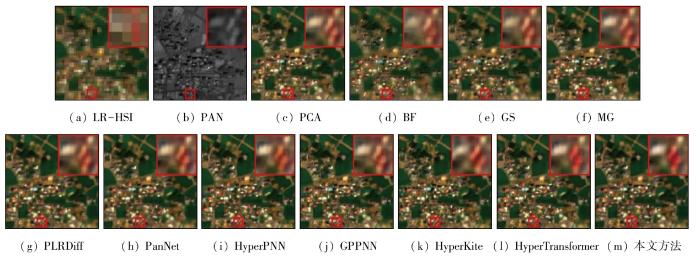

2.4 全分辨率下对比实验与实验结果分析

为说明本文提出的全色锐化方法的实际应用能力,基于Chikusei数据集进行了全分辨率实验,并利用真实的高分辨率全色图像与低分辨率的高光谱图像进行融合对比,可视化实验结果如图10 所示,实验结果见表4 。由于缺乏HR-HSI作为参考,实验只能在没有参考的情况下去计算质量评价[37 ] (quality-with-no-referance,QNR)、光谱损伤指数(${D}_{\mathrm{\lambda }}$ ) 和空间破坏指数(Ds )。其中,${D}_{\mathrm{\lambda }}$ Ds 用于评估原始PAN和生成的HR-HSI之间的空间相关性; QNR 为${D}_{\mathrm{\lambda }}$ Ds 相结合的综合指标。

图10

图10

Chikusei 数据集上的可视化实验结果(全分辨率)

Fig.10

Visualization experimental results on the Chikusei dataset (full resolution)

从表4 中可以看出,对于综合指标QNR ,本文方法具有最好的性能,总体效果最好。从图9 中也可以看出,本文方法具有更好的全色锐化效果,尤其是在局部放大的部分,优于其他方法,进一步证明了本文方法的广泛适用性和稳健性。

2.5 消融实验研究

为进一步证明提出的三流 Transformer对高光谱遥感图像全色锐化的有效性,从FEM、Transformer模块以及多头(N)数量等方面进行消融实验。将无FEM模块、无Transformer模块以及N =12作为基线(Baseline)结果。实验结果如表5 所示。从表5 中可以看出,随着多头数量的增加,网络的全色锐化性能最初有所提高,但随后有所下降。当N =12时,网络模型实现了最佳性能。模块消融实验结果如表6 所示,其中的B/L即为Baseline,从中可以看出,FEM模块和Transformer模块都对最终的全色锐化结果作出了重大贡献。与基线相比,FEM模块可使CC指数增加4.39%,PSNR指数增加2.58,SAM指数减少1.51,RMSE指数减少0.42%,ERGAS指数减少1.58。Transformer模块将CC指数提高5.89%,PSNR指数提高约6.36,SAM指数降低约2.34,RMSE指数降低约1.35%,ERGAS指数降低2.67。本文提出的完整的全色锐化方法进一步提高了这些质量指标。

3 结论与总结

本文提出了双阶段的全色锐化网络,第一阶段的核心为特征增强模块,可以有效地增强LR-HSI图像的光谱特征与空间特征。特征增强模块在多个尺度上应用,通过不同尺度的PAN的空间信息去增强对应尺度LR-HSI,通过多尺度信息融合模块将不同尺度的信息特征图融合在一起,生成初步增强的LR-HSI。第二阶段的核心为Transformer模块,从3种流的角度出发,利用多头注意力机制去指导遥感图像光谱信息和空间信息的提取与融合。此外,还在几个广泛使用的数据集上进行实验,从定量和定性上证明本文的全色锐化方法好于现有其他全色锐化方法。然而,与大多数基于深度学习的高光谱全色锐化方法相同,由于不同光谱波段的数据集网络都需要重新训练,很难形成统一的全色锐化范式,因此设计一个自适应的组件可以应对不同高光谱波段的遥感影像,并提高其泛化能力是未来研究的工作重点之一。

参考文献

View Option

[1]

Patil P M R Shirashyad P V V Pandhare P P S et al . An overview of sustainable development applications using artificial intelligence and remote sensing in urban planning

[J]. Interantional Journal of Scientific Research in Engineering and Management , 2023 , 7 (10 ):1 -11 .

[本文引用: 1]

[2]

Zhao S H Wang Q Li Y et al . An overview of satellite remote sensing technology used in China’s environmental protection

[J]. Earth Science Informatics , 2017 , 10 (2 ):137 -148 .

DOI:10.1007/s12145-017-0286-6

URL

[本文引用: 1]

[3]

Hamad H N Mushref Z J . Digital processing of satellite imagery to determine the spatial distribution of vegetation cover in the neighborhoods of Ramadi city

[J]. Al-Anbar University Journal for Humanities , 2024 , 21 (1 ):317 -338 .

[本文引用: 1]

[4]

Martadinata I Gibran M N Kaunang E S et al . Axiological review of the philosophy of defense science in efforts to improve national defense capabilities

[J]. Jurnal Multidisiplin Madani , 2024 , 4 (3 ):473 -480 .

DOI:10.55927/mudima.v4i3

URL

[本文引用: 1]

[5]

Xie B Zhang H K Huang B . Revealing implicit assumptions of the component substitution pansharpening methods

[J]. Remote Sen-sing , 2017 , 9 (5 ):443 .

[本文引用: 1]

[6]

Wang P Yao H Y Huang B et al . Multiresolution analysis pansharpening based on variation factor for multispectral and panchromatic images from different times

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2023 ,61: 1 -17 .

[本文引用: 1]

[7]

Wu Z C Huang T Z Deng L J et al . VO net:An adaptive approach using variational optimization and deep learning for panchromatic sharpening

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2021 ,60:5401016.

[本文引用: 1]

[8]

Wu Z C Huang T Z Deng L J et al . LRTCFPan:Low-rank tensor completion based framework for pansharpening

[J]. IEEE Transactions on Image Processing , 2023 ,32:1640 -1655 .

[本文引用: 1]

[9]

Lin S Z Han Z Li D W et al . Integrating model- and data-driven methods for synchronous adaptive multi-band image fusion

[J]. Information Fusion , 2020 ,54:145 -160 .

[本文引用: 1]

[10]

Cao X H Lian Y S Wang K X et al . Unsupervised hybrid network of transformer and CNN for blind hyperspectral and multispectral image fusion

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2024 ,62:5507615.

[本文引用: 1]

[11]

Chen X Pan J S Lu J Y et al . Hybrid CNN-transformer feature fusion for single image deraining

[J]. Proceedings of the AAAI Conference on Artificial Intelligence , 2023 , 37 (1 ):378 -386 .

DOI:10.1609/aaai.v37i1.25111

URL

[本文引用: 1]

Since rain streaks exhibit diverse geometric appearances and irregular overlapped phenomena, these complex characteristics challenge the design of an effective single image deraining model. To this end, rich local-global information representations are increasingly indispensable for better satisfying rain removal. In this paper, we propose a lightweight Hybrid CNN-Transformer Feature Fusion Network (dubbed as HCT-FFN) in a stage-by-stage progressive manner, which can harmonize these two architectures to help image restoration by leveraging their individual learning strengths. Specifically, we stack a sequence of the degradation-aware mixture of experts (DaMoE) modules in the CNN-based stage, where appropriate local experts adaptively enable the model to emphasize spatially-varying rain distribution features. As for the Transformer-based stage, a background-aware vision Transformer (BaViT) module is employed to complement spatially-long feature dependencies of images, so as to achieve global texture recovery while preserving the required structure. Considering the indeterminate knowledge discrepancy among CNN features and Transformer features, we introduce an interactive fusion branch at adjacent stages to further facilitate the reconstruction of high-quality deraining results. Extensive evaluations show the effectiveness and extensibility of our developed HCT-FFN. The source code is available at https://github.com/cschenxiang/HCT-FFN.

[12]

He L Zhu J W Li J et al . HyperPNN:Hyperspectral pansharpe-ning via spectrally predictive convolutional neural networks

[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing , 2019 , 12 (8 ):3092 -3100 .

DOI:10.1109/JSTARS.4609443

URL

[本文引用: 2]

[13]

Yang J F Fu X Y Hu Y W et al . PanNet:A deep network architecture for pan-sharpening

[C]// 2017 IEEE International Conference on Computer Vision (ICCV).October 22-29,2017,Venice,Italy.IEEE , 2017 :1753 -1761 .

[本文引用: 2]

[14]

Deng L J Vivone G Jin C et al . Detail injection-based deep convo-lutional neural networks for pansharpening

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2021 , 59 (8 ):6995 -7010 .

DOI:10.1109/TGRS.2020.3031366

URL

[本文引用: 2]

[15]

Wang D Li Y Ma L et al . Going deeper with densely connected convolutional neural networks for multispectral pansharpening

[J]. Remote Sensing , 2019 , 11 (22 ):2608 .

DOI:10.3390/rs11222608

URL

[本文引用: 2]

In recent years, convolutional neural networks (CNNs) have shown promising performance in the field of multispectral (MS) and panchromatic (PAN) image fusion (MS pansharpening). However, the small-scale data and the gradient vanishing problem have been preventing the existing CNN-based fusion approaches from leveraging deeper networks that potentially have better representation ability to characterize the complex nonlinear mapping relationship between the input (source) and the targeting (fused) images. In this paper, we introduce a very deep network with dense blocks and residual learning to tackle these problems. The proposed network takes advantage of dense connections in dense blocks that have connections for arbitrarily two convolution layers to facilitate gradient flow and implicit deep supervision during training. In addition, reusing feature maps can reduce the number of parameters, which is helpful for reducing overfitting that resulted from small-scale data. Residual learning is explored to reduce the difficulty for the model to generate the MS image with high spatial resolution. The proposed network is evaluated via experiments on three datasets, achieving competitive or superior performance, e.g. the spectral angle mapper (SAM) is decreased over 10% on GaoFen-2, when compared with other state-of-the-art methods.

[16]

[本文引用: 1]

Guo P H Qiu J L Zhao S N . High frequency do-main multi-depth learning network for pansharpening

[J]. Remote Sensing for Natural Resources , 2024 , 36 (3 ):146 -153 .doi:10.6046/zrzyyg.2023133 .

[本文引用: 1]

[17]

路琨婷 , 费蓉蓉 , 张选德 . 融合卷积神经网络的遥感图像全色锐化

[J]. 计算机应用 , 2023 , 43 (9 ):2963 -2969 .

DOI:10.11772/j.issn.1001-9081.2022091458

[本文引用: 1]

在遥感图像全色锐化中,传统的成分替换(CS)和多分辨率分析(MRA)方法的线性注入模型没有考虑用于全色锐化传感器的相对光谱响应,而基于深度学习的方法对原图像特征的提取不足会导致融合结果中的光谱和空间信息的丢失。针对以上问题,提出一种结合传统与深度学习方法的全色锐化方法CMRNet。首先,将CS和MRA与卷积神经网络(CNN)相结合以实现非线性从而提高全色锐化方法性能;其次,设计残差通道(RC)块实现多尺度特征信息的融合提取,并利用通道注意力(CA)自适应地为不同通道的特征图分配不同的权值,从而学习更有效的信息。在QuickBird和GF1卫星数据集上对CMRNet进行训练和测试,实验结果表明,在降尺度QuickBird和GF1数据集上,与经典方法PanNet相比,CMRNet的峰值信噪比(PSNR)分别提高了5.48%和9.62%,其他指标也均有显著提高。可见,CMRNet能实现较好的全色锐化效果。

Lu K T Fei R R Zhang X D . Remote sensing image pansharpening by convolutional neural network

[J]. Journal of Computer Applications , 2023 , 43 (9 ):2963 -2969 .

DOI:10.11772/j.issn.1001-9081.2022091458

[本文引用: 1]

In the linear injection models of traditional Component Substitution (CS) and Multi-Resolution Analysis (MRA) in remote sensing image pansharpening, the relative spectral response of the sensor used for pansharpening is not considered. At the same time, the insufficient feature extraction of the original images caused by the deep learning-based methods results in the loss of spectral and spatial information in the fusion results. Aiming at the above problems, a pansharpening method combining traditional and deep learning methods was proposed, namely CMRNet. Firstly, CS and MRA were combined with Convolutional Neural Network (CNN) to achieve nonlinearity and improve the performance of pansharpening method. Secondly, the Residual Channel (RC) blocks were designed to realize the fusion and extraction of multi-scale feature information, and the feature maps of different channels were assigned different weights by using Channel Attention (CA) adaptively to learn more effective information. Experiments were conducted on QuickBird and GF1 satellite datasets. Experimental results show that on downscale QuickBird and GF1 datasets, compared with the classic method PanNet, CMRNet has the Peak Signal-to-Noise Ratio (PSNR) increased by 5.48% and 9.62% respectively, and other indexes also improved significantly, which verifies that CMRNet can achieve a better pansharpening effect.

[18]

Ma J Y Yu W Chen C et al . Pan-GAN:An unsupervised pan-sharpening method for remote sensing image fusion

[J]. Information Fusion , 2020 ,62:110 -120 .

[本文引用: 1]

[19]

Zhou H Y Liu Q J Wang Y H . PGMAN:An unsupervised generative multiadversarial network for pansharpening

[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing , 2021 ,14:6316 -6327 .

[本文引用: 1]

[20]

Qu J H Dong W Q Li Y S et al . An interpretable unsupervised unrolling network for hyperspectral pansharpening

[J]. IEEE Transactions on Cybernetics , 2023 , 53 (12 ):7943 -7956 .

DOI:10.1109/TCYB.2023.3241165

URL

[本文引用: 1]

[21]

Rui X Y Cao X Y Pang L et al . Unsupervised hyperspectral pansharpening via low-rank diffusion model

[J]. Information Fusion , 2024 ,107:102325.

[本文引用: 2]

[22]

Bandara W G C Patel V M . HyperTransformer:A textural and spectral feature fusion transformer for pansharpening

[C]// 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 18-24,2022,New Orleans,LA,USA.IEEE , 2022 :1757 -1767 .

[本文引用: 2]

[23]

Plaza A Benediktsson J A Boardman J W et al . Recent advances in techniques for hyperspectral image processing

[J]. Remote Sen-sing of Environment , 2009 ,113:S110 -S122 .

[本文引用: 1]

[24]

Ungar S G Pearlman J S Mendenhall J A et al . Overview of the earth observing one (EO-1) mission

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2003 , 41 (6 ):1149 -1159 .

DOI:10.1109/TGRS.2003.815999

URL

[本文引用: 2]

[25]

Yokoya N Lwasaki A . Airborne hyperspect-ral data over chikusei

[J] Space Appl.Lab.,Univ.Tokyo,Tokyo,Japan,Tech.Rep.SAL-2016-05-27 . 2016 May 27, 5 (5 ): 5 .

[本文引用: 2]

[26]

Bandara W G C Valanarasu J M J Patel V M . Hyperspectral pansharpening based on improved deep image prior and residual reconstruction

[J]. IEEE Transactions on Geoscience and Remote Sen-sing , 2021 ,60: 1 -16 .

[本文引用: 3]

[27]

Zheng Y X Li J J Li Y S et al . Hyperspectral pansharpening using deep prior and dual attention residual network

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2020 , 58 (11 ):8059 -8076 .

DOI:10.1109/TGRS.36

URL

[本文引用: 1]

[28]

Wald L . Quality of high resolution synthesised images:Is there a simple criterion? [M].2000 Third conference “Fusion of Earth data : merging point measurements,raster maps and remotely sensed images” , 2000 :99 -103 .

[本文引用: 2]

[29]

Zeng Y N Huang W Liu M G et al . Fusion of satellite images in urban area:Assessing the quality of resulting images

[C]// 2010 18th International Conference on Geoinformatics . June 18-20,2010,Beijing,China . IEEE , 2010 :1 -4 .

[本文引用: 1]

[30]

Loncan L De Almeida L B Bioucas-Dias J M et al . Hyperspectral pansharpening:A review

[J]. IEEE Geoscience and Remote Sen-sing Magazine , 2015 , 3 (3 ):27 -46 .

[本文引用: 1]

[31]

Yokoya N Yairi T Iwasaki A . Coupled nonnegative matrix factorization unmixing for hyperspectral and multispectral data fusion

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2012 , 50 (2 ):528 -537 .

DOI:10.1109/TGRS.2011.2161320

URL

[本文引用: 1]

[32]

Chavez P S Kwarteng A Y . Extracting spectral contrast in Landsat thematic mapper image data using selective principal component analysis

[J]. Photogrammetric Engineering and Remote Sensing , 1989 , 55 (1 ): 339 -348 .

[本文引用: 1]

[33]

Wei Q Dobigeon N Tourneret J Y . Bayesian fusion of multi-band images

[J]. IEEE Journal of Selected Topics in Signal Processing , 2015 , 9 (6 ):1117 -1127 .

DOI:10.1109/JSTSP.2015.2407855

URL

[本文引用: 1]

[34]

Aiazzi B Baronti S Selva M . Improving component substitution pansharpening through multivariate regression of MS+Pan data

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2007 , 45 (10 ):3230 -3239 .

DOI:10.1109/TGRS.2007.901007

URL

[本文引用: 1]

[35]

Aiazzi B Alparone L Baronti S et al . Context-driven fusion of high spatial and spectral resolution images based on oversampled multiresolution analysis

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2002 , 40 (10 ):2300 -2312 .

DOI:10.1109/TGRS.2002.803623

URL

[本文引用: 1]

[36]

Xu S Zhang J S Zhao Z X et al . Deep gradient projection networks for pan-sharpening

[C]// 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 20-25,2021,Nashville,TN,USA.IEEE , 2021 :1366 -1375 .

[本文引用: 1]

[37]

Zhuo Y W Zhang T J Hu J F et al . A deep-shallow fusion network with multidetail extractor and spectral attention for hyperspectral pansharpening

[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing , 2022 ,15:7539 -7555 .

[本文引用: 1]

An overview of sustainable development applications using artificial intelligence and remote sensing in urban planning

1

2023

... 随着卫星技术的发展,研究人员可以通过卫星传感器获取大量的遥感图像.遥感图像包含丰富的空间信息和光谱信息,因此可以为观测区域的观察任务和处理任务提供依据,例如,城市规划[1 ] 、环境保护[2 ] 、植被覆盖分类[3 ] 和国防监测[4 ] 等.然而,受到卫星传感器本身的限制,光学遥感卫星只能获得全色图像(panchromatic images,PAN)和低空间分辨率高光谱图像(low spatial resolution hyperspectral images,LR-HSI).PAN空间分辨率很高,但是只含一个波段,缺乏光谱信息; LR-HSI虽有很多个波段,富含丰富的光谱信息,但空间分辨率低,缺乏空间信息.因此,为了得到高分辨率的高光谱图像,遥感图像的全色锐化技术融合PAN和LR-HSI得到高空间分辨率的高光谱图像(high spatial resolution hyperspectral images,HR-HSI),是常采用的手段之一. ...

An overview of satellite remote sensing technology used in China’s environmental protection

1

2017

... 随着卫星技术的发展,研究人员可以通过卫星传感器获取大量的遥感图像.遥感图像包含丰富的空间信息和光谱信息,因此可以为观测区域的观察任务和处理任务提供依据,例如,城市规划[1 ] 、环境保护[2 ] 、植被覆盖分类[3 ] 和国防监测[4 ] 等.然而,受到卫星传感器本身的限制,光学遥感卫星只能获得全色图像(panchromatic images,PAN)和低空间分辨率高光谱图像(low spatial resolution hyperspectral images,LR-HSI).PAN空间分辨率很高,但是只含一个波段,缺乏光谱信息; LR-HSI虽有很多个波段,富含丰富的光谱信息,但空间分辨率低,缺乏空间信息.因此,为了得到高分辨率的高光谱图像,遥感图像的全色锐化技术融合PAN和LR-HSI得到高空间分辨率的高光谱图像(high spatial resolution hyperspectral images,HR-HSI),是常采用的手段之一. ...

Digital processing of satellite imagery to determine the spatial distribution of vegetation cover in the neighborhoods of Ramadi city

1

2024

... 随着卫星技术的发展,研究人员可以通过卫星传感器获取大量的遥感图像.遥感图像包含丰富的空间信息和光谱信息,因此可以为观测区域的观察任务和处理任务提供依据,例如,城市规划[1 ] 、环境保护[2 ] 、植被覆盖分类[3 ] 和国防监测[4 ] 等.然而,受到卫星传感器本身的限制,光学遥感卫星只能获得全色图像(panchromatic images,PAN)和低空间分辨率高光谱图像(low spatial resolution hyperspectral images,LR-HSI).PAN空间分辨率很高,但是只含一个波段,缺乏光谱信息; LR-HSI虽有很多个波段,富含丰富的光谱信息,但空间分辨率低,缺乏空间信息.因此,为了得到高分辨率的高光谱图像,遥感图像的全色锐化技术融合PAN和LR-HSI得到高空间分辨率的高光谱图像(high spatial resolution hyperspectral images,HR-HSI),是常采用的手段之一. ...

Axiological review of the philosophy of defense science in efforts to improve national defense capabilities

1

2024

... 随着卫星技术的发展,研究人员可以通过卫星传感器获取大量的遥感图像.遥感图像包含丰富的空间信息和光谱信息,因此可以为观测区域的观察任务和处理任务提供依据,例如,城市规划[1 ] 、环境保护[2 ] 、植被覆盖分类[3 ] 和国防监测[4 ] 等.然而,受到卫星传感器本身的限制,光学遥感卫星只能获得全色图像(panchromatic images,PAN)和低空间分辨率高光谱图像(low spatial resolution hyperspectral images,LR-HSI).PAN空间分辨率很高,但是只含一个波段,缺乏光谱信息; LR-HSI虽有很多个波段,富含丰富的光谱信息,但空间分辨率低,缺乏空间信息.因此,为了得到高分辨率的高光谱图像,遥感图像的全色锐化技术融合PAN和LR-HSI得到高空间分辨率的高光谱图像(high spatial resolution hyperspectral images,HR-HSI),是常采用的手段之一. ...

Revealing implicit assumptions of the component substitution pansharpening methods

1

2017

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

Multiresolution analysis pansharpening based on variation factor for multispectral and panchromatic images from different times

1

2023

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

VO net:An adaptive approach using variational optimization and deep learning for panchromatic sharpening

1

2021

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

LRTCFPan:Low-rank tensor completion based framework for pansharpening

1

2023

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

Integrating model- and data-driven methods for synchronous adaptive multi-band image fusion

1

2020

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

Unsupervised hybrid network of transformer and CNN for blind hyperspectral and multispectral image fusion

1

2024

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

Hybrid CNN-transformer feature fusion for single image deraining

1

2023

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

HyperPNN:Hyperspectral pansharpe-ning via spectrally predictive convolutional neural networks

2

2019

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

PanNet:A deep network architecture for pan-sharpening

2

2017

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

... Comparison of runtime and total network parameters on the Pavia Center dataset

Tab.3 方法 参数总量 时间/s PSNR PanNet[15 ] 8.0×105 2.472 35.61 HyperPNN[13 ] 1.3×105 1.207 36.74 GPPNN 3.0×106 2.819 35.35 HyperKite[28 ] 5.2×105 2.413 38.97 HyperTransformer[24 ] 1.2×107 3.845 41.56 本文方法 5.8×106 3.176 42.82

从表3 中可以发现,本文方法与PanNet,HyperPNN,GPPNN和Hyperkit相比参数数量略有增加,但定量评估指标PSNR显著提高.此外,本文方法的参数计数小于HyperTransformer,但PSNR优于HyperTransformer.表3 中时间代表平均训练每一个epoch所需要的时间,本文方法比HyperTransformer运行得更快,虽然具有大量的参数,但依赖于GPU的并行操作,其运行速度并不劣于PanNet、GPPNN和Hyperkit,并且本文方法获得了最好的PSNR. ...

Detail injection-based deep convo-lutional neural networks for pansharpening

2

2021

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

Going deeper with densely connected convolutional neural networks for multispectral pansharpening

2

2019

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

... Comparison of runtime and total network parameters on the Pavia Center dataset

Tab.3 方法 参数总量 时间/s PSNR PanNet[15 ] 8.0×105 2.472 35.61 HyperPNN[13 ] 1.3×105 1.207 36.74 GPPNN 3.0×106 2.819 35.35 HyperKite[28 ] 5.2×105 2.413 38.97 HyperTransformer[24 ] 1.2×107 3.845 41.56 本文方法 5.8×106 3.176 42.82

从表3 中可以发现,本文方法与PanNet,HyperPNN,GPPNN和Hyperkit相比参数数量略有增加,但定量评估指标PSNR显著提高.此外,本文方法的参数计数小于HyperTransformer,但PSNR优于HyperTransformer.表3 中时间代表平均训练每一个epoch所需要的时间,本文方法比HyperTransformer运行得更快,虽然具有大量的参数,但依赖于GPU的并行操作,其运行速度并不劣于PanNet、GPPNN和Hyperkit,并且本文方法获得了最好的PSNR. ...

高频域多深度空洞网络的遥感图像全色锐化算法

1

2024

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

高频域多深度空洞网络的遥感图像全色锐化算法

1

2024

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

融合卷积神经网络的遥感图像全色锐化

1

2023

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

融合卷积神经网络的遥感图像全色锐化

1

2023

... 当前,遥感图像的全色锐化技术可分为传统模型方法和深度学习方法.传统模型方法有组件替换(component substitution,CS)[5 ] 、多分辨率分析(multi-resolution analysis,MRA)[6 ] 、变分优化(variational optimization,VO)[7 ] ,以及其他基于传统模型的全色方法[8 -9 ] .传统模型方法利用先验知识去寻找HR-HSI与PAN和LR-HSI之间的映射关系,具有逻辑性强、可解释高等优点,但没有从大量的数据中学习到关键的信息,锐化结果的准确性不高.近几年,基于深度学习的方法在图像融合任务中具有较好的性能[10 -11 ] ,众多研究人员将深度学习应用于遥感图像全色锐化.例如,He等[12 ] 提出了一种HyperPNN的网络,该网络将上采样的LR-HSI与PAN连接起来,以构建HR-HSI.此后,研究者们提出了更深层次网络来改进HyperPNN,例如FusionNet [13 ] 和PANNet[14 ] .此外,Wang等[15 ] 设计了一种具有44个卷积层的密集连接网络,加深的网络可以在一定程度上提高性能,但训练难度增加较大.以上基于深度卷积的方法,对PAN和LR-HSI图像进行直接特征拼接,但忽略了二者之间的联系.郭彭浩等[16 ] 提出一种基于多深度神经网络的遥感图像全色锐化方法,其包含结构保护和光谱保护2个模块; 路琨婷等[17 ] 提出一种结合传统模型与深度学习方法的全色锐化方法.但这些方法不能很好地指导空间信息与光谱信息提取与融合,且缺乏特征信息增强机制. ...

Pan-GAN:An unsupervised pan-sharpening method for remote sensing image fusion

1

2020

... 除此之外,还有很多基于无监督方法的研究,如Ma等[18 ] 提出一种新的基于生成对抗网络(generative adversarial network,GAN)的无监督全色锐化框架,称为PAN-GAN,该框架在网络训练过程中不需要真实的训练标签,生成器分别于光谱鉴别器和空间鉴别器建立对抗,以保持多光谱图像的丰富光谱信息和PAN的空间信息; Zhou等[19 ] 设计一种新的生成多对抗网络的全色锐化框架,通过使用双流生成器分别从PAN和多光谱图像中提取模态特定特征; Qu等[20 ] 将研究良好的全色锐化观测模型显式编码为无督展开迭代对抗性网络,构建一种新的可解释的无监督端到端的全色锐化网络; Rui等[21 ] 将扩散模型与低秩矩阵分解技术相结合,提出了一种无监督的全色锐化方法,并且推导了一种简单有效的方法来从观测到的光谱图像中预估计系数矩阵.但这些方法由于没有地面真值标签作为参考,其最终生成图像的质量有待改善,并且训练过程的稳健性有待提高. ...

PGMAN:An unsupervised generative multiadversarial network for pansharpening

1

2021

... 除此之外,还有很多基于无监督方法的研究,如Ma等[18 ] 提出一种新的基于生成对抗网络(generative adversarial network,GAN)的无监督全色锐化框架,称为PAN-GAN,该框架在网络训练过程中不需要真实的训练标签,生成器分别于光谱鉴别器和空间鉴别器建立对抗,以保持多光谱图像的丰富光谱信息和PAN的空间信息; Zhou等[19 ] 设计一种新的生成多对抗网络的全色锐化框架,通过使用双流生成器分别从PAN和多光谱图像中提取模态特定特征; Qu等[20 ] 将研究良好的全色锐化观测模型显式编码为无督展开迭代对抗性网络,构建一种新的可解释的无监督端到端的全色锐化网络; Rui等[21 ] 将扩散模型与低秩矩阵分解技术相结合,提出了一种无监督的全色锐化方法,并且推导了一种简单有效的方法来从观测到的光谱图像中预估计系数矩阵.但这些方法由于没有地面真值标签作为参考,其最终生成图像的质量有待改善,并且训练过程的稳健性有待提高. ...

An interpretable unsupervised unrolling network for hyperspectral pansharpening

1

2023

... 除此之外,还有很多基于无监督方法的研究,如Ma等[18 ] 提出一种新的基于生成对抗网络(generative adversarial network,GAN)的无监督全色锐化框架,称为PAN-GAN,该框架在网络训练过程中不需要真实的训练标签,生成器分别于光谱鉴别器和空间鉴别器建立对抗,以保持多光谱图像的丰富光谱信息和PAN的空间信息; Zhou等[19 ] 设计一种新的生成多对抗网络的全色锐化框架,通过使用双流生成器分别从PAN和多光谱图像中提取模态特定特征; Qu等[20 ] 将研究良好的全色锐化观测模型显式编码为无督展开迭代对抗性网络,构建一种新的可解释的无监督端到端的全色锐化网络; Rui等[21 ] 将扩散模型与低秩矩阵分解技术相结合,提出了一种无监督的全色锐化方法,并且推导了一种简单有效的方法来从观测到的光谱图像中预估计系数矩阵.但这些方法由于没有地面真值标签作为参考,其最终生成图像的质量有待改善,并且训练过程的稳健性有待提高. ...

Unsupervised hyperspectral pansharpening via low-rank diffusion model

2

2024

... 除此之外,还有很多基于无监督方法的研究,如Ma等[18 ] 提出一种新的基于生成对抗网络(generative adversarial network,GAN)的无监督全色锐化框架,称为PAN-GAN,该框架在网络训练过程中不需要真实的训练标签,生成器分别于光谱鉴别器和空间鉴别器建立对抗,以保持多光谱图像的丰富光谱信息和PAN的空间信息; Zhou等[19 ] 设计一种新的生成多对抗网络的全色锐化框架,通过使用双流生成器分别从PAN和多光谱图像中提取模态特定特征; Qu等[20 ] 将研究良好的全色锐化观测模型显式编码为无督展开迭代对抗性网络,构建一种新的可解释的无监督端到端的全色锐化网络; Rui等[21 ] 将扩散模型与低秩矩阵分解技术相结合,提出了一种无监督的全色锐化方法,并且推导了一种简单有效的方法来从观测到的光谱图像中预估计系数矩阵.但这些方法由于没有地面真值标签作为参考,其最终生成图像的质量有待改善,并且训练过程的稳健性有待提高. ...

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

HyperTransformer:A textural and spectral feature fusion transformer for pansharpening

2

2022

... 随着注意力机制和Transformer的出现,越来越多的研究者将这些算法用到遥感图像全色锐化中,Bandara等[22 ] 设计了一种称为HyperTransformer的网络架构,该架构通过多头特征软注意机制将PAN的HR纹理特征与LR-HSI光谱特征相结合,生成HR-HSI.HyperTransformer首次巧妙地解决了利用2个输入进行多头注意力计算的问题,使其特征提取更加具有指导性,但是上下采样的方式会极大破坏PAN空间像素的分布,进而损失空间信息. ...

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

Recent advances in techniques for hyperspectral image processing

1

2009

... 在本实验中,为了验证所提出方法的性能,使用3个公开的高光谱遥感图像数据集,分别是Pavia Center(102×1 096×715)[23 ] ,Botswana(145×1 476×145)[24 ] 和Chikusei(128×2 517×2 335)[25 ] .由于遥感图片尺寸较大,根据相关文献[26 -27 ] ,3个数据集分别被裁剪后的大小尺寸为24×102×160×160,24×145×120×120和210×128×160×160,数字含义为N ×C ×H ×W ,其中,C 为遥感数据集中的波段数量,N 为被裁剪之后图片的数量.接着,采用Wald协议[28 -29 ] 从HR-HSI生成PAN和LR-HSI,主要就是使用8×8高斯滤波器,再使用缩放因子为4的下采样算子为3个数据集生成LR-HSI图像,而PAN图像就是HR-HSI其中一个波段.随机选择80%的图片组作为每个数据集的训练集,其余的20%用于形成测试集.在可视化展示图片的过程中,Pavia Center数据集是以第10,30,60波段作为蓝绿红光谱波段,Botswana数据集是以第10,35,61作为蓝绿红光谱波段,Chikusei数据集是以第12,20,29作为蓝绿红光谱波段. ...

Overview of the earth observing one (EO-1) mission

2

2003

... 在本实验中,为了验证所提出方法的性能,使用3个公开的高光谱遥感图像数据集,分别是Pavia Center(102×1 096×715)[23 ] ,Botswana(145×1 476×145)[24 ] 和Chikusei(128×2 517×2 335)[25 ] .由于遥感图片尺寸较大,根据相关文献[26 -27 ] ,3个数据集分别被裁剪后的大小尺寸为24×102×160×160,24×145×120×120和210×128×160×160,数字含义为N ×C ×H ×W ,其中,C 为遥感数据集中的波段数量,N 为被裁剪之后图片的数量.接着,采用Wald协议[28 -29 ] 从HR-HSI生成PAN和LR-HSI,主要就是使用8×8高斯滤波器,再使用缩放因子为4的下采样算子为3个数据集生成LR-HSI图像,而PAN图像就是HR-HSI其中一个波段.随机选择80%的图片组作为每个数据集的训练集,其余的20%用于形成测试集.在可视化展示图片的过程中,Pavia Center数据集是以第10,30,60波段作为蓝绿红光谱波段,Botswana数据集是以第10,35,61作为蓝绿红光谱波段,Chikusei数据集是以第12,20,29作为蓝绿红光谱波段. ...

... Comparison of runtime and total network parameters on the Pavia Center dataset

Tab.3 方法 参数总量 时间/s PSNR PanNet[15 ] 8.0×105 2.472 35.61 HyperPNN[13 ] 1.3×105 1.207 36.74 GPPNN 3.0×106 2.819 35.35 HyperKite[28 ] 5.2×105 2.413 38.97 HyperTransformer[24 ] 1.2×107 3.845 41.56 本文方法 5.8×106 3.176 42.82

从表3 中可以发现,本文方法与PanNet,HyperPNN,GPPNN和Hyperkit相比参数数量略有增加,但定量评估指标PSNR显著提高.此外,本文方法的参数计数小于HyperTransformer,但PSNR优于HyperTransformer.表3 中时间代表平均训练每一个epoch所需要的时间,本文方法比HyperTransformer运行得更快,虽然具有大量的参数,但依赖于GPU的并行操作,其运行速度并不劣于PanNet、GPPNN和Hyperkit,并且本文方法获得了最好的PSNR. ...

Airborne hyperspect-ral data over chikusei

2

2016

... 在本实验中,为了验证所提出方法的性能,使用3个公开的高光谱遥感图像数据集,分别是Pavia Center(102×1 096×715)[23 ] ,Botswana(145×1 476×145)[24 ] 和Chikusei(128×2 517×2 335)[25 ] .由于遥感图片尺寸较大,根据相关文献[26 -27 ] ,3个数据集分别被裁剪后的大小尺寸为24×102×160×160,24×145×120×120和210×128×160×160,数字含义为N ×C ×H ×W ,其中,C 为遥感数据集中的波段数量,N 为被裁剪之后图片的数量.接着,采用Wald协议[28 -29 ] 从HR-HSI生成PAN和LR-HSI,主要就是使用8×8高斯滤波器,再使用缩放因子为4的下采样算子为3个数据集生成LR-HSI图像,而PAN图像就是HR-HSI其中一个波段.随机选择80%的图片组作为每个数据集的训练集,其余的20%用于形成测试集.在可视化展示图片的过程中,Pavia Center数据集是以第10,30,60波段作为蓝绿红光谱波段,Botswana数据集是以第10,35,61作为蓝绿红光谱波段,Chikusei数据集是以第12,20,29作为蓝绿红光谱波段. ...

... 为了定量评估所提出的全色锐化方法的质量,根据有关文献 [25 -26 ,30 -31 ] 使用不同空间和光谱角度的评价指标,包括互相关(cross-correlation,CC)、光谱角映射(spectral angle mapping,SAM)、均方根误差(root mean square errors,RMSE)、相对无量纲全局误差(errur relative globale adimensionnelle desynthese,ERGAS)和峰值信噪比(peak signal to noise ratio,PSNR).这些评价指标已在高光谱遥感图像处理领域广泛运用,也适用于评估光谱和空间分辨率的融合质量评价.所有实验都是在高性能计算机上进行的,该计算机搭配Intel(R)Xeon(R)Silver 4210R CPU@2.40 GHz 2.39 GHz、NVIDIA Quadro RTX 5000和64 GB RAM内存. ...

Hyperspectral pansharpening based on improved deep image prior and residual reconstruction

3

2021

... 在本实验中,为了验证所提出方法的性能,使用3个公开的高光谱遥感图像数据集,分别是Pavia Center(102×1 096×715)[23 ] ,Botswana(145×1 476×145)[24 ] 和Chikusei(128×2 517×2 335)[25 ] .由于遥感图片尺寸较大,根据相关文献[26 -27 ] ,3个数据集分别被裁剪后的大小尺寸为24×102×160×160,24×145×120×120和210×128×160×160,数字含义为N ×C ×H ×W ,其中,C 为遥感数据集中的波段数量,N 为被裁剪之后图片的数量.接着,采用Wald协议[28 -29 ] 从HR-HSI生成PAN和LR-HSI,主要就是使用8×8高斯滤波器,再使用缩放因子为4的下采样算子为3个数据集生成LR-HSI图像,而PAN图像就是HR-HSI其中一个波段.随机选择80%的图片组作为每个数据集的训练集,其余的20%用于形成测试集.在可视化展示图片的过程中,Pavia Center数据集是以第10,30,60波段作为蓝绿红光谱波段,Botswana数据集是以第10,35,61作为蓝绿红光谱波段,Chikusei数据集是以第12,20,29作为蓝绿红光谱波段. ...

... 为了定量评估所提出的全色锐化方法的质量,根据有关文献 [25 -26 ,30 -31 ] 使用不同空间和光谱角度的评价指标,包括互相关(cross-correlation,CC)、光谱角映射(spectral angle mapping,SAM)、均方根误差(root mean square errors,RMSE)、相对无量纲全局误差(errur relative globale adimensionnelle desynthese,ERGAS)和峰值信噪比(peak signal to noise ratio,PSNR).这些评价指标已在高光谱遥感图像处理领域广泛运用,也适用于评估光谱和空间分辨率的融合质量评价.所有实验都是在高性能计算机上进行的,该计算机搭配Intel(R)Xeon(R)Silver 4210R CPU@2.40 GHz 2.39 GHz、NVIDIA Quadro RTX 5000和64 GB RAM内存. ...

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

Hyperspectral pansharpening using deep prior and dual attention residual network

1

2020

... 在本实验中,为了验证所提出方法的性能,使用3个公开的高光谱遥感图像数据集,分别是Pavia Center(102×1 096×715)[23 ] ,Botswana(145×1 476×145)[24 ] 和Chikusei(128×2 517×2 335)[25 ] .由于遥感图片尺寸较大,根据相关文献[26 -27 ] ,3个数据集分别被裁剪后的大小尺寸为24×102×160×160,24×145×120×120和210×128×160×160,数字含义为N ×C ×H ×W ,其中,C 为遥感数据集中的波段数量,N 为被裁剪之后图片的数量.接着,采用Wald协议[28 -29 ] 从HR-HSI生成PAN和LR-HSI,主要就是使用8×8高斯滤波器,再使用缩放因子为4的下采样算子为3个数据集生成LR-HSI图像,而PAN图像就是HR-HSI其中一个波段.随机选择80%的图片组作为每个数据集的训练集,其余的20%用于形成测试集.在可视化展示图片的过程中,Pavia Center数据集是以第10,30,60波段作为蓝绿红光谱波段,Botswana数据集是以第10,35,61作为蓝绿红光谱波段,Chikusei数据集是以第12,20,29作为蓝绿红光谱波段. ...

2

2000

... 在本实验中,为了验证所提出方法的性能,使用3个公开的高光谱遥感图像数据集,分别是Pavia Center(102×1 096×715)[23 ] ,Botswana(145×1 476×145)[24 ] 和Chikusei(128×2 517×2 335)[25 ] .由于遥感图片尺寸较大,根据相关文献[26 -27 ] ,3个数据集分别被裁剪后的大小尺寸为24×102×160×160,24×145×120×120和210×128×160×160,数字含义为N ×C ×H ×W ,其中,C 为遥感数据集中的波段数量,N 为被裁剪之后图片的数量.接着,采用Wald协议[28 -29 ] 从HR-HSI生成PAN和LR-HSI,主要就是使用8×8高斯滤波器,再使用缩放因子为4的下采样算子为3个数据集生成LR-HSI图像,而PAN图像就是HR-HSI其中一个波段.随机选择80%的图片组作为每个数据集的训练集,其余的20%用于形成测试集.在可视化展示图片的过程中,Pavia Center数据集是以第10,30,60波段作为蓝绿红光谱波段,Botswana数据集是以第10,35,61作为蓝绿红光谱波段,Chikusei数据集是以第12,20,29作为蓝绿红光谱波段. ...

... Comparison of runtime and total network parameters on the Pavia Center dataset

Tab.3 方法 参数总量 时间/s PSNR PanNet[15 ] 8.0×105 2.472 35.61 HyperPNN[13 ] 1.3×105 1.207 36.74 GPPNN 3.0×106 2.819 35.35 HyperKite[28 ] 5.2×105 2.413 38.97 HyperTransformer[24 ] 1.2×107 3.845 41.56 本文方法 5.8×106 3.176 42.82

从表3 中可以发现,本文方法与PanNet,HyperPNN,GPPNN和Hyperkit相比参数数量略有增加,但定量评估指标PSNR显著提高.此外,本文方法的参数计数小于HyperTransformer,但PSNR优于HyperTransformer.表3 中时间代表平均训练每一个epoch所需要的时间,本文方法比HyperTransformer运行得更快,虽然具有大量的参数,但依赖于GPU的并行操作,其运行速度并不劣于PanNet、GPPNN和Hyperkit,并且本文方法获得了最好的PSNR. ...

Fusion of satellite images in urban area:Assessing the quality of resulting images

1

2010

... 在本实验中,为了验证所提出方法的性能,使用3个公开的高光谱遥感图像数据集,分别是Pavia Center(102×1 096×715)[23 ] ,Botswana(145×1 476×145)[24 ] 和Chikusei(128×2 517×2 335)[25 ] .由于遥感图片尺寸较大,根据相关文献[26 -27 ] ,3个数据集分别被裁剪后的大小尺寸为24×102×160×160,24×145×120×120和210×128×160×160,数字含义为N ×C ×H ×W ,其中,C 为遥感数据集中的波段数量,N 为被裁剪之后图片的数量.接着,采用Wald协议[28 -29 ] 从HR-HSI生成PAN和LR-HSI,主要就是使用8×8高斯滤波器,再使用缩放因子为4的下采样算子为3个数据集生成LR-HSI图像,而PAN图像就是HR-HSI其中一个波段.随机选择80%的图片组作为每个数据集的训练集,其余的20%用于形成测试集.在可视化展示图片的过程中,Pavia Center数据集是以第10,30,60波段作为蓝绿红光谱波段,Botswana数据集是以第10,35,61作为蓝绿红光谱波段,Chikusei数据集是以第12,20,29作为蓝绿红光谱波段. ...

Hyperspectral pansharpening:A review

1

2015

... 为了定量评估所提出的全色锐化方法的质量,根据有关文献 [25 -26 ,30 -31 ] 使用不同空间和光谱角度的评价指标,包括互相关(cross-correlation,CC)、光谱角映射(spectral angle mapping,SAM)、均方根误差(root mean square errors,RMSE)、相对无量纲全局误差(errur relative globale adimensionnelle desynthese,ERGAS)和峰值信噪比(peak signal to noise ratio,PSNR).这些评价指标已在高光谱遥感图像处理领域广泛运用,也适用于评估光谱和空间分辨率的融合质量评价.所有实验都是在高性能计算机上进行的,该计算机搭配Intel(R)Xeon(R)Silver 4210R CPU@2.40 GHz 2.39 GHz、NVIDIA Quadro RTX 5000和64 GB RAM内存. ...

Coupled nonnegative matrix factorization unmixing for hyperspectral and multispectral data fusion

1

2012

... 为了定量评估所提出的全色锐化方法的质量,根据有关文献 [25 -26 ,30 -31 ] 使用不同空间和光谱角度的评价指标,包括互相关(cross-correlation,CC)、光谱角映射(spectral angle mapping,SAM)、均方根误差(root mean square errors,RMSE)、相对无量纲全局误差(errur relative globale adimensionnelle desynthese,ERGAS)和峰值信噪比(peak signal to noise ratio,PSNR).这些评价指标已在高光谱遥感图像处理领域广泛运用,也适用于评估光谱和空间分辨率的融合质量评价.所有实验都是在高性能计算机上进行的,该计算机搭配Intel(R)Xeon(R)Silver 4210R CPU@2.40 GHz 2.39 GHz、NVIDIA Quadro RTX 5000和64 GB RAM内存. ...

Extracting spectral contrast in Landsat thematic mapper image data using selective principal component analysis

1

1989

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

Bayesian fusion of multi-band images

1

2015

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

Improving component substitution pansharpening through multivariate regression of MS+Pan data

1

2007

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

Context-driven fusion of high spatial and spectral resolution images based on oversampled multiresolution analysis

1

2002

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

Deep gradient projection networks for pan-sharpening

1

2021

... 为了证明三流Transformer的有效性,将本文的模型与传统方法和近些年来的基于深度学习的方法进行了比较.常规方法有主成分分析[32 ] (principal component analysis,PCA)、贝叶斯融合[33 ] (bayesian fusion,BF)、gram-schmidt融合[34 ] (GS)、多分辨率通用[35 ] (multiresolution generalized,MG)和全色锐化低秩扩散模型[21 ] (pansharp-ening low-rank diffusion model,PLRDiff),而基于深度学习有PanNet[14 ] ,HyperPNN[12 ] ,HyperKite[26 ] ,GPPNN[36 ] ,HyperTransformer [22 ] 和等全色锐化方法. ...

A deep-shallow fusion network with multidetail extractor and spectral attention for hyperspectral pansharpening

1

2022

... 为说明本文提出的全色锐化方法的实际应用能力,基于Chikusei数据集进行了全分辨率实验,并利用真实的高分辨率全色图像与低分辨率的高光谱图像进行融合对比,可视化实验结果如图10 所示,实验结果见表4 .由于缺乏HR-HSI作为参考,实验只能在没有参考的情况下去计算质量评价[37 ] (quality-with-no-referance,QNR)、光谱损伤指数(${D}_{\mathrm{\lambda }}$ ) 和空间破坏指数(Ds ).其中,${D}_{\mathrm{\lambda }}$ Ds 用于评估原始PAN和生成的HR-HSI之间的空间相关性; QNR 为${D}_{\mathrm{\lambda }}$ Ds 相结合的综合指标. ...