0 引言

应用遥感技术进行建筑物提取的传统方法主要有基于像元和面向对象2类。基于像元的遥感影像建筑物提取方法是根据影像上由于各类地物的光谱差异所反映出的像元值差异,通过各种方法设定相应的规则来将存在差异的像元加以区分和归类,从而实现不同地物的分类。目前最常用的分类规则设定方法有最大似然法[3]、支持向量机[4]、决策树[5]、随机森林[6]、人工神经网络[7]等。这些方法具有算法成熟、可操作性高等优势,但没有综合考虑目标的空间、纹理等信息,而高分辨率遥感影像中建筑物形态多样、背景复杂,因此基于像元的提取方法容易出现“异谱同物”、“同谱异物”等问题,导致误分、漏分,使得提取结果的精度不高。面向对象分类[8]是目前高分辨率遥感影像建筑物提取的重要方法,该方法考虑到影像中建筑物的几何特征和纹理信息[9],有效地避免了基于像元分类中光谱差异带来的分类误差。但影像中复杂的场景(如树木遮挡、建筑阴影)会造成建筑物提取不完整; 同时单一的特征参数很难有效提取不同尺度的建筑信息[10]。另一方面,传统遥感提取方法都要经过人为选定分类规则,不仅存在工作量大、效率低等问题,还对不同传感器的多源遥感影像建筑物提取的泛化能力差,因此当下需要更有效、更自动化的遥感建筑物提取技术。

近年来,利用深度学习[11]实现遥感影像建筑物提取已取得了广泛应用,包括基于图像块[12,13]和基于全卷积神经网络(fully convolutional networks,FCN)[14,15]两类方法对图像进行像素级分类。基于图像块的方法通过评估像素周围的小斑块来分类每个像素,文献[12]将相邻区域的低层次形状特征与卷积神经网络(convolutional neural networks,CNN)特征相结合,能够保证建筑物提取的完整性,从而得到更精确的建筑物提取效果。但这种方法产生重叠斑块会导致冗余计算,而基于FCN方法进行端到端分割,可直接对像素进行分类,无需冗余计算,相比基于图像块方法更准确和高效。目前,诸多学者已在基于FCN的遥感建筑物提取研究中做出贡献,提出在网络中加入深度残差学习[16]、利用反卷积网络[17]、采用新型的激活函数(ELU)提高网络性能[18]、在卷积层采用更大的卷积核[19]和引入空洞卷积提取更大范围的建筑物特征[20]等方法,能够有效提取出具有不同尺度、丰富拓扑外观和复杂背景的建筑物。但上述基于FCN的遥感影像建筑物提取方法仍存在以下两个问题: 一是相比输入产生较低分辨率的输出特征图,造成小目标信息丢失,而在上采样中对高分辨率特征的浅层细节特征利用不充分; 二是特征层间的简单卷积操作不能充分利用不同层的特征信息。Sun等[21]提出一种新的网络结构即高分辨率深度神经网络,该网络能够在整个网络中保持特征图的高分辨率,在获得深层特征的同时保留浅层特征并使深浅层特征信息不断融合。这种网络结构能够有效结合网络中深浅层特征[22],将其应用于建筑物提取能有效提高小目标建筑物的提取能力,但该网络对特征抽取能力不足,信息传递能力难以满足建筑物提取的精确要求。而DenseNet利用密集连接块(DenseBlock)抽取不同层的特征信息,增强特征的复用能力,能有效提高建筑物分割的精度[23]。

针对当前小目标建筑信息丢失严重,现有网络特征利用能力不足,分割精度有待提升等问题,本文提出了一种新型的多层次感知网络建筑物提取方法,通过构建不同层级的并行网络,在提取深层特征的同时保留目标浅层信息,并在不同层级的网络中加入密集连接机制增强特征信息提取能力,同时在深层网络中利用空洞空间金字塔(atrous spatial pyramid pooling,ASPP)模块扩大感受野,获取建筑物多尺度信息。

1 研究方法

在CNN中,浅层特征的细节信息比较丰富,而深层特征具有丰富的语义信息[24]。传统基于编码和解码结构的CNN主要使用池化操作来获得高级语义信息,导致了特征分辨率和空间精度的损失,而解码器很难恢复这种精度。同时,在多次池化过程中,细节信息丢失严重,容易造成小目标的丢失。

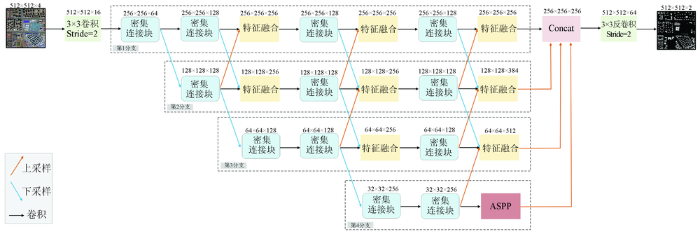

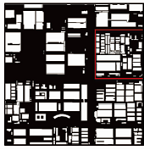

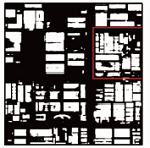

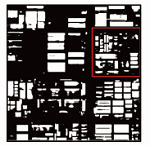

针对上述问题,本文通过多支网络并行与特征融合等方式连接高低分辨率,构建了全新的多层次感知网络。其中,多支网络并行的结构能够保留不同分辨率的特征信息,同时多级特征信息相互融合,有效减少空间信息的丢失; 每支网络中主要利用密集连接机制增强卷积层间的信息传递,提高特征信息的利用能力; 为顾及不同尺度的地物信息,在底层网络中利用ASPP结构获取深层多尺度特征感受野信息。本文提出的多层次感知网络能够充分利用不同分辨率的特征信息,捕捉多尺度地物信息,有效地提高遥感影像建筑信息的分割精度。该网络结构如图1所示。原始影像进入网络后,首先利用步长为2的卷积进行下采样操作减少特征图大小,降低计算量。接着,特征图每经过一次密集连接块后,都将进行下采样操作。同时每次下采样生成的特征图都将通过分支网络保持特征图大小,并利用密集连接块获取特征信息,共生成4个分支网络,输出 4 种不同分辨率的特征。4个分支网络由上到下依次为第1,2,3,4分支,每个分支网络利用特征融合模块实现不同分支网络间的多层次特征结合。为了获取建筑物深层特征的多尺度信息,网络在第4分支后增加了ASPP模块。在恢复特征信息过程中,第2,3,4分支通过连续上采样操作将特征图恢复到第1分支的特征图大小。将4支网络的特征图合并后,利用上采样操作将特征图恢复到原始影像大小,并利用softmax函数实现建筑物的精确分割。

图1

1.1 密集连接块

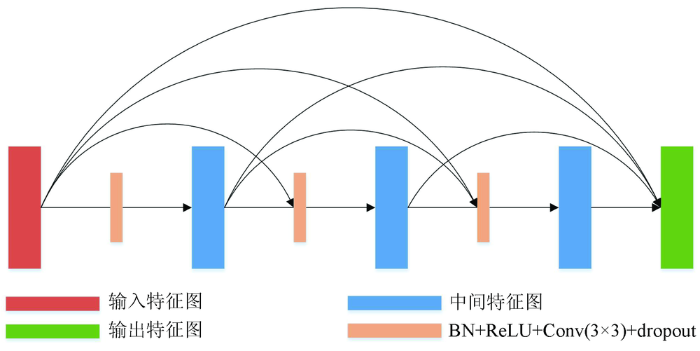

图2

式中: [X0,X1,X2,…,XL-1]为L层前的所有特征图; HL为非线性组合函数,包括批量归一化层(BN)、非线性激活层、卷积层(Conv)和dropout层。密集连接块不仅可以解决网络训练过程中出现的梯度消失等问题,还能够极大减少网络中的参数量。

1.2 ASPP结构

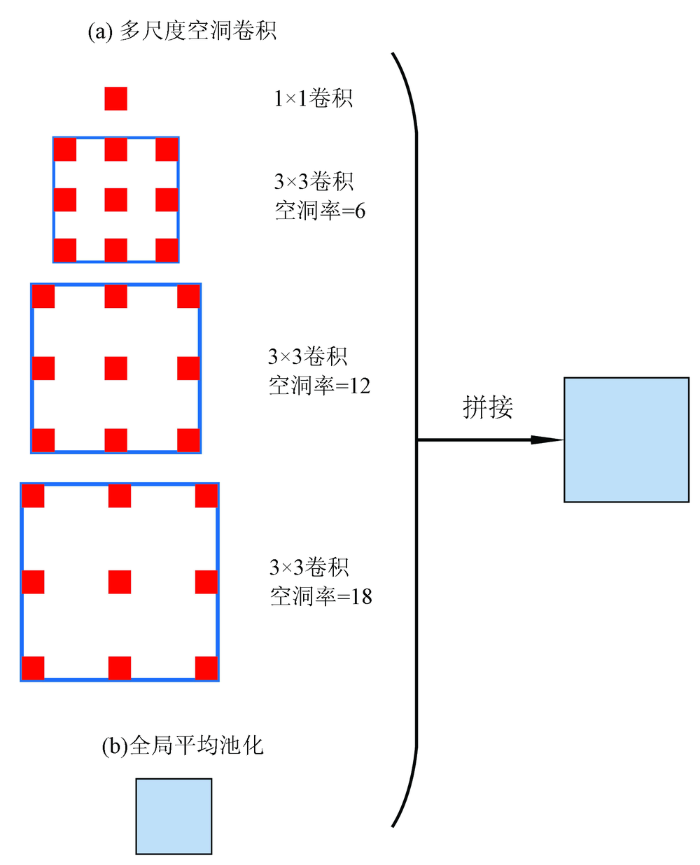

ASPP具体组成包括: (a)多尺度空洞卷积,一个1×1卷积和3个3×3的空洞率分别为6,12,18的空洞卷积; (b)全局平均池化,获得图像级特征。最后,两者拼接后卷积融合,如图3所示。

图3

1.3 特征融合模块

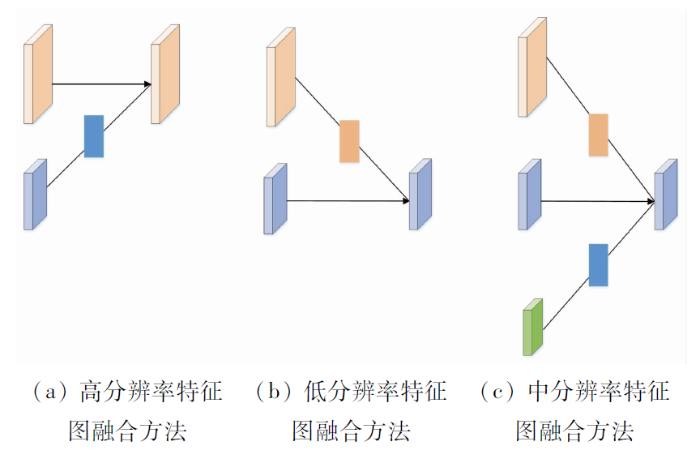

为了最大程度地保留高低分辨率特征,本文构建特征融合模块加强分支网络之间的深浅层特征结合与利用。该模块主要有3种表现形式,如图4所示。图4(a)为高分辨率特征图保持不变,低分辨率特征图通过1×1卷积将通道数保持与高分辨率相同维度,接着利用上采样插值将低分辨率特征图变为高分辨率特征图相同大小,而后将高分辨率特征图与低分辨率特征图通道叠加,再使用ReLU激活函数输出。图4(b)为低分辨率特征图保持不变,高分辨率特征图通过卷积核大小为3×3、步长为2、通道数与低分辨率特征图相同的卷积,将高分辨率特征图下采样至低分辨率特征图相同大小后,叠加高分辨率特征图与低分辨率特征图通道,再使用ReLU激活函数输出。图4(c)为保持中分辨率特征图不变,低分辨率特征图通过上采样插值变为中分辨率特征图相同大小,高分辨率特征图通过卷积核大小为3×3、步长为2、通道数与低分辨率特征图相同的卷积,将高分辨率特征图下采样至中分辨率特征图相同大小,而后将高、中、低分辨率特征图通道叠加,最后使用ReLU激活函数输出。

图4

2 数据与实验

2.1 数据介绍

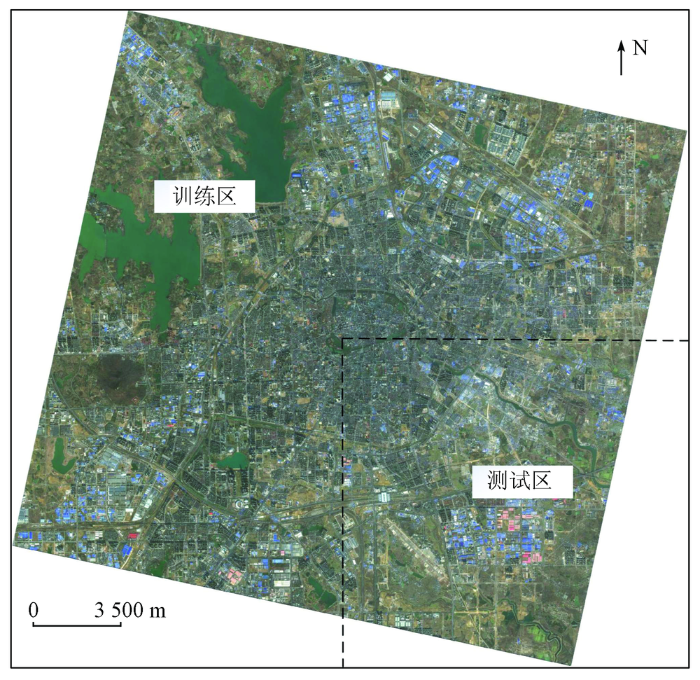

国产高分二号(GF-2)卫星全色影像空间分辨率为1 m,多光谱影像空间分辨率为4 m,包含蓝、绿、红、近红外4个波段。利用ArcMap10.2和ENVI5.3软件,采用目前被广泛应用的Gram-Schmidt影像融合算法完成多光谱影像和全色影像的融合,融合后影像空间分辨率为1 m。GF-2卫星遥感影像在提供建筑物丰富的地物光谱信息的同时,还能提供更多的地物结构、形状和纹理等细节信息。由于南北方城市的建筑物类型及分布形态存在差异,因此分别选取一景合肥市和一景天津市的GF-2遥感影像数据作为数据源。所选区域均为主城区,建筑物覆盖类型多样且密集,能够提供丰富的建筑物样本,提高样本库的多样性。同时,本文分别将合肥、天津影像的部分区域划分为测试数据,以安徽省合肥市部分区域为例,具体划分范围如图5所示。

图5

图5

合肥市训练区域和测试区域划分范围

Fig.5

Division scope of training area and testing area in Hefei

此外本文选用其他不同传感器和不同分辨率的数据,包括高分一号(GF-1)、高分六号(GF-6)以及高景(SV1)数据对本文方法进行泛化性验证。具体影像信息如表1。

表1 影像参数

Tab.1

| 用途 | 样本制作及模型测试 | 泛化性验证 | |||

|---|---|---|---|---|---|

| 传感器类型 地理位置 | GF2-PMS2 合肥市 | GF2-PMS1 天津市 | GF1-PMS1 铜陵市 2 2019-03-11 E118.4,N31.3 | GF6-PMS 合肥市 2 2020-05-04 E117.6,N31.3 | SV1 贵州市 |

| 空间分辨率/m 获取时间 中心坐标/(°) | 1 2017-01-26 E117.3,N31.9 | 1 2019-04-15 E117.4,N39.0 | 0.5 2019-12-25 E105.3,N25.9 | ||

2.2 样本库构建

样本示例如表2所示。

利用目视解译方法以建筑物屋顶轮廓为界限勾画建筑物矢量数据(边界精确到单个像元),再生成标签数据。为获取更大的建筑信息,本文按512×512和800×800的大小对影像和标签数据进行分割,并取多个不同切割步长来增加数据量,共生成23 372幅子图。其中训练数据和测试数据比例按3∶1进行随机筛选,最终17 373张用于模型训练,5 999张用于模型精度验证。

2.3 实验设计

本文在Tensorflow框架下进行网络模型的训练,在训练前对网络模型主要参数进行设置,训练过程中采用交叉熵损失函数,优化器使用Adam函数初始学习率为0.001,之后根据训练轮数epoch对学习率进行自动调整,动量参数设置为0.99。将每一轮的训练次数设置为5 000次,batch size设置为4,正则化系数为10-3,轮数为80轮。

2.4 精度评价方法

为了量化分析提取结果,本文采用基于像元的评价方法。通过统计对提取建筑物内的像元数量,常用评价指标有总体精度(overall accuracy,OA)、交并比(intersection-over-union,IOU)和综合评价指标F1值。其中OA是衡量分割精度的全局指标[29],能正确检测到建筑物和非建筑物像素的个数之和与所有像素个数的比值; IOU是检测结果与真实值的交集比上它们的并集,公式为:

式中: tp为真正值; fp为假正值; fn为假负值; r为正确像素在真实值中的比例; p为正确像素在预测结果中的比例。F1是精确度和召回率之间的几何平均值,又称两者的调和平均数,是衡量二分类模型精确度的一种指标,公式为:

3 结果与分析

3.1 实验结果

图6

表3 测试精度

Tab.3

| 区域 | OA | IOU | F1 |

|---|---|---|---|

| 合肥区域 | 96.52 | 72.60 | 84.45 |

| 天津区域 | 97.86 | 76.06 | 86.40 |

| 平均精度 | 97.19 | 74.33 | 85.43 |

3.2 不同方法的对比及分析

3.2.1 与传统方法的对比分析

表4 与传统方法提取精度对比

Tab.4

| 方法名称 | OA | IOU | F1 |

|---|---|---|---|

| 本文方法 | 97.19 | 74.33 | 85.43 |

| 最大似然法 | 58.68 | 35.13 | 50.17 |

| 支持向量机 | 84.03 | 45.47 | 62.46 |

| 面向对象 | 67.40 | 35.13 | 50.17 |

表5为本文方法与传统方法在图6中A—D区域的提取结果。由图可知,本文方法的建筑物提取结果相比另外3种传统方法,与地表真值符合程度更高。以图6中标记红框的区域A的工厂建筑进行研究对比发现,由于道路与灰色屋顶建筑的光谱特征较为接近,导致最大似然法和支持向量机对建筑物漏分和误分现象比较严重; 面向对象方法提取效果相比前两个方法较好,但建筑物间边界模糊不清晰。对于标记红框区域B的农村低矮建筑,受影像中复杂背景的影响,3种传统方法的提取结果均不理想。虽然面向对象的方法在某些场景提高了识别能力,但其准确性取决于训练样本的选择。对标记红框区域C的高层建筑对比发现,3种传统方法主要受高层建筑阴影的影响较大,且也出现了道路误提的现象。而标记红框区域D的密集型建筑中,支持向量机较另外两种传统方法的提取结果减少了误分的情况,但其相比本文方法在建筑物边界处理上不够精细,独立房屋没有被单独识别出来。高层次特征在建筑物提取中占主导地位,深度学习方法能够有效避免传统方法出现的“同物异谱”、“ 同谱异物”和“椒盐”噪声等问题。

表5 与传统方法提取结果对比

Tab.5

| 区域 | 遥感影像 | 标签 | 本文方法 | 最大似然法 | 支持向量机 | 面向对象 |

|---|---|---|---|---|---|---|

| A |  |  |  |  |  |  |

| B |  |  |  |  |  |  |

| C |  |  |  |  |  |  |

| D |  |  |  |  |  |  |

3.2.2 与深度学习方法对比分析

本文在相同的训练条件下,分别与DenseNet,DeeplabV3+和BiseNet这3种经典的深度学习网络模型对比分析。表6统计了不同方法测试的结果,从表6中可以看出,本文方法提取精度整体优于其他深度学习方法,在OA,IOU,F1上分别高出性能最好的DeeplabV3+方法6.18,4.32和2.72百分点,证明了该网络在高分辨率遥感影像建筑物提取方面的优越性。由表7可知,区域A中 DenseNet和BiseNet方法有明显的漏分现象且识别结果破碎,DeeplabV3+在建筑物提取的完整性上表现较好,但边界模糊使得多个建筑物间粘连,本文方法对边缘细节的处理和小目标的识别均优于其他3种方法。由区域B分析可知,对于小目标的识别本文方法更有优势,减少了漏分的现象。由区域C对比发现,对于不规则形状的建筑物,本文方法的识别效果更加完整。由区域D可知,对于密集型建筑的提取,

表6 与深度学习网络模型提取精度对比

Tab.6

| 方法名称 | OA | IOU | F1 |

|---|---|---|---|

| 本文方法 | 97.19 | 74.33 | 85.43 |

| DenseNet | 88.29 | 55.39 | 70.01 |

| DeeplabV3+ | 91.01 | 70.01 | 82.71 |

| BiseNet | 89.55 | 54.83 | 72.40 |

表7 与经典深度学习网络模型提取结果对比

Tab.7

| 区域 | 遥感影像 | 标签 | 本文方法 | DenseNet | DeeplabV3+ | BiseNet | |||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| A |  |  |  |  |  |  | |||||

| B |  |  |  |  |  |  | |||||

| C |  |  |  |  |  |  | |||||

| D |  |  |  |  |  |  | |||||

DenseNet和DeeplabV3+方法的结果均存在多处多个相邻建筑物间粘连的现象,BiseNet方法虽在这方面表现较好,但建筑物轮廓识别得不够完整。本文方法通过改进原有平行卷积神经网络,增加了密集连接块与ASPP结构,在提高对高空间分辨率遥感影像中建筑物的细节特征的提取能力和顾及全局上下文信息的同时,更有效地融合浅层特征的细节信息和深层特征的语义信息,对形态复杂及多尺度建筑物具有更好的提取效果。

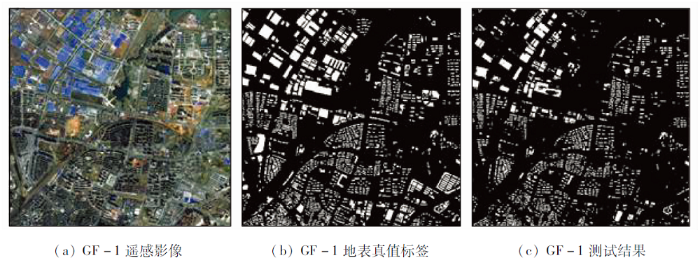

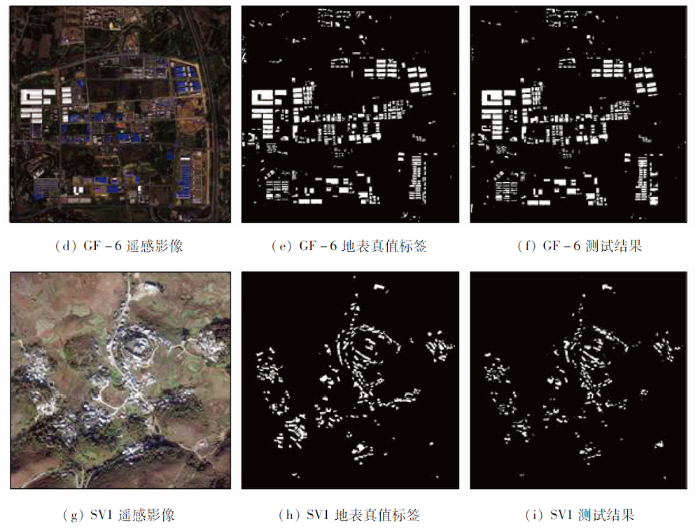

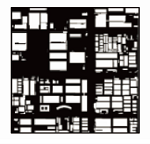

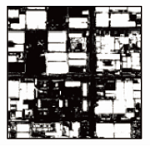

3.3 泛化性验证

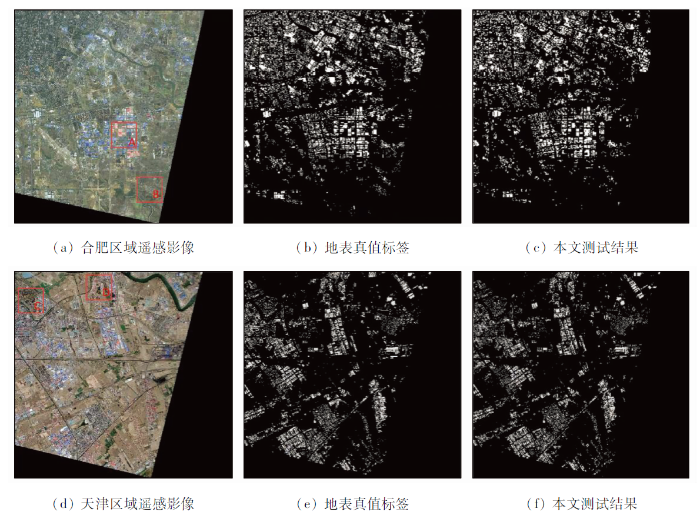

在遥感建筑物提取任务中,针对不同地区、不同传感器、不同分辨率的遥感影像,基于光谱的监督分类方法需要选取不同的感兴趣区,面向对象分类方法需要人为确定不同的分类规则,故传统分类方法泛化性较差。本文提出的多层次感知网络利用训练好的GF-2模型可直接对不同传感器的遥感影像进行建筑物自动化提取。为验证本文方法的泛化能力,本文选取GF-1,GF-6和SV1影像数据进行泛化性验证,提取结果如图7所示。从图7的测试结果可以看出,本文方法在不同传感器遥感影像上的建筑物提取效果良好。对于GF-1和GF-6遥感影像,在密集城区建筑中存在部分低矮建筑的漏分和误分,但总体来说本文方法仍具有良好的识别效果。对于SV1遥感影像中的农村建筑,受周围树木遮盖的影响,建筑物边界轮廓不够完整。表8为各类影像的提取精度。实验证明,本文方法在GF-1,GF-6以及SV1影像上也具备较好的泛化性,其中高分辨率的SV1影像测试结果的总体精度达95.93%。

图7-1

图7-2

表8 测试精度表

Tab.8

| 影像类型 | OA | IOU | F1 |

|---|---|---|---|

| GF-1 | 82.75 | 60.32 | 75.25 |

| GF-6 | 90.96 | 87.81 | 93.51 |

| SV1 | 95.93 | 51.95 | 68.37 |

4 结论

本文为克服遥感影像建筑物提取中小目标建筑的漏提现象,提出了一种多层次感知网络。该网络通过不断融合不同层级之间的特征信息并增强特征抽取能力,可以有效提升建筑物的分割精度并减少小目标漏提现象。通过与传统遥感提取方法和基于深度学习的语义分割算法的试验结果作对比并经过泛化性实验,得出以下几点结论。

1)本文方法对建筑物提取效果良好,在OA,IOU,F1这3种精度评价指标上分别为97.19%,74.33%,85.43%,各指标均高于传统方法。相比其他深度学习的语义分割算法,能在保持较高分类精度的同时,有效地识别小目标建筑并处理边缘细节,对于多尺度建筑物具有更好的提取效果。

2)本文方法对于GF-1,GF-6和SV1遥感影像具有较好的泛化性,增加了方法的实用能力,但对于分辨率较低的遥感影像存在漏分和误分的现象。后续工作将考虑加入多类传感器的建筑物样本,进一步提高模型的泛化性能,以期取得更佳的建筑物提取效果。

参考文献

基于特征提取的北方乡村景观建筑物层次化布局研究

[J].

Research on hierarchical distribution of buildings in northern rural landscape based on feature extraction

[J].

Novel unsupervised classification of collapsed buildings using satellite imagery,hazard scenarios and fragility functions

[J].DOI:10.3390/rs10020296 URL [本文引用: 1]

基于裸土期多时相遥感影像特征及最大似然法的土壤分类

[J].

Soil classification based on maximum likelihood method and features of multitemporal remote sensing images in bare soil period

[J].

基于支持向量机的遥感图像建筑物识别与分类方法研究

[J].

Remote sensing image building recognition and classification based on the support vector machine

[J].

基于CART决策树提取高分辨率遥感影像建筑物信息

[J].

Extraction of building information from high resolution images based on CART decision tree

[J].

基于高分卫星遥感影像的城市建筑物提取研究

[J].

Research on extraction of urban buildings based on high satellite remote sensing images

[J].

基于BP神经网络的遥感影像分类方法

[J].

Classification for remote sensing image based on BP neural network

[J].

A combined fuzzy pixel-based and object-based approach for classification of high-resolution multispectral data over urban areas

[J].

Detecting informal settlements from IKONOS image data using methods of object oriented image analysis:An example from Cape Town (South Africa)

[M].

面向对象的高分辨率遥感影像城区建筑物分级提取方法

[J].

Objectoriented method of hierarchical urban building extraction from high-resolution remotesensing imagery

[J].

基于深度学习的建筑物识别

[J].

Building identification based on deep learning

[J].

Simultaneous extraction of roads and buildings in remote sensing imagery with convolutional neural networks

[J].

Machine learning for aerial image labeling

[D].

基于SegNet语义模型的高分辨率遥感影像农村建设用地提取

[J].

Rural construction land extraction from high spatial resolution remote sensing image based on SegNet semantic segmentation model

[J].

一种改进型U-Net遥感影像建筑物提取

[J].

An improved U-Net remote sensing image building extraction

[J].

Semantic segmentation of urban buildings from VHR remote sensing imagery using a deep convolutional neural network

[J].DOI:10.3390/rs11151774 URL [本文引用: 1]

Building extraction from multi-source remote sensing images via deep deconvolution neural networks

[C]//

Improved deep fully convolutional network with superpixel-based conditional random fields for building extraction

[C]//

Building footprint extraction from high-resolution images via spatial residual inception convolutional neural network

[J].DOI:10.3390/rs11070830 URL [本文引用: 1]

多尺度特征融合空洞卷积ResNet遥感图像建筑物分割

[J].

Building segmentation in remote sensing image based on multiscale-feature fusion dilated convolution resnet

[J].

Deep high-resolution representation learning for human pose estimation

[C]//

Building extraction in very high resolution imagery by dense-attention networks

[J].DOI:10.3390/rs10111768 URL [本文引用: 2]

一种新的多尺度深度学习图像语义理解方法研究

[J].

A new multiscale image semantic understanding method based on deep learning

[J].

Densely connected convolutional networks

[C]//

Land use classification of the deep convolutional neural network method reducing the loss of spatial features

[J].DOI:10.3390/s19122792 URL [本文引用: 1]

Encoder-decoder with atrous separable convolution for semantic image segmentation

[C]//

DeepLab:Semantic image segmentation with deep convolutional nets,atrous convolution,and fully connected CRFs

[J].DOI:10.1109/TPAMI.2017.2699184 URL [本文引用: 2]

An automatic and threshold-free performance evaluation system for building extraction techniques from airborne LiDAR data

[J].