0 引言

在地球观测技术的不断发展下,地球空间信息的获取已经进入了高分辨率的时期,描述地球空间信息的遥感影像数据已经成为人类认识世界、理解世界的重要信息来源[1]。高分辨率遥感图像中具有光谱特征信息和精细的多尺度空间结构特征,因此如何有效地从遥感图像中提取表征以及融合这些信息就成为了限制高分辨率遥感图像信息应用深入发展的关键。

按照图像特征反映信息的程度可以将其分为底层视觉特征、中层视觉特征和高层视觉特征3类,采用由简到繁逐步变化的处理方法,首先是直接提取图像光谱、纹理、结构信息的底层视觉特征; 其次是对提取的底层场景特征进行编码,再进一步提取更具判别能力信息的中层视觉特征; 最后是利用深度网络模型提取图像抽象信息的高层视觉特征[2]。

早期传统的遥感图像场景分类方法主要是基于底层和中层特征的人工提取技术,通过考虑图像的局部或全局的各种特征,根据其光谱、纹理、形状和空间结构等信息来进行特征提取,且获取的特征具有可解释性强的优点,其中具有代表性的特征提取方法包括尺度不变特征变换(scale-invariant feature transform,SIFT)、局部二进制模式(local binary pattern,LBP)、Gabor滤波器、灰度共生矩阵(gray-level co-occurrence matrix,GLCM)和方向梯度直方图(histogram of oriented gradient,HOG)等,常将其应用于图像场景分类[3,4,5,6]。近年来深度学习神经网络逐渐被更多地应用到了遥感图像的分析中,尤其是在语义分割,场景分类等方面,深度学习通过利用不同尺度感受野能够学习感知不同尺度图像特征的优势,取得了较好的效果[7,8],但对于图像的分辨率保持以及结果的可解释性仍存在一定的缺陷。

研究者分析发现,深度学习过程中得到的不同尺度特征图均对图像有着较强的表征能力。在利用深度学习进行遥感图像场景分类时,通常需要大量数据来支撑,否则就会因数据量过少而导致分类精度不高,因此就有文献提出采用遥感图像的多尺度特征对其进行分类来解决这一问题。Hu等[9]利用多尺度方式从最后一个卷积层提取出密集特征,再通过常用的特征编码方法将密集特征编码为全局图像特征并进行分类; 许夙晖等[10]提出利用非下采样Contourlet变换对遥感图像进行多尺度分解,利用深度卷积网络训练得到不同尺度的图像特征,再采用多核支持向量机进行图像场景分类; Li等[11]将卷积模型作为特征提取器提取特征,同时利用多尺度改进的Fisher核编码方法构建了卷积深度特征的中层特征表示,然后利用主成分分析(principal component analysis,PCA)和谱回归核判别分析方法将卷积层提取的中层特征与全连接层的特征融合再进行分类; Wang等[12]提出用局部聚合描述符向量分别对底层和中层的卷积特征进行编码,再通过PCA进行约简,得到层次全局特征,同时对全连通特征进行平均池化、归一化,形成新的全局特征,最后连接所有特征进行分类。然而在上述方法中,由于深度学习的池化操作会使得图像的细节信息在特征提取和传递过程中逐渐被模糊平滑,难以保持图像的分辨率,图像本身在局部会具有多尺度结构的细节特征。

针对上述问题,本文将图像的局部区域特征考虑在内,提出了一种基于多尺度灰度和纹理结构特征融合的遥感图像分类方法模型(multi-scale gray and texture structure feature fusion,Ms_GTSFF),将图像局部区域所蕴含的多尺度灰度信息和纹理结构特征同时考虑在内,获取到全面且有效描述图像区域特征的信息,大幅提升高分辨率遥感影像的分类识别性能。

1 算法原理

1.1 图像的多尺度纹理结构特征

纹理是图像中普遍存在而又难以描述的特征,可看作是一种反映图像像素空间分布特征的属性,常表现为在局部不规则而宏观上又有一定规律。图像的纹理反映了图像中物体的结构特征,具有尺度性、异向性、韵律性等特点,传统的纹理特征提取尺度较为单一,获取的图像信息有限,因此需要从多个尺度上表征图像内部纹理基元的排列、组合方式及其在多尺度上的变化,以更好地捕捉图像全面的结构特征及其细节信息,展现不同尺度感受野下图像的独有特性,使图像的多尺度纹理特征提取成为图像分类识别的重要方法之一。

1.1.1 旋转不变模式LBP

图像纹理特征提取的方法有很多,有统计法、结构法、信号处理法等,能够很好地用于简单纹理分类,但是难以解决多变的光照和观测条件下图像的纹理表征与识别问题。因此近年来提出了许多提取图像局部纹理基元并通过直方图统计其分布的方法,其中LBP算法是目前比较热门的一种纹理特征提取算法,它是用来描述图像局部纹理结构的特征描述符,反映了每个像素与其周围像素的关系,具有灰度和旋转不变性的显著优点。

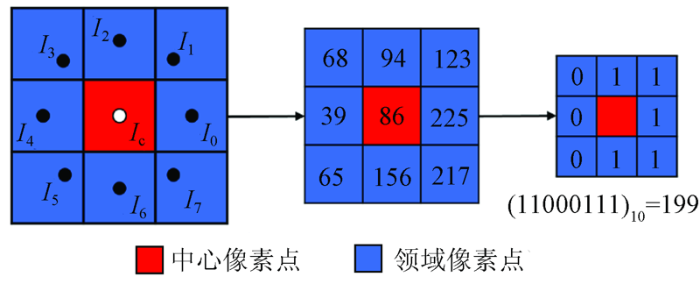

式中: R为邻域的半径; N为所取邻域内的像素点的数量; Ic为邻域的中心像素,In为周围邻域像素,如图1所示。LBPN,R对应的邻域集合中的N个像素可以形成2N个不同的二进制模式。当R=1,N=8时,LBP8,1描述符也就有256种(即28)不同的输出结果。

图1

然而采取原始LBP8,1得到的特征维度过大,且特征信息中存在过多的冗余信息,使得计算量和数据量急剧增加,不利于图像纹理特征表达的实际应用。Ojala等[13]经过大量的实验后统计发现,对图像进行原始LBP后得到的二进制序列中,会出现一些频率比较高的LBP编码值,反映图像的大部分纹理特征,把这些模式称为“等价模式”,表示编码中“0”⇔“1”变化的次数≤2时的情况,得到58维均匀模式编码,但此法不能解决图像的旋转问题。因此又提出了旋转不变等价LBP算子,将特征维度从256维降到了9维,使用9种编码模式来表述图像特征,但降低维数过大导致图像大量有效信息丢失。

综合上述因素,本文选择旋转不变局部二进制模式(rotation invariant local binary pattern,Ri-LBP)旋转不变LBP模式来处理图像,将特征维度从256维降到了36维,对应36种旋转不变LBP模式,既消除了一些冗余编码信息,同时还考虑了图像的旋转不变性,在降低特征维度的同时很大程度地保留了图像信息,其计算公式为:

式中: 上标ri表示“旋转不变”的含义; 函数ROR(x,i)表示对得到的N位二进制数x,进行i次循环逐位右移。当R=1,N=8时,可获得36维的旋转不变LBP特征LB

1.1.2 多尺度旋转不变模式LBP

在利用LBP获取图像的多尺度信息时,采用了多尺度局部二进制模式(Multi-scale LBP)的提取方法[14],能够更好地捕捉图像多尺度的结构信息,表现出大尺度感受野下图像的独特表征。

MsLB

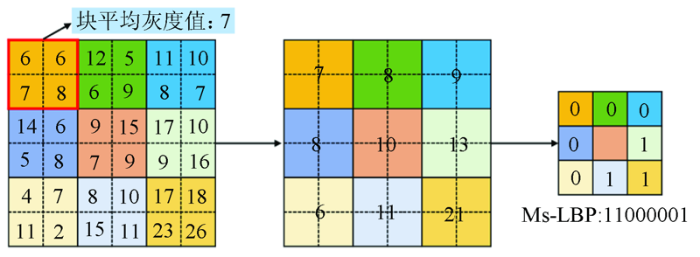

式中: Gc为中心矩形块内的平均像素强度,{G0,G1,…,G7}为邻域各矩形块内的像素均值,将Gc与其邻域矩形块内的像素均值{G0,G1,…,G7}进行比较,由此获得了一个二进制序列,同样也可得到36种不同多尺度的Ri-LBP模式。图2即尺度为2时对图像进行MsLBP的方法示意图,这种二进制模式可以在不同的尺度和位置检测到图像的不同结构,如点、线、角、边缘和平坦区域。另外与传统LB

图2

图像经原始的LBP8,1后得到的256维编码为等概率分布,但经旋转不变模式LBP对图像进行处理后得到的36维特征则变为以一定的条件概率出现,从而导致改进的特征编码面临先验概率影响的问题。如表1所示,对于Ri-LBP8,1有固定的二进制编码,且其值是由LBP8,1编码经旋转不变转换得到的,因此使得部分Ri-LBP8,1编码值对应于原始LBP8,1的多个编码值。在后续对Ri-LBP8,1进行直方图标准化时就会由于先验概率的影响而导致直方图特征间存在相关性无法处理,对此本文采用全概率公式来解决,公式为:

式中: B为经旋转不变改进后的特征编码; Ai为经原始LBP得到的等概率出现的特征编码,编码值范围为0~255。

表1 旋转不变LBP编码与原始LBP编码对应表

Tab.1

| Ri-LBP8,1 二进制编码 | Ri-LBP8,1 编码值 | LBP8,1 编码值 |

|---|---|---|

| 00000000 | 0 | 0 |

| 00000001 | 1 | 1,2,4,8,16,32,64,128 |

| …… | …… | …… |

| 11011111 | 34 | 127,191,223,239,247,251,253,254 |

| 11111111 | 35 | 255 |

1.2 图像多尺度灰度属性特征

图像的灰度属性特征可以从总体特征、局部特征以及LBP模式尺度特征3个维度进行表征。

图像总体灰度分布统计特征,即从灰度图像中获取其灰度值的整体分布情况,灰度图像中像素取值为0~255的灰度级,描述了图像显著的灰度属性特征,不同类图像的灰度分布各有其特点,因此对各类图像分别统计其灰度特征,就能够获取到不同类别图像各自蕴含的灰度属性信息,对图像的分类识别起到一定的作用。在进行计算图像的灰度分布特征时,通过统计图像每类中各灰度级出现的概率,从而得到每类图像对应的灰度概率分布直方图。

描述图像灰度特征的指标有很多,包括均值(mean)、方差(variance)、偏度(skewness)、峰态(variance)、能量(energy)、熵(entropy)等[15]。本文选取其中的灰度均值(mean)、灰度方差(variance)来计算遥感图像原始灰度图中的各类地物在不同尺度上的局部灰度分布,就可以得到图像中每类地物局部区域内的灰度分布信息以及在此区域中各点像素与其均值的离散状况等,得到关于图像的本征属性特征。

对原始灰度图像经过MsLB

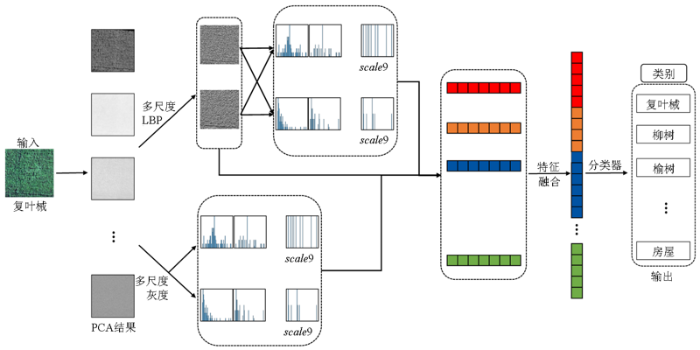

2 多尺度LBP特征融合模型

本文提出了Ms_GTSFF方法模型对图像进行特征提取,实现了对遥感图像各类场景灰度和纹理结构特征提取能力的改善,更全面地描述了图像的本征特征,利用所提出的模型可以获取蕴含图像纹理空间结构和灰度特征的综合图像特征,增强了所提取特征对图像的表征能力,进一步提升了遥感图像分类识别的效果。模型的结构流程如图3所示,其基本思想是先对原始图像进行PCA处理选取前20个主成分; 对PCA20数据提取不同尺度上的多尺度LBP特征(MsLBP)和多尺度灰度特征(MsG); 将2种多尺度特征进行融合,形成图像的最终特征,最后连接分类器进行分类识别。Ms_GTSFF方法模型的具体算法流程如下: ①对原始遥感图像进行PCA处理,消除图像不同波段间的相关性,选择其中前20个能够解释数据大部分信息的主成分; ②对步骤①选取的数据进行尺度大小为d×d,d=3,5,7,9,...,19的MsG特征提取,得到9个尺度下的多尺度灰度和方差的特征图,接着获得各尺度下特征的统计直方图,得到多尺度特征,再将不同尺度的直方图特征进行串联融合; ③对步骤①选取的数据同样进行尺度大小为d×d,d=3,5,7,9,...,19的MsLBP特征提取,得到9个尺度下的MsLBP特征图,同样统计其多尺度直方图特征,再将各尺度特征进行串联融合; ④在步骤③中得到的MsLBP直方图特征的基础上,统计其每个直方图编码所对应图像中的灰度特征,计算每种编码在9种尺度下对应的灰度均值和方差,得到多尺度LBP编码对应的灰度特征,同样将各尺度特征进行串联融合; ⑤将步骤②—④获取的多尺度特征进行串联融合,得到图像的多尺度综合特征; ⑥对步骤⑤得到的多尺度综合特征采用不同的机器学习分类器进行识别,得到最后的图像分类识别结果。

图3

3 算法测试及分析

3.1 测试数据

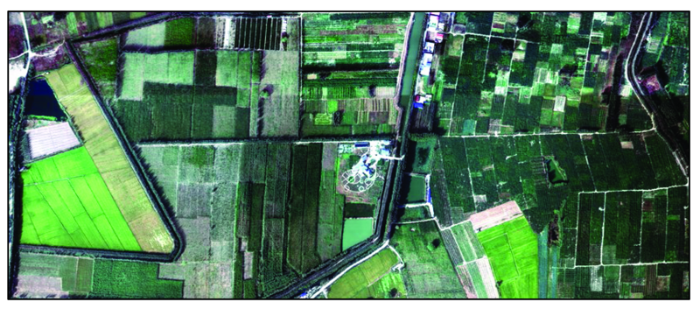

测试数据采用的是雄安新区(马蹄湾村)航空高光谱遥感影像数据集[16],其光谱范围为400~1 000 nm,波段数为256个,影像大小为1 580像元×3 750像元,空间分辨率为0.5 m,数据集中包括复叶槭、柳树、榆树、水稻、国槐、白蜡、栾树、水域、裸地、水稻茬、刺槐、玉米、梨树等20种不同地物,不同地物所占总数据的比例不同。在具体测试过程中,首先对原始所有波段的数据集DA进行了PCA预处理,从PCA结果中选取能解释图像大部分特征的前20个主成分分量为数据集D20; 接着再从D20的20种地物图像中,每类选取1 000个点,以采样点位置为中心,提取相邻9个尺度大小为d×d,d=3,5,7,9,...,19的邻域均值,构成3×3的LBP模式网格数据集D1并进行特征提取。如图4为实验选取的测试数据集示意图。

图4

3.2 数据特征分析

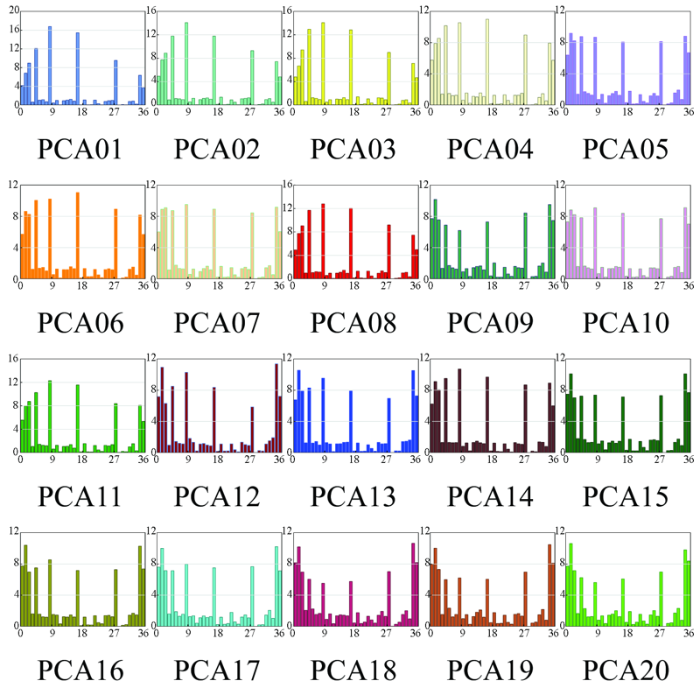

对遥感图像而言,不同波段数据之间存在一定的相关性导致冗余,因此本文采用PCA的方法对数据集进行降维,保留累计方差贡献率97%的前20个主成分分量。图5为以梨树类典型地物为例对DA全部数据进行PCA后选取前20个主成分分量,经过LB

图5

图5

梨树类区域经LB

Fig.5

Histogram of the area of pear by LB

图6

图6

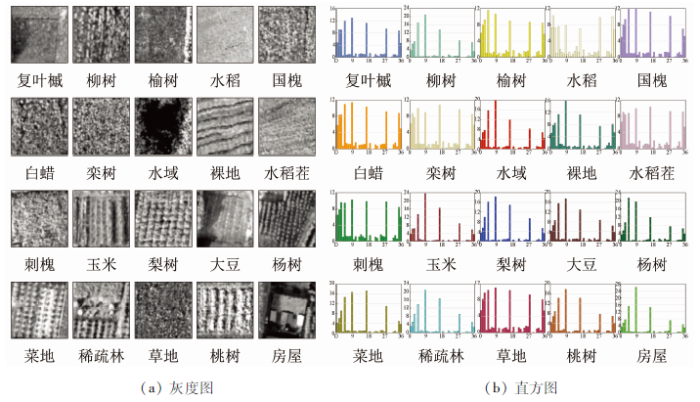

选取PCA01下20类地物的灰度图及LB

Fig.6

Grayscale image and LB

图6数据选取自遥感图像经PCA后得到的第1主成分分量中的20类地物的典型区域A0~A20,图6(a),(b)分别显示了Ai各自的典型灰度图及其对应经旋转不变LBP得到的统计直方图,可以看出不同类地物各自的灰度分布有着明显差异。图6(a)中右下角图描述了房屋类地物的灰度特征,可以直观地发现其灰度特征显著区别于左上角复叶槭类地物灰度分布,对应图6(b)中蓝框下的复叶槭和房屋类地物的LBP直方图其分布也大不相同; 同样的,水稻和梨树的直方图特征也能够明显区分,因此对遥感图像而言不同类地物有着其特有的灰度特征和纹理结构,灰度统计特征能表达不同类地物的灰度属性,利用LB

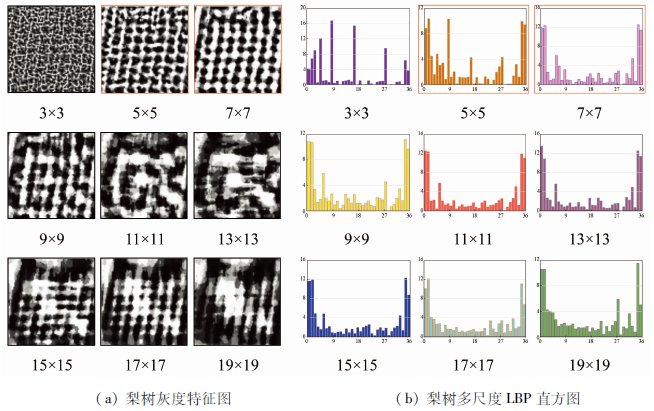

图7中为梨树类地物在不同尺度下获取的灰度特征图以及利用MsLB

图7

图7

图像在不同尺度下的灰度特征图和MsLB

Fig.7

Gray-scale feature maps and histogram of MsLB

综上,对于不同类别的图像在不同尺度下的灰度特征和纹理结构信息均有所区别,对不同类图像即使具有类似的灰度特征也会由于其自身纹理结构的不同而区分开,而对同类图像采用不同大小的尺度进行特征提取时所获得的纹理结构信息也各不相同。通常图像的单尺度特征仅能描述图像在当前尺度上像素分布的纹理结构而具有一定的局限性,无法全面反映图像的特征信息,容易导致图像特征相似而难以区分的现象; 综合考虑图像的多尺度信息才能较为全面地表达图像在纹理结构和灰度上的尺度性特点,使得对图像本征信息的描述更加完备,有效提升高分辨率遥感影像的分类识别性能。

3.3 测试结果与分析

通过对原始的所有波段的数据集DA和经PCA后选出的测试数据集D1进行了不同分类器的效果对比,另外还在测试数据集DA和D1上分别运用一些常见的深度学习网络: LeNet5,GoogLeNet与传统的LBP方法和MS_GTSFF方法模型进行了对比测试,结果如表2。表中Original代表原始光谱,PCA20代表原始光谱经PCA后取前20个主成分分量。

表2 不同分类器精度对比

Tab.2

| 分类器 | Original | PCA20 | LBP | Ms_GTSFF |

|---|---|---|---|---|

| Bayes | 29.16 | 56.81 | — | — |

| KNN | 50.88 | 72.53 | — | — |

| DT | 43.75 | 61.17 | — | — |

| BP | 75.83 | 81.81 | 93.28 | 99.44 |

| SVM | 48.75 | 77.55 | — | — |

| RF | 56.52 | 77.54 | 93.54 | 98.94 |

| XGB | 61.27 | 79.52 | 91.70 | 99.20 |

| LightGBM | 61.32 | 79.30 | 92.44 | 99.17 |

| LeNet5 | — | 94.72 | — | — |

| GoogLeNet | — | 95.59 | — | — |

根据表2中Original和PCA20的对比测试结果,发现对Original数据进行处理得到的结果均较差,最低为Bayes分类器得到的精度为29.16%,最高为采用BP分类器得到的精度75.83%; 而对于PCA20的数据进行测试得到的结果均比Original数据对应分类器得到的结果高,在SVM分类器上精度提高了28.8个百分点,最高是在BP分类器上得到的分类精度为81.81%。对比测试表明对数据集DA经过PCA预处理后选取的前20个主成分分量在保留能解释数据大部分信息的基础上消除了一些噪声影响,进而提升了分类识别效果。

此外,表2还对比了在PCA20的数据集D1运用传统LBP方法和本文方法在不同分类器上的测试结果,可以看出利用LBP方法对图像进行特征提取与分类的精度均达到了90%以上,但此种方法未将图像的多尺度灰度特征信息考虑在内。而利用Ms_GTSFF方法进行特征提取,既保留了LBP方法得到的结构特征还把图像的多尺度灰度属性特征融合在内,得到了最高的分类精度为99.44%,提升最高达到了7.5个百分点。与深度学习方法得到的分类结果相比,本文方法得到的精度更高且方法更加简洁有可解释性。实验对比结果充分说明了Ms_GTSFF方法的有效性,通过将图像的纹理结构特征与灰度特征融合起来,获得了图像更加全面有效的特征信息,使遥感图像分类效果显著提升,也为后续遥感图像信息的进一步分析与应用提供强有力的支撑。

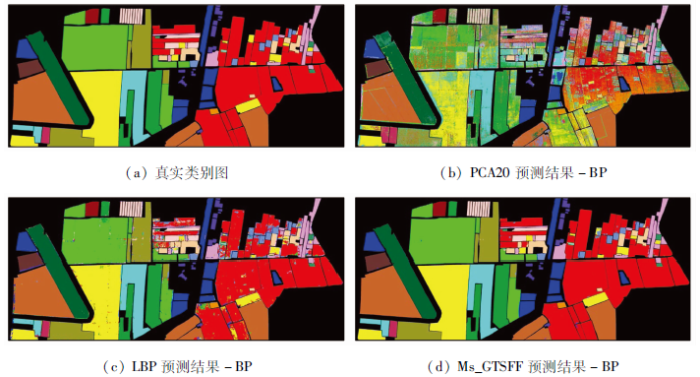

对测试数据集采用不同方法提取特征在BP分类器上得到的预测结果如图8所示,图8(a)表示图像真实类别图; 图8(b)表示对PCA20数据直接进行分类的预测结果图,可以看出对数据直接进行分类由于未考虑各点的邻域结构分布而导致每类地物中的预测结果会出现“椒盐”现象的识别错误点; 图8(c)表示对PCA20数据采用多尺度LBP方法后得到的最优预测结果图,该方法通过LBP提取出图像的局部纹理结构特征使识别结果有所提高,但由于类别边缘存在混合地物而难以识别; 图8(d)表示对PCA20数据采用Ms_GTSFF方法提取图像特征的最优预测结果图,通过提取图像的多尺度灰度和纹理结构特征信息,提高了对混合地物区域所提取特征的有效性,使获取的图像特征更加全面,进而分类识别精度大幅提高。

图8

图8

遥感图像各类场景分类结果图对比

Fig.8

Comparison of classification results of various scenes in remote sensing images

4 结论

本文提出了一种多尺度灰度分布和纹理结构特征融合(multi-scale gray and texture structure feature fusion,Ms_GTSFF)的方法模型,通过特征提取得到图像本身的多尺度灰度属性特征,同时再融合多尺度旋转不变局部二值模式(MsLB

1) 采用多尺度旋转不变局部二进制模式(Multi-scale Ri-LBP)的特征提取方法,能够以更多的感受野获取图像特征,将图像多尺度LBP直方图特征及其编码对应的图像灰度属性信息融合,通过充分考虑图像局部结构信息,有效解决了深度学习中的分辨率保持和可解释性问题。

2) 在雄安新区(马蹄湾村)航空高光谱遥感影像数据集的测试数据集上进行对比实验,结果表明与传统的逐像素方法提取图像特征的方式相比,本文方法使得高分辨率遥感图像的分类精度有了明显提升,获得的最高分类精度为99.44%,比LBP方法提升了7.5个百分点。另外还与深度学习不同网络进行了对比,结果显示采用Ms_GTSFF模型的图像分类精度更高,进一步说明本文方法在遥感图像分类特征提取过程中的有效性。

3) 有效改进传统方法在特征提取时只考虑图像的纹理特征而忽略其本征灰度属性特征的缺陷,同时从多尺度邻域出发有效获取了图像不同尺度下的纹理结构,克服了单尺度局部邻域提取图像信息的缺陷,最后采用多特征融合,显著提升了高分辨率遥感影像的分类识别性能,为未来进一步分析和应用遥感图像信息打下基础。

参考文献

基于深度对抗域适应的高分辨率遥感影像跨域分类

[J].

Deep adversarial domain adaptation method for cross-domain classification in high-resolution remote sensing images

[J].

基于CNN的高分遥感影像深度语义特征提取研究综述

[J].

A survey of depth semantic feature extraction of high-resolution remote sensing images based on CNN

[J].

Comparing SIFT descriptors and Gabor texture features for classification of remote sensed imagery

[C].DOI:10.1109/ICIP.2008.4712139 [本文引用: 1]

Evaluating the potential of texture and color descriptors for remote sensing image retrieval and classification

[C].

Land-use scene classification using multi-scale completed local binary patterns

[J].

Indexing of remote sensing images with different resolutions by multiple features

[J].DOI:10.1109/JSTARS.4609443 URL [本文引用: 1]

Gradient-based learning applied to document recognition

[J].DOI:10.1109/5.726791 URL [本文引用: 1]

Large patch convolutional neural networks for the scene classification of high spatial resolution imagery

[J].DOI:10.1117/1.JRS.10.025006 URL [本文引用: 1]

Transferring deep convolutional neural networks for the scene classification of high-resolution remote sensing imagery

[J].DOI:10.3390/rs71114680 URL [本文引用: 1]

利用多尺度特征与深度网络对遥感影像进行场景分类

[J].

Scene classification of remote sensing image based on multi-scale feature and deep neural network

[J].

Integrating multilayer features of convolutional neural networks for remote sensing scene classification

[J].

Aggregating rich hierarchical features for scene classification in remote sensing imagery

[J].DOI:10.1109/JSTARS.4609443 URL [本文引用: 1]

Multi-resolution gray-scale and rotation invariant texture classification with local binary patterns

[J].DOI:10.1109/TPAMI.2002.1017623 [本文引用: 2]

Face detection based on multi-block LBP representation

[C]//

不同照度下煤矸图像灰度及纹理特征提取的实验研究

[J].

Experimental study on gray and texture features extraction of coal and gangue image under different illuminance

[J].