0 引言

随着遥感技术的发展,我国在提高遥感影像分辨率方面有了重大突破,通过高分系列卫星采集的遥感影像分辨率已经达到了米级甚至是亚米级[1 ] 。与中分辨率和低分辨率的遥感影像相比较,高分辨率遥感影像中包含了更加丰富和详尽的细节信息。可以准确地反映出地表类型以及空间布局,但是由于地表建筑的空间分布和几何结构相当繁杂,导致同谱异物和同物异谱的现象愈加严重,为高分遥感影像的分类带来了巨大的挑战[2 ] 。

随着深度学习技术的发展,神经网络被广泛应用于图像处理领域,特别是卷积神经网络在遥感领域表现突出。如Liu等[3 ] 采用了多尺度的卷积结构,利用两个不同尺度的卷积结构分别提取不同的特征表示,学习到的特征具有尺度不变性,实现了对遥感数据的分类。Zan等[4 ] 提出了循环变换网络,能够学习到局部区域的特征表示,提取遥感影像的关键信息用于分类。Wang等[5 ] 提出了一种递归注意网络模型,能够捕捉遥感影像的关键区域的特征进行场景信息的理解。Sun等[6 ] 提出了一种双向门控网络结构,能够对不同分层的特征进行聚合以及消除干扰信息,去除冗余特征,增强了模型对于遥感影像潜在语义信息的理解。这些方法都是通过对网络结构进行优化用以提升其对于遥感特征的拟合能力,对于遥感影像中存在的纹理,形状,颜色的差别,以及拍摄的角度和高度问题没有进行针对性的训练,导致了网络模型的泛化能力不足。

当前的网络模型大多使用Softmax[7 ] 损失来衡量真实概率分布与模型预测概率分布之间的差异,使用模型预测概率分布表示真实概率分布的困难程度。该损失函数的值越大,说明该模型在真实标签的分类概率越小,性能也越差。由于Softmax损失仅仅惩罚整体分类的损失,忽略了遥感影像的类内差异性以及类间相似性,导致模型泛化能力不足,为了实现遥感影像的特征可分,Center损失[8 ] 、三元组损失[9 ] 、对比度损失[10 ] 以及L-Softmax损失[11 ] 等被先后提出。Center损失使用欧氏距离来衡量同类特征之间的距离,结合Softmax损失函数来进行网络结构的优化,忽略了遥感影像不同类别特征重叠的问题,导致模型训练效果一般。三元组损失和对比度损失需要构建遥感图像的三元组和图像对作为训练样本度量同类和异类之间的特征距离。用以提升模型对于各类特征的分类性能,但是由于训练样本的急剧增加,模型收敛变得缓慢和不稳定,增加了模型计算的复杂性并且使训练过程变得繁琐。L-Softmax损失是一种大间隔学习方法,引入了余弦余量项,最大化特征空间中的决策边缘。但是由于决策边缘的固定性,对所有特征进行相同程度的惩罚,无法进行针对性学习,并且类别之间间隔越大,相应类别的区域流形就越小,从而导致训练困难的问题。

针对以上问题,本文在中心损失的基础上提出了新的标签聚类损失。首先根据聚类中心的选取影响着聚类效果的好坏,提出了类标签中心初始化方法,对类别中心进行参数初始化; 模型在初始训练阶段没有形成一定的概率分布,遥感数据离散程度高,分布范围广,十分不稳定,为了保持各类别中心在模型初始训练阶段的稳定性,提出了正弦衰减学习率来控制类别中心的优化与训练; 最后使用欧氏距离与余弦距离进行类内特征的聚集,指数级欧氏距离和余弦距离进行类间中心的远离。通过联合交叉熵损失函数进行监督训练。使用了不同的网络模型进行验证。本文提出的损失函数不仅有效的实现了遥感影像同类特征的聚集以及类别中心的远离,并且在不增加网络模型复杂度,训练样本数量,以及训练时间的同时,有效提高了网络模型的特征拟合能力。

1 传统损失函数

1.1 Softmax损失函数

Softmax损失是遥感影像分类任务中最常用的损失函数,定义如下:

(1) L S o f t m a x = - 1 m ∑ i = 1 m l o g e x p ( W T x i + b y i ) ∑ j = 1 n e x p ( W j T x i + b i )

式中: m 为训练样本的批次大小; n 为训练样本的类别个数;x i ∈ R d i 个样本的特征值,并且样本属于y i W ∈ R d × n W j ∈ R d j 列;b ∈ R d

1.2 中心损失函数

为提高同类别特征的聚集性能,提升网络模型的可分性,使用欧氏距离来计算各个类别与类别中心之间的距离,并使其达到最小,使各类别特征向各自的类别中心进行聚集,由此提出了中心损失函数为:

(2) L c = 1 2 ∑ i = 1 m ‖ x i - c x i ‖ 2 2

式中:x i i 个样本的特征值;c x i ∈ R d i 个样本的特征所属类别中心; m 为训练批次的大小。该损失函数使用小批次训练的方式来进行网络模型的优化以及类别中心的更新,随着训练批次的更新,带动各类别所属样本及特征值产生变化,使类别中心c x i

(3) L t o t a l = L S o f t m a x + λ L c = - 1 m ∑ i = 1 m l o g e x p ( W T x i + b y i ) ∑ j = 1 n e x p ( W j T x i + b i ) + λ 2 ∑ i = 1 m ‖ x i - c x i ‖ 2 2

式中λ 为Softmax损失和中心损失的调节因子,用来调节两种损失函数所占比重。当λ =0时,表示仅使用Softmax损失函数。由于遥感影像同一类场景内存在较大的差别,导致每个集群内的特征值较为分散,且每类不同的场景内存在高度相似的部分,导致不同集群特征间有较大的重叠部分。虽然样本特征被拉向各自的类别中心,但是不同的特征集群之间存在着大量相交的部分。该损失函数在一定程度上可以提高模型对于遥感影像的特征辨别能力,但是还存在着进一步的优化空间。

2 标签聚类损失函数

2.1 类标签中心初始化

借鉴聚类算法[12 ] 中的思想,聚类中心的选取影响着聚类效果的好坏。本文模拟理想条件下的类别中心以及数据的分布情况,提出了一种类标签中心初始化方法来代替随机初始化。首先将网络模型最后一层全连接层提取的特征进行归一化处理,之后将每一类场景的类别标签进行独热编码,使每一个类别的标签数据生成一组二值向量,类别标签中对应的类别数目取值为1,其余的取值为0,然后进行数据平滑。能够降低正确标签的自信度,提高错误标签的关注度,也就是对模型的分类准确度进行一定的惩罚。不再只针对正确标签进行训练,也对错误标签进行惩罚训练,使网络模型在初始阶段就学到一个较优的类别中心,可以有效的降低网络模型训练的复杂度以及提高模型的泛化能力。类标签中心初始化表示为:

(4) c 0 = ( 1 - ε ) x + ε m + r a n d ( m , m )

式中:x ε m 为训练集的类别数目; rand 为随机初始化向量。

2.2 正弦衰减学习率

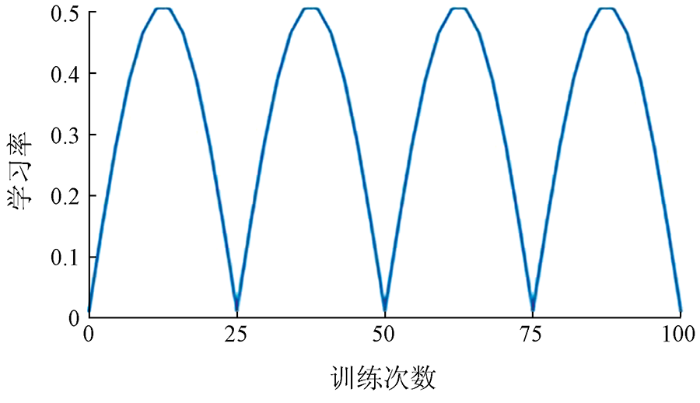

网络模型在初始训练阶段没有形成一定的概率分布,数据分布范围广,离散程度高,波动性大,十分不稳定,会对类标签中心造成较大程度影响甚至使其失效。为解决这一问题,本文提出了正弦衰减学习率,使类别中心在初始阶段以较小的学习率进行学习,然后逐渐增大,并使其从小到大进行周期性迭代。在解决模型预热阶段类标签中心失效问题的同时,防止模型训练陷入局部最优,使模型更好的收敛到最优解。正弦衰减学习率表示为:

(5) ∂ s = ∂ 0 ‖ s i n ( x s ) ‖ + ε , x s ∈ ( 0 , k π ) , k = 1,2 , 3 , … , N

式中:∂ 0 ε

如图1 所示为正弦衰减学习率示意图,横坐标轴代表训练次数,纵坐标轴代表学习率,类别中心开始阶段以较小的学习率开始学习,然后不断增大,模型经过预热阶段之后,学习率进行周期性的迭代变化,衰减周期为25个训练次数。其中正弦衰减学习率最小值为0.01,最大值为0.51。

图1

图1

正弦衰减学习率

Fig.1

Sine attenuation learning rate

2.3 聚类损失函数

遥感影像中存在着大量的角度,光照和颜色的变化。在度量遥感影像特征分布的任务中,中心损失函数仅通过减小类内特征之间的欧式距离,使特征值向各自类别中心聚集。虽然在一定程度上提高了网络模型的性能,但是依旧存在着进一步的优化空间。本文提出了一种新的聚类损失函数,使用欧氏距离和余弦距离来计算类内特征之间的距离,在考虑绝对距离的同时,考虑了相对方向的问题,使类内特征与类别中心的绝对直线距离与角度值大小同时达到最小,进行类内特征的聚集。使用指数级欧氏距离和余弦距离度量类间中心之间的距离,使各类别中心的直线距离和角度值达到最大,从而实现类别中心之间的分离。聚类损失函数的表达式为:

(6) L c = 1 2 ∑ i = 1 m ‖ x i - c x i ‖ 2 2 + β 0 ∑ i = 1 m 1 - x i · c x i ‖ x i ‖ 2 ‖ c x i ‖ 2 + β 1 ∑ c j ∈ N ∑ c k ∈ N c j ≠ c k c k · c j ‖ c k ‖ 2 ‖ c j ‖ 2 + 1 + e - 1 2 ∑ c j ∈ N ∑ ∑ c k ∈ N c j ≠ c k c j - c k ‖ 2 2

式中: m 为训练批次大小;x i c x i ∈ R d i 个样本特征所属的类别中心; N 为遥感影像的类别总数;c j j 类样本中心的取值;c k β 0 β 1

关于式(6)的更新以及优化,本文使用Adam优化算法进行网络模型的反向传播和优化。聚类损失函数L c x i

(7) ∂ L c ∂ x i = x i - c x i + c x i · x i ‖ c x i ‖ 2 ‖ x i ‖ 2 3 · x i - c x i ‖ c x i ‖ 2 ‖ x i ‖ 2

(8) Δ c j = ∑ i = 1 m δ ( x i = j ) c j - x i + β 0 x i · c x i 2 ‖ x i ‖ 2 ‖ c x i ‖ 2 3 - x i ‖ c x i ‖ 2 ‖ x i ‖ 2 1 + ∑ i = 1 m δ ( x i = j ) + β 1 N - 1 ∑ c k ∈ N c j ≠ c k c k ‖ c k ‖ 2 ‖ c j ‖ 2 - c k · c j 2 ‖ c k ‖ 2 ‖ c j ‖ 2 3 + 1 N - 1 e - 1 2 ∑ c j ∈ N ∑ c k ∈ N c j ≠ c k ‖ c j - c k ‖ 2 2 · ( c k - c j )

式中:δ ( x i = j ) xj 属于第j 类样本中心c j c j s ∂ s ∈ ( 0.01,0.51 )

(9) c j t + 1 = c j t - ∂ s Δ c j t

式中: t 为迭代次;∂ s c j t t 次迭代训练中第j 类别中心的取值;Δ c j t t 次迭代训练中第j 类样本中心的梯度更新值。

3 实验结果与分析

3.1 数据集介绍

为了验证本文提出方法的有效性,使用数据集NWPU-RESISC45进行实验。该数据集是由西北工业大学创建的遥感图像场景分类的一个公开的可用基准。来自100多个国家和地区,在2017年公布使用。该数据集一共包含31 500幅遥感影像,45类遥感场景,每个类别为700幅尺寸大小为256像素×256像素的影像,此数据集在平移、光照、遮挡、背景、分辨率方面都有着很大的变化,并且有着较高的类内多样性和类间相似性,该数据集对于本文提出的方法有较高的挑战性。

如图2 所示为该数据集的部分遥感影像,图2 (a)-(d)为同一类遥感影像的对比图,图2 (e)-(h)为不同类别遥感影像对比图,从中可以看出同类场景之间的光照、角度、颜色、轮廓有着较大的差异,不同类别场景之间的色彩、背景、光照、形状以及轮廓有着很大的相似性。

图2

图2

NWPU-RESISC45数据集示例

Fig.2

Sample dataset of NWPU-RESISC45

本文采用80%的数据作为训练样本,20%的数据作为测试样本,并且数据集未通过旋转、翻转、缩放、裁剪等手段进行数据增强。

3.2 实验结果与分析

为了比较不同损失函数在不同模型中遥感特征的收敛情况,本文设置了两组实验进行验证,分别使用VGG16网络模型和ResNet50网络模型来验证本文提出方法的有效性,其中训练次数设置为100,训练批次设置为32,调节因子λ 设置为0.000 1,β 0 β 1

如图3 (a)和图3 (b)所示为2个不同的网络模型在不同损失函数中的训练效果对比图。通过对比可以看出中心损失函数在2个基线模型的基础上提升均有限,效果不明显,本文提出的聚类损失函数在基线模型的基础上均有较高的提升,而标签聚类损失更是进一步提升了模型的特征提取能力,并且增加了模型的稳定性,本文提出的方法在残差网络模型中提升效果更佳。

图3

图3

不同损失函数训练步骤图

Fig.3

Training step diagram of different loss function

针对标签聚类损失函数的两个超参数β 0 β 1 β 0 β 1 β 1 β 0 图4 (a)和图4 (b)所示为不同网络模型的超参数搜索图,其中VGG16网络模型在β 0 β 1 β 0 β 1 =0.1处取得最优值。

图4

图4

不同网络模型超参数搜索图

Fig.4

Hyperparametric search graph for different network models

为了更好地对比标签聚类损失函数与其他损失函数的性能,本文分别记录了不同损失函数在2个网络模型中的平均准确率以及Kappa系数,对比结果如表2 所示,其中softmax_loss表示基线网络模型,center_loss表示使用中心损失训练出的网络模型,no label_loss表示使用聚类损失,即不使用类标签中心初始化条件下训练出的网络模型,label_loss表示使用本文提出的标签聚类损失训练出的网络模型。从中可以看出本文提出的损失函数在2个不同的网络模型中的平均准确率和Kappa系数均有显著提升,相比softmax损失,本文方法在VGG16网络模型中平均准确率提高了2.3%,Kappa系数增加了0.017,在ResNet50网络模型中平均准确率提高了5.7%,Kappa系数增加了0.06,相比中心损失,本文方法也显示出了良好的性能,可以学到判别性更好的特征。

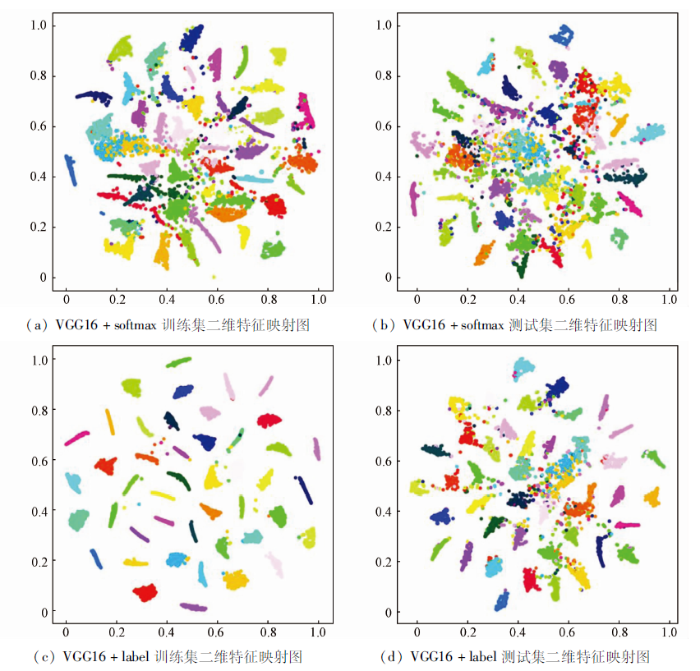

为了进一步阐释本文方法在特征空间数据的分布情况,使用TSNE算法和PCA算法对模型输出的特征进行数据降维,得到了数据特征的二维空间映射图。如图5 所示为VGG16网络模型的二维特征映射图,图5 (a)和图5 (b)分别为使用softmax损失函数在训练集和测试集上的二维特征映射图,从中可以看出softmax训练的特征,过分关注了正确类别,忽略了负样本的得分,导致特征分布较为散乱,各类特征的聚集性较差,每一个类别之间的距离较近,各类之间没有形成一定的界限。在测试集上数据分布则是更加散乱。图5 (c)和图5 (d)分别为使用标签聚类损失函数在训练集和测试集上的二维特征映射图,从中可以看出在训练集当中使用标签聚类损失后,各类别之间的特征被完全分离,表现为每一类特征向类别中心聚集,特征的聚集程度显著提升,每一类的特征中心被完全分离,各类别之间的界限更加明显,在二维空间形成了较好的数据分布。在测试集上的表现相对于softmax损失也有较大的改善。

图5

图5

VGG16网络模型使用不同损失函数二维特征映射图

Fig.5

Two dimensional feature map of VGG16 network model with different loss functions

为了更加直观有效的观察不同损失函数在网络模型中对于遥感影像不同场景的分类性能。本文绘制了各类别场景的精度对比图,如图6 (a)和图6 (b)所示分别为VGG16网络模型和ResNet50网络模型使用不同损失函数的各类别精度对比图,可以看出本文提出的标签聚类损失函数较softmax损失各类别场景的准确度均得到了不同程度的提高,尤其是ResNet50网络模型中提升效果更加显著。同时可以看出在准确率最低的第8类和第28类(教堂,宫殿)也均获得了较好的提升效果。

图6

图6

不同损失函数各类别场景准确度对比图

Fig.6

Comparison of accuracy of different loss functions and scenarios

为了评价不同算法的分类效果,将本文提出的方法与目前几种流行的方法进行比较,如表3 所示,本文方法得到了较好的分类精度。

4 结论

为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化。在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征。通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中。用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势。在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升。

参考文献

View Option

[1]

李冠东 , 张春菊 , 王铭恺 , 等 . 卷积神经网络迁移的高分影像场景分类学习

[J]. 测绘科学 , 2019 , 44 (4 ):116 -123 ,174.

[本文引用: 1]

Li G D Zhang C J Wang M K et al. High resolution remote sensing image classification learning based on convolutional neural network migration

[J]. Surveying and Mapping Science , 2019 , 44 (4 ):116 -123 ,174.

[本文引用: 1]

[2]

何小飞 , 邹峥嵘 , 陶超 , 等 . 联合显著性和多层卷积神经网络的高分影像场景分类

[J]. 测绘学报 , 2016 , 45 (9 ):1073 -1080 .

[本文引用: 1]

He X F Zou Z R Tao C et al. High resolution image scene classification based on saliency and multilayer convolutional neural network

[J]. Acta Surveying and Mapping , 2016 , 45 (9 ):1073 -1080 .

[本文引用: 1]

[3]

Liu Y Zhong Y Qin Q Scene classificationbased on multiscale convolutional neural network

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2018 , 56 (12 ):7109 -7121 .

DOI:10.1109/TGRS.2018.2848473

URL

[本文引用: 1]

[4]

Zan C Wang S X Hou et al. Recurrent transformer network for remote sensing scene categorisation

[C]. // Proceedings of the 2018 British Machine Vision Conference.Durham:BMVA , 2018 :266 .

[本文引用: 1]

[5]

Wang Q Liu S Chanussot J et al. Scene classification with recurrent attention of VHR remote sensing images

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2019 , 57 (2 ):1155 -1167 .

DOI:10.1109/TGRS.2018.2864987

URL

[本文引用: 1]

[6]

Sun H Li S Zheng X et al. Remote sensing scene classification by gated bidirectional network

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2019 (99 ):1 -15 .

[本文引用: 1]

[7]

Li Y Liu M Zhang S Classification of optical remote sensing images based on convolutional neural network

[C]// 2019 6th International Conference on Control,Decision and Information Technologies (CoDIT).IEEE , 2019 :801 -806 .

[本文引用: 1]

[8]

杨斌 , 李成华 , 江小平 , 等 . 一种用于提升深度学习分类模型准确率的正则化损失函数

[J]. 中南民族大学学报(自然科学版) , 2020 , 39 (1 ):74 -78 .

[本文引用: 1]

Yang B Li C H Jiang X P et al. A regularized loss function for improving the accuracy of deep learning classification model

[J]. Journal of Central South University for Nationalities,Natural Science Edition , 2020 , 39 (1 ):74 -78 .

[本文引用: 1]

[9]

Liu Y Huang C Scene classification via triplet networks

[J]. IEEE Journal of Selected Topics in Applied Earth Observations & Remote Sensing , 2018 , 11 (1 ):220 -237 .

[本文引用: 1]

[10]

Khatun A Denman S Sridharan S et al. Joint identification-verification for person re-identification:A four stream deep learning approach with improved quartet loss function

[J]. Computer Vision and Image Understanding , 2020 ,197 -198 :102989.

[本文引用: 1]

[11]

Shi W Gong Y Tao X et al. Fine-grained image classification using modified DCNNs trained by cascaded softmax and generalized large-margin losses

[J]. IEEE Transactions on Neural Networks and Learning Systems , 2018 , 30 (3 ):683 -694 .

DOI:10.1109/TNNLS.2018.2852721

URL

[本文引用: 1]

[12]

Reddy A C Saraschandrika A Reddy A V Study of the Clustering algorithms for hyper spectral remote sensing images

[J]. Journal of Hyperspectral Remote Sensing , 2020 , 10 (2 ):117 -121 .

DOI:10.29150/jhrs.v10.2.p117-121

URL

[本文引用: 1]

[13]

Gong C Han J Lu X Remote sensing image scene classification:Benchmark and state of the art

[J]. Proceedings of the IEEE , 2017 , 105 (10 ):1865 -1883 .

DOI:10.1109/JPROC.2017.2675998

URL

[本文引用: 4]

[14]

He N Fang L Li S et al. Remote sensing scene classification using multilayer stacked covariance pooling

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2018 ,(99 ):1 -12 .

[本文引用: 1]

[15]

杨宏炳 , 迟勇欣 , 王金光 . 基于剪枝网络的知识蒸馏对遥感卫星图像分类方法

[J/OL]. 计算机应用研究 , 2021 , 38 (8 ):2469 -2473 .

[本文引用: 1]

Yang H B Chi Y X Wang J G Remote sensing satellite image classification method based on knowledge distillation of pruning net work

[J/OL]. Computer Application Research , 2021 , 38 (8 ):2469 -2473 .

[本文引用: 1]

[16]

马欣悦 , 王梨名 , 祁昆仑 , 等 . 基于多尺度循环注意力网络的遥感影像场景分类方法

[J]. 地球科学 , 2021 , 46 (10 ):3740 -3752 .

Ma X Y Wang L M Qi K L et al. Remotesensing image scene classification method based on multi-scale cyclic attention network

[J]. Earth Science , 2021 , 46 (10 ):3740 -3752 .

[17]

Zhou Z Zheng Y Ye H et al. Satellite image scene classification via ConvNet with context aggregation

[J]. PCM , 2018 (2 ):329 -339 .

[本文引用: 1]

[18]

业巧林 , 许平 , 张冬 . 基于深度学习特征和支持向量机的遥感图像分类

[J]. 林业工程学报 , 2019 , 4 (2 ):125 -131 .

[本文引用: 1]

Ye Q L Xu X P Zhang D Remote sensing image classification based on deep learning feature and support vector machine

[J]. Journal of Forestry Engineering , 2019 , 4 (2 ):125 -131 .

[本文引用: 1]

[19]

Wang J Liu W Ma L et al. IORN:An effective remote sensing image scene classification framework

[J]. IEEE Geoscience and Remote Sensing Letters , 2018 , 15 (11 ):1695 -1699 .

DOI:10.1109/LGRS.2018.2859024

URL

[本文引用: 1]

卷积神经网络迁移的高分影像场景分类学习

1

2019

... 随着遥感技术的发展,我国在提高遥感影像分辨率方面有了重大突破,通过高分系列卫星采集的遥感影像分辨率已经达到了米级甚至是亚米级[1 ] .与中分辨率和低分辨率的遥感影像相比较,高分辨率遥感影像中包含了更加丰富和详尽的细节信息.可以准确地反映出地表类型以及空间布局,但是由于地表建筑的空间分布和几何结构相当繁杂,导致同谱异物和同物异谱的现象愈加严重,为高分遥感影像的分类带来了巨大的挑战[2 ] . ...

卷积神经网络迁移的高分影像场景分类学习

1

2019

... 随着遥感技术的发展,我国在提高遥感影像分辨率方面有了重大突破,通过高分系列卫星采集的遥感影像分辨率已经达到了米级甚至是亚米级[1 ] .与中分辨率和低分辨率的遥感影像相比较,高分辨率遥感影像中包含了更加丰富和详尽的细节信息.可以准确地反映出地表类型以及空间布局,但是由于地表建筑的空间分布和几何结构相当繁杂,导致同谱异物和同物异谱的现象愈加严重,为高分遥感影像的分类带来了巨大的挑战[2 ] . ...

联合显著性和多层卷积神经网络的高分影像场景分类

1

2016

... 随着遥感技术的发展,我国在提高遥感影像分辨率方面有了重大突破,通过高分系列卫星采集的遥感影像分辨率已经达到了米级甚至是亚米级[1 ] .与中分辨率和低分辨率的遥感影像相比较,高分辨率遥感影像中包含了更加丰富和详尽的细节信息.可以准确地反映出地表类型以及空间布局,但是由于地表建筑的空间分布和几何结构相当繁杂,导致同谱异物和同物异谱的现象愈加严重,为高分遥感影像的分类带来了巨大的挑战[2 ] . ...

联合显著性和多层卷积神经网络的高分影像场景分类

1

2016

... 随着遥感技术的发展,我国在提高遥感影像分辨率方面有了重大突破,通过高分系列卫星采集的遥感影像分辨率已经达到了米级甚至是亚米级[1 ] .与中分辨率和低分辨率的遥感影像相比较,高分辨率遥感影像中包含了更加丰富和详尽的细节信息.可以准确地反映出地表类型以及空间布局,但是由于地表建筑的空间分布和几何结构相当繁杂,导致同谱异物和同物异谱的现象愈加严重,为高分遥感影像的分类带来了巨大的挑战[2 ] . ...

Scene classificationbased on multiscale convolutional neural network

1

2018

... 随着深度学习技术的发展,神经网络被广泛应用于图像处理领域,特别是卷积神经网络在遥感领域表现突出.如Liu等[3 ] 采用了多尺度的卷积结构,利用两个不同尺度的卷积结构分别提取不同的特征表示,学习到的特征具有尺度不变性,实现了对遥感数据的分类.Zan等[4 ] 提出了循环变换网络,能够学习到局部区域的特征表示,提取遥感影像的关键信息用于分类.Wang等[5 ] 提出了一种递归注意网络模型,能够捕捉遥感影像的关键区域的特征进行场景信息的理解.Sun等[6 ] 提出了一种双向门控网络结构,能够对不同分层的特征进行聚合以及消除干扰信息,去除冗余特征,增强了模型对于遥感影像潜在语义信息的理解.这些方法都是通过对网络结构进行优化用以提升其对于遥感特征的拟合能力,对于遥感影像中存在的纹理,形状,颜色的差别,以及拍摄的角度和高度问题没有进行针对性的训练,导致了网络模型的泛化能力不足. ...

Recurrent transformer network for remote sensing scene categorisation

1

2018

... 随着深度学习技术的发展,神经网络被广泛应用于图像处理领域,特别是卷积神经网络在遥感领域表现突出.如Liu等[3 ] 采用了多尺度的卷积结构,利用两个不同尺度的卷积结构分别提取不同的特征表示,学习到的特征具有尺度不变性,实现了对遥感数据的分类.Zan等[4 ] 提出了循环变换网络,能够学习到局部区域的特征表示,提取遥感影像的关键信息用于分类.Wang等[5 ] 提出了一种递归注意网络模型,能够捕捉遥感影像的关键区域的特征进行场景信息的理解.Sun等[6 ] 提出了一种双向门控网络结构,能够对不同分层的特征进行聚合以及消除干扰信息,去除冗余特征,增强了模型对于遥感影像潜在语义信息的理解.这些方法都是通过对网络结构进行优化用以提升其对于遥感特征的拟合能力,对于遥感影像中存在的纹理,形状,颜色的差别,以及拍摄的角度和高度问题没有进行针对性的训练,导致了网络模型的泛化能力不足. ...

Scene classification with recurrent attention of VHR remote sensing images

1

2019

... 随着深度学习技术的发展,神经网络被广泛应用于图像处理领域,特别是卷积神经网络在遥感领域表现突出.如Liu等[3 ] 采用了多尺度的卷积结构,利用两个不同尺度的卷积结构分别提取不同的特征表示,学习到的特征具有尺度不变性,实现了对遥感数据的分类.Zan等[4 ] 提出了循环变换网络,能够学习到局部区域的特征表示,提取遥感影像的关键信息用于分类.Wang等[5 ] 提出了一种递归注意网络模型,能够捕捉遥感影像的关键区域的特征进行场景信息的理解.Sun等[6 ] 提出了一种双向门控网络结构,能够对不同分层的特征进行聚合以及消除干扰信息,去除冗余特征,增强了模型对于遥感影像潜在语义信息的理解.这些方法都是通过对网络结构进行优化用以提升其对于遥感特征的拟合能力,对于遥感影像中存在的纹理,形状,颜色的差别,以及拍摄的角度和高度问题没有进行针对性的训练,导致了网络模型的泛化能力不足. ...

Remote sensing scene classification by gated bidirectional network

1

2019

... 随着深度学习技术的发展,神经网络被广泛应用于图像处理领域,特别是卷积神经网络在遥感领域表现突出.如Liu等[3 ] 采用了多尺度的卷积结构,利用两个不同尺度的卷积结构分别提取不同的特征表示,学习到的特征具有尺度不变性,实现了对遥感数据的分类.Zan等[4 ] 提出了循环变换网络,能够学习到局部区域的特征表示,提取遥感影像的关键信息用于分类.Wang等[5 ] 提出了一种递归注意网络模型,能够捕捉遥感影像的关键区域的特征进行场景信息的理解.Sun等[6 ] 提出了一种双向门控网络结构,能够对不同分层的特征进行聚合以及消除干扰信息,去除冗余特征,增强了模型对于遥感影像潜在语义信息的理解.这些方法都是通过对网络结构进行优化用以提升其对于遥感特征的拟合能力,对于遥感影像中存在的纹理,形状,颜色的差别,以及拍摄的角度和高度问题没有进行针对性的训练,导致了网络模型的泛化能力不足. ...

Classification of optical remote sensing images based on convolutional neural network

1

2019

... 当前的网络模型大多使用Softmax[7 ] 损失来衡量真实概率分布与模型预测概率分布之间的差异,使用模型预测概率分布表示真实概率分布的困难程度.该损失函数的值越大,说明该模型在真实标签的分类概率越小,性能也越差.由于Softmax损失仅仅惩罚整体分类的损失,忽略了遥感影像的类内差异性以及类间相似性,导致模型泛化能力不足,为了实现遥感影像的特征可分,Center损失[8 ] 、三元组损失[9 ] 、对比度损失[10 ] 以及L-Softmax损失[11 ] 等被先后提出.Center损失使用欧氏距离来衡量同类特征之间的距离,结合Softmax损失函数来进行网络结构的优化,忽略了遥感影像不同类别特征重叠的问题,导致模型训练效果一般.三元组损失和对比度损失需要构建遥感图像的三元组和图像对作为训练样本度量同类和异类之间的特征距离.用以提升模型对于各类特征的分类性能,但是由于训练样本的急剧增加,模型收敛变得缓慢和不稳定,增加了模型计算的复杂性并且使训练过程变得繁琐.L-Softmax损失是一种大间隔学习方法,引入了余弦余量项,最大化特征空间中的决策边缘.但是由于决策边缘的固定性,对所有特征进行相同程度的惩罚,无法进行针对性学习,并且类别之间间隔越大,相应类别的区域流形就越小,从而导致训练困难的问题. ...

一种用于提升深度学习分类模型准确率的正则化损失函数

1

2020

... 当前的网络模型大多使用Softmax[7 ] 损失来衡量真实概率分布与模型预测概率分布之间的差异,使用模型预测概率分布表示真实概率分布的困难程度.该损失函数的值越大,说明该模型在真实标签的分类概率越小,性能也越差.由于Softmax损失仅仅惩罚整体分类的损失,忽略了遥感影像的类内差异性以及类间相似性,导致模型泛化能力不足,为了实现遥感影像的特征可分,Center损失[8 ] 、三元组损失[9 ] 、对比度损失[10 ] 以及L-Softmax损失[11 ] 等被先后提出.Center损失使用欧氏距离来衡量同类特征之间的距离,结合Softmax损失函数来进行网络结构的优化,忽略了遥感影像不同类别特征重叠的问题,导致模型训练效果一般.三元组损失和对比度损失需要构建遥感图像的三元组和图像对作为训练样本度量同类和异类之间的特征距离.用以提升模型对于各类特征的分类性能,但是由于训练样本的急剧增加,模型收敛变得缓慢和不稳定,增加了模型计算的复杂性并且使训练过程变得繁琐.L-Softmax损失是一种大间隔学习方法,引入了余弦余量项,最大化特征空间中的决策边缘.但是由于决策边缘的固定性,对所有特征进行相同程度的惩罚,无法进行针对性学习,并且类别之间间隔越大,相应类别的区域流形就越小,从而导致训练困难的问题. ...

一种用于提升深度学习分类模型准确率的正则化损失函数

1

2020

... 当前的网络模型大多使用Softmax[7 ] 损失来衡量真实概率分布与模型预测概率分布之间的差异,使用模型预测概率分布表示真实概率分布的困难程度.该损失函数的值越大,说明该模型在真实标签的分类概率越小,性能也越差.由于Softmax损失仅仅惩罚整体分类的损失,忽略了遥感影像的类内差异性以及类间相似性,导致模型泛化能力不足,为了实现遥感影像的特征可分,Center损失[8 ] 、三元组损失[9 ] 、对比度损失[10 ] 以及L-Softmax损失[11 ] 等被先后提出.Center损失使用欧氏距离来衡量同类特征之间的距离,结合Softmax损失函数来进行网络结构的优化,忽略了遥感影像不同类别特征重叠的问题,导致模型训练效果一般.三元组损失和对比度损失需要构建遥感图像的三元组和图像对作为训练样本度量同类和异类之间的特征距离.用以提升模型对于各类特征的分类性能,但是由于训练样本的急剧增加,模型收敛变得缓慢和不稳定,增加了模型计算的复杂性并且使训练过程变得繁琐.L-Softmax损失是一种大间隔学习方法,引入了余弦余量项,最大化特征空间中的决策边缘.但是由于决策边缘的固定性,对所有特征进行相同程度的惩罚,无法进行针对性学习,并且类别之间间隔越大,相应类别的区域流形就越小,从而导致训练困难的问题. ...

Scene classification via triplet networks

1

2018

... 当前的网络模型大多使用Softmax[7 ] 损失来衡量真实概率分布与模型预测概率分布之间的差异,使用模型预测概率分布表示真实概率分布的困难程度.该损失函数的值越大,说明该模型在真实标签的分类概率越小,性能也越差.由于Softmax损失仅仅惩罚整体分类的损失,忽略了遥感影像的类内差异性以及类间相似性,导致模型泛化能力不足,为了实现遥感影像的特征可分,Center损失[8 ] 、三元组损失[9 ] 、对比度损失[10 ] 以及L-Softmax损失[11 ] 等被先后提出.Center损失使用欧氏距离来衡量同类特征之间的距离,结合Softmax损失函数来进行网络结构的优化,忽略了遥感影像不同类别特征重叠的问题,导致模型训练效果一般.三元组损失和对比度损失需要构建遥感图像的三元组和图像对作为训练样本度量同类和异类之间的特征距离.用以提升模型对于各类特征的分类性能,但是由于训练样本的急剧增加,模型收敛变得缓慢和不稳定,增加了模型计算的复杂性并且使训练过程变得繁琐.L-Softmax损失是一种大间隔学习方法,引入了余弦余量项,最大化特征空间中的决策边缘.但是由于决策边缘的固定性,对所有特征进行相同程度的惩罚,无法进行针对性学习,并且类别之间间隔越大,相应类别的区域流形就越小,从而导致训练困难的问题. ...

Joint identification-verification for person re-identification:A four stream deep learning approach with improved quartet loss function

1

2020

... 当前的网络模型大多使用Softmax[7 ] 损失来衡量真实概率分布与模型预测概率分布之间的差异,使用模型预测概率分布表示真实概率分布的困难程度.该损失函数的值越大,说明该模型在真实标签的分类概率越小,性能也越差.由于Softmax损失仅仅惩罚整体分类的损失,忽略了遥感影像的类内差异性以及类间相似性,导致模型泛化能力不足,为了实现遥感影像的特征可分,Center损失[8 ] 、三元组损失[9 ] 、对比度损失[10 ] 以及L-Softmax损失[11 ] 等被先后提出.Center损失使用欧氏距离来衡量同类特征之间的距离,结合Softmax损失函数来进行网络结构的优化,忽略了遥感影像不同类别特征重叠的问题,导致模型训练效果一般.三元组损失和对比度损失需要构建遥感图像的三元组和图像对作为训练样本度量同类和异类之间的特征距离.用以提升模型对于各类特征的分类性能,但是由于训练样本的急剧增加,模型收敛变得缓慢和不稳定,增加了模型计算的复杂性并且使训练过程变得繁琐.L-Softmax损失是一种大间隔学习方法,引入了余弦余量项,最大化特征空间中的决策边缘.但是由于决策边缘的固定性,对所有特征进行相同程度的惩罚,无法进行针对性学习,并且类别之间间隔越大,相应类别的区域流形就越小,从而导致训练困难的问题. ...

Fine-grained image classification using modified DCNNs trained by cascaded softmax and generalized large-margin losses

1

2018

... 当前的网络模型大多使用Softmax[7 ] 损失来衡量真实概率分布与模型预测概率分布之间的差异,使用模型预测概率分布表示真实概率分布的困难程度.该损失函数的值越大,说明该模型在真实标签的分类概率越小,性能也越差.由于Softmax损失仅仅惩罚整体分类的损失,忽略了遥感影像的类内差异性以及类间相似性,导致模型泛化能力不足,为了实现遥感影像的特征可分,Center损失[8 ] 、三元组损失[9 ] 、对比度损失[10 ] 以及L-Softmax损失[11 ] 等被先后提出.Center损失使用欧氏距离来衡量同类特征之间的距离,结合Softmax损失函数来进行网络结构的优化,忽略了遥感影像不同类别特征重叠的问题,导致模型训练效果一般.三元组损失和对比度损失需要构建遥感图像的三元组和图像对作为训练样本度量同类和异类之间的特征距离.用以提升模型对于各类特征的分类性能,但是由于训练样本的急剧增加,模型收敛变得缓慢和不稳定,增加了模型计算的复杂性并且使训练过程变得繁琐.L-Softmax损失是一种大间隔学习方法,引入了余弦余量项,最大化特征空间中的决策边缘.但是由于决策边缘的固定性,对所有特征进行相同程度的惩罚,无法进行针对性学习,并且类别之间间隔越大,相应类别的区域流形就越小,从而导致训练困难的问题. ...

Study of the Clustering algorithms for hyper spectral remote sensing images

1

2020

... 借鉴聚类算法[12 ] 中的思想,聚类中心的选取影响着聚类效果的好坏.本文模拟理想条件下的类别中心以及数据的分布情况,提出了一种类标签中心初始化方法来代替随机初始化.首先将网络模型最后一层全连接层提取的特征进行归一化处理,之后将每一类场景的类别标签进行独热编码,使每一个类别的标签数据生成一组二值向量,类别标签中对应的类别数目取值为1,其余的取值为0,然后进行数据平滑.能够降低正确标签的自信度,提高错误标签的关注度,也就是对模型的分类准确度进行一定的惩罚.不再只针对正确标签进行训练,也对错误标签进行惩罚训练,使网络模型在初始阶段就学到一个较优的类别中心,可以有效的降低网络模型训练的复杂度以及提高模型的泛化能力.类标签中心初始化表示为: ...

Remote sensing image scene classification:Benchmark and state of the art

4

2017

... Classification accuracy of different methods

Tab.3 方法 准确率/% Fine-tuned AlexNet[13 ] 81.22 AlexNet+MSCP[14 ] 81.70 ResNet18[15 ] 81.10 ResNet50 82.90 Fine-tuned GoogleNet[13 ] 82.57 VGG-VD16+MSCP[13 ] 85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20

4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

... [

13 ]

82.57 VGG-VD16+MSCP[13 ] 85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20 4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

... [

13 ]

85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20 4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

... [

13 ]

87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20 4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

Remote sensing scene classification using multilayer stacked covariance pooling

1

2018

... Classification accuracy of different methods

Tab.3 方法 准确率/% Fine-tuned AlexNet[13 ] 81.22 AlexNet+MSCP[14 ] 81.70 ResNet18[15 ] 81.10 ResNet50 82.90 Fine-tuned GoogleNet[13 ] 82.57 VGG-VD16+MSCP[13 ] 85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20

4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

基于剪枝网络的知识蒸馏对遥感卫星图像分类方法

1

2021

... Classification accuracy of different methods

Tab.3 方法 准确率/% Fine-tuned AlexNet[13 ] 81.22 AlexNet+MSCP[14 ] 81.70 ResNet18[15 ] 81.10 ResNet50 82.90 Fine-tuned GoogleNet[13 ] 82.57 VGG-VD16+MSCP[13 ] 85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20

4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

基于剪枝网络的知识蒸馏对遥感卫星图像分类方法

1

2021

... Classification accuracy of different methods

Tab.3 方法 准确率/% Fine-tuned AlexNet[13 ] 81.22 AlexNet+MSCP[14 ] 81.70 ResNet18[15 ] 81.10 ResNet50 82.90 Fine-tuned GoogleNet[13 ] 82.57 VGG-VD16+MSCP[13 ] 85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20

4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

基于多尺度循环注意力网络的遥感影像场景分类方法

0

2021

基于多尺度循环注意力网络的遥感影像场景分类方法

0

2021

Satellite image scene classification via ConvNet with context aggregation

1

2018

... Classification accuracy of different methods

Tab.3 方法 准确率/% Fine-tuned AlexNet[13 ] 81.22 AlexNet+MSCP[14 ] 81.70 ResNet18[15 ] 81.10 ResNet50 82.90 Fine-tuned GoogleNet[13 ] 82.57 VGG-VD16+MSCP[13 ] 85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20

4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

基于深度学习特征和支持向量机的遥感图像分类

1

2019

... Classification accuracy of different methods

Tab.3 方法 准确率/% Fine-tuned AlexNet[13 ] 81.22 AlexNet+MSCP[14 ] 81.70 ResNet18[15 ] 81.10 ResNet50 82.90 Fine-tuned GoogleNet[13 ] 82.57 VGG-VD16+MSCP[13 ] 85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20

4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

基于深度学习特征和支持向量机的遥感图像分类

1

2019

... Classification accuracy of different methods

Tab.3 方法 准确率/% Fine-tuned AlexNet[13 ] 81.22 AlexNet+MSCP[14 ] 81.70 ResNet18[15 ] 81.10 ResNet50 82.90 Fine-tuned GoogleNet[13 ] 82.57 VGG-VD16+MSCP[13 ] 85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20

4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...

IORN:An effective remote sensing image scene classification framework

1

2018

... Classification accuracy of different methods

Tab.3 方法 准确率/% Fine-tuned AlexNet[13 ] 81.22 AlexNet+MSCP[14 ] 81.70 ResNet18[15 ] 81.10 ResNet50 82.90 Fine-tuned GoogleNet[13 ] 82.57 VGG-VD16+MSCP[13 ] 85.33 Fine-tuned VGGNet-16[13 ] 87.15 ResNetP18[17 ] 89.13 AlexNet+SVM[18 ] 90.50 IORN4-VGG16[19 ] 91.30 文献[16] 91.18 文献[15] 91.97 本文方法 92.20

4 结论 为了解决高分遥感影像同类别场景差异性较大、不同类别场景相似性较大的问题,本文提出了一种标签聚类损失,使用欧氏距离和余弦距离共同度量类内特征和类间中心的绝对距离与角度变化.在两个不同的网络模型中进行了优化训练,使学习到特征向每一类的中心进行聚集,并且每一个类别中心之间都被区分开来,达到了最小化类内距离、最大化类间距离的效果,学习到了拥有较强区分度的遥感场景特征.通过实验结果表明本文提出的方法在不增加训练时间、模型规模以及训练样本的同时,可以直接用于不同的网络模型中.用以提升基准模型的准确率,并且支持端到端的训练模式,不需要任何复杂的处理流程,在遥感影像分类任务中具有较大的优势.在之后的研究中将进一步进行损失函数的改进,减少人工的干预以及改进超参数调优的方法,使其更好地指导神经网络模型的训练,能够使遥感影像分类的准确率能够得到进一步的提升. ...