0 引言

遥感图像的精准分类是遥感内容分析的重要技术支撑,随着遥感图像分辨率的提高,其所包含的几何、纹理、结构,以及内容场景信息,使得遥感图像类内距离变大,类间距离变小,检索和分类任务面对更大的挑战。近年来,随着深度学习技术和硬件环境的发展,卷积神经网络 (convolutional neural network,CNN)广泛应用于图像的检索和分类任务,网络深度也由最初AlextNet[1]的8层逐步发展到Resnet[2]的最多152层,DenseNet[3]的最多264层,深度学习的网络结构在不断优化,网络学习能力不断增强。虽然遥感图像承载的信息与普通自然图像不同,但是二者的特征分布具有高度的相似性[4],大量实验证明自然图像所训练的CNN在遥感图像处理领域同样具有良好的效果。经过训练的网络各层对原始遥感图像的激活响应,具有优秀的特征表达能力[5],其中通过对卷积层和全连接层特征的编码与池化,可以进一步提升高层语义表征能力,这种深度学习特征正逐渐取代传统的描述算子[6]。

深度学习方法在遥感图像分类中的应用大致可以分为以下3种:

1)深度神经网络的迁移学习。主要思想是利用预训练和微调的CNN模型迁移至遥感数据集中进行分类。由于预训练模型已经在大规模图像数据集进行了训练,各参数具备了很好的适应性,通过修改CNN模型全连接层节点数并进行参数微调,一般都可以实现较好的识别效果。

2)深度特征的编码融合。该类算法将CNN作为特征提取器,以网络某一全连接层或卷积层的输出响应作为特征向量,直接输入或编码后输入分类器。按照实现过程,可以分为特征提取和特征编码两个部分。Hu等[7]在不同尺度上提取预训练网络的卷积层特征,多个特征连接并编码形成最终图像特征; Cheng等[8]将深度学习特征与词袋模型(bag of words,BOW),Fisher向量(Fisher vector,FV),局部聚合描述符向量(vector of locally aggregated descriptors,VLAD)等编码方法相融合; 王鑫等[9]训练核函数将全连接层特征映射到高维空间,形成最终分类特征; Wang等[4]将不同的深度学习网络卷积层进行VLAD编码降维后,与全连接层特征组成遥感图像特征; He等[10]使用预训练CNN模型将多个卷积层特征集成,计算这些叠加特征的协方差矩阵池化特征; Cheng等[11]通过优化新的目标函数,引入度量学习正则化项,构成D-CNN网络模型,提高针对于遥感图像类内多样性和类间相似性的识别精度; 刘异等[12]将Fisher编码和CaffeNet全连接层特征结合到一起形成新的特征向量。

与传统特征描述方法相比,上述深度学习方法优势明显,但也存在一些问题,比如迁移学习模型经过相当长的迭代后,分类精度基本保持稳定,瓶颈效应凸显,提升空间有限。深度特征的编码和多方法集成,学习过程相对复杂,特征存储和计算代价偏高。为此,本文将哈希算法引入密集网络结构,将密集网络输出的高层语义特征映射为二进制的特征表达,构建适应遥感图像的分类模型。

1 密集网络的特征提取分析

DenseNet是2017年的最优深度模型,在Resnet基础上提出的密集连接模式,主要由密集块和过渡层组成。密集块中每一个上层网络节点输出不仅顺序传递至相连接的下游层节点,同时也传递至所有非直接连接的下游节点,这些跨节点的输入与上层连接点的输出串联形成新的输入特征,这样使得任一层的输入包含上游所有结点信息,各层特征得到充分复用,具体可以表示为:

式中:

过渡层主要包括卷积和池化2部分。各密集块间的连接对于特征输入尺寸要求不同,过渡层的主要作用就是对上游密集块输出特征的降维池化,在对特征进一步融合的同时保证有效输入下游密集块。DenseNet中各层和块的连接设计,使得各部分特征有效融合,极大程度保留图像的高层语义特征。

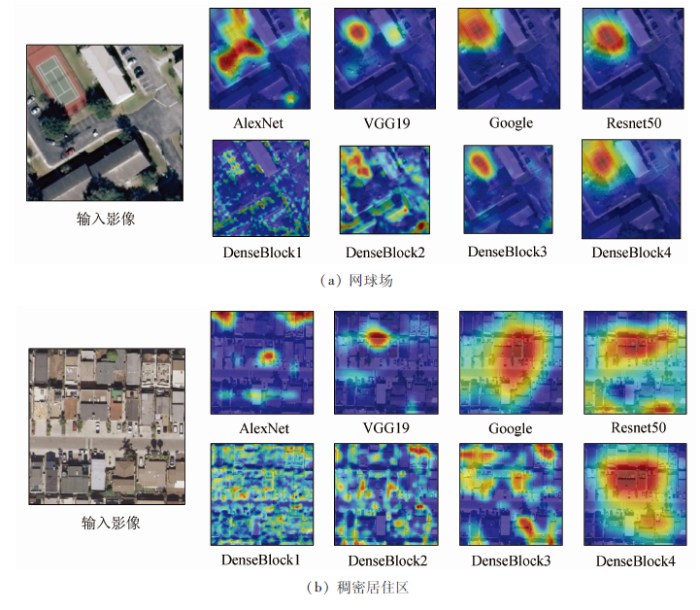

为了直观感受各块特征输出,利用梯度加权激活方法将特征输出可视化[16],同时与其他主流网络中的最后卷积层特征进行对比。图1以网球场(图1(a))和稠密居住区(图1(b))2幅遥感图像作为输入,其中网球场影像直观上容易识别并定位,稠密居住区影像内容复杂,容易引起类别混淆。图中红色代表对类别判断起主要贡献部分,DenseBlock1— DenseBlock 4分别代表了DenseNet第1—4密集块的特征输出,可以看出,随着特征在不同密集块中的递进传输,输出特征对于类别判断的焦点逐渐集中在图像核心要素内。对于易于区分的网球场图像,各类特征都能集中在所属类别的主要标的物。对于判断难度较大的稠密居住区图像,AlexNet和VGG19卷积层输出的判断重点对类间区分贡献不明显,Google特征在关注居住区的同时也将图中的道路纳入其中,容易引起类别的混淆。Resnet50同样具有不错的高层语义表征能力。

图1

2 密集特征的哈希表示

图像的紧凑哈希表示能够有效减少后续检索和分类的计算成本,其核心思想是将图像从原始高维空间映射为低维汉明空间的二进制编码。自深度学习与哈希算法首次结合以来,众多改进的深度哈希算法在图像检索领域获得广泛应用,其中Lin等[17]采用激活函数将AlexNet全连接层特征映射为哈希编码,方法简单且效果良好。但遥感影像除了具有传统图像特征之外,还具有丰富空间、纹理等语义信息,因此在有限的二进制编码中表现出不同遥感图像深层次的语义信息是关键,为此,本文通过提取DenseNet高层语义特征的输出,根据哈希码长设置全连接层结点,对DenseBlock4的输出降维,之后利用sigmoid函数将密集特征映射为归一化的特征向量,通过目标数据集的训练调参,形成最终遥感场景分类的哈希特征生成网络。测试数据在网络末端激活函数的归一化输出,经二值化即为图像哈希特征。最后使用支持向量机分类。框架如图2所示。

图2

3 实验

3.1 实验数据集

为了验证本文方法的有效性,实验在3个通用的遥感数据集上进行测试分析。第一个数据集为 UC Merced Land Use Dataset(UCM),每张图像大小为 256像素× 256像素,21类不同的遥感场景,每一类100张,共计2 100张。第二个数据集为 WHU-RS19 Data Set(WHU),每个图像尺寸为600像素× 600像素,整个数据集包含19类场景,每一类约为50张,总共1 005张。第三个数据集是NWPU-RESISC45(NWPU)数据集,每个图像尺寸为256像素×256像素,包含飞机、机场、棒球场等45个场景类别,每个场景类别包含700幅,图像,共31 500幅遥感图像,场景类别丰富,类内多样性和类间相似性较高,对遥感图像场景分类方法具有更高的挑战性。实验过程中,UCM和NWPU数据集每类场景分别随机选取50% 的图像作为训练数据,剩余50%图像作为测试数据,WHU数据集中由于每个类别样本数量不同,每类选择25幅图像作为训练数据,25幅图像作为测试数据。

针对于上述讨论,本文算法(DenseHash)分别与BOW,VLAD等传统特征,AlexNet,VGG19,Resnet等主流CNN模型的迁移学习和深度特征编码等方法进行对比试验。UCM和WHU数据集上各算法随机运行10次,深度学习方法训练周期设置为20,NWPU数据集规模较大,各算法随机运行5次,深度学习方法训练周期设置为5,学习率统一为0.000 3,验证频率设置为10。试验硬件环境为: Xeon(R) CPU Gold-6128,GPU QUADRO P5000; 软件环境为MATLAB 2019a。实验中,数据集中所有样本均未进行数据增强。采用平均分类精度、混淆矩阵评价分类性能。分类精度Poverall的定义为:

式中: N为总体样本数; Z为所有分类正确的样本数。

3.2 实验结果与分析

3.2.1 不同映射结点数对于精确度的影响分析

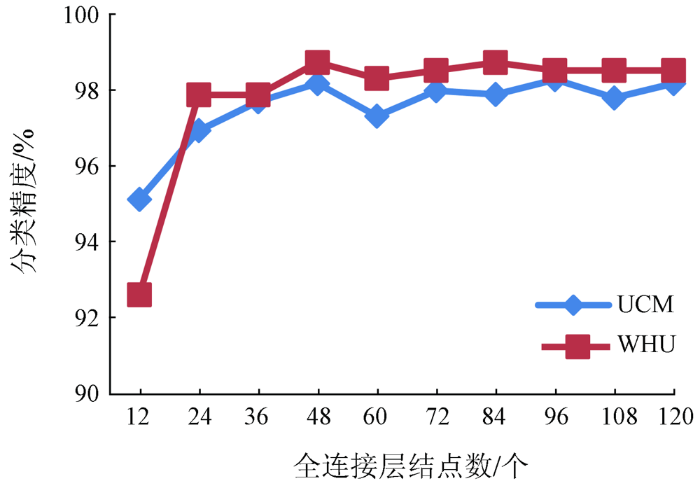

全连接层结点的作用是析取密集特征,实现重要特征的低维度表示。结点数量决定特征载体的容量,如何用有限的单元实现遥感图像特征的高层语义表示尤为重要。图3显示了不同结点数对于分类精度的影响,结点数量增加之初,分类精度有着不同程度的提高,当结点数达到48时分类精度基本稳定,继续增加结点数量对于分类效果的整体提升不明显,且在结点数为60时还有下降趋势。因此在接下来的实验中,我们将全连接层结点数设置为48。

图3

3.2.2 传统特征描述子对比

实验过程中,对比算法特征点的提取采用尺度不变特征变换(scale-invariant feature transform,SIFT)算子,BOW的词典大小为200,VLAD词典大小64位。表1是传统局部特征描述算法结果,本文算法优势明显,即便与局部特征描述的改进算法DRFV相比,在3个数据集上的表现也是大幅领先,而这种优势在大数据集NWPU中体现的更为明显。说明密集网络的特征映射,能够有效代表遥感图像高层语义,即便是大规模数据集中也能做出很好的类别区分。

表1 与传统特征描述子分类精度对比

Tab.1

3.2.3 主流CNN模型的迁移学习对比

应用当前主流CNN模型进行迁移学习,将最后的全连接层输出替换为目标数据集类别数量的结点,并在目标数据集中重新调整参数。对比结果如表2所示。可以看出,这些在ImageNet数据集中训练的CNN模型在不改变网络结构的情况下,经过目标数据集的参数精调后,与前面的传统描述算子相比,分类效果大幅提升,说明这些预训练模型的网络结构在不同类型的图像上具有普遍适应性。表2中CNN按照其提出的时间顺序由上至下做了排序,各数据集的整体分类精度也基本上按照时间顺序逐渐提升,说明随着深度学习网络结构的不断改进,学习能力逐渐增强,其中DenseNet的迁移学习效果最好。本文算法基于DenseNet,但是通过对其网络结构的适当改进,各数据集上的分类精度再次得到了一定程度的提升。

表2 与迁移学习算法对比

Tab.2

3.2.4 深度特征编码方法对比

表3 不同CNN模型的特征编码

Tab.3

| 深度特征 | 迁移学习 | Bilinear | BOVW | VLAD | FV | 编码方法平均精度 |

|---|---|---|---|---|---|---|

| AlexNet | 89.80 | 80.40 | 89.50 | 90.30 | 92.50 | 88.18 |

| VGG19 | 92.00 | 90.70 | 92.60 | 93.30 | 93.40 | 92.50 |

| 92.50 | 90.30 | 84.00 | 89.50 | 87.70 | 87.88 | |

| Resnet50 | 95.50 | 93.30 | 90.00 | 89.90 | 90.40 | 90.90 |

| DenseNet | 96.70 | |||||

| DenseBlock1 | 54.10 | 78.86 | 84.57 | 87.81 | 76.34 | |

| DenseBlock2 | 71.62 | 85.24 | 87.14 | 92.38 | 84.10 | |

| DenseBlock3 | 90.76 | 91.90 | 92.76 | 95.05 | 92.62 | |

| DenseBlock4 | 95.24 | 93.90 | 92.29 | 93.14 | 93.64 | |

| 本文算法 | 98.21 |

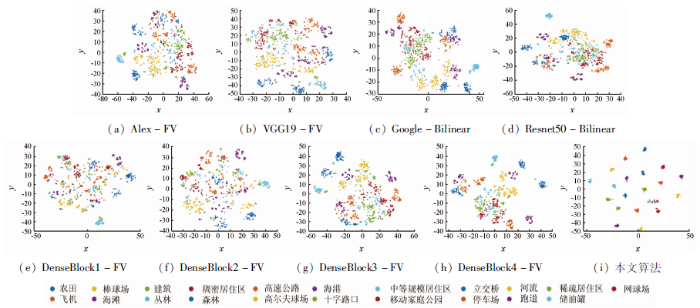

从编码方法的角度来看,相同的深度特征,FV和Bilinear的编码效果相对优于其他方法,但是Bilinear在低层次的密集块特征表现欠佳。对于AlexNet和VGG19的卷积层特征,FV的特征编码是最优的,超过了这两个网络的迁移学习精度。对于Google和Resnet50的卷积特征,Bilinear编码效果较好,但是仍低于相应网络迁移学习的分类精度。对于DenseNet的密集块特征,密集块的依次递进,是一个不断精细化特征的过程。在DenseBlock3特征输出的各类编码,分类精度均已经达到90%以上,而FV编码使该层特征表现最优。从深度特征选择的角度来看,DenseNet的DenseBlock3和DenseBlock4特征和VGG19的卷积层特征平均编码精度较高,能够很好地适应不同的编码方法。图4将不同卷积特征的最优编码,降维映射至二维空间形成散点图。相比于其他算法,本文算法的特征在同类遥感场景内聚性强,不同类别间可区分性好。

图4

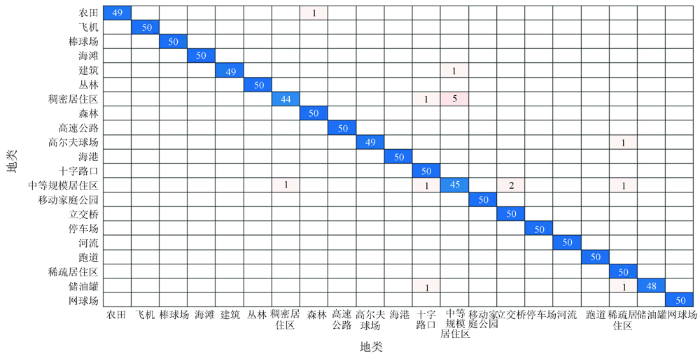

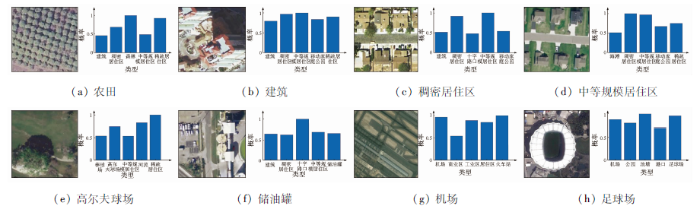

3.2.5 混淆分析

混淆矩阵用于定量评估各类之间的混淆程度,矩阵的行和列分别代表真实和预测场景,矩阵中任意元素xij代表将第i种场景预测为第j种场景类别的图像数。限于版面,这里仅以UCM数据集为例显示本文算法的混淆矩阵,如图5所示。通过对UCM混淆矩阵的分析,可以发现误判主要集中在稠密居住区,中等规模居住区等类别中,从遥感图像内容来看,这些类别主要是对居住区的稠密和稀疏程度分类,或者是图像中包含多个类别要素,在对不同类别要素比例划分的时候出现误判,而这些即便对于人工标注,都存在一定的辨别难度。

图5

在WHU数据集中,共存在5个误判,分别是将农田判断为草地,河流判断为公园,工厂判断为居住区,足球场判断为池塘、机场判断为火车站。这些图像就其内容本身同样具有高度相似性和不同类别元素的交叉。

图6

3.2.6 不同数据集样本的训练与测试

由于不同数据集中图像特点各不相同,遥感场景分类的一般做法都是在目标数据集上随机选择样本,训练学习网络与之适应,因此不同的数据集中需要重新进行调参,而深度学习网络的训练调参是一个需要大量时间和空间的过程。本文尝试验证DenseHash特征表达的通用性,即在一个数据集中训练后直接作为其他数据集的特征提取器。实验结果如表4所示,NWPU数据集体量较大,训练出的密集哈希特征提取模型具有一定的通用性,迁移应用于其他2个数据集中,均可以获得近90%的分类精度,结合其紧凑的二值化表达所带来的计算时间和存储空间的降低,可以直接应用于遥感的粗分类场景。

表4 不同数据集样本的训练与测试

Tab.4

| 训练样本 | 测试样本 | 分类精度/% | 时间/s |

|---|---|---|---|

| UCM | UCM | 98.21 | 87.27 |

| NWPU | 58.12 | 837.69 | |

| WHU | 77.00 | 26.29 | |

| WHU | UCM | 71.30 | 55.56 |

| NWPU | 58.23 | 735.37 | |

| WHU | 99.02 | 26.33 | |

| NWPU | UCM | 88.62 | 54.43 |

| NWPU | 96.49 | 715.13 | |

| WHU | 91.86 | 25.03 |

4 结论

本文提出了一种面向遥感场景分类的紧凑哈希特征提取网络。针对遥感图像语义丰富的特点,采用密集网络提取高层语义特征,通过全连接层和激活函数实现低维度的特征表达,最后映射到汉明空间,生成紧凑的二值哈希码,作为支持向量机分类的特征输入。与其他方法相比,密集特征的哈希码表示一方面保留了遥感高层语义特征,另一方面二进制的特征结构,便于分类器的快速高效分类。3个通用遥感数据集的实证分析表明了算法有效性,各数据集的分类精度得到不同程度的提升。在下一步的研究中,尝试扩大不同类别的训练样本集,构建具有广泛适用性特征提取模型,减少目标数据集的训练调参成本。

参考文献

Imagenet classification with deep convolutional neural networks

[C]//

Deep residual learning for image recognition

[C]//

Densely connected convolutional networks

[C]//

Aggregating rich hierarchical features for scene classification in remote sensing imagery

[J].DOI:10.1109/JSTARS.4609443 URL [本文引用: 2]

Visual instance retrieval with deep convolutional networks

[J].DOI:10.3169/mta.4.251 URL [本文引用: 1]

SIFT meets CNN:A decade survey of instance retrieval

[J].DOI:10.1109/TPAMI.2017.2709749 URL [本文引用: 1]

Transferring deep convolutional neural networks for the scene classification of high-resolution remote sensing imagery

[J].DOI:10.3390/rs71114680 URL [本文引用: 1]

Remote sensing image scene classification using bag of convolutional features

[J].DOI:10.1109/LGRS.2017.2731997 URL [本文引用: 1]

基于深度卷积神经网络和多核学习的遥感图像分类方法

[J].

Remote sensing image classification method based on deep convolution neural network and multi-kernel learning

[J].

Remote sensing scene classification using multilayer stacked covariance pooling

[J].DOI:10.1109/TGRS.2018.2845668 URL [本文引用: 1]

When deep learning meets metric learning:Remote sensing image scene classification via learning discriminative CNNs

[J].DOI:10.1109/TGRS.2017.2783902 URL [本文引用: 1]

联合Fisher核编码和卷积神经网络的影像场景分类

[J].

Combined Fisher kernel coding framework with convolutional neural network for remote sensing scene classification

[J].

联合卷积神经网络与集成学习的遥感影像场景分类

[J].

Scene classification of remote sensing image using ensemble convolutional neural network

[J].

基于卷积神经网络的遥感图像分类研究

[J].

Classification of remote-sensing image based on convolutional neural network

[J].

基于脉冲卷积神经网络稀疏表征的高分辨率遥感图像场景分类方法

[J].

Sparse representation with spike convolutional neural networks for scene classification of remote sensing images of high resolution

[J].

Grad-cam:Visual explanations from deep networks via gradient-based localization

[C]//

Deep learning of binary hash codes for fast image retrieval

[C]//

Beyond bags of features:Spatial pyramid matching for recognizing natural scene categories

[C]//

All about VLAD

[C]//

稠密特征编码的遥感场景分类算法

[J].

Remote sensing image classification based on dense feature coding

[J].

Very deep convolutional networks for large-scale image recognition

[J/OL].

Going deeper with convolutions

[C]//

NetVLAD:CNN architecture for weakly supervised place recognition

[C]//

Bilinear convolutional neural networks for fine-grained visual recognition

[J].DOI:10.1109/TPAMI.2017.2723400 URL [本文引用: 1]

Image classification with the fisher vector:Theory and practice

[J].DOI:10.1007/s11263-013-0636-x URL [本文引用: 1]