0 引言

密集时间的高空间分辨率图像对全球或区域范围内的许多应用具有重要意义,如土地利用制图和变化检测[1 ] 、作物生长定量监测[2 ] 、植被物候变化监测[3 ] 、地表温度监测[4 ] 等。迄今为止,多平台卫星获得的高空间、高时间分辨率的遥感数据已经取得了巨大的突破,但是由于硬件技术的限制和预算的制约,目前的卫星传感器仍然不得不在空间和时间分辨率之间做出妥协[5 -6 ] 。时空融合技术是一种可行的、具有成本效益的方法,可以同时获得具有高空间和时间分辨率的遥感图像[7 ] 。

近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] 。在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构。这类算法原理简单、计算简便,但易出现异常值[13 ] 。为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据。尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域。为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性。然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变。另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异。

针对地表非线性变化的问题,研究人员提出了一系列的基于深度学习的时空融合技术,并且逐渐成为研究的主流。Shao等[16 ] 提出了一个扩展的超分辨率卷积神经网络(extended super-resolution convolutional neural network, ESRCNN)的数据融合框架,基于超分辨率的思想,将高分辨率的Sentinel-2图像作为辅助数据来降尺度低分辨率的Landsat8图像,从而生成高分辨率的密集时间影像序列; Li等[17 ] 提出了一种新的传感器偏差驱动的时空融合模型(bias-driven spatio-temporal fusion, Bia⁃STF),通过地表变化学习卷积神经网络(convolutional neural network,CNN)和偏差学习CNN的串联,共同学习不同传感器下的数据的差异信息; Jia等[18 ] 提出了一种双流的CNN——基于深度学习的时空数据融合(deep learning-based spatiotemporal data fusion, DL-SDFM),将正向预测和反向预测相结合,生成目标精细图像的同时形成基于时间变化和空间信息的映射,具有较好的泛化能力和鲁棒性。这些方法通过多层的网络模型有效提取和利用了图像的内在特征,如空间上下文和纹理等信息,取得了优异的预测效果。然而,这些方法也存在一些问题,如模型复杂度高、参数量巨大、预测过程容易出错,最重要的是,这些方法通常需要大量的已知影像进行训练,成本巨大[19 ] 。

近些年来,一种新型空间处理技术二维奇异谱分析(2D singular spectrum analysis, 2DSSA)被成功应用于图像的空间特征提取[19 -20 ] 。基于奇异值分解(singular value decomposition, SVD),它可以将一幅图像分解成多个子图像,每个子图像都包含不同的空间信息,充分挖掘图像的全局空间相关性,同时消除图像噪声。为了充分利用不同传感器影像的内在特征,并且在较少的已知影像上进行预测,本文提出了一种结合2DSSA的时空融合模型(2DSSA spatial-temporal fusion model, 2DSSA-STFM)。通过提取不同传感器影像的空间趋势和细节特征,分别建立对应光谱差异和不同时相地物的形状差异的线性模型,从而实现对目标时刻高分辨率影像的预测。结合深度时空融合技术中不同空间信息的优势,以及线性模型的简便快速的优势,提高时空融合的预测精度。

1 2DSSA-STFM模型

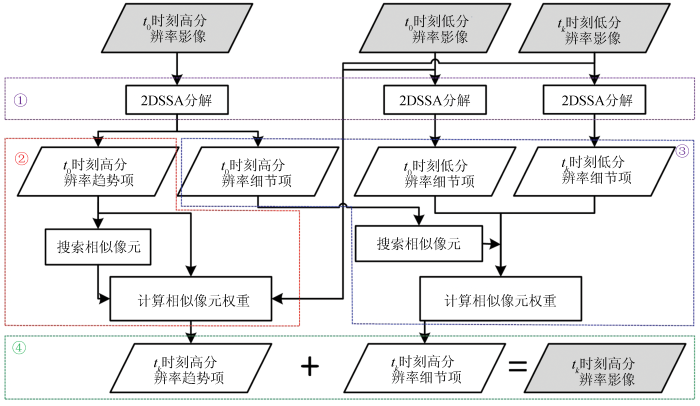

2DSSA-STFM模型主要包括4个步骤: 基于2DSSA的影像分解、高分辨率趋势项计算、高分辨率细节项计算和目标影像合成,具体流程如图1 所示。为了方便,本文将空间分辨率低、时间分辨率高的遥感影像简称为“低分辨率影像”,将空间分辨率高、时间分辨率低的遥感影像简称为“高分辨率影像”。2DSSA-STFM主要基于一对已知高、低分辨率影像进行预测,将已知时刻t 0 的高、低分辨率影像分别表示为L 0 M 0 tk 的低分辨率影像表示为M k

图1

图1

算法流程

Fig.1

Algorithm flowchart

1.1 基于2DSSA的影像分解

为了充分利用给定影像包含的趋势和纹理等内在特征,2DSSA-STFM使用2DSSA方法对给定的影像进行空间特征提取[19 -20 ] ,即趋势成分与细节成分提取,如图1 中①所示。2DSSA的具体处理步骤为: 给定一幅尺寸为W ×H 的灰度图像I ,2DSSA首先确定一个大小为u ×v 的嵌入窗口,该窗口通常远小于图像的大小。然后,将该窗口在图像上进行步长为1的滑动,滑动方向为从左到右、从上到下。在不同位置处,嵌入窗口内的像素都被拉伸为列向量V i , j ∈ R u v M

(1) M = { V 1,1 , V 1,2 , … , V i , j , … , V W - u + 1 , H - v + 1 } ∈ R u v × ( W - u + 1 , H - v + 1 )

式中轨迹矩阵M [21 ] 。然后,对得到的轨迹矩阵进行SVD分解,可以得到轨迹矩阵多个子矩阵相加和的形式,将其写为:

(2) M = M 1 + M 2 , M i = λ i u i v i

式中: M 1 M 2 λ i u i v i i =1,2。根据2DSSA在图像中的应用[19 ,21 ] 可知,M 1 M 2 M 1 M 2 I t r e n d I d e t a i l

(3) I = I t r e n d + I d e t a i l

由此,通过2DSSA可以得到任意一幅灰度图像的趋势项成分和细节项成分。

根据上述过程,对给定的3幅影像L 0 , M 0 M k

(4) L 0 = L t r e n d 0 + L d e t a i l 0 M 0 = M t r e n d 0 + M d e t a i l 0 M k = M k t r e n d + M k d e t a i l

由此得到的对应不同影像的趋势成分和细节成分将用于后续的计算。

1.2 高分辨率趋势项

与高分辨率图像相比,低分辨率图像在视觉上呈现为地物目标模糊、区分度下降的特点,而这与高分辨率图像分解得到的趋势项有相似之处。因此,使用高分辨率图像的趋势项与低分辨率图像建立二者在分辨率上的差异。通过建立高分辨率图像趋势项与低分辨率图像的线性关系,结合邻近相似像元信息构建权重函数,计算得到目标时刻影像的趋势成分,如图1 中②所示。

在与STARFM算法[14 ] 相同的假设条件下,建立高空间分辨率数据趋势项与低空间分辨率数据的关系为:

(5) L t r e n d 0 = M 0 + ε 0 L k t r e n d = M k + ε k

式中: L k t r e n d tk 时刻高分辨率影像的趋势项; ε 0 ε k t 0 和tk 时刻之间没发生变化,则ε 0 = ε k

(6) L k t r e n d = M k + L t r e n d 0 - M 0

(7) L k t r e n d ( x c , y c ) = ∑ i = 1 w ∑ j = 1 w W t r e n d [ M k ( x i , y j ) + L t r e n d 0 ( x i , y j ) - M 0 ( x i , y i ) ]

式中: w 为邻域窗口的尺寸; (x c , y c ) 为邻域窗口的中心像元; (x i , y j ) 为邻域窗口内与中心像元相似的像元; W t r e n d D S

(8) W t r e n d = ( 1 / S i j D i j ) / ∑ ∑ 1 / S i j D i j

(9) S i j = | L t r e n d 0 ( x i , y i ) - M 0 ( x i , y i ) | D i j = 1 + ( x c - x i ) 2 + ( y c - y i ) 2 / A

式中A 为常数,它定义了空间距离对光谱和时间距离的相对重要性。由此可以计算得到目标时刻高分辨率影像的趋势项L k t r e n d

1.3 高分辨率细节项

从t 0 到tk 时刻,影像中的地物会发生一定的变化。之前的研究直接计算2个时刻的低分辨率图像的差异,这一定程度上忽略了地物细节的变化[14 -15 ] 。细节项中包含的纹理信息能够更加有效地反映地表随时间的形状变化。因此,本文选择建立2个时相下低分辨率细节分量的线性关系,基于已知时刻高分辨率细节分量,结合邻域像素的时间和空间差异进行加权,得到目标时刻影像的细节成分,如图1 中③所示。

假设从t 0 到tk 时刻的反射率变化为线性变化,这个假设在短时间内是合理的[11 ] ,建立2个时相下低分辨率细节项和高分辨率细节项的关系,即

(10) M k d e t a i l = a M 0 d e t a i l + b L d e t a i l k = a L d e t a i l 0 + b

式中: L d e t a i l k tk 时刻高分辨率影像的细节项; a 和b 为线性回归模型的系数,用于描述影像在t 0 和tk 时刻的反射率变化。假设低分辨率影像和高分辨率影像的时相变化相同,并且t 0 和tk 时刻的反射率完全相关,即系数a =1,可得:

(11) L d e t a i l k = L d e t a i l 0 + M d e t a i l k - M 0 d e t a i l

(12) L k d e t a i l ( x c , y c ) = ∑ i = 1 w ∑ j = 1 w W d e t a i l [ L d e t a i l 0 ( x i , y i ) + M k d e t a i l ( x i , y i ) - L d e t a i l 0 ( x i , y i ) ]

式中W d e t a i l T d

(13) W t r e n d = ( 1 / T i j d i j ) / ∑ ∑ 1 / T i j d i j

(14) T i j = | M d e t a i l k ( x i , y j ) - M d e t a i l 0 ( x i , y j ) | d i j = 1 + ( x c - x i ) 2 + ( y c - y i ) 2 / 2

根据该过程,可以计算得到目标时刻高分辨率影像的细节项L k d e t a i l

1.4 目标影像合成

获得了目标时刻高分辨率图像的趋势项和细节项,对其进行合成得到最终的预测图像。根据式(3),对趋势项和细节项进行相加,即

(15) L k = L t r e n d k + L k d e t a i l

其中,趋势项L t r e n d k L k d e t a i l 图1 中④所示。

2 实验设置

2.1 实验数据

采用2个Landsat7 ETM+和MODIS数据集对提出的算法进行性能测试,每个数据集包括2对及以上的Landsat7 ETM+影像和MODIS影像。所有影像均进行了辐射校正、大气校正、重采样等预处理操作,Landsat7 ETM+与MODIS影像区域和时间匹配。Landsat7 ETM+影像的空间分辨率为30 m,MODIS影像的空间分辨率为500 m,主要选用绿光、红光、近红外3个波段进行实验,分别对应Landsat7 ETM+的4,3,2波段和MODIS的3,1,2波段。

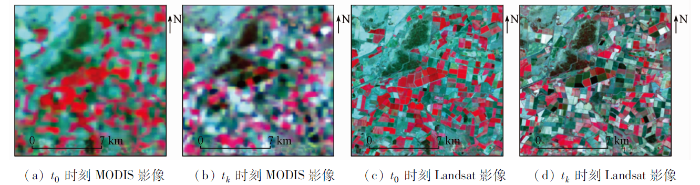

数据集1位于澳大利亚新南威尔士州南部的灌溉区(34.0034°E,145.0675°S)[22 ] ,包含2景Landsat7 ETM+影像和2景MODIS影像。这2对Landsat-MODIS卫星分别于2002年3月9日和2002年4月26日拍摄,覆盖范围为15 km×15 km,对应30 m空间分辨率Landsat影像的尺寸为500像元×500像元。该研究区是各种夏季作物的灌溉田,如水稻、玉米、高粱、大豆等,显示出高度异质性的景观。除了自然物候变化外,该区域的其他土地覆盖的多样性、复杂性、异质性和由人类活动引起的巨大时间变化产生了很高的空间和时间差异,这使得该地区的时空融合比正常测试地区更难解决,相应的近红外-红光-绿光假彩色图像如图2 所示。

图2

图2

数据集1的MODIS和Landsat7 ETM+影像

Fig.2

Images of MODIS and Landsat7 ETM+ of data set 1

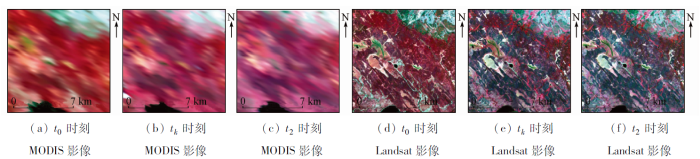

数据集2位于加拿大北部区域(104°W,54°N)[8 ] ,包含3景Landsat7 ETM+影像和3景MODIS影像,相应的近红外-红光-绿光假彩色影像,如图3 所示。这3对Landsat和MODIS卫星分别于2001年5月24日、2001年7月11日和2001年8月12日拍摄,覆盖范围为12 km×12 km,对应30 m空间分辨率Landsat图像的图像尺寸为400像元×400像元。研究区内土地覆盖类型以森林为主,包括云杉、松树、白杨等树种,此外还有沼泽、稀疏植被、土壤、岩石等地物,土地覆盖斑块很大,植被生长季节短,物候变化迅速,土地覆盖变化较小,但受到物候和天顶角变化的较大影响。

图3

图3

数据集2的MODIS和Landsat7 ETM+影像

Fig.3

Images of MODIS and Landsat7 ETM+ of data set 2

2.2 评价指标及参数设置

所有的融合结果都是通过定性和定量指标来进行评估,定性的评价主要是融合结果与真实图像的视觉效果对比,定量的评价指标是对图像的质量进行评定,本文主要采用平均绝对差(average absolute deviation,AAD)、均方根误差(root-mean-square error,RMSE)、结构相似性指数(structural similarity, SSIM)和相对无量纲全局误差(erreur relative globale adimensionnelle de synthese, ERGAS)[8 ] 共4个指标从光谱相似度和结构相似度两方面综合进行定量评价。

另外,在2DSSA-STFM模型中,2DSSA的嵌入窗口大小设置为10×10,以满足最佳的图像分解要求。在1.2节趋势项预测中,采用9×9大小的搜索窗口,在窗口中选择与中心像元最相似的前20个像元进行加权,以方便搜索更加相似的像素。在1.3节的细节项预测中,搜索窗口大小设置为31×31,选取前50个最相似的像元,以获取更加丰富的细节信息[23 ] 。

3 实验结果与分析

3.1 趋势项与细节项的预测

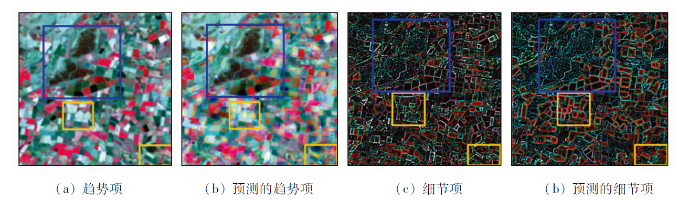

以数据集1为例,首先给出了由2DSSA分解得到的目标时刻影像的趋势项和细节项,然后给出了预测得到的影像的趋势项和细节项,如图4 所示。根据图4(a) 和(b) 所示,预测得到的趋势项(b)与实际趋势项(a)十分接近,在不规则的植被区、颜色差别较大的地物区域均有较好的相似度,如蓝色框所示。另外,根据图4(c) 和(d) 的蓝色框可知,细节项的预测也具有较高的准确度,不规则地物的形状、边缘等都与实际细节项相符。然而,预测的趋势项和细节项中也存在一些差别较大的地方,如黄色框所示,在(b)中某些区域地物反射率存在错误,(d)中某些地物的边缘存在色彩差异,主要原因在于趋势项和细节项的预测是基于线性模型,这一定程度上忽略了地物的非线性变化,因而在部分变化剧烈的区域存在预测错误。

图4

图4

数据集1预测的趋势项和细节项

Fig.4

Trend and detail terms predicted by data set 1

总体而言,预测得到的趋势项、细节项与原始图像的实际趋势项、细节项有较高的吻合度,体现了2DSSA-STFM模型的有效性。

3.2 实验结果和讨论

针对2个数据集分别将2DSSA-STFM模型与经典的STARFM和ESTARFM模型进行性能对比。首先,在数据集1上,评价了2DSSA-STFM模型与STARFM模型的性能,主要考虑到2个模型均使用一对已知时刻的影像预测目标时刻的高分辨率影像; 然后,在数据集2上,评价了2DSSA-STFM模型与STARFM和ESTARFM的性能,原因在于ESTARFM需要2对已知影像进行预测。

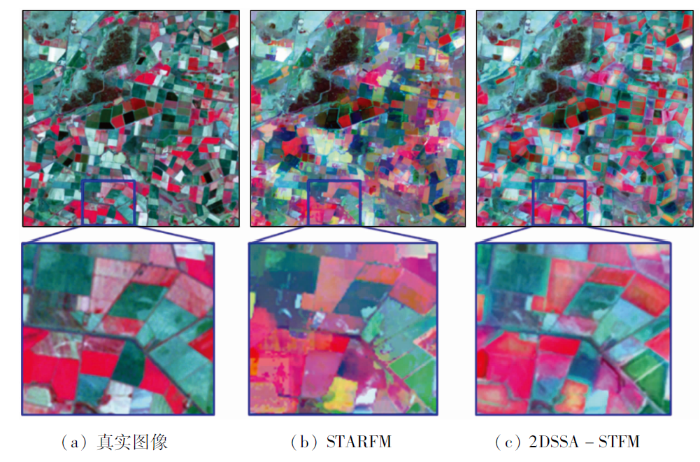

图5 给出了在数据集1上,2DSSA-STFM模型与STARFM模型的预测结果。整体来看,STARFM模型预测的图像上存在较多细碎的斑块,存在一些地物预测错误。相比之下,2DSSA-STFM有效降低了这种斑块效应,不同地物的边界和细节信息得到了很好的保留,与真实影像有较好的一致性。根据细节图(蓝色框)所示,尽管在部分地物上出现了预测偏差,2DSSA-STFM模型的预测结果拥有更加清晰可分的地物区域、良好的地物边界以及与真实影像相吻合的地物颜色,这证明了2DSSA-STFM模型的有效性。

图5

图5

数据集1预测图像

Fig.5

Data set 1 prediction image

表1 给出了2DSSA-STFM模型与STARFM模型的定量结果,加粗字体为最佳值。根据结果可知,2DSSA-STFM模型在绿光、红光、近红外3个波段上均取得了更好的效果。以近红外波段为例,2DSSA-STFM模型的AAD指标下降约13.12,RMSE指标下降了约29.74,ERGAS指标下降0.02,SSIM指标提升了0.08。定量结果显示,2DSSA-STFM模型的预测结果拥有更高的精度。图6 给出了在数据集2上,2DSSA-STFM模型与STARFM和ESTARFM模型的预测结果。与真实图像相比,STARFM模型的预测结果有较大偏差,图像颜色偏深,ESTARFM和2DSSA-STFM模型偏差较小,但是ESTARFM模型的预测图像与真实图像更为接近,主要原因在于ESTARFM模型使用2对已知图像进行预测,而2DSSA-STFM模型仅使用一对已知影像进行预测。根据细节图(红色框)所示,ESTARFM模型的结果仍然是最好的,但是在某些区域,如左下角白色地物处,2DSSA-STFM模型的预测结果与真实图像更为接近,其余模型均存在一些颜色偏差。

图6

图6

数据集2预测图像

Fig.6

Data set 2 prediction image

表2 给出了2DSSA-STFM模型与STARFM和ESTARFM模型的定量结果,加粗字体为最佳值。总体而言,ESTARFM模型在大部分波段都取得了更好的分类效果,主要原因还是因为它利用了更多的已知图像信息,而2DSSA-STFM模型在近红外波段取得了最好的效果,STARFM模型效果最差。以近红外波段为例,相比于STARFM和ESTARFM模型,2DSSA-STFM模型的AAD指标分别下降约42.90和0.47,RMSE指标分别下降了约61.34和0.52,SSIM指标分别提升了0.258和0.007。由此可知,2DSSA-STFM模型虽然仅使用一对已知影像进行预测,但是在近红外波段仍取得最好的效果。

4 结论

基于2DSSA的图像分解特性,提出了2DSSA-STFM模型。该方法充分利用了影像的内在信息,包括空间趋势和纹理等细节,能够有效地反映不同时间影像的反射率变化和地形变化。在2个实验区的实验结果表明,2DSSA-STFM模型能够获得较高的预测精度,有利于预测土地覆盖变化。主要研究结论如下:

1) 2DSSA-STFM在AAD,RMSE和ERGAS指标下的预测误差更小,并且SSIM更高,因而提出的利用趋势项和细节项分别预测的方法要优于传统的STARFM方法。

2) 使用高分辨率影像的趋势项来代替原始影像,建立与低分辨率影像的关系,可以提高寻找相似像元的准确性,减少STARFM模型中存在的斑块问题。

3) 通过使用不同时相的MODIS影像的细节项,有效地捕捉到地表形状和细节变化,很好地保留了预测影像中地物的形状和边缘信息。

4) 2DSSA-STFM模型在近红外波段预测上具有优异的效果,趋势项和细节项的处理方法更适合于长波波段的处理。

然而,本文算法还存在一定的局限性,如建立的模型均为线性模型,未考虑地物的非线性变化。后期研究将开发简单快速的非线性模型,进一步提高图像预测的精度。

参考文献

View Option

[1]

Roy D P Wulder M A Loveland T R , et al . Landsat8:Science and product vision for terrestrial global change research

[J]. Remote Sensing of Environment , 2014 , 145 :154 -172 .

DOI:10.1016/j.rse.2014.02.001

URL

[本文引用: 1]

[2]

Singh D . Generation and evaluation of gross primary productivity using Landsat data through blending with MODIS data

[J]. International Journal of Applied Earth Observation and Geoinformation , 2011 , 13 (1 ):59 -69 .

DOI:10.1016/j.jag.2010.06.007

URL

[本文引用: 1]

[3]

Bhandari S Phinn S Gill T . Preparing Landsat image time series (LITS) for monitoring changes in vegetation phenology in Queensland,Australia

[J]. Remote Sensing , 2012 , 4 (6 ):1856 -1886 .

DOI:10.3390/rs4061856

URL

[本文引用: 1]

[4]

Weng Q H Fu P Gao F . Generating daily land surface temperature at Landsat resolution by fusing Landsat and MODIS data

[J]. Remote Sensing of Environment , 2014 , 145 :55 -67 .

DOI:10.1016/j.rse.2014.02.003

URL

[本文引用: 1]

[5]

Gevaert C M García-Haro F J . A comparison of STARFM and an unmixing-based algorithm for Landsat and MODIS data fusion

[J]. Remote Sensing of Environment , 2015 , 156 :34 -44 .

DOI:10.1016/j.rse.2014.09.012

URL

[本文引用: 1]

[6]

邬明权 , 牛铮 , 王长耀 . 多源遥感数据时空融合模型应用分析

[J]. 地球信息科学学报 , 2014 , 16 (5 ):776 -783 .

DOI:10.3724/SP.J.1047.2014.00776

[本文引用: 1]

多源遥感数据时空融合模型是解决目前遥感数据获取能力不足问题的重要方法之一,当前主要融合方法的研究,集中于平原区域,缺乏复杂条件下的多源遥感数据融合技术的应用研究。针对我国南方复杂条件,本文对比研究了多源遥感数据时空融合模型在我国南方复杂条件下的应用能力。针对LORENZO模型、LIU模型、统计回归模型、STARFM和ESTARFM 5种主流多源遥感数据时空融合模型,采用Landsat-ETM+和MODIS数据,以江苏省南京市的小块区域为实验区,利用5种模型生产融合影像,以真实Landsat-ETM+数据为模板,定性和定量评价融合效果的好坏。结果表明:除LORENZO模型外,其余4种模型获得的融合影像与真实影像之间都具有较高的相关性,相关系数均高于0.6,其中,ESTARFM模型的融合影像与真实影像间的相关性最高,融合效果最好,其次为STARFM模型,再次为LIU模型和统计模型法。在融合过程中采用距离、时间和光谱等信息越多,融合效果越好,在复杂地区的适用能力越强,融合影像更能反映地物的细节特征。

Wu M Q Niu Z Wang C Y . Assessing the accuracy of spatial and temporal image fusion model of complex area in south China

[J]. Journal of Geo-Information Science , 2014 , 16 (5 ):776 -783 .

[本文引用: 1]

[7]

Zhao Y Huang B Song H . A robust adaptive spatial and temporal image fusion model for complex land surface changes

[J]. Remote Sensing of Environment , 2018 , 208 :42 -62 .

DOI:10.1016/j.rse.2018.02.009

URL

[本文引用: 2]

[9]

Wu M Wu C Huang W , et al . An improved high spatial and temporal data fusion approach for combining Landsat and MODIS data to generate daily synthetic Landsat imagery

[J]. Information Fusion , 2016 , 31 :14 -25 .

DOI:10.1016/j.inffus.2015.12.005

URL

[本文引用: 1]

[10]

Huang B Song H . Spatiotemporal reflectance fusion via sparse representation

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2012 , 50 (10 ):3707 -3716 .

DOI:10.1109/TGRS.2012.2186638

URL

[本文引用: 1]

[11]

Cheng Q Liu H Shen H , et al . A spatial and temporal nonlocal filter-based data fusion method

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2017 , 55 (8 ):4476 -4488 .

DOI:10.1109/TGRS.2017.2692802

URL

[本文引用: 2]

[12]

Li J Li Y He L , et al . Spatio-temporal fusion for remote sensing data:An overview and new benchmark

[J]. Science China Information Sciences , 2020 , 63 (4 ):7 -23 .

[本文引用: 1]

[14]

Gao F Masek J Schwaller M , et al . On the blending of the Landsat and MODIS surface reflectance:Predicting daily Landsat surface reflectance

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2006 , 44 (8 ):2207 -2218 .

DOI:10.1109/TGRS.2006.872081

URL

[本文引用: 3]

[15]

Zhu X Chen J Gao F , et al . An enhanced spatial and temporal adaptive reflectance fusion model for complex heterogeneous regions

[J]. Remote Sensing of Environment , 2010 , 114 (11 ):2610 -2623 .

DOI:10.1016/j.rse.2010.05.032

URL

[本文引用: 2]

[16]

Shao Z Cai J Fu P , et al . Deep learning-based fusion of Landsat8 and Sentinel-2 images for a harmonized surface reflectance product

[J]. Remote Sensing of Environment , 2019 , 235 (12 ):111425 .

DOI:10.1016/j.rse.2019.111425

URL

[本文引用: 1]

[17]

Li Y Li J He L , et al . A new sensor bias-driven spatio-temporal fusion model based on convolutional neural networks

[J]. Science China Information Sciences , 2020 , 63 (4 ):20 -35 .

[本文引用: 1]

[18]

Jia D Song C Cheng C , et al . A novel deep learning-based spatio-temporal fusion method for combining satellite images with different resolutions using a two-stream convolutional neural network

[J]. Remote Sensing , 2020 , 12 (4 ):698 .

DOI:10.3390/rs12040698

URL

[本文引用: 1]

Spatiotemporal fusion is considered a feasible and cost-effective way to solve the trade-off between the spatial and temporal resolution of satellite sensors. Recently proposed learning-based spatiotemporal fusion methods can address the prediction of both phenological and land-cover change. In this paper, we propose a novel deep learning-based spatiotemporal data fusion method that uses a two-stream convolutional neural network. The method combines both forward and backward prediction to generate a target fine image, where temporal change-based and a spatial information-based mapping are simultaneously formed, addressing the prediction of both phenological and land-cover changes with better generalization ability and robustness. Comparative experimental results for the test datasets with phenological and land-cover changes verified the effectiveness of our method. Compared to existing learning-based spatiotemporal fusion methods, our method is more effective in predicting phenological change and directly reconstructing the prediction with complete spatial details without the need for auxiliary modulation.

[19]

Fu H Sun G Ren J , et al . Fusion of PCA and segmented-PCA domain multiscale 2-D-SSA for effective spectral-spatial feature extraction and data classification in hyperspectral imagery

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2022 , 60 :1 -14 .

[本文引用: 4]

[20]

Sun G Fu H Ren J , et al . SpaSSA:Superpixelwise adaptive SSA for unsupervised spatial-spectral feature extraction in hyperspectral image

[J]. IEEE Transactions on Cybernetics , 2022 , 52 (7 ):6158 -6169 .

DOI:10.1109/TCYB.2021.3104100

URL

[本文引用: 2]

[21]

Zabalza J Ren J Zheng J , et al . Novel two-dimensional singular spectrum analysis for effective feature extraction and data classification in hyperspectral imaging

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2015 , 53 (8 ):4418 -4433 .

DOI:10.1109/TGRS.36

URL

[本文引用: 2]

[22]

Emelyanova I V McVicar T R Van Niel T G , et al . Assessing the accuracy of blending Landsat-MODIS surface reflectances in two landscapes with contrasting spatial and temporal dynamics:A framework for algorithm selection

[J]. Remote Sensing of Environment , 2013 , 133 :193 -209 .

DOI:10.1016/j.rse.2013.02.007

URL

[本文引用: 1]

[23]

刘慧琴 , 吴鹏海 , 沈焕锋 , 等 . 一种基于非局部滤波的遥感时空信息融合方法

[J]. 地理与地理信息科学 . 2015 , 31 (4 ):27 -32 .

[本文引用: 1]

Liu H W Wu P H Sheng H F . A spatio-temporal information fusion method based on non-local means filter

[J]. Geography and Geo-Information Science , 2015 , 31 (4 ):27 -32 .

[本文引用: 1]

Landsat8:Science and product vision for terrestrial global change research

1

2014

... 密集时间的高空间分辨率图像对全球或区域范围内的许多应用具有重要意义,如土地利用制图和变化检测[1 ] 、作物生长定量监测[2 ] 、植被物候变化监测[3 ] 、地表温度监测[4 ] 等.迄今为止,多平台卫星获得的高空间、高时间分辨率的遥感数据已经取得了巨大的突破,但是由于硬件技术的限制和预算的制约,目前的卫星传感器仍然不得不在空间和时间分辨率之间做出妥协[5 -6 ] .时空融合技术是一种可行的、具有成本效益的方法,可以同时获得具有高空间和时间分辨率的遥感图像[7 ] . ...

Generation and evaluation of gross primary productivity using Landsat data through blending with MODIS data

1

2011

... 密集时间的高空间分辨率图像对全球或区域范围内的许多应用具有重要意义,如土地利用制图和变化检测[1 ] 、作物生长定量监测[2 ] 、植被物候变化监测[3 ] 、地表温度监测[4 ] 等.迄今为止,多平台卫星获得的高空间、高时间分辨率的遥感数据已经取得了巨大的突破,但是由于硬件技术的限制和预算的制约,目前的卫星传感器仍然不得不在空间和时间分辨率之间做出妥协[5 -6 ] .时空融合技术是一种可行的、具有成本效益的方法,可以同时获得具有高空间和时间分辨率的遥感图像[7 ] . ...

Preparing Landsat image time series (LITS) for monitoring changes in vegetation phenology in Queensland,Australia

1

2012

... 密集时间的高空间分辨率图像对全球或区域范围内的许多应用具有重要意义,如土地利用制图和变化检测[1 ] 、作物生长定量监测[2 ] 、植被物候变化监测[3 ] 、地表温度监测[4 ] 等.迄今为止,多平台卫星获得的高空间、高时间分辨率的遥感数据已经取得了巨大的突破,但是由于硬件技术的限制和预算的制约,目前的卫星传感器仍然不得不在空间和时间分辨率之间做出妥协[5 -6 ] .时空融合技术是一种可行的、具有成本效益的方法,可以同时获得具有高空间和时间分辨率的遥感图像[7 ] . ...

Generating daily land surface temperature at Landsat resolution by fusing Landsat and MODIS data

1

2014

... 密集时间的高空间分辨率图像对全球或区域范围内的许多应用具有重要意义,如土地利用制图和变化检测[1 ] 、作物生长定量监测[2 ] 、植被物候变化监测[3 ] 、地表温度监测[4 ] 等.迄今为止,多平台卫星获得的高空间、高时间分辨率的遥感数据已经取得了巨大的突破,但是由于硬件技术的限制和预算的制约,目前的卫星传感器仍然不得不在空间和时间分辨率之间做出妥协[5 -6 ] .时空融合技术是一种可行的、具有成本效益的方法,可以同时获得具有高空间和时间分辨率的遥感图像[7 ] . ...

A comparison of STARFM and an unmixing-based algorithm for Landsat and MODIS data fusion

1

2015

... 密集时间的高空间分辨率图像对全球或区域范围内的许多应用具有重要意义,如土地利用制图和变化检测[1 ] 、作物生长定量监测[2 ] 、植被物候变化监测[3 ] 、地表温度监测[4 ] 等.迄今为止,多平台卫星获得的高空间、高时间分辨率的遥感数据已经取得了巨大的突破,但是由于硬件技术的限制和预算的制约,目前的卫星传感器仍然不得不在空间和时间分辨率之间做出妥协[5 -6 ] .时空融合技术是一种可行的、具有成本效益的方法,可以同时获得具有高空间和时间分辨率的遥感图像[7 ] . ...

多源遥感数据时空融合模型应用分析

1

2014

... 密集时间的高空间分辨率图像对全球或区域范围内的许多应用具有重要意义,如土地利用制图和变化检测[1 ] 、作物生长定量监测[2 ] 、植被物候变化监测[3 ] 、地表温度监测[4 ] 等.迄今为止,多平台卫星获得的高空间、高时间分辨率的遥感数据已经取得了巨大的突破,但是由于硬件技术的限制和预算的制约,目前的卫星传感器仍然不得不在空间和时间分辨率之间做出妥协[5 -6 ] .时空融合技术是一种可行的、具有成本效益的方法,可以同时获得具有高空间和时间分辨率的遥感图像[7 ] . ...

多源遥感数据时空融合模型应用分析

1

2014

... 密集时间的高空间分辨率图像对全球或区域范围内的许多应用具有重要意义,如土地利用制图和变化检测[1 ] 、作物生长定量监测[2 ] 、植被物候变化监测[3 ] 、地表温度监测[4 ] 等.迄今为止,多平台卫星获得的高空间、高时间分辨率的遥感数据已经取得了巨大的突破,但是由于硬件技术的限制和预算的制约,目前的卫星传感器仍然不得不在空间和时间分辨率之间做出妥协[5 -6 ] .时空融合技术是一种可行的、具有成本效益的方法,可以同时获得具有高空间和时间分辨率的遥感图像[7 ] . ...

A robust adaptive spatial and temporal image fusion model for complex land surface changes

2

2018

... 密集时间的高空间分辨率图像对全球或区域范围内的许多应用具有重要意义,如土地利用制图和变化检测[1 ] 、作物生长定量监测[2 ] 、植被物候变化监测[3 ] 、地表温度监测[4 ] 等.迄今为止,多平台卫星获得的高空间、高时间分辨率的遥感数据已经取得了巨大的突破,但是由于硬件技术的限制和预算的制约,目前的卫星传感器仍然不得不在空间和时间分辨率之间做出妥协[5 -6 ] .时空融合技术是一种可行的、具有成本效益的方法,可以同时获得具有高空间和时间分辨率的遥感图像[7 ] . ...

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

一种基于分层策略的时空融合模型

3

2021

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

... 数据集2位于加拿大北部区域(104°W,54°N)[8 ] ,包含3景Landsat7 ETM+影像和3景MODIS影像,相应的近红外-红光-绿光假彩色影像,如图3 所示.这3对Landsat和MODIS卫星分别于2001年5月24日、2001年7月11日和2001年8月12日拍摄,覆盖范围为12 km×12 km,对应30 m空间分辨率Landsat图像的图像尺寸为400像元×400像元.研究区内土地覆盖类型以森林为主,包括云杉、松树、白杨等树种,此外还有沼泽、稀疏植被、土壤、岩石等地物,土地覆盖斑块很大,植被生长季节短,物候变化迅速,土地覆盖变化较小,但受到物候和天顶角变化的较大影响. ...

... 所有的融合结果都是通过定性和定量指标来进行评估,定性的评价主要是融合结果与真实图像的视觉效果对比,定量的评价指标是对图像的质量进行评定,本文主要采用平均绝对差(average absolute deviation,AAD)、均方根误差(root-mean-square error,RMSE)、结构相似性指数(structural similarity, SSIM)和相对无量纲全局误差(erreur relative globale adimensionnelle de synthese, ERGAS)[8 ] 共4个指标从光谱相似度和结构相似度两方面综合进行定量评价. ...

一种基于分层策略的时空融合模型

3

2021

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

... 数据集2位于加拿大北部区域(104°W,54°N)[8 ] ,包含3景Landsat7 ETM+影像和3景MODIS影像,相应的近红外-红光-绿光假彩色影像,如图3 所示.这3对Landsat和MODIS卫星分别于2001年5月24日、2001年7月11日和2001年8月12日拍摄,覆盖范围为12 km×12 km,对应30 m空间分辨率Landsat图像的图像尺寸为400像元×400像元.研究区内土地覆盖类型以森林为主,包括云杉、松树、白杨等树种,此外还有沼泽、稀疏植被、土壤、岩石等地物,土地覆盖斑块很大,植被生长季节短,物候变化迅速,土地覆盖变化较小,但受到物候和天顶角变化的较大影响. ...

... 所有的融合结果都是通过定性和定量指标来进行评估,定性的评价主要是融合结果与真实图像的视觉效果对比,定量的评价指标是对图像的质量进行评定,本文主要采用平均绝对差(average absolute deviation,AAD)、均方根误差(root-mean-square error,RMSE)、结构相似性指数(structural similarity, SSIM)和相对无量纲全局误差(erreur relative globale adimensionnelle de synthese, ERGAS)[8 ] 共4个指标从光谱相似度和结构相似度两方面综合进行定量评价. ...

An improved high spatial and temporal data fusion approach for combining Landsat and MODIS data to generate daily synthetic Landsat imagery

1

2016

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

Spatiotemporal reflectance fusion via sparse representation

1

2012

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

A spatial and temporal nonlocal filter-based data fusion method

2

2017

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

... 假设从t 0 到tk 时刻的反射率变化为线性变化,这个假设在短时间内是合理的[11 ] ,建立2个时相下低分辨率细节项和高分辨率细节项的关系,即 ...

Spatio-temporal fusion for remote sensing data:An overview and new benchmark

1

2020

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

遥感数据时空融合研究进展及展望

1

2018

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

遥感数据时空融合研究进展及展望

1

2018

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

On the blending of the Landsat and MODIS surface reflectance:Predicting daily Landsat surface reflectance

3

2006

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

... 在与STARFM算法[14 ] 相同的假设条件下,建立高空间分辨率数据趋势项与低空间分辨率数据的关系为: ...

... 从t 0 到tk 时刻,影像中的地物会发生一定的变化.之前的研究直接计算2个时刻的低分辨率图像的差异,这一定程度上忽略了地物细节的变化[14 -15 ] .细节项中包含的纹理信息能够更加有效地反映地表随时间的形状变化.因此,本文选择建立2个时相下低分辨率细节分量的线性关系,基于已知时刻高分辨率细节分量,结合邻域像素的时间和空间差异进行加权,得到目标时刻影像的细节成分,如图1 中③所示. ...

An enhanced spatial and temporal adaptive reflectance fusion model for complex heterogeneous regions

2

2010

... 近年来,针对遥感数据时空融合技术,国内外学者进行了大量研究[7 ⇓ ⇓ ⇓ ⇓ -12 ] .在众多已有的时空融合技术中,基于像元重构的融合模型算法得到广泛的应用,其基本思想是通过一定的规则选择目标像元周边的像元参与目标像元的重构.这类算法原理简单、计算简便,但易出现异常值[13 ] .为了避免异常值,Gao等[14 ] 提出了一种时空自适应性反射率融合模型(spatial and temporal adaptive reflectance fusion model, STARFM),该模型通过融合Landsat和MODIS影像来获得兼具Landsat的空间分辨率特征和MODIS的时间分辨率特征的反射率数据.尽管STARFM模型能够获取预测数据,但是不适用于异质性较高的区域.为此,Zhu等[15 ] 提出了一种改进型时空自适应融合模型(enhanced spatial and temporal adaptive reflectance fusion model, ESTARFM),考虑了反射率的时间变化趋势,可以更好地预测反射率的变化,对不同地表具有更好的适应性.然而,这2种模型都是基于不同反射率和时间变化的线性关系,忽略了地表的非线性变化和突变.另外,它们直接在原始影像上构建线性关系,未对影像的内在特征进行分析,无法有效反映高低空间分辨率的光谱差异和不同时相地物的形状差异. ...

... 从t 0 到tk 时刻,影像中的地物会发生一定的变化.之前的研究直接计算2个时刻的低分辨率图像的差异,这一定程度上忽略了地物细节的变化[14 -15 ] .细节项中包含的纹理信息能够更加有效地反映地表随时间的形状变化.因此,本文选择建立2个时相下低分辨率细节分量的线性关系,基于已知时刻高分辨率细节分量,结合邻域像素的时间和空间差异进行加权,得到目标时刻影像的细节成分,如图1 中③所示. ...

Deep learning-based fusion of Landsat8 and Sentinel-2 images for a harmonized surface reflectance product

1

2019

... 针对地表非线性变化的问题,研究人员提出了一系列的基于深度学习的时空融合技术,并且逐渐成为研究的主流.Shao等[16 ] 提出了一个扩展的超分辨率卷积神经网络(extended super-resolution convolutional neural network, ESRCNN)的数据融合框架,基于超分辨率的思想,将高分辨率的Sentinel-2图像作为辅助数据来降尺度低分辨率的Landsat8图像,从而生成高分辨率的密集时间影像序列; Li等[17 ] 提出了一种新的传感器偏差驱动的时空融合模型(bias-driven spatio-temporal fusion, Bia⁃STF),通过地表变化学习卷积神经网络(convolutional neural network,CNN)和偏差学习CNN的串联,共同学习不同传感器下的数据的差异信息; Jia等[18 ] 提出了一种双流的CNN——基于深度学习的时空数据融合(deep learning-based spatiotemporal data fusion, DL-SDFM),将正向预测和反向预测相结合,生成目标精细图像的同时形成基于时间变化和空间信息的映射,具有较好的泛化能力和鲁棒性.这些方法通过多层的网络模型有效提取和利用了图像的内在特征,如空间上下文和纹理等信息,取得了优异的预测效果.然而,这些方法也存在一些问题,如模型复杂度高、参数量巨大、预测过程容易出错,最重要的是,这些方法通常需要大量的已知影像进行训练,成本巨大[19 ] . ...

A new sensor bias-driven spatio-temporal fusion model based on convolutional neural networks

1

2020

... 针对地表非线性变化的问题,研究人员提出了一系列的基于深度学习的时空融合技术,并且逐渐成为研究的主流.Shao等[16 ] 提出了一个扩展的超分辨率卷积神经网络(extended super-resolution convolutional neural network, ESRCNN)的数据融合框架,基于超分辨率的思想,将高分辨率的Sentinel-2图像作为辅助数据来降尺度低分辨率的Landsat8图像,从而生成高分辨率的密集时间影像序列; Li等[17 ] 提出了一种新的传感器偏差驱动的时空融合模型(bias-driven spatio-temporal fusion, Bia⁃STF),通过地表变化学习卷积神经网络(convolutional neural network,CNN)和偏差学习CNN的串联,共同学习不同传感器下的数据的差异信息; Jia等[18 ] 提出了一种双流的CNN——基于深度学习的时空数据融合(deep learning-based spatiotemporal data fusion, DL-SDFM),将正向预测和反向预测相结合,生成目标精细图像的同时形成基于时间变化和空间信息的映射,具有较好的泛化能力和鲁棒性.这些方法通过多层的网络模型有效提取和利用了图像的内在特征,如空间上下文和纹理等信息,取得了优异的预测效果.然而,这些方法也存在一些问题,如模型复杂度高、参数量巨大、预测过程容易出错,最重要的是,这些方法通常需要大量的已知影像进行训练,成本巨大[19 ] . ...

A novel deep learning-based spatio-temporal fusion method for combining satellite images with different resolutions using a two-stream convolutional neural network

1

2020

... 针对地表非线性变化的问题,研究人员提出了一系列的基于深度学习的时空融合技术,并且逐渐成为研究的主流.Shao等[16 ] 提出了一个扩展的超分辨率卷积神经网络(extended super-resolution convolutional neural network, ESRCNN)的数据融合框架,基于超分辨率的思想,将高分辨率的Sentinel-2图像作为辅助数据来降尺度低分辨率的Landsat8图像,从而生成高分辨率的密集时间影像序列; Li等[17 ] 提出了一种新的传感器偏差驱动的时空融合模型(bias-driven spatio-temporal fusion, Bia⁃STF),通过地表变化学习卷积神经网络(convolutional neural network,CNN)和偏差学习CNN的串联,共同学习不同传感器下的数据的差异信息; Jia等[18 ] 提出了一种双流的CNN——基于深度学习的时空数据融合(deep learning-based spatiotemporal data fusion, DL-SDFM),将正向预测和反向预测相结合,生成目标精细图像的同时形成基于时间变化和空间信息的映射,具有较好的泛化能力和鲁棒性.这些方法通过多层的网络模型有效提取和利用了图像的内在特征,如空间上下文和纹理等信息,取得了优异的预测效果.然而,这些方法也存在一些问题,如模型复杂度高、参数量巨大、预测过程容易出错,最重要的是,这些方法通常需要大量的已知影像进行训练,成本巨大[19 ] . ...

Fusion of PCA and segmented-PCA domain multiscale 2-D-SSA for effective spectral-spatial feature extraction and data classification in hyperspectral imagery

4

2022

... 针对地表非线性变化的问题,研究人员提出了一系列的基于深度学习的时空融合技术,并且逐渐成为研究的主流.Shao等[16 ] 提出了一个扩展的超分辨率卷积神经网络(extended super-resolution convolutional neural network, ESRCNN)的数据融合框架,基于超分辨率的思想,将高分辨率的Sentinel-2图像作为辅助数据来降尺度低分辨率的Landsat8图像,从而生成高分辨率的密集时间影像序列; Li等[17 ] 提出了一种新的传感器偏差驱动的时空融合模型(bias-driven spatio-temporal fusion, Bia⁃STF),通过地表变化学习卷积神经网络(convolutional neural network,CNN)和偏差学习CNN的串联,共同学习不同传感器下的数据的差异信息; Jia等[18 ] 提出了一种双流的CNN——基于深度学习的时空数据融合(deep learning-based spatiotemporal data fusion, DL-SDFM),将正向预测和反向预测相结合,生成目标精细图像的同时形成基于时间变化和空间信息的映射,具有较好的泛化能力和鲁棒性.这些方法通过多层的网络模型有效提取和利用了图像的内在特征,如空间上下文和纹理等信息,取得了优异的预测效果.然而,这些方法也存在一些问题,如模型复杂度高、参数量巨大、预测过程容易出错,最重要的是,这些方法通常需要大量的已知影像进行训练,成本巨大[19 ] . ...

... 近些年来,一种新型空间处理技术二维奇异谱分析(2D singular spectrum analysis, 2DSSA)被成功应用于图像的空间特征提取[19 -20 ] .基于奇异值分解(singular value decomposition, SVD),它可以将一幅图像分解成多个子图像,每个子图像都包含不同的空间信息,充分挖掘图像的全局空间相关性,同时消除图像噪声.为了充分利用不同传感器影像的内在特征,并且在较少的已知影像上进行预测,本文提出了一种结合2DSSA的时空融合模型(2DSSA spatial-temporal fusion model, 2DSSA-STFM).通过提取不同传感器影像的空间趋势和细节特征,分别建立对应光谱差异和不同时相地物的形状差异的线性模型,从而实现对目标时刻高分辨率影像的预测.结合深度时空融合技术中不同空间信息的优势,以及线性模型的简便快速的优势,提高时空融合的预测精度. ...

... 为了充分利用给定影像包含的趋势和纹理等内在特征,2DSSA-STFM使用2DSSA方法对给定的影像进行空间特征提取[19 -20 ] ,即趋势成分与细节成分提取,如图1 中①所示.2DSSA的具体处理步骤为: 给定一幅尺寸为W ×H 的灰度图像I ,2DSSA首先确定一个大小为u ×v 的嵌入窗口,该窗口通常远小于图像的大小.然后,将该窗口在图像上进行步长为1的滑动,滑动方向为从左到右、从上到下.在不同位置处,嵌入窗口内的像素都被拉伸为列向量 V i , j ∈ R u v M

... 式中: M 1 M 2 λ i u i v i i =1,2.根据2DSSA在图像中的应用[19 ,21 ] 可知, M 1 M 2 M 1 M 2 I t r e n d I d e t a i l

SpaSSA:Superpixelwise adaptive SSA for unsupervised spatial-spectral feature extraction in hyperspectral image

2

2022

... 近些年来,一种新型空间处理技术二维奇异谱分析(2D singular spectrum analysis, 2DSSA)被成功应用于图像的空间特征提取[19 -20 ] .基于奇异值分解(singular value decomposition, SVD),它可以将一幅图像分解成多个子图像,每个子图像都包含不同的空间信息,充分挖掘图像的全局空间相关性,同时消除图像噪声.为了充分利用不同传感器影像的内在特征,并且在较少的已知影像上进行预测,本文提出了一种结合2DSSA的时空融合模型(2DSSA spatial-temporal fusion model, 2DSSA-STFM).通过提取不同传感器影像的空间趋势和细节特征,分别建立对应光谱差异和不同时相地物的形状差异的线性模型,从而实现对目标时刻高分辨率影像的预测.结合深度时空融合技术中不同空间信息的优势,以及线性模型的简便快速的优势,提高时空融合的预测精度. ...

... 为了充分利用给定影像包含的趋势和纹理等内在特征,2DSSA-STFM使用2DSSA方法对给定的影像进行空间特征提取[19 -20 ] ,即趋势成分与细节成分提取,如图1 中①所示.2DSSA的具体处理步骤为: 给定一幅尺寸为W ×H 的灰度图像I ,2DSSA首先确定一个大小为u ×v 的嵌入窗口,该窗口通常远小于图像的大小.然后,将该窗口在图像上进行步长为1的滑动,滑动方向为从左到右、从上到下.在不同位置处,嵌入窗口内的像素都被拉伸为列向量 V i , j ∈ R u v M

Novel two-dimensional singular spectrum analysis for effective feature extraction and data classification in hyperspectral imaging

2

2015

... 式中轨迹矩阵 M [21 ] .然后,对得到的轨迹矩阵进行SVD分解,可以得到轨迹矩阵多个子矩阵相加和的形式,将其写为: ...

... 式中: M 1 M 2 λ i u i v i i =1,2.根据2DSSA在图像中的应用[19 ,21 ] 可知, M 1 M 2 M 1 M 2 I t r e n d I d e t a i l

Assessing the accuracy of blending Landsat-MODIS surface reflectances in two landscapes with contrasting spatial and temporal dynamics:A framework for algorithm selection

1

2013

... 数据集1位于澳大利亚新南威尔士州南部的灌溉区(34.0034°E,145.0675°S)[22 ] ,包含2景Landsat7 ETM+影像和2景MODIS影像.这2对Landsat-MODIS卫星分别于2002年3月9日和2002年4月26日拍摄,覆盖范围为15 km×15 km,对应30 m空间分辨率Landsat影像的尺寸为500像元×500像元.该研究区是各种夏季作物的灌溉田,如水稻、玉米、高粱、大豆等,显示出高度异质性的景观.除了自然物候变化外,该区域的其他土地覆盖的多样性、复杂性、异质性和由人类活动引起的巨大时间变化产生了很高的空间和时间差异,这使得该地区的时空融合比正常测试地区更难解决,相应的近红外-红光-绿光假彩色图像如图2 所示. ...

一种基于非局部滤波的遥感时空信息融合方法

1

2015

... 另外,在2DSSA-STFM模型中,2DSSA的嵌入窗口大小设置为10×10,以满足最佳的图像分解要求.在1.2节趋势项预测中,采用9×9大小的搜索窗口,在窗口中选择与中心像元最相似的前20个像元进行加权,以方便搜索更加相似的像素.在1.3节的细节项预测中,搜索窗口大小设置为31×31,选取前50个最相似的像元,以获取更加丰富的细节信息[23 ] . ...

一种基于非局部滤波的遥感时空信息融合方法

1

2015

... 另外,在2DSSA-STFM模型中,2DSSA的嵌入窗口大小设置为10×10,以满足最佳的图像分解要求.在1.2节趋势项预测中,采用9×9大小的搜索窗口,在窗口中选择与中心像元最相似的前20个像元进行加权,以方便搜索更加相似的像素.在1.3节的细节项预测中,搜索窗口大小设置为31×31,选取前50个最相似的像元,以获取更加丰富的细节信息[23 ] . ...