0 引言

大闸蟹是我国的一大典型经济作物,其具有可观的经济收益和庞大的消费市场。据中商产业研究院《2020年大闸蟹行业市场规模及产业布局情况分析》,2019年大闸蟹产业规模突破亿元,年增速约20%,且2020年我国大闸蟹市场规模或将接近1 500亿元。与此同时,据中国渔业统计年鉴数据显示,随着人工养殖技术的成熟和养殖规模的壮大,2019年我国大闸蟹养殖产量达77.87万t,2020年产量增至80.6万t,同比增长3.51%。因此,大闸蟹已成为养殖行业的重要经济作物之一。然而,由于蟹塘占地面积广、养殖环境要求苛刻等原因,现有耕地上挖塘养蟹行为日益增多,这不仅对耕作层造成破坏,而且会导致地区粮食产量下滑,妨害耕地可持续发展,对地区粮食产量与安全产生不良影响。因此,利用遥感影像对违规养蟹行为进行实时监测监管,是解决耕地变更蟹塘这一“非粮化”[1⇓-3]问题的重点与难点。

目前,基于遥感影像进行地物检测的传统手段主要有基于像元和面向对象2类方法[4⇓⇓⇓-8],二者的实质均为通过提取目标地物的纹理、波段、物候等特征来分割特定的地物目标。然而,传统监督分类方法存在着同谱异物与同物异谱[9-10]等问题,且当目标存在混合像元等复杂特征时,识别精度下降明显,检测效果较差。而深度学习作为近年来比较热门的研究方法,其在遥感影像的地物判读中已经有了广泛的应用[11⇓⇓⇓⇓-16],且其精度和速度均高于传统解译方法。然而,由于样本质量参差不齐以及模型结构自身的局限性,神经网络检测出来的结果往往存在误差,具体表现为误判、漏判和图斑形状异常等,使得网络的检测结果必须经过人工核查才能投入使用。但在影像图幅较大的情况下,核查会因图斑数量庞大而耗费较多的人力和时间,这使得整个监测流程的效率下降。因此,为应对传统遥感智能解译工作中存在的人工判读量大、核查效率不足的挑战,亟需提出一种新的监测识别方法,在引入人工核查机制的同时兼顾人工判读效率,提高整个监测流程的速度和精度。

1 研究方法

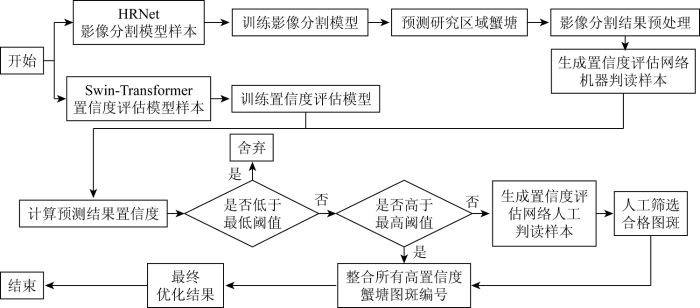

本研究以存在大面积蟹塘的江浙地区为研究区域,提出了一种基于协同判读机制的蟹塘遥感智能检测方法: 首先基于研究区域内的蟹塘影像构建蟹塘样本,作为蟹塘影像分割网络HRNet和置信度评估网络Swin-Transformer的训练数据; 继而借助已训练完成的HRNet模型对整体研究区域中的蟹塘地块进行检测,并优化检测结果。为解决误检、漏检等产生的错误地块识别问题,创新性地提出了利用Swin-Transformer模型计算通过HRNet模型检测得到的蟹塘地块的置信度评估数值,并构建针对蟹塘地块进行判别的人机协同判读机制。人机协同判读机制是指先由机器进行自动判读分类,分出确切地块和模糊地块,再由人工对被分为模糊地块的部分进行核查的机制。基于蟹塘置信度评估数值与蟹塘筛选阈值,精确区分确切地块和模糊地块,降低人机交互时间成本,最后利用筛选出的蟹塘地块对初始检测结果进行优化,得到准确的蟹塘识别结果。方法的总体流程如图1所示。

图1

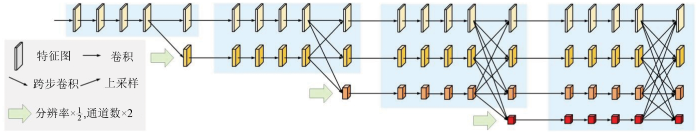

1.1 影像分割网络HRNet

为确保高分辨率蟹塘影像的分割精度与效率,选择语义分割网络HRNet作为影像分割网络。HRNet是目前最为先进的语义分割网络之一,其精度在COCO数据集中的关键点检测、姿态估计和多人姿态估计这3项任务中都刷新了纪录,拥有着巨大的潜力。该网络能在整个任务过程中都保持高分辨率,通过不同分辨率的分支自信息融合以减少随着网路的加深而造成的信息损失。

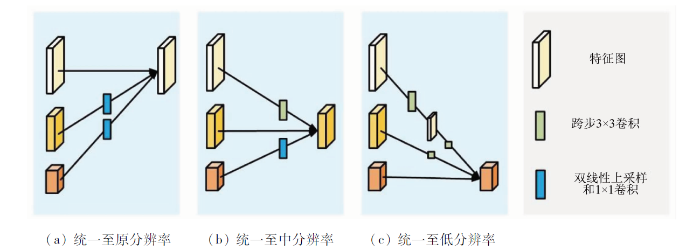

图2

图3

本文使用HRNet网络所生成的影像分割模型对研究区域内的蟹塘进行检测,以得到一个初步的蟹塘识别结果。

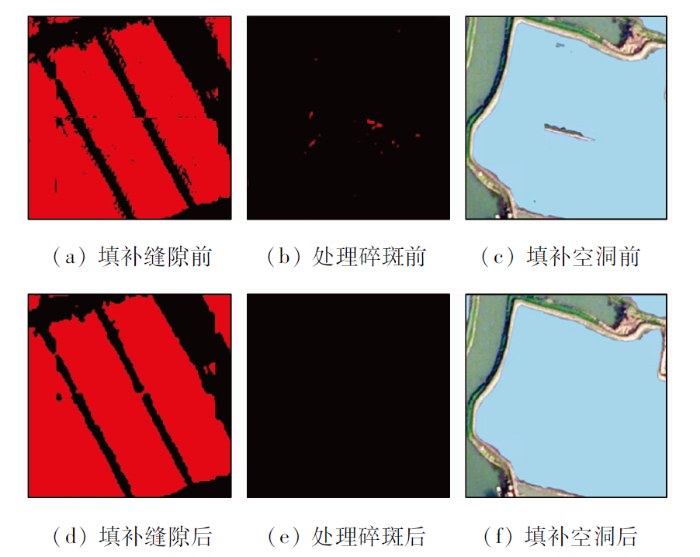

1.2 检测结果预处理

由于影像分割模型精度不能达到百分之百,识别结果通常会存在少量误判、漏判甚至图斑形状异常等问题,此外,整幅影像在检测过程中经过了裁剪和拼接,这使得检测结果还会存在拼接缝隙和碎斑。因此,需要对影像分割的检测结果进行初步的优化,优化过程分为缝隙填充、碎斑处理和空洞填补。

空洞填补是对转为矢量图层后存在空洞的图斑进行填补,找出图斑内部存在的岛并对其进行填充,即可获得形状完整的蟹塘地块。

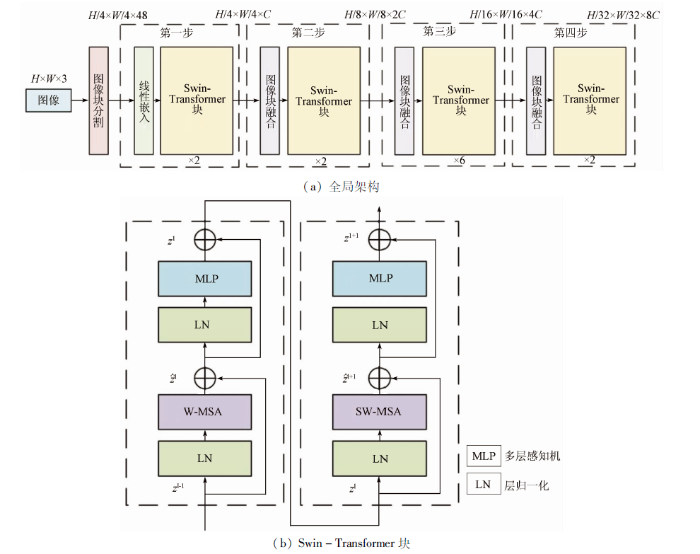

1.3 置信度评估网络Swin-Transformer

Swin-Transformer网络结构如图4所示。

图4

由于影像光谱特征、分辨率和地貌谱系的多样性等因素影响,识别出的蟹塘地块往往精度不一,顾及蟹塘监测监管的时效性与精度要求,需提高深度学习模型检测结果的置信度标准,因此集成置信度评估网络Swin-Transformer,检测每个蟹塘地块的置信度数值,并将置信度高的地块图斑作为地类明确的确切图斑,将置信度低的作为模糊图斑,以优化HRNet模型检测结果。

在全局架构中,Swin-Transformer网络首先用Patch Partition将输入的图像分切成没有重叠的图像块,并通过线性嵌入将分块后的图像映射到指定维度; 继而基于图像块融合模块联结相邻的图像块,实现降采样的过程,最后通过Swin-Transformer块实现多头注意力机制,提取每个的特征。

在Swin-Transformer块中,W-MSA模块主要将计算区域控制在每个当前窗口之内,以确保计算的低时间复杂度,提高网络的整体计算效率; SW-MSA模块则负责在控制窗口数量的情况下,增加各个窗口间的信息交流,弥补了W-MSA模块因窗口不重合从而缺乏信息交流的缺陷。

利用Swin-Transformer网络良好的分类性能,对HRNet网络检测出的每个蟹塘地块结果输出一个置信度数值,置信度越高,对应地块为蟹塘的可能性越大。

1.4 模型精度评价指标

为了评价蟹塘检测模型的精度,采用准确率A、精确率P、召回率R与F1系数作为初步评价模型的检测精度指标。

准确率为被正确分割的样本数与所有样本数之比,其计算公式为:

式中:

精确率为检测为正样本的数量与其中真正为正样本的数量之比,反映了模型“找得对”的能力,其计算公式为:

召回率为检测为正样本的数量与总体正样本的数量之比,反映了模型“找得全”的能力,其计算公式为:

F1系数为精度和召回率的调和平均数,是评价模型性能的重要指标,其计算公式为:

1.5 构建人机协同判读体系

在获得所有蟹塘检测结果图斑的置信度

2 研究区及样本获取

2.1 研究区域概况

江浙地区具有水网密集、耕地破碎、蟹塘养殖面积大等特征。截至2020年,全国蟹塘养殖面积已超4 600 km2,而江浙沪地区的占比达到70%,已经成为国内养蟹较为集中的区域。作为江浙一带的养蟹大区,江苏省南京市高淳区拥有大面积的养殖蟹塘。高淳区位于E118°41'~119°21',N31°13'~31°26'之间,地处长江流域中下游,整体地势平坦,淡水资源丰富,辖区内拥有多个河流与湖泊,已形成较具规模化的螃蟹养殖产业。本研究采用了2021年江苏南京市高淳区的高分辨率遥感影像,空间分辨率为0.3 m,如图5所示。可以看到,该区域具有大规模的蟹塘,且蟹塘呈现沿河网聚集状分布,因此本研究区域具有典型性。

图5

2.2 样本制作

本研究涉及样本主要包括: ①HRNet模型样本; ②Swin-Transformer模型样本; ③人工判读样本。为确保模型的检测精度,在进行样本制作之前,需对遥感影像进行大气校正、几何纠正和图像融合等预处理,消除影像中的辐射失真和几何畸变。待预处理完成后,方可进行样本制作。

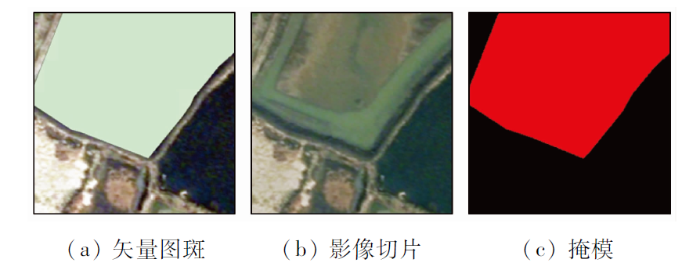

2.2.1 HRNet模型样本

图6

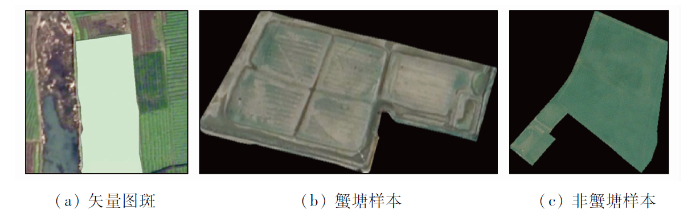

2.2.2 Swin-Transformer模型样本

Swin-Transformer模型样本分为训练样本和机器判读样本,其中,训练样本用于训练Swin-Transformer模型。首先,对与蟹塘纹理相近的地块进行了勾画,生成了矢量非蟹塘图斑(图7(a))。然后,用这些矢量非蟹塘图斑与HRNet模型训练样本制作过程中生成的矢量蟹塘图斑分别对影像进行依边界裁剪的掩模提取,生成黑色为背景、实际影像为地物的无统一大小的影像切片(图7(b)—(c))。最后,将蟹塘和非蟹塘的影像切片按4∶1的比例分为训练集和验证集,且蟹塘为正样本、非蟹塘为负样本,此时一套完整的Swin-Transformer模型训练样本制作完成。基于上述流程,本文共生成了7 000张Swin-Transformer模型训练样本,其中蟹塘样本为5 000张,非蟹塘样本为2 000张,训练集和验证集分别为5 600张和1 400张。

图7

而机器判读样本则是根据HRNet模型的检测结果进行制作的,用于对HRNet模型的检测结果图斑置信度进行评价。机器判读样本的制作流程与训练样本相同,区别在于所使用的矢量图斑为HRNet模型的检测结果图斑。此外,机器判读样本的命名中带有对应的图斑编号,旨在与检测结果图斑和下文所使用的人工判读样本进行关联。

2.2.3 人工判读样本

人工判读样本是针对Swin-Transformer检测结果中属于模糊地块的图斑设计的,旨在融合图斑所属地块附近的上下文背景信息,以方便人工判读。首先,根据Swin-Transformer检测结果中属于模糊地块的图斑编号,找到对应的矢量图斑; 然后,根据这些对应的矢量图斑,分别计算其最小外接矩形,并对其进行边界系数扩张,得到扩大后的外接矩形框; 最后,根据这些外接矩形框对影像进行裁剪,并根据图斑轮廓对影像进行地块边界绘制,生成对应的人工判读样本(图8)。人工判读样本保留了更多地块周边上下文信息,有利于人工判读时进行广泛取证、迁移推理以辅助人工判别地块类型。

图8

3 结果与分析

3.1 影像分割模型训练与结果

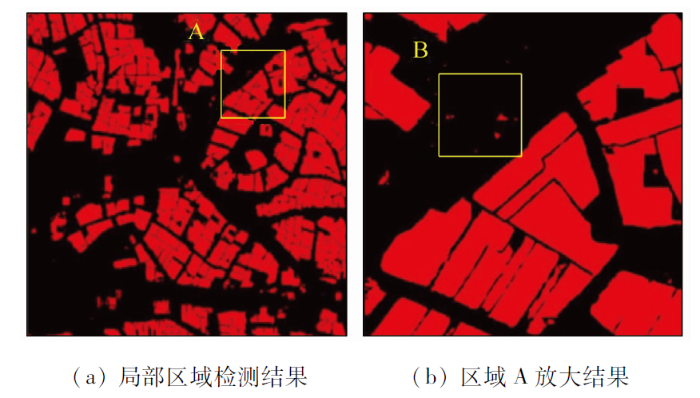

本研究利用深度学习语义分割网络HRNet对研究区域内的蟹塘进行模型训练解译。基于PyTorch深度学习框架,搭建并运行HRNet深度学习网络。所有训练数据及分割代码均部署在一台Linux服务器上,该服务器的系统为Ubuntu16.04.4,处理器为Core i7-8700k,内存为32 GB,显卡版本为GTX2080Ti-12 GB。模型训练过程中,设置优化器为SGD,初始学习率为1×10-3,迭代次数epoch为200次,其中学习率自适应于迭代次数,即随着迭代次数增加,学习率逐渐递减并最终归0。基于构建的分割模型,最终获得2021年高淳区蟹塘检测结果,如图9所示。HRNet模型可以准确分割出遥感影像中的蟹塘地块,模型准确率与F1系数较高,达到了0.827和0.852,精确率和召回率分别为0.837和0.867,分割效果较好。然而,由于蟹塘特征复杂以及曝光等成像因素影响,出现部分识别的蟹塘超出地块边界以及耕地/水域被错误识别成碎块蟹塘的情况(图9(b)区域B)。这些误判会降低蟹塘检测精度,对后续“非粮化”指标计算带来负面影响。

图9

图9

HRNet模型蟹塘检测部分结果

Fig.9

Partial results of crab pond prediction of HRNet model

为消除因分割产生的地块拼接缝、碎斑以及空洞等问题,在HRNet初步检测结果后介入拼接缝填补(闭运算)、碎斑处理(开运算)与空洞填补等优化措施。图10(a)、(b)、(d)、(e)分别展示了经形态学开闭运算前后的检测掩模对比,此处所使用的卷积核大小为3×3。可以看到,经过形态学开闭运算操作后,大部分的拼接缝隙被有效填补,地块碎斑也得到了去除,蟹塘地块的拓扑结构得到有效维持与修复,且地块原本的形状并未发生改变。此外,拼接缝的填补也使得蟹塘掩模及图斑边界毛刺减少,蟹塘规则性得到保持。图10(c)和(f)为填补矢量图斑空洞前后的结果,利用矢量图斑的拓扑关系将其中的岛全部进行填补,得到填补的矢量图斑能够实现对地块的全覆盖。

图10

3.2 置信度评估模型训练与结果

考虑到蟹塘检测的海量数据与时效性,借助Swin-Transformer深度学习模型,通过训练测试,对HRNet模型检测得到的蟹塘图斑进行检测判读,筛选出确定为蟹塘/非蟹塘的地块。在训练的过程中,设置优化器为Adam,初始学习率为1×10-3,迭代次数epoch为200次。

表1列出了Swin-Transformer模型检测的蟹塘地块精度。其中HRNet模型共计检测得到蟹塘图斑数量为18 471,依据蟹塘筛选阈值可自动化判别出的蟹塘、非蟹塘和模糊地块的数量分别为11 191,4 212和3 068,其中,在判别为蟹塘的图斑中实际为蟹塘的图斑数量为10 464,判别精确率为0.935; 在判别为非蟹塘的图斑中实际为非蟹塘的图斑数量为3 862,判别精确率为0.917; Swin-Transformer模型准确判别出的蟹塘/非蟹塘数量为14 326,模型准确率为0.930; 此外,模型的精确率为0.935,召回率为0.967,F1系数可达到0.941。上述结果表明,Swin-Transformer模型可以有效区分指定阈值下的蟹塘与非蟹塘地块,且模型整体精度较好,表现较优; 此外,此方法能够自动筛选掉83.4%确定图斑,仅剩余16.6%需介入人工判读,也从侧面表明借助Swin-Transformer网络的自动判别,可以大幅减少需人工判别的蟹塘/非蟹塘图斑数量,提升大尺度范围内的目视判别效率。

表1 Swin-Transformer模型检测蟹塘地块精度

Tab.1

| 分类结果 | 真实类别 | 总计 | |

|---|---|---|---|

| 蟹塘 | 非蟹塘 | ||

| 蟹塘 | 10 464 | 727 | 11 191 |

| 非蟹塘 | 350 | 3 862 | 4 212 |

| 总计 | 10 814 | 4 589 | 15 403 |

| 准确率 | 0.930 | ||

| 精确率 | 0.935 | ||

| 召回率 | 0.967 | ||

| F1系数 | 0.941 | ||

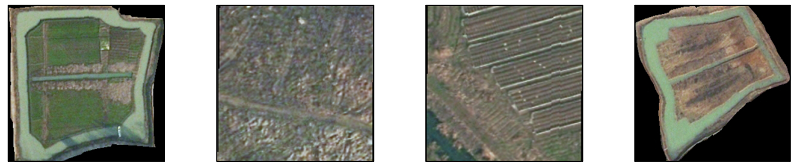

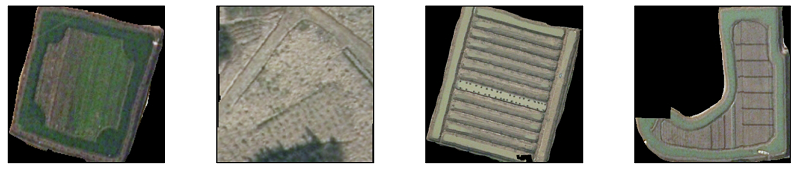

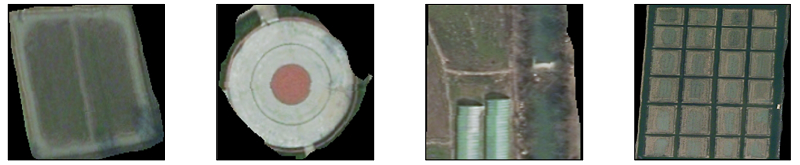

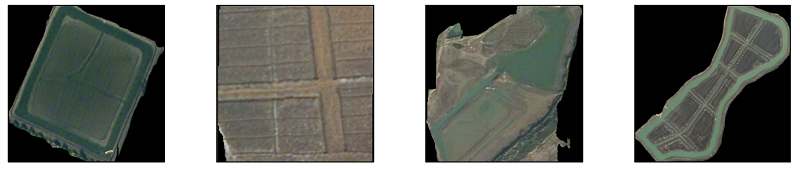

基于Swin-Transformer模型推理蟹塘的结果如表2所示。其中第1列为正确检测出的蟹塘地块,这些地块均为纹理清晰、具有典型特征的完整蟹塘地块; 第2列为正确检测出的非蟹塘地块,可以看出,对于耕地(第2列1,2,4行)与水工建筑(第2列3行)等与蟹塘具有明显区别的非蟹塘地块,均能够准确检测; 第3列为检测错误的蟹塘地块,错误情形主要发生在与蟹塘内陆地纹理相近的耕地地块(第3列1,2行)、水陆交融图斑(第3列3,4行)中,这些地块特征与蟹塘特征较相似,容易对蟹塘影像的智能判读产生负面影响; 第4列为检测错误的非蟹塘地块,该类地块主要受到地块规则与色相,与常见的蟹塘地块特征存在些许差异,导致Swin-Transformer模型将之划分为非蟹塘。

表2 Swin-Transformer模型推理结果

Tab.2

| 序号 | 预测正确的蟹塘地块 | 预测正确的非蟹塘地块 | 预测错误的蟹塘地块 | 预测错误的非蟹塘地块 |

|---|---|---|---|---|

| 1 |  | |||

| 2 |  | |||

| 3 |  | |||

| 4 |  | |||

针对基于蟹塘阈值筛选出的模糊图斑,需进一步采用人工判读,确定模糊图斑的具体归属类别。为此,设计了一套协同多任务判读系统,可辅助人工判读。借助该系统,人工判读的分类效率可达1 000~1 200张/h,同时能够有效改善传统判读过程中“找图斑、等加载、填属性”等效率较低的限制。经人工应用总结,在保障判读严肃性、严谨性的前提下,对模糊图斑而言,按照本实验检测出的3 068个模糊图斑,仅需1人在3 h内即可完成判读,判读效率大幅提升。经人工判读后,筛去563张非蟹塘图斑,保留2 505张蟹塘图斑。

综合上述实验结果,人机协同判读共筛去4 775张非蟹塘图斑,保留了13 696张蟹塘图斑,在以图斑为单位的情况下,检测准确率由0.721提升到了0.972(表3)。可见,本文提出的基于协同判读机制的蟹塘遥感智能检测方法,可有效提高监测效率,确保蟹塘监测监管的有效性。

表3 人机协同判读前后精度变化

Tab.3

| 指标 | 人机协同判读前 | 人机协同判读后 |

|---|---|---|

| 蟹塘图斑数 | 18 471 | 13 696 |

| 非蟹塘图斑数 | 0 | 4 775 |

| 实际蟹塘图斑数 | 13 319 | 13 319 |

| 准确率 | 0.721 | 0.972 |

3.3 应用分析

基于上述理论与试验,对整个高淳区进行蟹塘检测及二次判别筛选,结果如图11所示。可以看出,经Swin-Transformer模型判别与人工判读后,蟹塘识别精度得到有效提升,且规则性与边界拓扑效果更好。经统计,研究区域内的蟹塘总面积约为985.445 km2,通过套合三调数据,耕地总面积约为960.687 km2,其中被蟹塘占用的耕地面积约为18.192 km2,占比约1.9%,表明高淳区未出现大规模挖塘养蟹等“非粮”行为,并且未对当地耕地造成破坏。

图11

4 结论

为开展对蟹塘的遥感智能解译工作,并应对工作后期存在的人工判读量大、核查效率不足的挑战,实现遥感智能化监测的实时动态开展,本研究创新性地提出一种基于协同判读机制的蟹塘遥感智能检测方法,通过HRNet深度学习模型初步检测蟹塘地块,初步检测结束后借助Swin-Transformer模型得到检测蟹塘地块的置信度数值,最终通过人机协同判读机制完成对蟹塘地块的二次筛查。

通过对1景高淳区遥感影像进行语义分割与图像分类,蟹塘识别的总体精度可以达到0.972,研究试验表明,通过Swin-Transformer模型的分类筛查与人工核查,能够快速、有效和精准地识别大范围区域内蟹塘等典型“非粮化”地物,自动判别比例高达83.4%,能够大幅减少人工判别的样本数量,提高整体的目视判别效率。

本研究提出的基于协同判读机制的蟹塘遥感智能检测方法能够有效提高蟹塘的识别效率,降低人工核检的工作量,为提高此类耕地“非粮化”行为的检测速度和精度提供了一种新的思路和方法。然而,本研究也存在一些不足之处,譬如仅对发生误判的图斑进行了去除,而对于漏检的图斑则依然需要进行人工勾画填补,因此下一步拟探寻新的修正机制,进一步提升整个业务流程的效率和可行性。

参考文献

耕地流转中过度“非粮化”倾向产生的原因与对策

[J].

The causes and countermeasures on the excessive “non-food” tendency in the process of land transfer

[J].

耕地流转中的“非粮化”问题与对策建议

[J].

The non-grain problem in the process of land transfer and the countermeasures

[J].

农地流转过程中的“非农化”、“非粮化”辨析

[J].

Distingushing “non-agriculturalization” and “non-grainification” in the process of rural land transfer

[J].

一种面向对象的像元级遥感图像分类方法

[J].

A hybrid model of object-oriented and pixel based classification of remotely sensed data

[J].DOI:10.3724/SP.J.1047.2013.00744 URL [本文引用: 1]

高分辨率遥感影像智能解译研究进展与趋势

[J].

Research progress and trend of high-resolution remote sensing imagery intelligent interpretation

[J].DOI:10.11834/jrs.20210382 URL [本文引用: 1]

Object based image analysis for remote sensing

[J].DOI:10.1016/j.isprsjprs.2009.06.004 URL [本文引用: 1]

A review of supervised object-based land-cover image classification

[J].DOI:10.1016/j.isprsjprs.2017.06.001 URL [本文引用: 1]

遥感图像分类方法综述

[J].

A survey of remote sensing image classification methods

[J].

基于形状参数的遥感图像“同谱异物”目标区分

[C]//

Shape-based classification of “spectral similar” objects in remote sensing image processing

[C]//

遥感图像自动解译面临的问题与解决的途径

[J].

The problem and approach in the auto-interpretation of remote sensing imagery

[J].

基于深度学习的高分辨率遥感影像土地覆盖自动分类方法

[J].

DOI:10.12082/dqxxkx.2021.200795

[本文引用: 1]

土地覆盖变化是全球变化研究的核心,而精准分类是开展土地覆盖变化研究的基础。高分辨率遥感卫星技术的快速发展对地表分类的速度和精度提出了双重挑战,近年来人工智能等新技术的发展为图像自动分割提供了实现途径,而以卷积神经网络为代表的深度学习方法在遥感图像分类领域也具有独特的优势。为对比深度学习模型设计对高分辨率图像分类结果的影响,本文以郑州市2019年高分1号影像作为输入,对比研究了基于UNet模型改进的4种不同深度学习网络模型在高分辨率影像土地覆盖自动分类应用中的差异,探讨了残差网络、模型损失函数、跳层连接和注意力机制模块等编码和解码设定对于分类精度的影响机制。研究发现:同时加入多尺度损失函数、跳层连接和注意力机制模块的MS-EfficientUNet模型对郑州市土地覆盖分类结果最优,基于像元评价的整体分类精度可达0.7981。通过在解码器中引入多尺度损失函数可有效提高林地、水体和其他类别的分类精度;而对编码器进行改进,加入跳层连接和注意力机制可进一步提高草地、水体和其他类别地物的分类精度。研究结果表明,深度学习技术在高分辨率遥感影像自动分类中具有潜在应用价值,但分类结果精度的进一步提高和多级别大范围的精细分类方法仍是下一步研究的重点。

Automatic deep learning land cover classification methods of high-resolution remotely sensed images

[J].

结合高光谱像素级信息和CNN的玉米种子品种识别模型

[J].

Variety identification model for maize seeds using hyperspectral pixel-level information combined with convolutional neural network

[J].DOI:10.11834/jrs.20219349 URL [本文引用: 1]

Deep learning for remote sensing data: A technical tutorial on the state of the art

[J].DOI:10.1109/MGRS.2016.2540798 URL [本文引用: 1]

一种轻量级的DeepLabv3+遥感影像建筑物提取方法

[J].

Lightweight DeepLabv3+ building extraction method from remote sensing images

[J].

多尺度特征增强的遥感图像舰船目标检测

[J].

Ship detection based on multi-scale feature enhancement of remote sensing images

[J].

结合空间约束的卷积神经网络多模型多尺度船企场景识别

[J].

Multi-model and multi-scale scene recognition of shipbuilding enterprises based on convolutional neural network with spatial constraints

[J].

Deep high-resolution representation learning for human pose estimation

[C]//

Swin transformer: Hierarchical vision transformer using shifted windows

[C]//

数学形态学在图象处理中的应用进展

[J].

The advances of mathematical morphology in image processing

[J].

数学形态学在作物病害图像处理中的应用研究

[J].

Application research of mathematical morphology in image processing of crop disease

[J].

A fast arithmetic for the erosion and dilation operations of mathematical morphology

[J].

Attention is all you need

[C]//