0 引言

目前,混淆矩阵作为语义分割模型性能评价的重要工具,作为高级统计指标的标准输入[4],计算准确率、精确率、召回率和F1 Score等各种评价指标,从而绘制ROC曲线和CAP曲线等,更全面地评价和比较语义分割模型的性能。国内外学者将形态轮廓(morphological profiles,MPs)、微分形态剖面(differential morphological profiles,DMPs)、马尔可夫随机场(Markov random field,MRF)、局部二进制模式(local biary pattern,LBP)、像素形状指数(pixel shape index,PSI)、对象相关指数(object correlative index,OCI)和形状大小指数(shape size index,SSI)等方法用于影像分类精度的评价[5]。Zhang等[6]提出了一种基于光谱相似性的图像对象的属性OCI,来描述分类结果的空间特征; 段嘉鑫[7]提出了图像分割结果的逐像素误差谱的概念,通过解码器预测细粒度的分割结果误差谱,实现了分割结果的局部质量信息获取,以及像素级的分割质量评价; 党宇[8]以图幅为评价基本单元,对单一地类图斑评价有效性及混合图斑的评价策略进行研究及实验验证; 郑明国等[9]将包括目标语义信息和地学先验知识的地学知识嵌入遥感影像深度语义分割引导网络训练,以提高分割结果的可解释性和可靠性。从国内外的研究现状来看,顾及地学特征的深度学习语义分割模型性能评价的方法研究较少,性能评价维度缺少空间关系特征,尚难以有效支撑时空异质的遥感影像语义分割结果的评价,主要问题表现在2个方面: ①评价对象是像素粒度,像素只关注最低层次的局部特征信息,无法满足高层次面向目标对象的遥感地物解译需求; ②评价准则是像素分类是否正确,没有考虑到空间位置因素的影响,无法直接反映预测结果在空间几何特征上的保持情况。

遥感影像智能解译是遥感应用落地的核心和关键技术,而语义分割性能的准确评价是实现遥感影像智能解译的基础[10⇓⇓-13]。性能评价体系应满足像素和对象等不同层级的需求,遵循位置精度与逻辑完整性准则[14⇓-16]。本文从时空异质遥感解译和测绘生产的角度出发,在分析现有模型评价体系的基础上,提出一种顾及地学特征的遥感影像语义分割模型性能评价方法——连通相似性指数(connectivity similarity, CSIM),在充分考虑像素归类是否正确的基础上,以连通图斑(即像素群)为粒度,聚焦空间位置和空间关系,以真实标签和预测标签的连通序列相似程度来进行语义分割性能评价,以期为模型训练的实时监测、预训练模型的最优选择和遥感影像预测结果的质量评价提供可靠的技术支持。

1 模型性能评价问题分析

表1 常用评价指标

Tab.1

| 指标 | 意义 |

|---|---|

| 准确率 | 正确预测的样本占总样本的比例 |

| 精确率 | “正确被预测为正”占所有“实际被预测为正”的比例 |

| 召回率 | “正确被预测为正”占所有“应该被预测为正”的比例 |

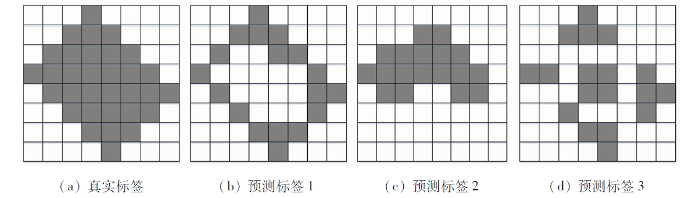

图1

图1

真实标签和预测标签对比示意图

Fig.1

Comparison chart between real label and predicted labels

表2 预测标签评价指标结果

Tab.2

| 指标 | |||

|---|---|---|---|

| 准确率 | 0.78 | 0.78 | 0.78 |

| 精确率 | 1 | 1 | 1 |

| 召回率 | 0.56 | 0.56 | 0.56 |

2 CSIM设计

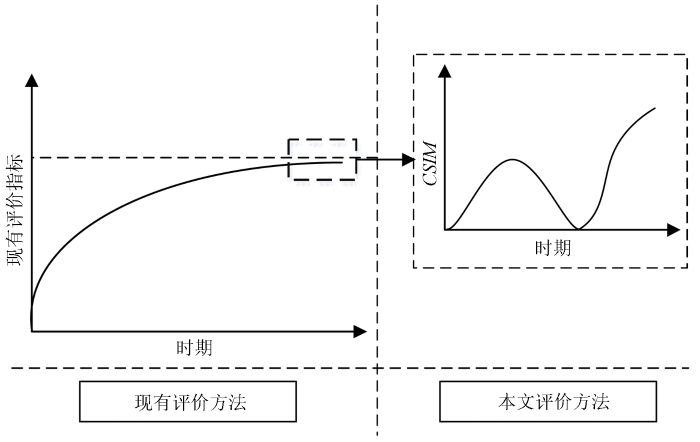

本文的目的是针对语义分割模型预测遥感影像,探索出一种评价预测标签真实质量的方法,并非是要替代现有的评价指标体系,所以本文在现有的评价体系中增加图斑连通相似性评价,以期在现有的评价指标无法区分的区间进一步提高对遥感解译质量的辨识度,实现性能评价指标值与主观质量分数保持一致。CSIM计算数据输入为模型的预测标签和真实标签,数据输出为连通相似性指数。其方法流程包括连通图斑特征提取、连通序列空间校准、连通序列相似度评价和连通相似性指数计算。图2显示了现有评价方法和CSIM指标值对比,随着训练时期的推移现有评价指标难以体现出性能差异,在训练末期,CSIM指标差异性明显,可以有效地评价语义分割性能。

图2

2.1 连通图斑特征提取

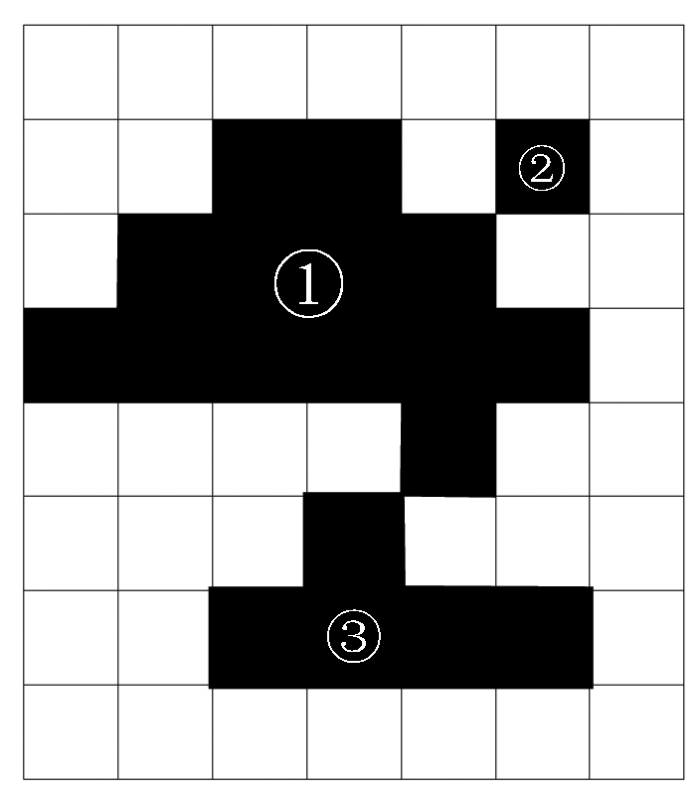

本文定义真实标签与预测标签中水平或垂直方向上像素值相同的相邻像素集合为连通图斑。连通图斑识别采用四邻域两遍扫描法,由左向右、由上向下对真实标签和预测标签进行逐行扫描搜索,将同一连通区域的所有像素点标记同一连通索引值,扫描完成输出一个标记所有连通图斑像素集合的连通序列。图3为连通图斑示意图,图中①,②,③均为连通图斑。

图3

连通图斑的特征有2类表示方法: 一类是区域特征,一类是轮廓特征。其中区域特征采用区域内像素总数量来定量描述; 轮廓特征主要针对图斑的内外边界。经过逐一对连通图斑的特征提取,最后输出记录所有连通对象特征信息的真实标签连通序列A和预测结果连通序列集合B。其中真实标签连通序列

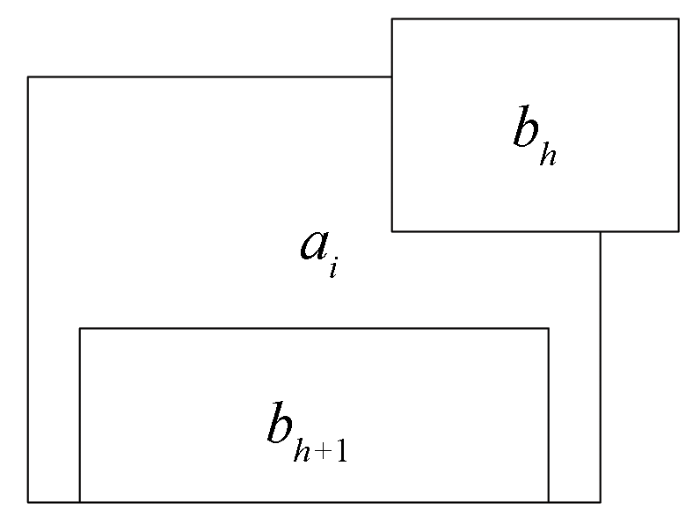

2.2 连通序列空间校准

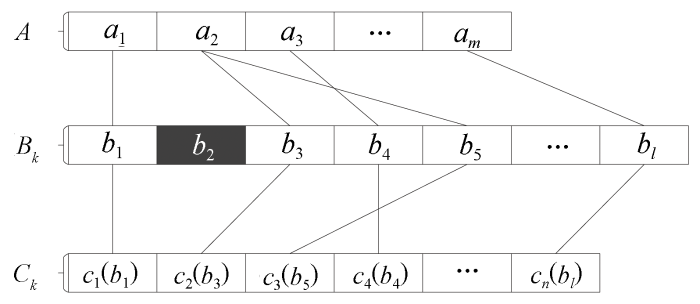

连通图斑的识别方式为逐行扫描,因此连通序列的存储顺序是基于连通图斑的识别先后顺序,这就导致真实标签的连通序列A和预测标签的连通序列Bk中的顺序难以保持近似的对应关系。为了保证连通序列A和

图4

按照此方式,就可以依次建立连通序列A与Bk的空间关联,并按照A序列顺序重组得到连通序列

图5

2.3 连通序列相似度评价

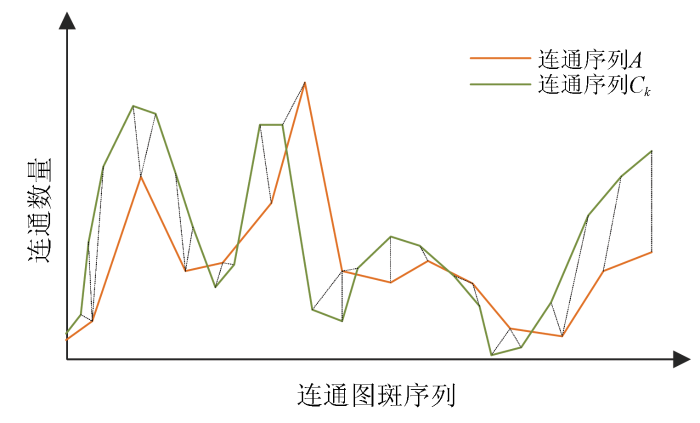

在连通序列中,需要比较相似性的2个连通图斑的区域特征指标一般都不相等,不同连通序列可能存在连通图斑序列轴上的位移,亦即在还原位移的情况下,2个连通序列是一致的。考虑到这些复杂情况,本文通过把连通图斑序列进行延伸和缩短,在连通图斑序列轴上进行局部的缩放和对齐,使其形态姿势保持相对一致性,从而计算2个连通序列的相似性。

图6的2条实线代表2个语义分割模型对同一景遥感影像预测标签的连通序列,连通序列之间的虚线代表2个连通区序列之间的相似的点。2个连通序列在形态上非常相似,但是这些形态特征点(波峰、波谷)在时间上不能一一对齐。如果使用类似欧氏距离的常规方法来计算2个序列的相似性,无法符合实际认知。通过对连通图斑序列进行匹配性的伸缩变形,匹配效果会大幅度增强。本文采用动态连通区规整算法,算法在匹配2个序列时,序列中的点不再是一一对应关系,而是一对一、一对多和多对一等不同映射关系。算法的核心在于基于动态规划匹配连通序列,使得序列相似点之间的距离和最小。该距离即归整路径距离,用于衡量2个连通序列之间的相似性。

图6

真实标签连通序列

1)构建一个m×n的相似性矩阵网格

2)定义搜索起点为

3)重复以上步骤,直至完成从矩阵要素起点

2.4 CSIM计算

CSIM计算是将所有预测标签对应的连通序列相似度归一化整合,映射到同一尺度下。本文采用最值归一化方法将连通相似度集合中的数据映射到0~1之间。该方法虽然受边界影响较大,但归一化的值具备较高的辨识度,符合本文预期目的,其计算方法为:

式中: dk为第k个预测标签的连通序列相似度值; dmin和dmax分别为所有预测标签的连通序列相似度的最小值和最大值;

3 实验分析

3.1 实验数据

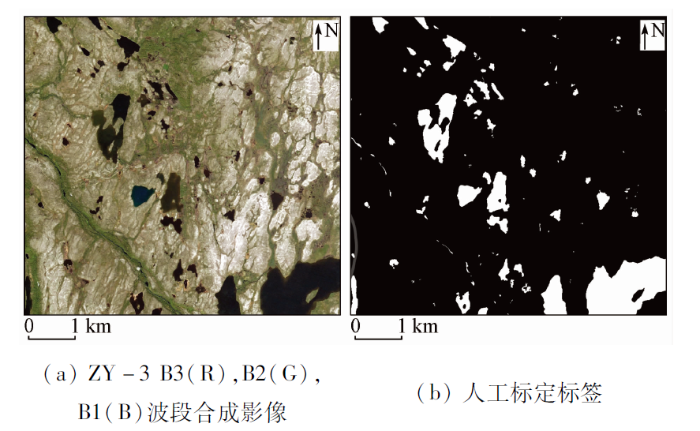

为了验证顾及地学特征的遥感地物图斑连通相似性评价体系应用于语义分割性能评价的可行性,实验选取具备几何结构多样性和尺度差异性的水体作为研究对象,实验数据来源于全球测图工程项目的芬兰西北片区,影像源为资源三号(ZY-3)影像,空间分辨率为2 m。时相为2019年6月24日,光谱可见光波段为红光、绿光和蓝光。由于实验涉及模型训练和模型评估2部分,因此实验数据样本包括训练样本、验证样本和测试样本。从目标影像上分别裁剪10幅 5 000像素×5 000 像素大小的影像切片,其中7幅作为训练样本,2幅作为验证样本,1幅作为测试样本。影像对应标签均来源于手工标定,其中测试图像与其真实标签如图7所示。

图7

3.2 实验流程

通过将实验区域的小样本数据集进行数据增强预处理,输入至卷积神经网络框架经过超参数调整循环训练输出一系列模型集合,应用本文提出的CSIM,对比现有精度评价指标,进行语义分割性能评价,选择适配于测绘实际生产的最优模型。

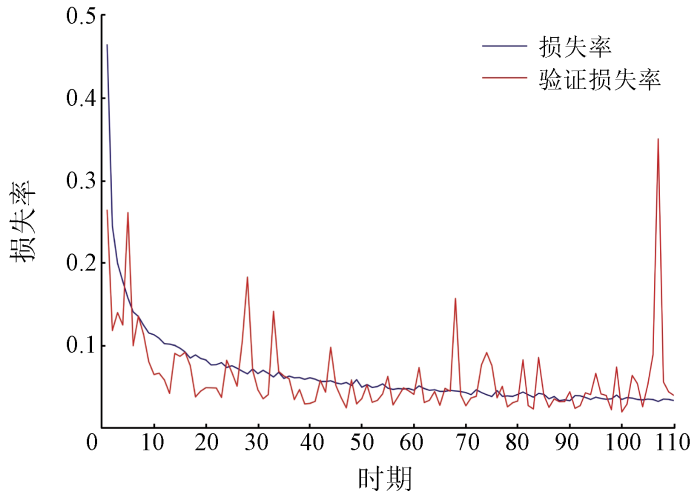

针对模型训练,实验搭建在TensorFlow深度学习框架平台上,基于残差学习机制的Res-UNet卷积神经网络,训练数据集、验证数据集和训练参数作为输入数据,输出数据为预训练网络模型和模型性能参数,经过循环迭代,通过判断输出模型的预测值f(x)与真实值Y的不一致程度,发送结束训练的信号。其训练参数设置如表3所示。由于卷积神经网络的拟合能力非常强,在训练数据集上的错误率降到最低时,容易造成模型过拟合,从而在验证数据集上的错误率会相对较高,本文希望获取一个最优泛化性能的网络模型。为了避免训练模型的过拟合状态出现,本文应用数据增强模式、Adam梯度下降优化算法和提早终止训练等方法来限制模型的复杂度。

表3 模型训练实验参数

Tab.3

| 参数 | 数值 |

|---|---|

| 样本数量/个 | 20 000 |

| 样本大小/像素 | 256×256 |

| 通道 | RGB 3通道 |

| 网络模型 | Res-UNet |

| 批尺寸/个 | 16 |

| 预设训练时期/次① | 200 |

①预设训练时期代表训练数据集中所有数据送入网络中,完成了一次前向计算+反向传播的过程。

针对模型评估,实验基于模型训练的输出成果集合,通过损失率和传统性能指标优先筛选出目标模型集合。遍历目标模型集合逐一预测测试影像,输出预测标签集合,应用本文提出的CSIM设计方法,识别每幅预测标签的连通图斑,对由于影像质量等其他因素带来的独立像素图斑进行过滤预处理操作,然后逐一与真实标签进行对比反演,归一化整合计算CSIM。为更好地验证语义分割性能评估的有效性,计算预测标签的现有精度指标,并进一步进行各类评价指标的数值分析。

3.3 实验结果及分析

图8

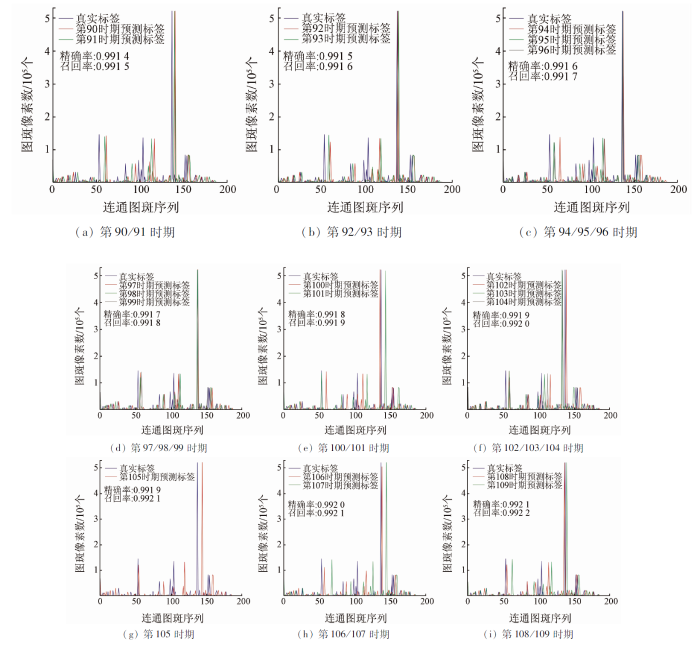

为了验证CSIM指标的有效性,模型评估实验选取第100时期前后连续10个时期的模型构成目标模型集合进行验证。图9展示以测试影像真实标签为参考基于空间地理位置匹配的准则,在训练数据集上相同精确率与相同召回率的不同模型的预测标签与真实标签的连通图斑集合对比情况。

图9

图9

不同时期模型预测标签连通图斑对比情况

Fig.9

Comparison of connected map spots in predicted label by models in different periods

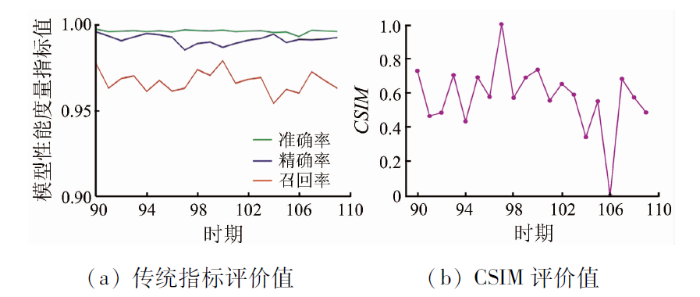

传统指标评价以像素为粒度,CSIM以像素群为粒度,两者在时间复杂度上保持一致。图9可以看出,不同时期模型预测标签连通图斑序列的表现与真实标签相比整体变化趋势比较相近,这也是精确率和召回率无法更好地判别语义分割性能差异性的验证。相似图斑出现的序列存在一定的差异性,差异性越小,越接近于期望模型。应用CSIM评估连通图斑的差异性,差异性表征CSIM指标归一化分布在[0,1],并与传统评价指标对比(图10)。图10(a)描述目标模型集合在准确率、精确率和召回率上的表现力,由于测试影像水体面积占比8.7%,背景值占比较大,而准确率计算同时考虑到背景值的预测情况,因此准确率平均高于精确率和召回率,集中分布在[0.993 2,0.997 7],精确率分布集中在[0.985 4,0.996 1],召回率集中分布在[0.953 9,0.979 0],召回率在第100时期和第104时期分别最大和最小,精确率在第90时期和第97时期分别最大和最小。图10(b)展示目标模型集合在CSIM表现力,归一化后指数区间分布均匀,第97时期指标值最大,表示该时期模型在测试影像上连通性表现最完整,而第106时期指标值最小,表示该时期模型在测试影像预测结果连通性表现相对来说差强人意。对比不同时期模型序列的现有指标和CSIM,两者结果呈现弱相关性。

图10

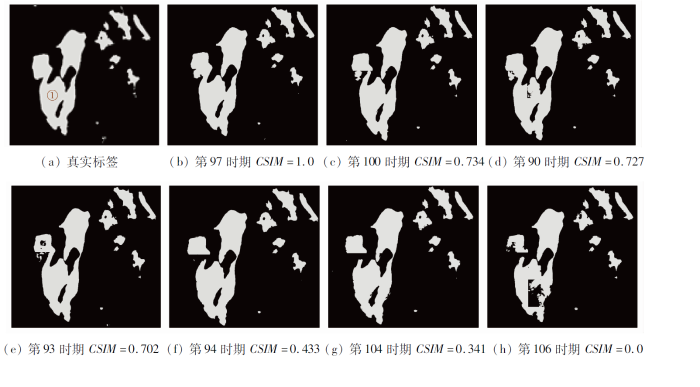

为更好地验证CSIM的合理性,图11依次显示真实标签、CSIM较高的4个模型与CSIM较低的3个模型预测的二值图像结果。第97时期CSIM指标为1,理论上表示该模型在水体连通性上保持能力最佳,实际预测结果显示①号湖泊没有零星图斑,完整性保持最好,局部边界有一点偏差。第106时期CSIM指标值为0,表征其连通相似性在目标模型集合中表现能力是最不好的,实际预测结果显示①号湖泊零碎图斑较多,没有保持湖泊连通性的几何特征,而且几乎丢失湖中心岛的空间位置信息。以上说明了CSIM指标的可靠性,具有很高的置信度,与预测标签连通性保持着高度的一致性。

图11

图11

不同时期测试影像局部区域的预测二值图像

Fig.11

Predicted label of local area of test image in different periods

4 结论

本文针对遥感解译和测绘生产智能解译需求,分析了现有语义分割性能评价体系没有涉及到空间关系特征保持,难以有效支撑时空异质的遥感影像语义分割结果的评价,因此提出了一种顾及地学特征的遥感影像语义分割模型性能评价方法——连通相似性指数CSIM,基于现有的模型评价指标,构建复合指标体系,可以更好地实时监测和控制模型训练; 面向不同地理地域特征的不同时相的不同影像源,可以有效地指导预训练模型的最优选取; 同时实现在像素粒度的基础上顾及地物几何特征的遥感影像预测结果真实质量的准确评估。

本方法还有待改进的地方在于性能评价因子涉及到的地学特征更多地是关注自身,包括像素是否归类正确、像素群是否区域连通,没有涉及到邻近特征的考量。针对这一问题,考虑在下一步工作中将地学先验知识纳入评价因子中,进一步丰富完善遥感影像语义分析模型性能评价方法。

参考文献

遥感影像智能解译样本库现状与研究

[J].

DOI:10.11947/j.AGCS.2021.20210085

[本文引用: 2]

我国遥感对地观测等项目顺利实施,获取了大量时效性强、覆盖范围广、信息量丰富的遥感数据。但遥感影像智能化自动处理技术发展仍相对滞后,无法满足区域/全球大范围地物信息快速提取的需求。近年来,人们利用深度学习技术显著提高了影像特征提取成效,但由于所使用的深度学习样本数量和类型有限,对于多源遥感影像的自动解译能力仍然不足。本文面向大范围多源遥感影像地物信息智能解译需求,在分析现有样本集现状及问题的基础上,研究提出遥感影像智能解译样本库设计方案,并在此基础上设计了基于互联网的样本协同采集与共享服务框架。本文将为多源遥感影像样本库建设提供参考,为大范围遥感影像智能解译提供支持。

Status analysis and research of sample database for intelligent interpretation of remote sensing image

[J].

DOI:10.11947/j.AGCS.2021.20210085

[本文引用: 2]

The rapid development of earth observation projects in China has obtained a large volume of multi-source (multi-type sensors, multi-temporal, multi-scale) remote sensing data. But the capability of intelligent remote sensing image processing lags behind data acquisition. In recent years, people have significantly improved the effectiveness of image feature extraction with deep learning networks. But limited number and variety of sample data is not enough for processing the multi-source remote sensing images. This paper analyzed existing sample datasets and proposed a method for constructing a sample database for intelligent remote sensing image interpretation, including the data model, classification system, data organization, as well as the Internet-based platform for collaborative sample collection and sharing.

Deep convolutional neural networks for image classifycation:A comprehensive review

[J].

DOI:10.1162/neco_a_00990

URL

[本文引用: 1]

Convolutional neural networks (CNNs) have been applied to visual tasks since the late 1980s. However, despite a few scattered applications, they were dormant until the mid-2000s when developments in computing power and the advent of large amounts of labeled data, supplemented by improved algorithms, contributed to their advancement and brought them to the forefront of a neural network renaissance that has seen rapid progression since 2012. In this review, which focuses on the application of CNNs to image classification tasks, we cover their development, from their predecessors up to recent state-of-the-art deep learning systems. Along the way, we analyze (1) their early successes, (2) their role in the deep learning renaissance, (3) selected symbolic works that have contributed to their recent popularity, and (4) several improvement attempts by reviewing contributions and challenges of over 300 publications. We also introduce some of their current trends and remaining challenges.

Deep learning in environmental remote sensing:Achievements and challenges

[J].DOI:10.1016/j.rse.2020.111716 URL [本文引用: 1]

Deep learning for remote sensing data:A technical tutorial on the state of the art

[J].DOI:10.1109/MGRS.2016.2540798 URL [本文引用: 1]

面向对象的多尺度加权联合稀疏表示的高空间分辨率遥感影像分类

[J].

DOI:10.11947/j.AGCS.2022.20190290

[本文引用: 1]

针对高空间分辨率遥感影像中的地物具有多尺度特性,以及各个尺度的对象特征对地物分类精度的影响具有较强的尺度效性,并结合面向对象影像分析方法和多尺度联合稀疏表示方法在高空间分辨率遥感影像分类中的各自优点,提出了一种面向对象的多尺度加权稀疏表示的高空间分辨率遥感影像分类算法。首先,采用多尺度分割算法获得多尺度分割结果并提取对象的多尺度特征;然后,根据影像对象的多尺度分割质量测度计算各尺度的对象权重,构建面向对象的多尺度加权联合稀疏表示模型;最后,采用2个国产GF-2高空间分辨率遥感数据集和1个高光谱-高空间分辨率航空遥感数据集(WashingtonD.C.数据)验证该算法的有效性。试验结果表明,与SVM、像素级稀疏表示、单尺度和多尺度对象级稀疏表示和深度学习等算法相比较,本文算法获得了较高的OA和Kappa分类精度,提高了各个尺度地物的分类精度,有效抑止了地物分类结果中的椒盐噪声现象,同时保持大尺度地物的区域性和小尺度地物的细节信息。

Classification of high spatial resolution remote sensing imagery based on object-oriented multiscale weighted sparse representation

[J].

Object-based spatial feature for classification of very high resolution remote sensing images

[J].DOI:10.1109/LGRS.2013.2262132 URL [本文引用: 1]

一种遥感影像分类精度检验的新方法

[J].

A new approach to accuracy assessment of classifications of remotely sensed data

[J].

遥感影像智能解译:从监督学习到自监督学习

[J].

DOI:10.11947/j.AGCS.2021.20210089

[本文引用: 1]

遥感影像精准解译是遥感应用落地的核心和关键技术。近年来,以深度学习为代表的监督学习方法凭借其强大的特征学习能力,在遥感影像智能解译领域较传统方法取得了突破性进展。这一方法的成功严重依赖于大规模、高质量的标注数据,而遥感影像解译对象独特的时空异质性特点使得构建一个完备的人工标注数据库成本极高,这一矛盾严重制约了以监督学习为基础的遥感影像解译方法在大区域、复杂场景下的应用。如何破解遥感影像精准解译“最后一千米”已成为业界亟待解决的问题。针对该问题,本文系统地总结和评述了监督学习方法在遥感影像智能解译领域的主要研究进展,并分析其存在的不足和背后原因。在此基础上,重点介绍了自监督学习作为一种新兴的机器学习范式在遥感影像智能解译中的应用潜力和主要研究问题,阐明了遥感影像解译思路从监督学习转化到自监督学习的意义和价值,以期为数据源极大丰富条件下开展遥感影像智能解译研究提供新的视角。

Remote sensing image intelligent interpretation:From supervised learning to self-supervised learning

[J].

人工智能时代测绘遥感技术的发展机遇与挑战

[J].

Chances and challenges for development of surveying and remote sensing in the age of artificial intelligence

[J].

高分辨率光学遥感场景分类的深度度量学习方法

[J].

DOI:10.11947/j.AGCS.2019.20180434

[本文引用: 1]

针对高分辨率光学遥感影像场景具有同类型内部差异大、不同类型间相似度高导致部分场景识别困难的问题,本文提出了一种深度度量学习方法。首先在深度学习模型的特征输出层上为每类预设聚类中心,其次基于欧氏距离方法设计均值中心度量损失项,最后联合交叉熵损失项以及权重与偏置正则项构成模型的损失函数。该方法的目标是在特征空间上使同类型特征聚集并扩大类型间的距离以提高分类准确率。试验结果表明,本文方法有效地提升了分类准确率。在RSSCN7、UC Merced和NWPU-RESISC45数据集上,与现有方法相比,分类准确率分别提高了1.46%、1.09%和2.51%。

Deep metric learning method for high resolution remote sensing image scene classification

[J].

DOI:10.11947/j.AGCS.2019.20180434

[本文引用: 1]

Due to the similarity of intra-class and dissimilarity of inter-class of high-resolution remote sensing image scene, it is difficult to identify some image scene class. In this paper, a new classification approach for high-resolution remote sensing image scene is proposed based on deep learning and metric learning. Firstly, a clustering center of each class is preset on the output features of deep learning model. Secondly, the Euclidean distance method is used to calculate the average central metric loss. Finally, the final loss function consists of a central metric loss term, a cross entropy loss term, and a weight and bias term. The goal of this method is to improve the classification accuracy by forcing intra-class compactness and inter-class separability. The experimental results show that the proposed method significantly improves the classification accuracy. Compared with state-of-the-art results, the classification accuracy ratios on RSSCN7, UC Merced and NWPU-RESISC45 datasets are increased by 1.46%, 1.09% and 2.51%, respectively.

图像理解中的卷积神经网络

[J].

Convolutional neural networks in image understanding

[J].

基于深度学习的图像质量评价方法综述

[J].

DOI:10.3778/j.issn.1002-8331.2106-0228

[本文引用: 1]

图像质量评价是对图像或视频的视觉质量的一种度量,主要分析了最近10年图像质量评价算法的研究情况。介绍了图像质量评价算法的衡量指标以及常用的图像质量评价数据集,对图像质量评价方法的分类做了阐述,重点分析了基于深度学习技术的图像质量评价算法。目前,该类算法的基础模型主要包括深度卷积神经网络、深度生成对抗网络和变换器,其性能通常高于传统的图像质量评价算法。描述了基于深度学习技术的图像质量评价算法的原理,重点介绍了基于深度生成对抗网络的无参考图像质量评价算法,通过增强对抗学习强度提高模拟参考图的可靠性。深度学习技术需要海量训练数据的支持,探讨和总结数据集增强的方法,对数字图像质量评价方法的未来研究进行展望。

Overview of image quality assessment method based on deep learning

[J].

DOI:10.3778/j.issn.1002-8331.2106-0228

[本文引用: 1]

Image quality evaluation is a measurement of the visual quality of an image or video. The researches on image quality evaluation algorithms in the past 10 years are reviewed. First, the measurement indicators of image quality evaluation algorithm and image quality evaluation datasets are introduced. Then, the different classification of image quality evaluation methods are analyzed, and image quality evaluation algorithms with deep learning technology are focused on, basic model of which is deep convolutional network, deep generative adversarial network and transformer. The performance of algorithms with deep learning is often higher than that of traditional image quality assessment algorithms. Subsequently, the principle of image quality assessment with deep learning is described in detail. A specific no-reference image quality evaluation algorithm based on deep generative adversarial network is introduced, which improves the reliability of simulated reference images through enhanced confrontation learning. Deep learning technology requires massive data support. Data enhancement methods are elaborated to improve the performance of the model. Finally, the future research trend of digital image quality evaluation is summarized.

特征提取策略对高分辨率遥感图像场景分类性能影响的评估

[J].

Evaluation of the effect of feature extraction strategy on the performance of high-resolution remote sensing image scene classification

[J].

基于深度学习模型的图像质量评价方法

[J].

Image quality evaluation method based on deep learning model

[J].