0 引言

近年来,深度学习作为一种数据驱动的机器学习方法,在许多领域都取得了优于传统方法的效果,并逐渐应用于图像分析领域的大多数问题[10],在遥感变化检测任务中受到了广泛的关注。Daudt等[10]提出了全卷积早期融合(fully convolutional early fusion,FC-EF)、全卷积孪生级联(fully convolutional Siamese concatenation,FC-Siam-conc)和全卷积孪生差异(fully convolutional Siamese difference,FC-Siam-diff)的全卷积网络(fully convolutional network,FCN)用于遥感变化检测。3种网络都采用孪生结构,并逐渐成为遥感变化检测的标准范式[9]。FC-EF将两时相的遥感影像首先拼接成一张输入图像,然后输入FCN直接进行变化特征提取;但由于缺乏每张影像的深度特征信息,所以大规模变化场景识别效果较差。FC-Siam-conc与FC-Siam-diff都是先将两时相的遥感影像输入孪生卷积网络分别提取特征,再将提取出2个时相的特征通过卷积进行变化特征提取。不同之处在于,前者将分别提取的特征串联后再进行变化特征提取;而后者进行差值后再进行变化特征提取。因此,FC-Siam-diff比FC-Siam-conc能更清楚地指导网络比较图像之间的差异,但可能会增加由于光照变化等因素造成的伪变化错误检测。为了克服光照变化和配准误差对变化检测准确性的影响,Chen等[11]在网络的特征提取部分引入自注意力机制,提出了时空注意力神经网络(spatial-temporal attention neural network,STANet),实现对输入图像不同像素的时空关系建模,以提高遥感变化检测方法的性能;Zhang等[12]针对高分辨率遥感影像存在的精细影像特征和复杂纹理特征带来的挑战,提出采用深度监督来增强浅层特征的表示和判断能力;Fang等[9]针对高分辨率遥感变化检测边缘损失和小目标确定性降低的问题,提出了联合孪生结构和NestedUNet[13]的网络SNUNet,以减少神经网络深层定位信息的损失,并通过集成通道注意力模块(ensemble channel attention module,ECAM)用于深度监督,以细化不同语义级别最具代表性的特征,取得了较好的效果;Chen等[14]针对复杂场景下高分辨率遥感影像存在的“同物异谱”现象导致的变化检测困难,提出双时相图像变换器(bitemporal image Transformfer,BIT)网络,通过将双时相影像表达成一些标签,并利用Transformer编码器对远程上下文进行建模,取得了优于多个最先进遥感变化检测方法的效果;Feng等[15]提出了一种双分支多级跨期网络(dual-branch multilevel intertemporal network,DMINet),通过同时考虑自注意力机制和交叉注意力机制,实现了对2个时序图像之间相互作用的建模,这种双分支结构能够有效地捕捉到变化区域,并提高变化检测的精度;Zhang等[16]提出一种新颖的全局感知孪生网络(global-aware Siamese network,GAS-Net),通过背景和前景之间的关系来生成全局感知特征,从而提高变化检测的性能;宋嘉鑫等[17]提出了一种基于模糊C均值聚类(fuzzy C-means,FCM)和简单贝叶斯网络(simple bayesian network,SBN)的非下采样轮廓波变换(non-subsampled contourlet transform,NSCT)变化检测方法,该方法首先将FCM与SBN耦合,计算出后验概率变化强度图,之后,通过NSCT将后验概率变化强度图分解为不同尺度和方向的子图,通过保留高频子图中的细节并消除噪声,优化了重构后的后验概率变化强度图,实现了后验概率空间下的多尺度、多方向的变化检测,最终提高了变化检测的精度;柴佳兴等[18]提出了一种联合无人机影像生成数字表面模型(digital surface model,DSM)和正射影像(digital orthophoto map,DOM)的多层次建筑物变化检测方法,该方法不但能够保留较低高差阈值检测到的低矮变化建筑物,而且能够保证高大变化建筑物的正确性、完整性;马惠等[19]提出了一种多任务学习深度孪生网络用于遥感影像的多类变化检测,采用第三次全国国土调查的影像数据和相应的土地利用图斑数据对多任务学习深度孪生网络模型进行了测试,结果表明所提出的方法适用于这种在没有变化、未变化样本而有历史专题图的变化检测场景中。

尽管上述方法取得了一定的效果,但对于复杂场景的遥感变化检测仍然存在识别不完整、误检率高的问题。大多数变化检测方法都侧重于通过卷积神经网络(convolutional neural network,CNN)提取深度变化语义特征,而对特征上下文信息提取不充分,导致对变化区域识别不完整。而多期遥感影像不同的成像条件,通常存在光照差异、季节变化,常导致变化检测结果中存在较多“伪变化”,导致变化检测误检率高。高效多头自注意力机制(efficient multi-head self attention,EMHSA)在特征提取阶段可捕获远程关联信息,提取更多的上下文信息。快速傅里叶变换[20](fast Fourier transform,FFT)经常被用在频域分析中,利用FFT可将两时相影像从空间域转换为频率域进行处理后,实现两时相遥感影像风格统一。所以受Gao等[21]的启发,在SNUnet的基础上,融合FFT和EMHSA,提出了一种新的遥感变化检测网络FTUNet,以提高变化目标分割结果的完整性,并降低因伪变化引起的错误检测。

1 FTUNet网络设计

1.1 网络总体结构

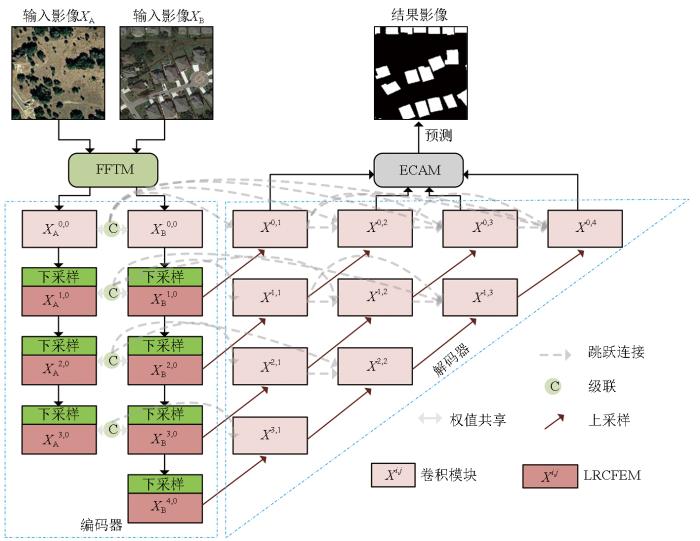

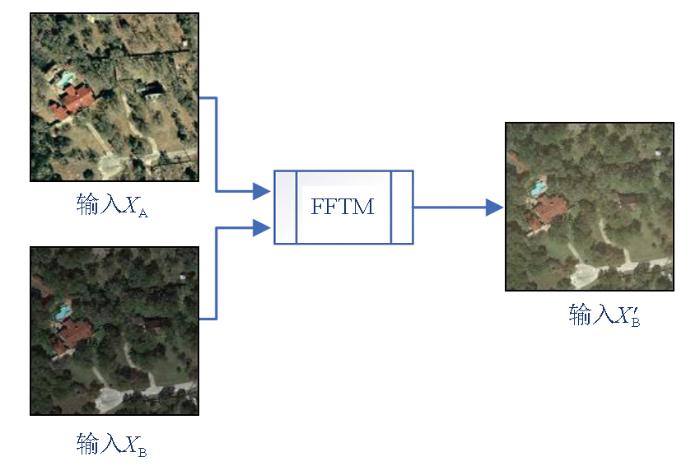

FTUNet模型总体结构如图1所示,包括快速傅里叶变换模块(fast Fourier transform module,FFTM)、编码器、解码器和ECAM 4个模块。对于输入的双时相图像,首先通过FFTM进行风格统一,然后输入编码器进行特征提取。编码器和解码器由卷积模块、下采样模块、远程上下文特征提取模块(long-range context feature extraction module,LRCFEM)和上采样模块组成,结构从上到下,可以看作有5层,每层都包含不同数量的卷积模块和LRCFEM。编码器采用孪生结构,分别提取双时相图像特征

图1

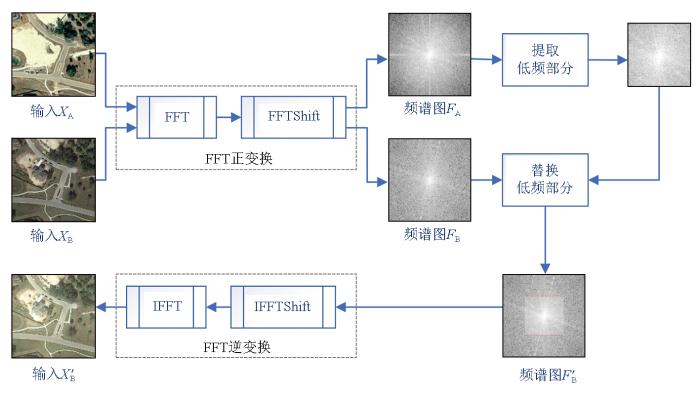

1.2 FFTM

FFTM的基本原理如图2所示。对于输入图像XA和XB,以图像XA为参考。首先,将2张图像分别通过FFT正变换从空间域转换到频率域,通过FFT后图像频谱图低频部分在四周,高频部分在中间,因此再通过FFTShift将低频部分平移到频谱图中心;然后,将XB的低频部分替换为XA的低频部分;最后,将FFT变换原点平移回原位置,并采用FFT逆变换(inverse FFT,IFFT)将XB从频率域转换回空间域,得到统一风格后的图像X'B。

图2

1.3 LRCFEM

如图1所示,LRCFEM位于编码器中每次下采样操作之后,其主要功能是捕获远程关联信息,提取特征图更多的上下文信息。

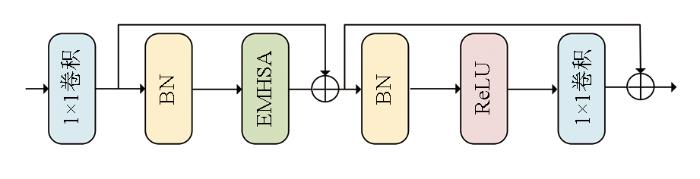

图3

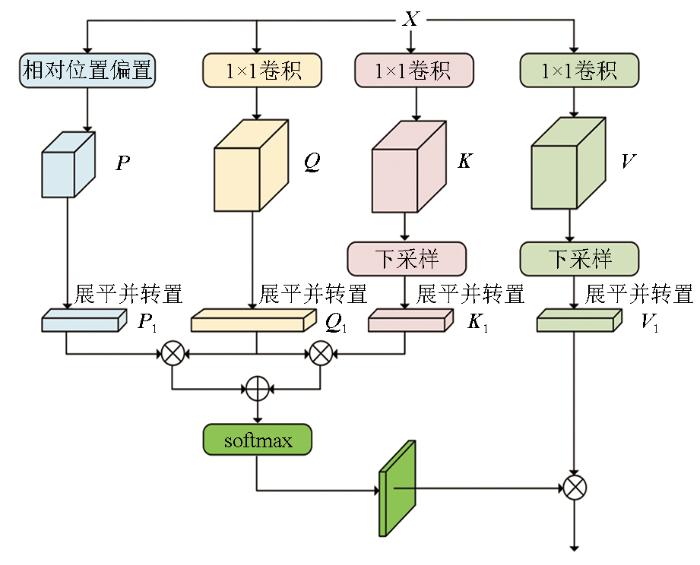

EMHSA模块的结构如图4所示。对于输入特征图X∈

图4

EMHSA模块通过对K和V进行下采样操作,将操作的复杂性从O(n2)显著降低到近似O(n);通过添加相对高度和宽度信息来使用二维相对位置编码,让像素间保持空间位置关系。

2 实验与分析

2.1 数据集

实验采用公开的遥感变化检测数据集LEVIR-CD[11]和SYSU-CD[22]。LEVIR-CD数据集是通过Google Earth API在2002—2018年间收集的。其覆盖范围广泛,涵盖了美国得克萨斯州的20个不同区域。该数据集共包含637张高分辨率的遥感影像,影像的空间分辨率0.5 m,尺寸均为1 024像素×1 024像素。此数据集的主要关注点在于建筑物的变化检测,包括建筑物的新增与消失情况。数据集中涵盖了多样化的建筑类型,如独立别墅、高层住宅楼、小型车库以及大型豪华别墅等,从而能够全面反映建筑物变化的多种场景。在标注方面,该数据集采用了二值标签体系,其中0代表未发生变化的区域,而1则代表发生变化的区域。值得注意的是,数据集中存在显著的光照和季节变化,这可能导致“伪变化”问题的出现。该数据集在总体上包含了31 333个独立的变化建筑物,平均每对数据包含约50个变化建筑物。由于原始影像的尺寸较大,直接在网络训练中使用可能会引发显存不足的问题。因此,本文对原始尺寸为1 024像素×1 024像素的影像实施了无重叠的裁剪操作,每个裁剪后的影像尺寸为256像素×256像素。最终数据集包含7 120个训练图像对用于模型训练,2 048个验证图像对用于模型验证,以及1 024个测试图像对用于模型性能的最终评估。SYSU-CD数据采集于2007—2014年的香港地区。该数据集包含20 000对航拍图像,空间分辨率为0.5 m,图像大小为256像素×256像素。该数据集涵盖了诸多不同类型的变化,包括新建城市建筑、郊区扩张、植被的变化、道路扩建和海上建设等。同样使用二值标签,其中0表示未发生变化,1表示发生变化。最终数据集包含12 000个训练图像对用于模型训练,4 000个验证图像对用于模型验证,以及4 000个测试图像对用于模型性能的最终评估。

2.2 实验设置

实验程序基于PyTorch框架开发。在训练过程中,批大小设置为6,回合设为100,模型采用文献[9]提出的混合损失函数,并采用Adam作为优化器。学习率设置为0.001,每8个epoch衰减50%。每个卷积层的权重均通过Kaiming初始化设置。

2.3 评价指标

变化检测性能通过4个典型指标来评估[11]:精确率(precision,P)、召回率(recall,R)、交并比(intersection over union,IoU)和F1分数。P越高表示错误检测越少;R更大表明更多的正样本被检测出来;IoU和F1分数都是对预测结果进行整体度量,值越大,预测结果就越好。指标公式分别为:

式中:TP为被正确预测的正样本数量;FP为被错误预测的负样本数量;FN为被错误预测的正样本数量。

2.4 消融实验

为了验证FFTM和LRCFEM的作用,基于LEVIR-CD数据集,设计了一组消融实验。实验以SNUNet[9]作为基准网络,在SNUNet的编码器前加入FFTM,得到SNUNet+FFTM;通过将SNUNet中编码器第2—5层的卷积模块用LRCFEM替换,得到SNUNet+LRCFEM;在SNUNet编码器前加入FFTM同时将编码器第2—5层的卷积模块用LRCFEM替换,构建SNUNet+FFTM+LRCFEM,即FTUNet。基于LEVIR-CD数据集,对SNUNet,SNUNet+FFTM,SNUNet+FFTM+LRCFEM和FTUNet这4种不同的网络进行实验,实验结果通过多个关键评价指标来衡量,包括P,R,IoU以及F1,详细数据如表1所示,表1中加粗数字为最优结果。

表1 消融实验结果

Tab.1

| 网络模型 | P | R | IoU | F1 |

|---|---|---|---|---|

| SNUNet(基准网络) | 89.91 | 87.21 | 79.44 | 88.54 |

| SNUNet+FFT | 90.81 | 87.86 | 80.69 | 89.31 |

| SNUNet+LRCFEM | 90.46 | 89.15 | 81.50 | 89.81 |

| FTUNet(本文网络) | 90.72 | 89.22 | 81.75 | 89.96 |

从表1可以看出,对于基准网络SNUNet来说,无论在网络编码器前加入FFTM还是将网络编码器2—5层替换为LRCFEM,P,R,IoU和F1等评价指标结果都有一定的提升,而且单独将网络编码器2—5层替换为LRCFEM的改进效果优于在网络编码器前加入FFTM的改进效果。对于同时加入FFTM和LRCFEM的FTUNet,在R,IoU和F1指标上取得了最佳效果。具体来说,当基准网络中仅加入FFTM时,相较于基准网络来说,P,R,IoU和F1分别提升了0.90,0.65,1.25和0.77百分点。这是因为FFTM将输入的两时相影像进行风格统一,减轻了由于光照变化等因素使得前后影像颜色不一致产生伪变化,使得网络更加能区分真实变化和不相关变化。当基准网络仅添加LRCFEM时,相较于基准网络来说,P,R,IoU和F1分别提升了0.55,1.94,2.06和1.27百分点。这是因为LRCFEM在特征提取阶段扩大了感受野,可以提取特征图更多的上下文信息,提高了变化目标分割结果的完整性。当同时加入2个模块时,相比于基准网络,P提升了0.81百分点,R提升了2.01百分点,F1提升了1.42百分点,这是由于FFTM通过风格统一,减少了伪变化,使得网络减少对未变化区域的误判;LRCFEM能够扩大感受野,捕获远程关联信息,使得网络提取特征图更多的上下文信息。从以上消融实验,可以看出FFTM和LRCFEM对网络的变化检测性能提升均具有积极作用。

为了更直观地展示实验结果,进一步对实验结果进行了可视化处理,如表2所示,从表2中a和b可以看出,SNUNet在变化检测过程中,容易将由于光照变化等因素使得前后影像中屋顶颜色不一致的同一建筑物识别为未变化区域(图中方框所示)。如图5所示,通过引入FFTM,进行风格统一,使得两时相影像中同一建筑物屋顶颜色一致。SNUNet+FFTM和FTUNet都能对这种类型建筑物正确识别,减少了错误检测;而单独引入LRCFEM,SNUNet+LRCFEM对于这种区域仍然判定为变化区域。从表2中c和d可以看出,SNUNet对于变化的建筑物,存在识别不完整甚至无法识别的现象。通过引入LRCFEM,提升提取特征图上下文信息的能力,增强对变化区域完整识别能力。SNUNet+LRCFEM和FTUNet都能较完整的识别出变化的建筑物。因此,FTUNet不仅能对部分伪变化区域进行正确识别,对于变化区域的识别也更加完整。

表2 消融实验可视化结果

Tab.2

| 序号 | 影像A | 影像B | 标签 | SNUNet | SNUNet+FFT | SNUNet+LRCFEM | FTUNet |

|---|---|---|---|---|---|---|---|

| a |  | ||||||

| b |  | ||||||

| c |  | ||||||

| d |  | ||||||

| 图例 |  | ||||||

图5

2.5 对比实验

表3 LEVIR-CD数据集对比实验结果

Tab.3

| 网络模型 | P | R | IoU | F1 |

|---|---|---|---|---|

| FC-EF | 86.69 | 79.87 | 71.15 | 83.14 |

| FC-Siam-conc | 89.41 | 85.02 | 77.24 | 87.16 |

| FC-Siam-diff | 90.12 | 83.01 | 76.09 | 86.42 |

| SNUNet | 89.91 | 87.21 | 79.44 | 88.54 |

| BIT | 92.01 | 86.72 | 80.65 | 89.28 |

| FTUNet(本文网络) | 90.72 | 89.22 | 81.75 | 89.96 |

为了更直观地说明FTUNet相较于其他方法变化检测结果的效果差异,对不同的网络在LEVIR-CD测试集上的变化检测结果进行可视化对比,如表4所示。从表4的a和b可以看出,对于由于光照变化等因素使得前后影像中屋顶颜色不一致的同一建筑物,FTUNet网络能够较好地识别为未变化区域,但其他网络基本会错误识别为变化区域;从表4的c可以看出,对于大型新增建筑物,FTUNet网络的识别效果最好,但FC-Siam-diff和SNUNet等网络都没有完整的识别出来;从表4的d和e可以看出,对于小型新增建筑物,FTUNet网络都能够完整的识别出来,其他网络都识别不完整,甚至在表4的d中,其他网络未识别到新增建筑物。由此表明,FTUNet能过利用FFTM,将输入的双时相影像进行风格统一,然后通过编码器中的LRCFEM捕获远程关联信息,提取特征图更多的上下文信息,使得网络不仅能正确识别部分伪变化区域,减少错误识别,也能通过上下文信息进行正确识别,从而使得识别出的变化区域更加完整。

表4 LEVIR-CD数据集对比实验可视化结果

Tab.4

| 序号 | 影像A | 影像B | 标签 | FE-EF | FC-Siam- conc | FC-Siam- diff | BIT | SNUNet | FTUNet |

|---|---|---|---|---|---|---|---|---|---|

| a |  | ||||||||

| b |  | ||||||||

| c |  | ||||||||

| d |  | ||||||||

| e |  | ||||||||

| 图例 |  | ||||||||

在SYSU-CD数据集的实验结果如表5所示,可视化对比结果如表6所示。从表5可以看出,FTUNet网络在多类别变化目标识别中,R,IoU和F1的指标都是最佳的。FTUNet的F1达到了79.48%,比FC-Siam-diff高了15.67百分点,比FC-EF高了5.68百分点,比FC-Siam-conc高了3.89百分点,比SNUNet和BIT分别高了1.53和2.1百分点。从IoU指标上看,除了FTUNet网络,其他变化检测网络的IoU值均低于65%,最高仅为63.87%;FTUNet的IoU值为65.94%,比FC-Siam-diff高了19.08百分点,比SNUNet和BIT分别高了2.07和2.83百分点。由此表明,FTUNet对于SYSU-CD数据集中不同类型的变化具有鲁棒性。而FC-Siam-Diff实现了最高的精确率和最低的召回率,可能是因为减法差分融合仅仅能识别除比较明显变化的区域,但对于多类别变化目标数据集的复杂变化场景漏检情况比较多。

表5 SYSU-CD数据集对比实验结果

Tab.5

| 网络模型 | P | R | IoU | F1 |

|---|---|---|---|---|

| FC-EF | 78.60 | 69.55 | 58.47 | 73.80 |

| FC-Siam-conc | 81.11 | 70.76 | 60.75 | 75.59 |

| FC-Siam-diff | 90.35 | 49.33 | 46.86 | 63.81 |

| SNUNet | 81.90 | 74.37 | 63.87 | 77.95 |

| BIT | 81.71 | 73.49 | 63.11 | 77.38 |

| FTUNet(本文网络) | 79.95 | 79.01 | 65.94 | 79.48 |

表6 SYSU-CD数据集对比实验可视化结果

Tab.6

| 序号 | 影像A | 影像B | 标签 | FE-EF | FC-Siam- conc | FC-Siam- diff | BIT | SNUNet | FTUNet |

|---|---|---|---|---|---|---|---|---|---|

| a |  | ||||||||

| b |  | ||||||||

| c |  | ||||||||

| d |  | ||||||||

| e |  | ||||||||

| 图例 |  | ||||||||

在表6的a中,对于有些海上轮船从有到无,有些海上轮船从无到有而产生的变化,除了FTUNet和BIT,其他方法都不能将其识别完整;与BIT相比,FTUNet识别出变化区域的边界更加准确。在表6的b中,对于道路扩建,可以看到除了FTUNet的识别结果较为完整,其他几个网络都有不同程度的漏检。在表6的c中,对于新建大型建筑物,虽然这6个网络都不能将建筑物完整的识别出来,但FTUNet识别的结果完整度是最高的,漏检最少。表6前3行显示了3种不同类型的变化,FTUNet都能比较完整地识别出变化区域。在表6的d和e中,对于道路扩建和新增小建筑物,在FTUNet识别出变化区域的边界更加准确,特别在表6的d中表现最明显,FTUNet能完整的识别出,但其他网络在变化区域边界处存在不同程度的误检或漏检。

3 结论

本文提出了一种融合FFT和EMHSA的遥感变化检测网络FTUNet,通过引入FFTM,统一两时相图像处理风格,有效减弱遥感影像因光照变化等外界因素导致的颜色差异,从而显著减少错误检测,提高检测结果的准确性。在FTUNet中设计了LRCFEM模块,在网络特征提取阶段扩大感受野,充分提取特征图的上下文信息,并通过EMHSA更有效地关注变化区域,增强多尺度变化目标分割结果的完整性。

在LEVIR-CD和SYSU-CD这2个公开数据集上进行实验验证,结果表明,FTUNet在减弱光照等外界因素干扰、减少错误检测以及提高多尺度变化目标分割完整性方面,相较于FC-EF等网络具有显著优势;但在面对极端复杂或噪声较多的遥感影像时,FTUNet的性能可能会受到一定影响。

随着遥感技术的不断发展,更高分辨率、更多样化的影像数据将不断涌现,对FTUNet的适应性和泛化能力提出了更高的要求。因此,未来的研究可以进一步探索如何提升FTUNet在复杂场景下的性能,以及如何将其拓展应用于更多类型的遥感影像变化检测任务。

参考文献

Land-use/land-cover change detection based on a Siamese global learning framework for high spatial resolution remote sensing imagery

[J].

Land cover change detection techniques:Very-high-resolution optical images:A review

[J].

Change detection from very-high-spatial-resolution optical remote sensing images:Methods,applications,and future directions

[J].

Spectral indices based object oriented classification for change detection using satellite data

[J].

A new artificial intelligence optimization method for pca based unsupervised change detection of remote sensing image data

[J].

Asymmetric cross-attention hierarchical network based on CNN and Transformer for bitemporal remote sensing images change detection

[J].

SNUNet-CD:A densely connected Siamese network for change detection of VHR images

[J].

A spatial-temporal attention-based method and a new dataset for remote sensing image change detection

[J].

A deeply supervised image fusion network for change detection in high resolution bi-temporal remote sensing images

[J].

Remote sensing image change detection with Transformers

[J].

Change detection on remote sensing images using dual-branch multilevel intertemporal network

[J].

Global-aware Siamese network for change detection on remote sensing images

[J].

基于后验概率空间变化向量分析的NSCT高分辨率遥感影像变化检测

[J].

NSCT-based change detection for high-resolution remote sensing images under the framework of change vector analysis in posterior probability space

[J].

联合无人机影像生成DSM和DOM的多层次建筑物变化检测

[J].

Multi-level building change detection based on the DSM and DOM generated from UAV images

[J].

多任务学习孪生网络的遥感影像多类变化检测

[J].

Multi-class change detection using a multi-task Siamese network of remote sensing images

[J].

Fast Fourier transforms:A tutorial review and a state of the art

[J].

A deeply supervised attention metric-based network and an open aerial image dataset for remote sensing change detection

[J].