0 引言

遥感图像特征点匹配旨在识别和建立不同时间或视角下遥感图像中同名像点的对应关系,这一过程为后续遥感图像的变化检测与分析[1 -2 ] 、图像融合[3 ] 和图像拼接及配准[4 ] 等工作提供了重要依据。然而,在实际场景中,遥感图像中的地物场景具有多尺度、纹理相似以及复杂多变等特点,可能会造成误匹配,甚至无法匹配等问题。

目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法。其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低。相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] 。Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性。Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征。Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征。Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果。Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系。Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对。Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配。为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷。陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系。此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想。综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色。然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取。

鉴于此,通过对ResNet34网络引入空间重构单元[20 ] 和大核选择性卷积核卷积结构,本文提出了一种结合大核选择性卷积增强模块的遥感图像特征点匹配网络,在使用空间重构单元增强特征信息表达的基础上,结合大核选择性卷积核卷积结构来获取目标地物更广泛的上下文信息,并通过跳跃连接将经过大核选择性卷积增强模块输出的深层特征与ResNet34输出的浅层特征融合,实现动态获取遥感图像的多尺度细节信息,减少特征点的误匹配干扰。为进一步优化匹配结果,附加几何一致性和运动一致性约束,对稀疏邻域共识网络获取的初始匹配点对进行优化,达到提高遥感图像特征点匹配精度的目的。

1 结合大核选择性卷积增强模块的遥感图像匹配网络

1.1 网络整体架构

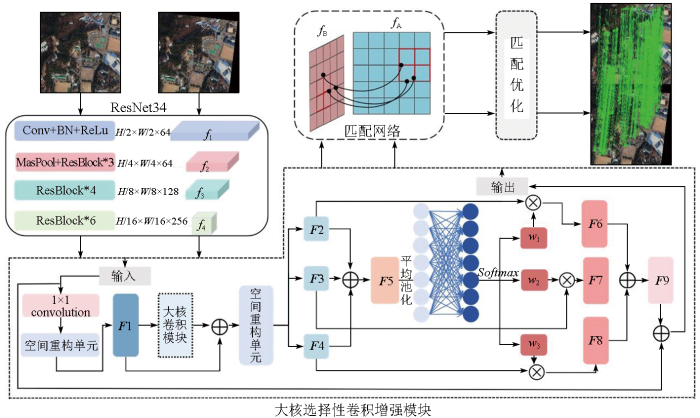

网络架构如图1 所示,由ResNet34网络、大核选择性卷积增强模块、稀疏邻域共识网络和匹配优化模块组成。相较于直接使用ResNet34作为特征提取网络,大核选择性卷积增强模块的加入允许网络动态调整不同卷积核的权重以适应不同目标地物的特征提取,使特征信息提取更加完整; 此外,匹配优化模块能有效过滤误匹配点对,从而优化提取结果。

图1

图1

结合大核选择性卷积增强模块的遥感图像特征点匹配网络

Fig.1

Remote sensing image feature point matching network combining enhanced large selective kernel convolution module

1.2 结合大核选择性卷积增强模块的特征提取

以ResNet34网络作为特征提取的基础网络,只使用1个卷积层和3个卷积组以防止过拟合现象并减少网络深度和参数数量。由于遥感图像中覆盖地物类型复杂、尺度变化范围大,同时还存在同类型建筑物但空间分布不同等易混淆情况,而该网络中固定组合形式的卷积结构较难有效根据不同地物所需的上下文信息进行特征提取,从而导致遥感图像特征提取时丢失细节信息。因此,大核选择性卷积增强模块的加入能让模型更关注遥感图像中不同地物的细节信息提取。

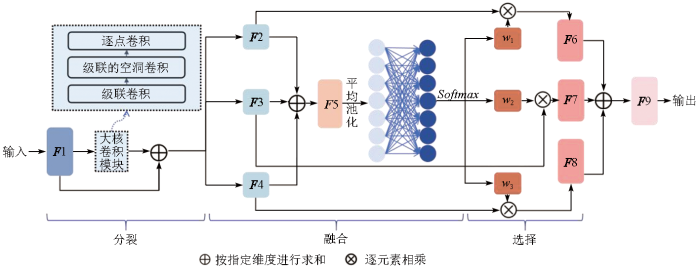

该模块主要由大核选择性卷积核卷积结构和空间重构单元组成。其中大核选择性卷积核卷积结构分为分裂(split),融合(fuse)和选择(select)3部分,如图2 所示。为更好获取不同目标地物的上下文信息,使用级联的1×K 和K ×1卷积核替换深度卷积中的K ×K 卷积核,并结合空洞深度卷积,通过堆叠方式扩大感受野,最终动态调整各个分支权重以自适应使用不同尺寸卷积核,实现对重要特征的筛选和非重要特征的剔除。

图2

图2

大核选择性卷积核卷积结构

Fig.2

Large selective Kernel convolution structure

具体操作流程如下: 输入特征向量F 1,通过分裂操作在不同的分支生成具有不同尺寸的卷积核,从而获取多尺度的特征信息。其中大核卷积部分以堆叠卷积核的方式实现,第一层使用级联的1×K 和K ×1卷积核来取代传统深度卷积中的K ×K 卷积核; 第二层使用膨胀率为3的级联1×K 和K ×1卷积核; 第三层使用逐点卷积,最终堆叠获得更大的感受野。同时,为防止在堆叠过程中细节信息的丢失,采用跳跃连接生成特征向量F 2,F 3和F 4。其中,K =1时,获得特征向量F 2,其感受野较小,因此对图像中的细节信息更为敏感,可用于捕捉目标地物的局部特征; K =3时,特征向量F 3相较于F 2能捕获更广泛的上下文信息,可用于描述图像中更大范围的目标地物关系; K =5时,特征向量F 4拥有更大的感受野,能捕捉更大范围的语义关系,可用于描述图像中目标地物的整体结构和远距离依赖关系。为融合不同尺度特征信息,将上述特征向量相加,得到融合特征向量F 5。随后,通过全局平均池化和全连接层进一步增强特征向量F 5的空间关联性。最后,使用Softmax 将各分支对应的权重进行归一化处理,获取不同分支的权重信息,并对通过分裂操作获得的特征向量进行加权求和,动态选择并融合以上特征向量。因此,该结构能够聚焦于图像中当前地物最合适的特征尺度,从而提高对遥感图像特征信息的提取效率。

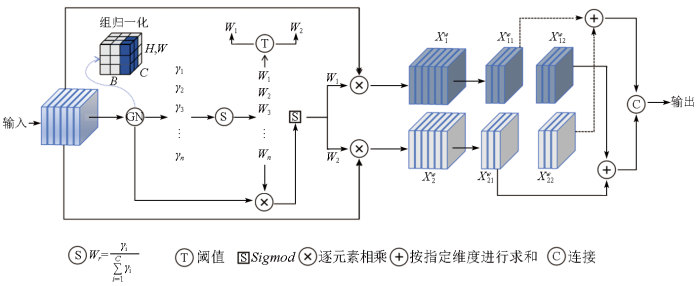

此外,引入空间重构单元,分离特征向量信息含量丰富和较少的部分,并通过交叉重构以加强重要特征信息的特征表达,达到抑制特征向量在空间维度上冗余的效果,其结构如图3 所示。

图3

图3

空间重构单元

Fig.3

Spatial reconstruction unit

空间重构单元分“分离”和“重构”2个阶段。其中,“分离”阶段的具体流程为: 首先实现特征向量的组归一化,计算公式为:

(1) X out =GN (X )=γ $\frac{X-\mu }{\sqrt{{\delta }^{2}+\epsilon }}$ +β ,

式中: μ 和δ 为输入特征向量X 的均值和标准差; γ 和β 为可训练的仿射变换参数; γ 用于评价特征向量中信息含量的丰富程度,数值越大表明空间像素变化越大即含有更丰富的空间信息。

其次,通过对参数γ 的归一化处理可获得权重参数Wγ ,不同的权重表明了不同特征向量的重要程度,计算公式为:

(2) Wγ ={wi }=$\frac{{\gamma }_{i}}{\stackrel{C}{\sum _{i=1}}{\gamma }_{i}}$ ,i ,j =1,2,…,C 。

再利用Sigmod 函数对加权特征向量进行0~1的映射,并通过阈值进行门控,将高于阈值的权重设置为1表示获得信息丰富的权重W 1 ,剩下的权重设置为0表示获得信息含量不丰富的权重W 2 ,计算公式为:

(3) W =Gate (Sigmod (Wγ (GN (X )))) 。

然后将输入特征向量X 与式(3)得到的权重相乘,得到信息含量丰富的特征${X}_{1}^{\mathrm{w}}$ ${X}_{2}^{\mathrm{w}}$ ${X}_{2}^{w}$

(4) $\left\{\begin{array}{l}{X}_{1}^{w}={W}_{1}\times X\\ {X}_{2}^{w}={W}_{2}\times X\end{array}\right.$ 。

“重构”阶段采用交叉重构的方式将信息含量丰富与较少的特征图相加,将交叉重构得到的特征连接得到特征向量Xw ,计算公式为:

(5) $\left\{\begin{array}{l}{X}_{11}^{w}+{X}_{22}^{w}={X}^{\mathrm{w}1}\\ {X}_{21}^{w}+{X}_{12}^{w}={X}^{\mathrm{w}2}\\ {X}^{\mathrm{w}1}\bigcup {X}^{\mathrm{w}2}={X}^{\mathrm{w}}\end{array}\right.$ 。

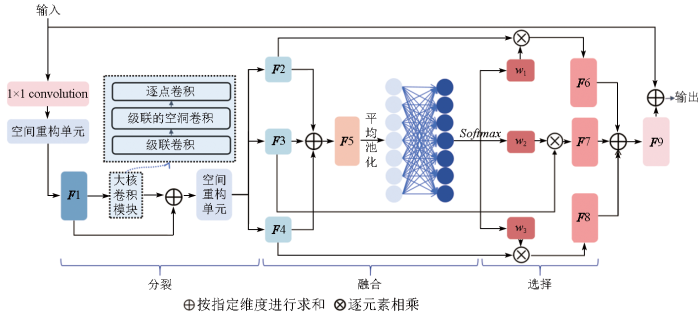

最终将该模块嵌入大核选择性卷积核卷积结构,提出大核选择性卷积增强模块,如图4 所示。其以ResNet -34网络输出作为输入,先利用1个1×1卷积调整输入特征向量的通道数; 再使用空间重构单元对该特征向量进行交叉重构,以获得加强重要特征信息的新的特征向量; 最后将其送入大核选择性卷积核卷积结构以动态获取不同尺度的特征信息,同时利用跳跃连接将浅层特征与深层特征融合输出,得到特征向量。

图4

图4

大核选择性卷积增强模块

Fig.4

Enhanced large selective Kernel convolution module

1.3 基于稀疏邻域共识网络的特征匹配与优化

由于稀疏邻域共识网络更加关注图像的局部邻域信息,当遥感图像中地物场景复杂或存在遮挡等情况时,可能会产生一定粗差,影响图像的局部邻域关系,从而导致特征点提取的不准确。因此,引入匹配优化模块以抑制不符合局部结构一致性的匹配点对。操作如下,经上述特征提取网络得到特征向量fA 和fB 后,利用余弦相似性计算两者间的相关性并通过K最邻近算法保留给定特征的前M 个匹配。同时,为保证输入图像顺序不会影响稀疏相关性的计算结果,采用双向执行操作将所得2个单边稀疏相关张量相加得到最终稀疏相关张量,随后使用子流形稀疏卷积对其进行处理得到匹配点对,最后使用匹配优化模块优化匹配点对。

其中,匹配优化模块考虑几何一致性和运动一致性。假设存在2幅图像IL 和IR ,根据特征提取与匹配过程可得初始特征匹配集CLR 。假设点${{p}_{i}}^{L}$ ${{p}_{j}}^{R}$ CLR 中任一初始匹配对,则初始匹配特征间的几何一致性可用点${{p}_{i}}^{L}$ ${{p}_{j}}^{R}$

(6) gij =||${p}_{i}^{L}$ -${p}_{j}^{R}$ ||,

(7) mij =||${p}_{i}^{L}$ -(R ${p}_{j}^{R}$ +t )||,

最后结合几何一致性和运动一致性约束,对初始特征匹配集CLR 进行过滤得到匹配优化合集,公式为:

(8) ${C}_{s}^{LR}$ =mij (gij (CLR )) 。

1.4 损失函数

本文沿用了Rocco等提出的弱监督损失函数[11 ] 。该方法假设待匹配的2幅图像IA 和IB 可成功匹配,则通过计算相关张量并使用Softmax函数,可得到匹配结果和匹配得分。对于成功匹配的图像,目标是最大化匹配得分; 而对于无法匹配的图像,则最小化匹配得分。损失函数的具体公式如下:

(9) L (IA ,IB )=-y (${\stackrel{-}{s}}^{A}$ +${\stackrel{-}{s}}^{B}$ ),

式中: y 取值±1,+1表示正训练样本,-1表示负训练样本; ${\stackrel{-}{S}}^{A}$ ${\stackrel{-}{S}}^{B}$

2 实验与结果分析

2.1 实验数据

将本文方法与特征点提取网络SuperPoint和R2D2,以及端到端的特征点提取与匹配网络NCNet,Sparse-NCNet,LoFTR和Two-Stream分别在Google Earth数据集[21 ] 和WHU-RS19[22 ] 数据集上进行匹配准确性性能评估,在Hpatches数据集[23 ] 上进行泛化性验证,实验数据集详细信息如下:

1) Google Earth数据集通过对多时相航空图像应用随机仿射变换模型生成,包含500对多时相图像及其相应的转换模型测试集。

2) WHU-RS19数据集由从谷歌卫星图像上获取的遥感图像制作而成。图像尺寸为600像素×600像素,共1 005张。同一类别的图像样本是从不同分辨率的卫星图像中的多个区域采集的,因此其尺度、方向和光照各异。按照Park等[21 ] 提出的随机仿射变换方法,生成测试数据集。

3) Hpatches数据集包含108个图像序列,56个视点变化和恒定光照条件的序列和52个光照变化和恒定视点的序列,每个序列来自不同的平面场景,包含6张图像,可用于评估算法在强视点和光照变化下的匹配精度。

2.2 评估指标

在Google Earth数据集和WHU-RS19数据集上使用定量评价指标: 正确匹配率(correct matching rate,CMR)、正确点概率度量(percentage of correct keypoints,PCK)、均方误差(mean squared error,MSE)、均方根误差(root mean squared error,RMSE)以及平均绝对误差(mean absolute error,MAE)对本文网络ELSK-NCNet的性能进行评估。其中CMR表示正确匹配点对数量与所有匹配点对数量的比值,其余指标计算公式为:

(10) PCK =$\frac{1}{N}\stackrel{N}{\sum _{i=1}}$ [d (T fin i p s i p t i α ·max(h ,w )],

(11) MSE =$\frac{1}{M}\stackrel{M}{\sum _{i=1}}$ ((xi -x'i )2 +(yi -y'i )2 ),

(12) RMSE =$\sqrt{\frac{1}{M}\stackrel{M}{\sum _{i=1}}\left(\right({x}_{i}-x{\text{'}}_{i}{)}^{2}+({y}_{i}-y{\text{'}}_{i}{)}^{2})}$ ,

(13) MAE =$\frac{1}{2M}\stackrel{2M}{\sum _{i=1}}$ (|xi -x'i |+|yi -y'i |),

式中: N 为图像的总关键点数量; T fin i p s i i 个图像对经过图像变换得到的源图像关键点; p t i i 个图像对真实标记的关键点; max(h ,w )表示高h 宽w 图片的最大阈值范围,α 系数取值越大,越能测量全局匹配情况; M 为图像中的所有像素点; (xi ,xj )为通过网络从图像中检测到的关键点坐标; (x'i ,x'j )为真实坐标; MSE ,MAE 和RMSE 用来衡量真实关键点和网络预测的关键点之间的误差,其值越小,准确率越高。

Hpatches数据集用于验证网络的泛化性,采用平均匹配精度MMA作为评估的度量标准,计算过程为:

(14) MMA =$\sqrt{({x}_{i}-x{\text{'}}_{i}{)}^{2}+({y}_{i}-y{\text{'}}_{i}{)}^{2}}$ <c ,c =1,3,5,

2.3 实验及结果分析

实验使用Ubuntu18.04系统,pytorch2.0.1框架,CPU为AMD R5 5600,GPU为NVIDIA GeForce RTX 4070-12 GB。训练过程中采用Adam优化器,初始学习率为0.001,在每个epoch结束后将学习率按0.5的衰减因子进行调整,批处理大小为16,网络训练的轮数为40。

2.3.1 Google Earth数据集实验分析

Google Earth数据集精度比较,如表1 所示,本文网络在各项指标上均优于对比网络。与SuperPoint,R2D2,NCNet,Sparse-NCNet,LoFTR和Two-Stream网络相比,当α 取值为0.1和0.05时,本文网络的PCK值分别为0.97和0.89,较其他网络分别提高了15.5%,14.1%,10.2%,14.1%,3.19%,7.78%和7.22%,5.95%,2.30%,4.71%,7.22%,9.88%。此外,在MSE ,RMSE 和MAE 误差上也分别取得了最优值0.88,0.94和0.46,CMR 指标则达到了95.58%。

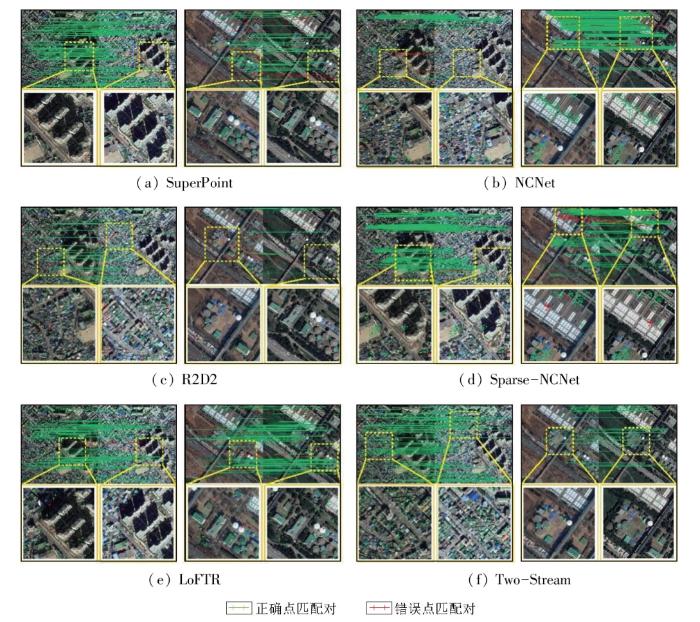

对比网络在Google Earth数据集上的可视化结果如图5 所示,其中绿色特征点和匹配线表示正确匹配点对,红色表示错误匹配点对。从第一组结果可看出,SuperPoint,Sparse-NCNet和LoFTR网络均在具有不同空间分布的同类型建筑物区域出现错误匹配。其中,SuperPoint仅涉及特征点提取,匹配阶段仍使用基于特征描述符计算特征点相似度的传统匹配方法,因其相似性测度的不稳定性,易出现误匹配问题; Sparse-NCNet网络架构更关注图像的邻域信息,面对上述情况时鲁棒性不强; 而LoFTR网络使用Transformer架构虽能获得更长距离的依赖关系,但由于遥感图像中不同地物所需的背景信息不同,所以在处理此类情况时也易出现错误匹配。同时,R2D2,NCNet和Two-Stream网络在处理密集且空间尺度较小的地物时也易产生误匹配问题。R2D2网络同样仅涉及特征点提取,在使用传统匹配方法时相似度计算不稳定从而导致匹配错误。而NCNet网络在面对由于不同时节光照条件的变化引起的特征变化时也较难正确识别相应的地物特征。Two-Stream网络则由于其卷积核感受野有限,较难识别具有不同空间分布的相似地物特征。与第一组遥感图像相比,第二组遥感图像的区域内建筑物分布分散且存在大面积裸露土地。这类地物特征相对不明显,更易影响特征点的提取和匹配。特征提取网络SuperPoint和R2D2因其匹配阶段的计算不稳定而产生较多错误匹配,而NCNet和Sparse-NCNet网络在面对特征信息不突出、空间分布不同但外观相似的地物时也出现了误匹配。Sparse-NCNet相比NCNet所关注的邻域范围更小,因此在处理大量重复纹理特征且特征不明显的情况时,误匹配点对数量更多。而LoFTR网络缺乏动态感知不同地物所需背景信息的能力,所以在如局部图所示区域出现了较为明显的错误匹配。

图5

图5

对比网络在Google Earth数据集上的可视化结果图

Fig.5

The visualization results of the contrastive network on the Google Earth dataset

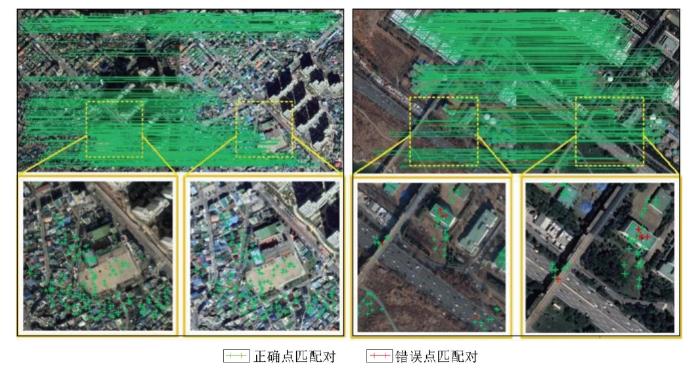

图6 展示了本文网络ELSK-NCNet在Google Earth数据集上的可视化结果。本文网络拥有更大的感受野,可动态获取不同地物所需的背景信息,但在地物特征不明显的区域仍然出现了错误匹配,因此还需继续探索并提升其匹配性能。对比其他网络,本文网络在地物类型复杂、空间分布不同的情况下展示了其优越的特征点提取与匹配能力,从而验证了ELSK-NCNet网络的有效性。

图6

图6

本文网络可视化结果图

Fig.6

The visualization results of the network in this paper

2.3.2 WHU-RS19数据集实验分析

本文所提出的网络与对比网络在WHU-RS19数据集上的精度如表2 所示。与SuperPoint,R2D2,NCNet,Sparse-NCNet,LoFTR和Two-Stream相比,当α 分别取0.1和0.05时,本文网络的PCK值为0.93和0.84,精度分别提高了22.4%,13.4%,10.7%,14.8%,1.09%,5.68%和13.51%,3.70%,1.19%,5.00%,1.19%,3.70%。此外,本文网络在MSE ,RMSE 和CMR 指标上也分别达到了1.74,1.31和91.53%。

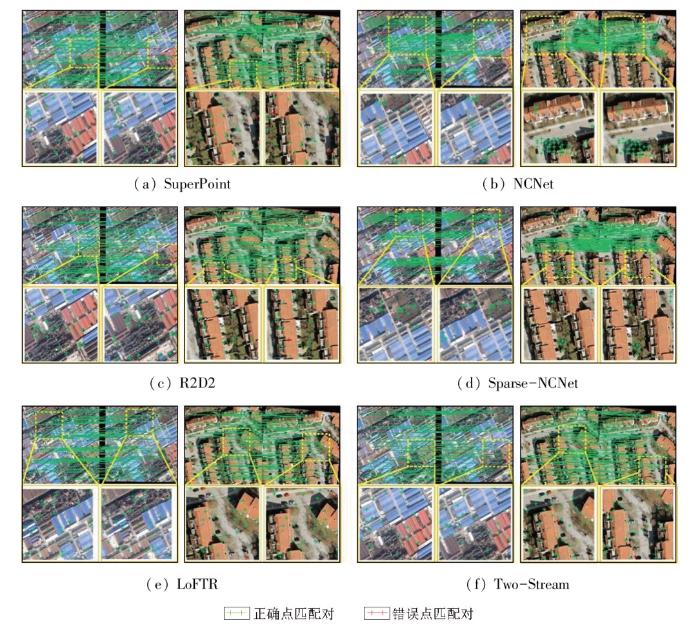

可视化对比结果如图7 所示。如第一组图像所示,该图中地物类型简单,但特征提取网络SuperPoint和R2D2仍在如局部图所示的土壤覆盖和红色建筑物区域出现了明显错误匹配。而NCNet,Sparse-NCNet和LoFTR网络能较好地分辨此示例中不同类型的地物特征,具有良好的匹配效果。同时Two-Stream网络在红色建筑物区域的不同位置也出现了明显匹配错误。其次,第二组图像聚焦于城市区域,该区域内建筑物空间尺度较大,与道路交错分布。SuperPoint和R2D2网络仍因其使用传统匹配方法而表现出较差的匹配性能,在图中空间分布不同的橙色建筑物区域产生了错误匹配。NCNet,Sparse-NCNet和LoFTR网络在该示例中表现出较好的匹配性能。而Two-Stream网络受其卷积核感受野限制,不能准确分辨不同车辆在不同区域的地物特征,出现了错误匹配。

图7

图7

对比网络在WHU-RS19数据集上的可视化结果图

Fig.7

The visualization results of the contrastive network on the WHU-RS19 dataset

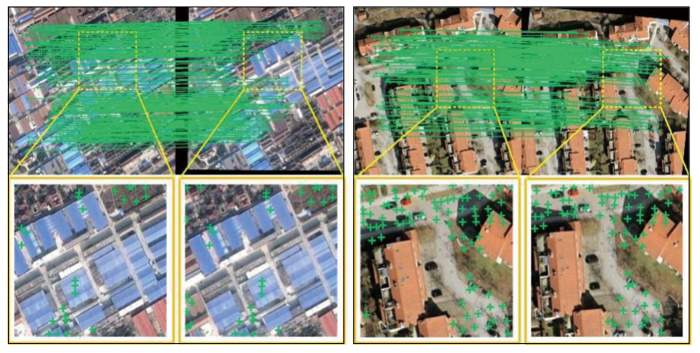

本文网络在该数据集上的可视化结果如图8 所示。ELSK-NCNet网络使用了空间重构单元增强特征信息表达且能动态捕获不同类型地物所需的上下文信息,因此具有良好的匹配性能。从图中可看出,本文网络能正确识别各类地物特征,从而实现不同地物的准确匹配。

图8

图8

本文网络可视化结果图

Fig.8

The visualization results of the network in this paper

2.3.3 Hpatches数据集实验分析

为验证本文网络ELSK-NCNet的泛化性,在Hpatches数据集上进行测试,结果如表3 所示,本文网络多项MMA精度评定指标均优于对比网络。其中在光照变化下阈值为5个像素时,MMA精度高达0.98,与对比网络SuperPoint,R2D2,NCNet,Sparse-NCNet,LoFTR相比分别提高25.64%,15.29%,7.69%,7.69%和3.16%。在视角变化下阈值为5个像素时,MMA精度达0.84,与SuperPoint,R2D2,NCNet,Sparse-NCNet,LoFTR网络相比,分别提高25.37%,9.09%,20.00%,1.20%和7.69%。结果表明,ELSK-NCNet网络具有良好的泛化性。

2.4 消融实验

本文提出的大核选择性卷积增强模块由大核选择性卷积核卷积结构(large selective Kernel convolution,LSKC)和空间重构单元(spatial reconstruction unit,SRU)构成,消融实验结果见表4 。原始的稀疏邻域共识网络在Google Earth数据集上的MSE值为0.971,RMSE值为0.985,MAE值为0.530; 使用LSKC后,MSE值为0.971,提升0.90%,RMSE值为0.981,提升0.41%,MAE值为0.492,提升7.17%; 使用SRU后,MSE值为0.889,提升8.44%,RMSE值为0.943,提升4.26%,MAE值为0.447,提升15.7%; 同时使用LSKC和SRU后,MSE值为0.884,提升8.96%,RMSE值为0.940,提升4.57%,MAE值为0.463,提升12.64%。证明了本文方法的有效性。

3 结论

本文提出了一种基于稀疏邻域共识网络,融合大核选择性卷积增强模块的遥感图像特征匹配网络,旨在解决遥感图像中不同目标地物所需上下文信息不同导致的细节信息提取丢失问题,主要结论如下:

1)本文网络以ResNet-34的输出作为输入,利用大核选择性卷积增强模块加强重要特征信息的表达,并动态获取多尺度特征信息; 同时,结合跳跃连接有效融合了深层和浅层特征。此外,通过引入几何一致性和运动一致性约束,对稀疏邻域共识网络获取的初始匹配点对进行优化,从而提升了遥感图像特征点的匹配精度。

2)实验结果表明,相较于对比方法,本文所提出的网络在Google Earth和WHU-RS19数据集上的匹配精度上有明显提升。同时,本文网络在Hpatches数据集上也展现出了良好的泛化能力。

然而,在地物特征不明显的区域,仍然存在一定的匹配误差。为进一步提升精度,未来工作将致力于在保持高精度匹配能力的同时,增强模型在地物特征不明显区域的特征提取和匹配能力。

参考文献

View Option

[1]

Girard N Charpiat G Tarabalka Y . Aligning and updating cadaster maps with aerial images by multi-task,multi-resolution deep learning

[C]// Computer Vision - ACCV 2018 . Cham : Springer International Publishing , 2019 :675 -690 .

[本文引用: 1]

[2]

[本文引用: 1]

Xue B Wang Y Z Liu S H et al . Change detection of high-resolution remote sensing images based on Siamese network

[J]. Remote Sensing for Natural Resources , 2022 , 34 (1 ):61 -66 .doi:10.6046/zrzyyg.2021122 .

[本文引用: 1]

[3]

Seo S Choi J S Lee J et al . UPSNet:Unsupervised pan-sharpening network with registration learning between panchromatic and multi-spectral images

[J]. IEEE Access , 2020 ,8:201199 -201217 .

[本文引用: 1]

[4]

Li X Feng R Guan X et al . Remote sensing image mosaicking:Achievements and challenges

[J]. IEEE Geoscience and Remote Sensing Magazine , 2019 , 7 (4 ):8 -22 .

[本文引用: 1]

[5]

李星华 , 艾文浩 , 冯蕊涛 , 等 . 遥感影像深度学习配准方法综述

[J]. 遥感学报 , 2023 , 27 (2 ):267 -284 .

[本文引用: 1]

Li X H Ai W H Feng R T et al . Survey of remote sensing image registration based on deep learning

[J]. National Remote Sensing Bulletin , 2023 , 27 (2 ):267 -284 .

DOI:10.11834/jrs.20235012

URL

[本文引用: 1]

[6]

DeTone D Malisiewicz T Rabinovich A . SuperPoint:Self-supervised interest point detection and description

[C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW) .June 18-22,2018,Salt Lake City,UT,USA.IEEE,2018:337 -33712 .

[本文引用: 1]

[7]

Laguna A B Riba E Ponsa D et al . Key.Net:Keypoint detection by handcrafted and learned CNN filters

[C]// 2019 IEEE/CVF International Conference on Computer Vision (ICCV) .October 27-November 2,2019.Seoul,Korea.IEEE,2019:5835 -5843 .

[本文引用: 1]

[8]

Simonyan K Zisserman A . Very deep convolutional networks for large-scale image recognition

[EB/OL]. 2014 :1409.1556.https://arxiv.org/abs/1409.1556v6.

URL

[本文引用: 1]

[9]

Yang Z Dan T Yang Y . Multi-temporal remote sensing image registration using deep convolutional features

[J]. IEEE Access , 2018 ,6:38544 -38555 .

[本文引用: 1]

[10]

Revaud J De Souza C Humenberger M et al . R2d2:Reliable and repeatable detector and descriptor

[J]. Advances in neural information processing systems , 2019 ,32.

[本文引用: 1]

[11]

Rocco I Cimpoi M Arandjelović R et al . Neighbourhood consensus networks

[C]// Proceedings of the 32nd International Conference on Neural Information Processing Systems.December 3 - 8,2018,Montréal,Canada .ACM, 2018 :1658 -1669 .

[本文引用: 2]

[12]

Li X Han K Li S et al . Dual-resolution correspondence networks

[C]// Proceedings of the 34th International Conference on Neural Information Processing Systems.December 6 - 12,2020,Vancouver,BC,Canada .ACM, 2020 :17346 -17357 .

[本文引用: 1]

[13]

Rocco I Arandjelović R Sivic J et al . Efficient neighbourhood consensus networks via submanifold sparse convolutions

[C]// Computer Vision - ECCV 2020 . ACM , 2020 :605 -621 .

[本文引用: 1]

[14]

陈颖 , 张祺 , 李文举 , 等 . 参数合成空间变换网络的遥感图像一致性配准

[J]. 中国图象图形学报 , 2021 , 26 (12 ):2964 -2980 .

[本文引用: 1]

Chen Y Zhang Q Li W J et al . Consistent registration of remote sensing images in parametric synthesized spatial transformation network

[J]. Journal of Image and Graphics , 2021 , 26 (12 ):2964 -2980 .

DOI:10.11834/jig.200587

URL

[本文引用: 1]

[15]

Vaswani A Shazeer N Parmar N et al . Attention is all you need

[J]. Advances in neural information processing systems , 2017 ,30.

[本文引用: 1]

[16]

Sun J Shen Z Wang Y et al . LoFTR:Detector-free local feature matching with transformers

[C]// 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 20-25,2021,Nashville,TN,USA .IEEE, 2021 :8918 -8927 .

[本文引用: 1]

[18]

Lau K W Po L M Rehman Y A U . Large separable kernel attention:Rethinking the large kernel attention design in CNN

[J]. Expert Systems with Applications , 2024 ,236:121352.

[本文引用: 1]

[19]

Li X Wang W Hu X et al . Selective kernel networks

[C]// 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 15-20,2019 . Long Beach,CA,USA.IEEE , 2019 :510 -519 .

[本文引用: 1]

[20]

Li J Wen Y He L . SCConv:Spatial and channel reconstruction convolution for feature redundancy

[C]// 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 17-24,2023,Vancouver,BC,Canada .IEEE,2023:6153 -6162 .

[本文引用: 1]

[21]

Park J H Nam W J Lee S W . A two-stream symmetric network with bidirectional ensemble for aerial image matching

[J]. Remote Sensing , 2020 , 12 (3 ):465 .

DOI:10.3390/rs12030465

URL

[本文引用: 2]

In this paper, we propose a novel method to precisely match two aerial images that were obtained in different environments via a two-stream deep network. By internally augmenting the target image, the network considers the two-stream with the three input images and reflects the additional augmented pair in the training. As a result, the training process of the deep network is regularized and the network becomes robust for the variance of aerial images. Furthermore, we introduce an ensemble method that is based on the bidirectional network, which is motivated by the isomorphic nature of the geometric transformation. We obtain two global transformation parameters without any additional network or parameters, which alleviate asymmetric matching results and enable significant improvement in performance by fusing two outcomes. For the experiment, we adopt aerial images from Google Earth and the International Society for Photogrammetry and Remote Sensing (ISPRS). To quantitatively assess our result, we apply the probability of correct keypoints (PCK) metric, which measures the degree of matching. The qualitative and quantitative results show the sizable gap of performance compared to the conventional methods for matching the aerial images. All code and our trained model, as well as the dataset are available online.

[22]

Dai D Yang W . Satellite image classification via two-layer sparse coding with biased image representation

[J]. IEEE Geoscience and Remote Sensing Letters , 2011 , 8 (1 ):173 -176 .

DOI:10.1109/LGRS.2010.2055033

URL

[本文引用: 1]

[23]

Balntas V Lenc K Vedaldi A et al . HPatches:A benchmark and evaluation of handcrafted and learned local descriptors

[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).July 21-26,2017,Honolulu,HI,USA .IEEE,2017:3852 -3861 .

[本文引用: 1]

Aligning and updating cadaster maps with aerial images by multi-task,multi-resolution deep learning

1

2019

... 遥感图像特征点匹配旨在识别和建立不同时间或视角下遥感图像中同名像点的对应关系,这一过程为后续遥感图像的变化检测与分析[1 -2 ] 、图像融合[3 ] 和图像拼接及配准[4 ] 等工作提供了重要依据.然而,在实际场景中,遥感图像中的地物场景具有多尺度、纹理相似以及复杂多变等特点,可能会造成误匹配,甚至无法匹配等问题. ...

基于孪生注意力网络的高分辨率遥感影像变化检测

1

2022

... 遥感图像特征点匹配旨在识别和建立不同时间或视角下遥感图像中同名像点的对应关系,这一过程为后续遥感图像的变化检测与分析[1 -2 ] 、图像融合[3 ] 和图像拼接及配准[4 ] 等工作提供了重要依据.然而,在实际场景中,遥感图像中的地物场景具有多尺度、纹理相似以及复杂多变等特点,可能会造成误匹配,甚至无法匹配等问题. ...

基于孪生注意力网络的高分辨率遥感影像变化检测

1

2022

... 遥感图像特征点匹配旨在识别和建立不同时间或视角下遥感图像中同名像点的对应关系,这一过程为后续遥感图像的变化检测与分析[1 -2 ] 、图像融合[3 ] 和图像拼接及配准[4 ] 等工作提供了重要依据.然而,在实际场景中,遥感图像中的地物场景具有多尺度、纹理相似以及复杂多变等特点,可能会造成误匹配,甚至无法匹配等问题. ...

UPSNet:Unsupervised pan-sharpening network with registration learning between panchromatic and multi-spectral images

1

2020

... 遥感图像特征点匹配旨在识别和建立不同时间或视角下遥感图像中同名像点的对应关系,这一过程为后续遥感图像的变化检测与分析[1 -2 ] 、图像融合[3 ] 和图像拼接及配准[4 ] 等工作提供了重要依据.然而,在实际场景中,遥感图像中的地物场景具有多尺度、纹理相似以及复杂多变等特点,可能会造成误匹配,甚至无法匹配等问题. ...

Remote sensing image mosaicking:Achievements and challenges

1

2019

... 遥感图像特征点匹配旨在识别和建立不同时间或视角下遥感图像中同名像点的对应关系,这一过程为后续遥感图像的变化检测与分析[1 -2 ] 、图像融合[3 ] 和图像拼接及配准[4 ] 等工作提供了重要依据.然而,在实际场景中,遥感图像中的地物场景具有多尺度、纹理相似以及复杂多变等特点,可能会造成误匹配,甚至无法匹配等问题. ...

遥感影像深度学习配准方法综述

1

2023

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

遥感影像深度学习配准方法综述

1

2023

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

SuperPoint:Self-supervised interest point detection and description

1

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

Key.Net:Keypoint detection by handcrafted and learned CNN filters

1

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

Very deep convolutional networks for large-scale image recognition

1

2014

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

Multi-temporal remote sensing image registration using deep convolutional features

1

2018

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

R2d2:Reliable and repeatable detector and descriptor

1

2019

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

Neighbourhood consensus networks

2

2018

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

... 本文沿用了Rocco等提出的弱监督损失函数[11 ] .该方法假设待匹配的2幅图像IA 和IB 可成功匹配,则通过计算相关张量并使用Softmax函数,可得到匹配结果和匹配得分.对于成功匹配的图像,目标是最大化匹配得分; 而对于无法匹配的图像,则最小化匹配得分.损失函数的具体公式如下: ...

Dual-resolution correspondence networks

1

2020

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

Efficient neighbourhood consensus networks via submanifold sparse convolutions

1

2020

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

参数合成空间变换网络的遥感图像一致性配准

1

2021

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

参数合成空间变换网络的遥感图像一致性配准

1

2021

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

Attention is all you need

1

2017

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

LoFTR:Detector-free local feature matching with transformers

1

2021

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

Visual attention network

1

2023

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

Large separable kernel attention:Rethinking the large kernel attention design in CNN

1

2024

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

Selective kernel networks

1

2019

... 目前,遥感图像的特征点匹配主要围绕2方面展开: 传统特征点匹配方法和以神经网络为核心的特征点匹配方法.其中,传统特征点匹配方法通过提取待匹配图像中关键点特征描述符来建立特征之间的匹配关系,但该类方法面对地物场景复杂的遥感图像时匹配精度较低.相较之下,神经网络凭借其对图像深层特征的有效提取,为遥感图像特征点的匹配研究提供了新思路[5 ] .Detone等[6 ] 以合成数据集为训练样本,根据其空间关系构造损失函数,提高了特征提取在几何畸变方面的鲁棒性.Laguna等[7 ] 联合Harris角点特征与卷积神经网络(convolutional neural network, CNN)深层特征,充分考虑尺度信息,融合浅层与深层特征.Simonyan等[8 ] 提出的VGGNet能有效准确提取深层特征.Yang等[9 ] 使用预训练的视觉几何组网络(visual geometry group net,VGGNet)作为特征提取网络,联合不同卷积层的特征描述符,取得了较好的匹配效果.Revaud等[10 ] 以L2-Net作为特征提取网络,提出重复性和可靠性的概念以获取更精确的图像匹配关系.Rocco等[11 ] 提出采用4D卷积细化相关图的邻域共识网络(neighbourhood consensus networks, NCNet),以过滤误匹配点对.Li等[12 ] 进一步在更高分辨率特征图上对NCNet输出结果进行二次匹配.为解决4D卷积占据内存大,执行时间长等问题,Rocco等[13 ] 提出使用稀疏相似度张量和子流形稀疏卷积匹配特征以弥补不足的缺陷.陈颖等[14 ] 通过改进参数加权合成的空间变化网络,捕获图像间复杂的非线性变换关系.此外,Vaswani等[15 -16 ] 提出的Transformer结构可有效捕捉图像特征的长距离依赖关系,但其在局部细节特征匹配中表现不理想.综上所述,在处理覆盖地物类型复杂、尺度变化范围大的遥感图像时,CNN在提取图像细节特征方面表现出色.然而,受制于其有限的感受野范围和固定组合的卷积结构,CNN难以有效捕获不同目标地物的上下文信息,而使用堆叠的深度卷积核[17 -18 ] 替换选择性卷积核卷积结构[19 ] 中的普通卷积核能有效解决感受野范围问题,实现不同地物特征的动态提取. ...

SCConv:Spatial and channel reconstruction convolution for feature redundancy

1

... 鉴于此,通过对ResNet34网络引入空间重构单元[20 ] 和大核选择性卷积核卷积结构,本文提出了一种结合大核选择性卷积增强模块的遥感图像特征点匹配网络,在使用空间重构单元增强特征信息表达的基础上,结合大核选择性卷积核卷积结构来获取目标地物更广泛的上下文信息,并通过跳跃连接将经过大核选择性卷积增强模块输出的深层特征与ResNet34输出的浅层特征融合,实现动态获取遥感图像的多尺度细节信息,减少特征点的误匹配干扰.为进一步优化匹配结果,附加几何一致性和运动一致性约束,对稀疏邻域共识网络获取的初始匹配点对进行优化,达到提高遥感图像特征点匹配精度的目的. ...

A two-stream symmetric network with bidirectional ensemble for aerial image matching

2

2020

... 将本文方法与特征点提取网络SuperPoint和R2D2,以及端到端的特征点提取与匹配网络NCNet,Sparse-NCNet,LoFTR和Two-Stream分别在Google Earth数据集[21 ] 和WHU-RS19[22 ] 数据集上进行匹配准确性性能评估,在Hpatches数据集[23 ] 上进行泛化性验证,实验数据集详细信息如下: ...

... 2) WHU-RS19数据集由从谷歌卫星图像上获取的遥感图像制作而成.图像尺寸为600像素×600像素,共1 005张.同一类别的图像样本是从不同分辨率的卫星图像中的多个区域采集的,因此其尺度、方向和光照各异.按照Park等[21 ] 提出的随机仿射变换方法,生成测试数据集. ...

Satellite image classification via two-layer sparse coding with biased image representation

1

2011

... 将本文方法与特征点提取网络SuperPoint和R2D2,以及端到端的特征点提取与匹配网络NCNet,Sparse-NCNet,LoFTR和Two-Stream分别在Google Earth数据集[21 ] 和WHU-RS19[22 ] 数据集上进行匹配准确性性能评估,在Hpatches数据集[23 ] 上进行泛化性验证,实验数据集详细信息如下: ...

HPatches:A benchmark and evaluation of handcrafted and learned local descriptors

1

... 将本文方法与特征点提取网络SuperPoint和R2D2,以及端到端的特征点提取与匹配网络NCNet,Sparse-NCNet,LoFTR和Two-Stream分别在Google Earth数据集[21 ] 和WHU-RS19[22 ] 数据集上进行匹配准确性性能评估,在Hpatches数据集[23 ] 上进行泛化性验证,实验数据集详细信息如下: ...