0 引言

城市绿地是指以自然植被和人工植被为主要存在形态的地表层,其尺度不一,分布范围广,且某些绿地与城市中的农田交错,在分类时极易被混淆,这使得中低空间分辨率的遥感影像难以满足高精度分类的要求。国内外已有较多高空间分辨率遥感影像提取城市绿地的相关研究。传统的人工目视解译方法精度较高,但耗时耗力,且要求解译人员具有丰富的先验知识。Liu等[3]结合支持向量机(support vector machine,SVM)和决策树方法,采用WorldView-2数据对东海区域漂浮的红树林进行监测; Zylshal等[4]结合了SVM和面向对象相似性度量的方法搭建了城市绿地提取的框架,抑制了主观性因素,提升了分类效率。此类方法大多基于像元光谱特征差异的分析,在分类时容易混淆光谱相似的地物。研究表明,上下文特征具备丰富的空间信息,Xu等[5]利用灰度共生矩阵提出了农田自动分层提取的架构; Zujovic等[6]在图像分类过程中加入纹理指标,消除了结果中的椒盐现象。然而,以上方法均依赖于人机交互,且参数设置十分复杂。

近年来广为关注的深度学习语义分割网络兼具计算机视觉的速度与精度。语义分割是指通过语义单元将图像分割为若干具有不同语义标识的区域,进而产生按类分割的影像[7]。最初结合深度学习的语义分割方法以卷积神经网络(convolutional neural networks,CNN)为主,其将每个像元周围固定尺寸的邻域划分成一个像元块,再对每个像元块进行训练和分类,得到的结果为该像元块中心像素的类别[8]。但CNN对每个像元都要进行区域划分和全程卷积运算,计算量庞大[9]。2014年Long等[10]提出的全卷积网络(fully convolutional networks,FCN)使用反卷积层取代CNN的全连接层,将分辨率减小的特征图进行上采样,还原输入图像的尺寸,降低运算量且解除了输入图像的尺寸限制。此后,以FCN为基础改进的大量语义分割网络方法纷纷涌现[11,12,13,14,15]。其中DeepLab网络模型延续了FCN所采取的全卷积操作,并进行了空洞卷积、金字塔池化等改进,近年来已被广泛应用于图像处理任务[16,17,18,19,20]。DeepLab系列网络结构在近2 a不断更新[21,22,23],其中DeepLabv3+是该网络模型的最新改进,它结合了编码-解码架构(encoder-decoder)和多孔空间金字塔池化(atrous spatial pyramid pooling,ASPP)的优点,通过逐渐恢复空间信息来捕捉清晰的目标边界[23]。在PASCAL VOC 2012数据集上的测试中,DeepLabv3+网络的精度指标突破新高,是目前最为成熟的语义分割网络之一,但仍鲜有学者将此类方法应用于高分辨率遥感影像的城市绿地提取。

基于以上讨论,本文提出一种基于DeepLabv3+网络的高分辨率遥感影像提取城市绿地架构,旨在实现更精确、自动化程度更高的城市绿地提取。通过多种方法的精度对比和本文架构的多地区应用,分别探究本方法的精度优势和迁移能力。

1 样本区域及数据来源

1.1 样本区域

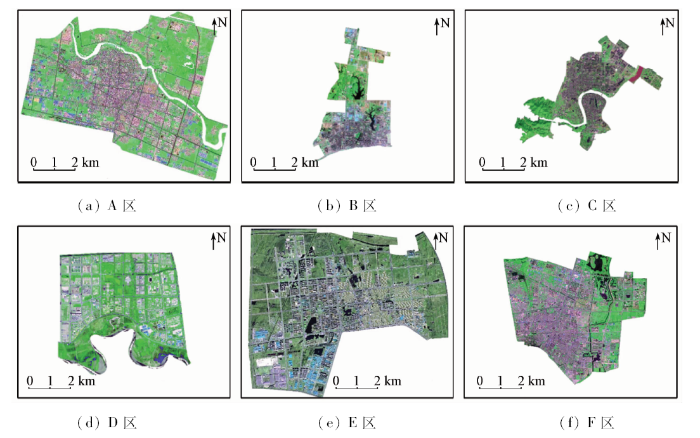

如图1所示,样本区域位于全国6个省份(包括内蒙古自治区、湖北省、广东省、江苏省、河北省及河南省)的6个城市的建成区,下文中分别以A—F区表示。其中A—D区的数据作为训练样本来源参与模型的训练,E区数据作为测试样本来源用于评估本文架构和其他方法的分类精度,F区数据用于探究本文架构的迁移能力。

图1

1.2 数据来源

高分二号(GF-2)卫星是中国自主发射的民用光学遥感卫星,提供空间分辨率为1 m的全色波段和4个空间分辨率为4 m的多光谱波段数据,因其高清晰度和高几何精准度被广泛应用于测绘、国土监测和规划、灾后救援等任务[24]。本文所用数据为6个样本城市不同季节GF-2 PMS2的B3(R),B2(G),B1(B)波段合成影像及地面真值,影像成像时间分别为2016年的3月8日、7月 9 日、11月28日、9月16日、10月8日、6月2日; 地面真值包括城市绿地、农田和其他地物共3类。各景影像的云层覆盖率均低于5%。遥感影像获取于资源卫星应用中心官网,地面真值数据由中国住房和城乡建设部提供。考虑到某些城市在短期内可能受到政策影响,土地类型发生变更,因此,作者先对6景遥感影像及地面真值进行比对,修改错误地类; 对于部分无法明确判别的像元,进一步参考Google Earth影像进行判定和修正。

2 研究方法

2.1 城市绿地提取架构概述

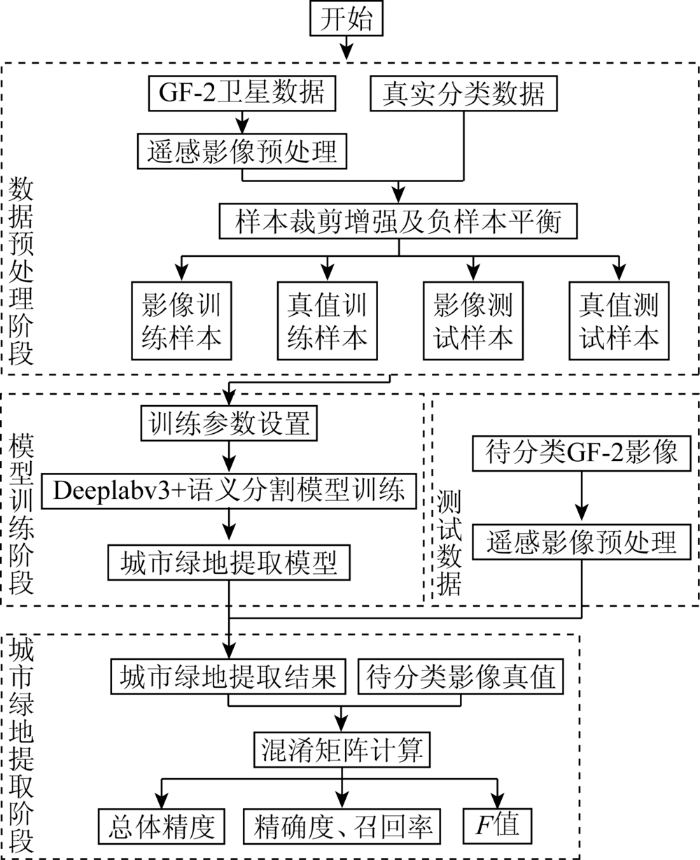

本文提出一种基于DeepLabv3+网络的GF-2城市绿地提取架构。架构包含3层,分别是数据预处理与数据集构建、语义分割模型训练和城市绿地提取,如图2所示。

图2

图2

GF-2遥感影像城市绿地自动化提取流程

Fig.2

Urban green space automatic extraction process of GF-2 imagery

2.2 数据集创建

2.2.1 遥感影像预处理

首先使用影像自带的有理多项式系数(rational polynomial coefficient,RPC)参数分别对全色波段和多光谱波段进行RPC正射校正; 使用Pan-sharp融合方法进行图像融合,融合影像具有两者的优势,既具有全色图像的空间信息,又具有多光谱图像的光谱信息; 本文使用指数增强法进行图像增强。经预处理得到6个样本城市的GF-2 B3(R),B2(G),B1(B)波段合成影像,空间分辨率为1 m。

2.2.2 样本创建策略

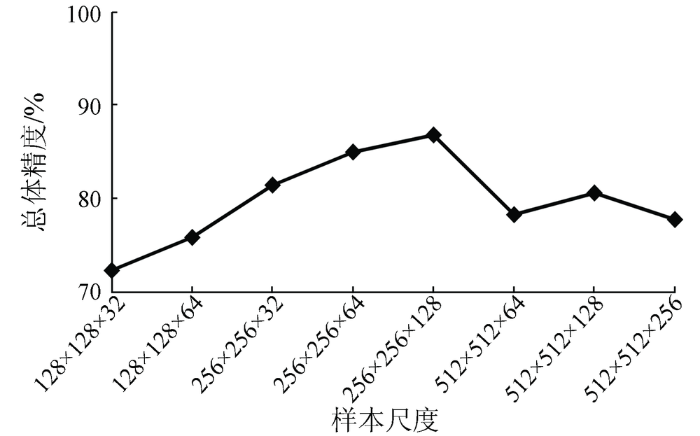

为了进一步区分城市绿地与农田,本文将农田单独列为一类参与训练,即样本真值包含3类: 城市绿地(像元值为1)、农田(像元值为2)、其他地物(像元值为0)。由于整幅影像尺寸较大,计算机内存无法支持全图输入,需要对样本进行切割[25]。在高空间分辨率影像中,城市绿地与农田像元的最大区别体现在,前者呈不规则形状排布,后者多为边缘整齐的多边形,且农田的纹理相比城市绿地而言更为细腻。当单样本尺寸过小,会破坏地物形状及纹理特征,降低农田与绿地的区分度; 样本尺寸太大会消耗大量内存,且易出现过拟合的现象[26]。因此,本文基于多尺度样本的分类实验,探究最适宜城市绿地提取的样本尺寸。如图3所示,当城市绿地样本的切割大小为256×256像素,切割步长为128时,总体分类精度最高。

图3

2.3 模型训练

2.3.1 DeepLabv3+网络

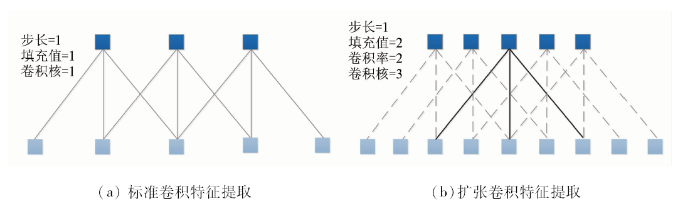

DeepLabv3+语义分割网络模型的最大特点是在DeepLabv3的基础上采用了编码-解码架构,其整体的网络结构如图4所示。DeepLabv3+结构设计了多个不同空洞率的空洞卷积模块,可在多尺度上探测卷积特征,编码全局上下文特征。空洞卷积的原理如图5所示,该方式在增大卷积感受野的同时,卷积层不会降低空间维度,也不会增加参数数量,实现精度与速度的均衡。此外,也可以明确地控制神经网络特征响应的空间分辨率。网络的解码部分采用一个简单有效的模块。编码器输出的特征先经过双线性上采样4倍得到特征层A,再取解码器中对应着相同分辨率的特征层,经过1×1卷积降通道得到特征层B,然后对特征A和B进行concat函数连接操作,再经过3×3卷积细化特征,最终通过双线性上采样4倍得到预测结果。

图4

图5

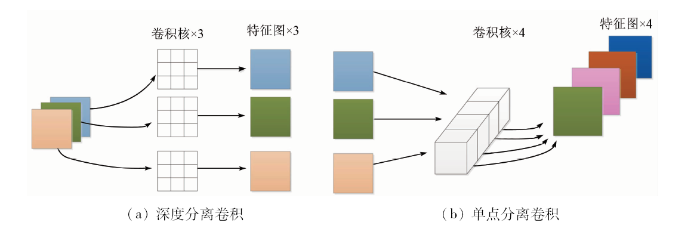

DeepLabv3+还将空洞卷积与深度分离卷积结合,形成扩张分离卷积,应用于ASPP模块和解码结构中。2种卷积的结合可以在减少运算量的同时保证分类效果。深度可分离卷积把标准卷积分解为深度卷积和逐点卷积,原理如图6所示,其中深度卷积独立地对每个输入通道做空间卷积,逐点卷积用于结合深度卷积的输出。

图6

2.3.2 硬件配置及参数设置

实验以TensorFlow作为开发框架,计算机硬件配置为GTX 1070GPU,11 G显存,128 G内存,能快速实现语义分割模型的训练和测试。网络训练前要对模型参数进行设置: 通道个数及类别数均设置为3; batch size设为4; 设置100个epoch; 基础学习率设为1E-3; 学习策略为ploy方式,power=0.9; 梯度下降方式选择SGD(随机梯度下降)。

为了证明本架构在高空间分辨率遥感影像提取城市绿地方面的优越性,采用最大似然法(maximum likelihood, ML)、支持向量机(support vector machine, SVM)和随机森林法(random forest, RF)3种传统的机器学习方法以及PspNet,SegNet,U-Net和DeepLabv2 4种典型的语义分割网络与DeepLabv3+网络进行实验对比。3种传统方法实验采用R,G,B 3波段影像,基于ENVI软件完成,ML法参数设置包括: 概率阈值为0.2,数据比例因子为255,核类型为径向基函数,核函数Gamma值为1/3; SVM参数设置包括: 惩罚参数为100,金字塔级别为0,分类概率阈值为0,分支数为100,特征数为Square Root; RF法参数设置为: 异质函数为Gini Coefficient,最小节点采样数为1,最小异质为0。5种语义分割网络的训练样本及参数设置保持一致。

2.4 城市绿地提取

2.4.1 精度评价指标

混淆矩阵是最常用且科学的遥感影像分类评价指标,基于混淆矩阵计算出的常用指标有: 精确度(Precision)、召回率(Recall)、F值和总体精度(Overall Accuracy,OA)。其中OA代表所有正确分类的像元占总像元的比例; Precision代表各类分类结果中正确像元所占的比例; Recall代表各类正确分类的像元占真值的比例; F值又称为总体精度和精确度的调和平均,在二分类模型中具有较强的客观性。

2.4.2 精度评估策略

整景测试影像尺寸较大,难以进行逐像素评估,因此本文从处理后的E区影像及地面真值中随机选取6组尺寸为2 048×2 048像元的测试切片用于精度评估,如图7所示。

图7

图7

6组测试影像切片及对应真值

Fig.7

Six validation slices with of test images and their GT labels.

3 结果与讨论

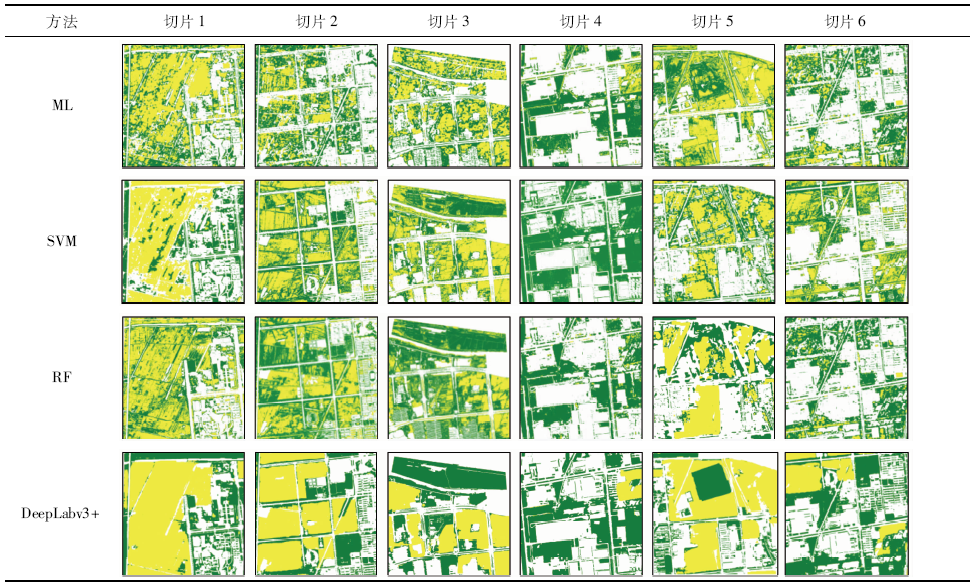

3.1 传统方法结果对比

表2 传统方法结果精度对比

Tab.2

| 指标 | 方法 | 切片1 | 切片2 | 切片3 | 切片4 | 切片5 | 切片6 | 平均值 |

|---|---|---|---|---|---|---|---|---|

| Precision/% | ML | 52.28 | 41.18 | 44.77 | 75.87 | 50.40 | 63.70 | 54.70 |

| SVM | 68.42 | 54.87 | 69.74 | 76.37 | 43.71 | 58.39 | 61.92 | |

| RF | 56.64 | 59.30 | 59.97 | 69.14 | 41.69 | 60.55 | 57.88 | |

| DeepLabv3+ | 88.63 | 86.54 | 88.2 | 86.49 | 81.23 | 86.99 | 86.35 | |

| Recall/% | ML | 60.13 | 61.61 | 59.26 | 78.12 | 67.67 | 63.08 | 64.98 |

| SVM | 79.67 | 70.57 | 67.88 | 80.99 | 67.94 | 64.72 | 71.96 | |

| RF | 59.37 | 68.95 | 65.17 | 75.68 | 69.27 | 64.09 | 67.09 | |

| DeepLabv3+ | 83.42 | 87.11 | 86.96 | 78.73 | 88.08 | 86.26 | 85.09 | |

| F值 | ML | 0.56 | 0.50 | 0.51 | 0.77 | 0.56 | 0.63 | 0.59 |

| SVM | 0.74 | 0.62 | 0.69 | 0.79 | 0.53 | 0.61 | 0.66 | |

| RF | 0.58 | 0.64 | 0.62 | 0.72 | 0.52 | 0.62 | 0.62 | |

| DeepLabv3+ | 0.86 | 0.87 | 0.88 | 0.82 | 0.85 | 0.87 | 0.86 | |

| OA/% | ML | 73.99 | 65.29 | 64.12 | 81.11 | 74.94 | 72.42 | 71.98 |

| SVM | 84.32 | 75.98 | 80.60 | 82.18 | 71.41 | 69.19 | 77.68 | |

| RF | 76.37 | 78.48 | 75.32 | 76.51 | 69.48 | 70.61 | 74.46 | |

| DeepLabv3+ | 92.51 | 92.74 | 92.23 | 87.24 | 92.28 | 90.68 | 91.02 |

传统方法的提取效果次于语义分割网络,是由于传统方法仅考虑了像元间的浅层特征,忽略了目标的深层语义信息。有研究表明,结合面向对象的思想或参考纹理等空间信息可以提升传统方法的分类性能,但此类方法都需要专家的先验知识和复杂的参数设置。

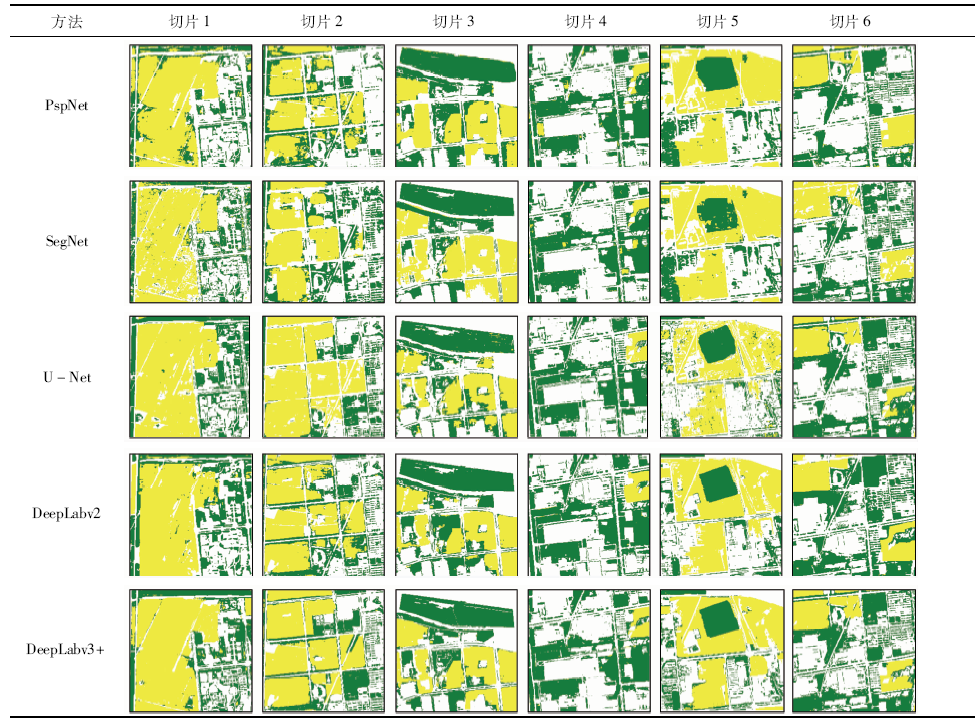

3.2 语义分割网络结果对比

表4 语义分割网络结果精度对比

Tab.4

| 指标 | 方法 | 切片1 | 切片2 | 切片3 | 切片4 | 切片5 | 切片6 | 平均值 |

|---|---|---|---|---|---|---|---|---|

| Precision/% | PspNet | 74.13 | 72.81 | 82.62 | 83.78 | 73.85 | 72.36 | 76.59 |

| SegNet | 76.34 | 70.09 | 81.94 | 85.79 | 78.66 | 78.69 | 78.59 | |

| U-Net | 85.83 | 77.58 | 78.42 | 81.42 | 75.62 | 78.67 | 79.59 | |

| DeepLabv2 | 74.09 | 81.41 | 81.03 | 86.19 | 72.91 | 74.30 | 78.32 | |

| DeepLabv3+ | 88.63 | 86.54 | 88.20 | 86.49 | 81.23 | 86.99 | 86.35 | |

| Recall/% | PspNet | 81.62 | 71.18 | 83.63 | 75.21 | 72.14 | 75.52 | 76.55 |

| SegNet | 80.83 | 85.19 | 78.70 | 73.68 | 74.20 | 85.67 | 79.71 | |

| U-Net | 80.31 | 86.99 | 78.10 | 73.30 | 72.55 | 85.41 | 79.45 | |

| DeepLabv2 | 78.31 | 81.52 | 88.82 | 81.49 | 74.80 | 79.81 | 80.79 | |

| DeepLabv3+ | 83.42 | 87.11 | 86.96 | 78.73 | 88.08 | 86.26 | 85.09 | |

| F值 | PspNet | 0.77 | 0.72 | 0.83 | 0.79 | 0.73 | 0.74 | 0.77 |

| SegNet | 0.79 | 0.77 | 0.80 | 0.79 | 0.76 | 0.82 | 0.79 | |

| U-Net | 0.83 | 0.82 | 0.78 | 0.77 | 0.75 | 0.80 | 0.79 | |

| DeepLabv2 | 0.76 | 0.81 | 0.85 | 0.84 | 0.75 | 0.76 | 0.79 | |

| DeepLabv3+ | 0.86 | 0.87 | 0.88 | 0.82 | 0.85 | 0.87 | 0.86 | |

| OA/% | PspNet | 87.13 | 84.79 | 89.30 | 84.09 | 79.79 | 87.25 | 85.39 |

| SegNet | 87.86 | 85.95 | 87.82 | 84.42 | 85.80 | 89.02 | 86.81 | |

| U-Net | 90.96 | 89.53 | 86.32 | 82.44 | 84.05 | 88.73 | 87.01 | |

| DeepLabv2 | 86.53 | 89.81 | 89.92 | 87.24 | 81.13 | 87.79 | 87.07 | |

| DeepLabv3+ | 92.51 | 92.74 | 92.23 | 86.43 | 89.92 | 92.28 | 91.02 |

如表3所示,从整体而言,本文采用的DeepLabv3+网络具有明显的精度优势,能准确还原绿地分布,也具备区分农田像元的能力。几种网络对比而言,U-Net和DeepLab系列网络善于提取出细节处的城市绿地(切片1和2),例如建筑物周围的草地及道路两旁的行道树。切片3,4,6的结果显示,某些农田像素仍被误判为城市绿地,这是由于它们与周边草地具有相似的地形信息,而DeepLab系列网络在这种情况下表现更好。另一方面,当出现某些和农田形状十分相似的城市绿地时,除了DeepLabv2和DeepLabv3+外,其他几种网络的提取结果均不理想(切片5)。不可否认的是,在某些情况下,模型的精度不理想是由于缺少相关样本,模型未能学习到足够的语义信息。综合6组结果,DeepLabv2和DeepLabv3+不仅可以更好地保留绿地的细节信息,获得规整精细的绿地边缘,还能准确提取出与农田交错的绿地像元,特别是区分形状与农田相似的城市绿地。

表4中的精度对比显示,几个指标的平均最高值(Precision=86.35%; Recall=85.09%; F=0.86; OA=91.02%)均来自DeepLabv3+的分类结果。其他4种网络的精度对比中,DeepLabv2稍具优势。

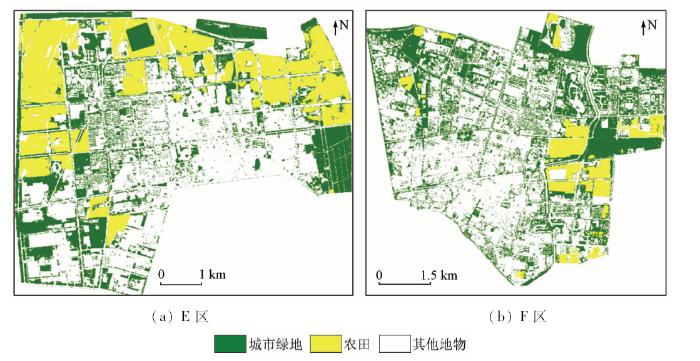

3.3 模型迁移性验证

图8

图8

基于本文架构的E区、F区城市绿地提取结果

Fig.8

The results of entire area E and area F based on the proposed architecture

表5 E区提取精度

Tab.5

| 真值 | 提取结果 | ||

|---|---|---|---|

| 城市绿地 | 非绿地 | 合计 | |

| 城市绿地 | 6 598 | 325 | 6 923 |

| 非绿地 | 253 | 2 824 | 3 077 |

| 合计 | 6 851 | 3 149 | 10 000 |

| Recall/% | 95.30 | ||

| Precision/% | 96.30 | ||

| F值 | 0.95 | ||

| OA/% | 94.22 | ||

表6 F区提取精度

Tab.6

| 真值 | 提取结果 | ||

|---|---|---|---|

| 城市绿地 | 非绿地 | 合计 | |

| 城市绿地 | 6 811 | 523 | 7 334 |

| 非绿地 | 169 | 2 497 | 2 666 |

| 合计 | 6 980 | 3 020 | 10 000 |

| Recall/% | 92.87 | ||

| Precision/% | 97.58 | ||

| F值 | 0.95 | ||

| OA/% | 93.08 | ||

4 结论

高空间分辨率遥感影像为城市地表监测提供了更丰富的空间信息,快速准确地监测城市绿地分布,创建智能化提取流程,对城市可持续发展意义重大。本文提出了一种基于DeepLabv3+语义分割网络的3层架构,旨在实现更高效、更准确地从GF-2影像中提取城市绿地,在实验中得到了如下结论:

1)ML,SVM,RF 3种传统的机器学习算法可以实现影像自动分类,但城市绿地提取结果中无法避免椒盐效应,且无法区分光谱相似的农田像元,分类精度较低,而结合面向对象的思想或引入空间特征均依赖于人机交互,效率较低。

2)深度学习语义分割算法兼具计算机视觉的精度和速度,本架构采用的DeepLabv3+在几种网络中表现最优,精确度、召回率、F值和总体精度分别达到86.35%,85.09%,0.86和91.02%,证明DeepLabv3+可通过其成熟的结构捕获样本中丰富的空间信息和上下文特征,实现了城市绿地的高精度提取,且过程高度自动化。此外,通过不同城市的应用,证明本架构还具备一定的通用性,可为大规模数据的城市监测任务提供参考。

3)总体而言,深度学习语义分割技术具有广阔的应用前景,必将推动遥感图像处理任务的范式转换。由于深度学习网络训练的过程十分复杂且高度封装,本文仍存在不足之处,如未能深入探究深度学习模型在区分农田能力方面的机理依据等。下一步将重点探究网络内部结构对不同地物提取的影响机制。

参考文献

城市绿地遥感信息自动提取研究——以广州市为例

[J].

An automatic extraction model of urban greenbelt remote sensing image:A study on Guangzhou City

[J].

基于GF-1卫星影像的城市绿地信息提取与景观格局研究

[D].

Information extraction and landscape pattern of urban greenbelt based on GF-1 satellite image:A case study of Lanzhou

[D].

Applying a new integrated classification method to monitor shifting mangrove wetlands

[C]//

A support vector machine object-based image analysis approach on urban green space extraction using Pleiades-1A imagery

[J].

Farmland extraction from high spatial resolution remote sensing images based on stratified scale pre-estimation

[J].

Structural texture similarity metrics for image analysis and retrieval

[J].

Automatic classification of high resolution land cover using a new data weighting procedure:The combination of K-means clustering algorithm and central tendency measures(KMC-CTM)

[J].

Object detection via a multi-region and semantic segmentation-aware CNN model

[C]//

Semantic segmentation of aerial images with an ensemble of CNSS

[C]//

Fully convolutional networks for semantic segmentation

[J].

Conditional random fields as recurrent neural networks

[C]//

SegNet:A deep convolutional encoder-decoder architecture for image segmentation

[C]//

Pyramid scene parsing network

[EB/OL].(

U-Net:Convolutional networks for biomedical image segmentation

[C]//

Semantic image segmentation with deep convolutional nets and fully connected CRFs

[J].

采用改进DeepLab网络的遥感图像分割

[J].

Remote sensing image segmentation based on improved DeepLab network

[J].

Skin lesion segmentation using atrous convolution via DeepLabv3

[EB/OL].(

A comparison of deep learning methods for semantic segmentation of coral reef survey images

[C]//

In pixels we trust:From pixel labeling to object localization and scene categorization

[EB/OL] .(

Reinforced evolutionary neural architecture search

[EB/OL].(

DeepLab:Semantic image segmentation with deep convolutional nets, atrous convolution,and fully connected CRFs

[J].

Rethinking atrous convolution for semantic image segmentation

[EB/OL].(

Encoder-decoder with atrous separable convolution for semantic image segmentation

[EB/OL].(

“高分二号”卫星遥感技术

[J].

GF-2 satellite remote sensing technology

[J].

基于SegNet语义模型的高分辨率遥感影像农村建设用地提取

[J].针对传统分类算法、浅层学习算法不适用于高空间分辨率遥感影像中农村建筑物信息提取的问题,该文以河北省霸州市高空间分辨率遥感影像World View-2为数据源,利用182 064幅128×128像素大小的影像切片为训练样本,选取基于深度卷积神经网络的SegNet图像语义分割算法对遥感影像中的农村建筑物进行提取,并与传统分类算法中的最大似然法(maximum likelihood,ML)和ISO聚类、浅层学习算法中的支持向量机(support vector machine,SVM)和随机森林(random forest,RF)以及深层语义分割算法中的金字塔场景解析网络(pyramid scene parsing network,PSPNet)的试验结果作对比分析。研究结果表明:SegNet不仅能够高效利用高空间分辨率遥感影像中农村建筑物的光谱信息而且还能够充分利用其丰富的空间特征信息,最终形成较好的分类模型,该算法在验证样本中的分类总体精度为96.61%,Kappa系数为0.90,建筑物的F1值为0.91,其余5种分类算法的总体精度、Kappa系数、建筑物的F1值都分别在94.68%、0.83、0.87以下。该研究可以为高空间分辨率遥感影像农村建设用地提取研究提供参考。

Rural construction land extraction from high spatial resolution remote sensing image based on SegNet semantic segmentation model

[J].

基于最优尺度选择的高分辨率遥感影像丘陵农田提取

[J].农田测绘与粮食安全密切相关,高效经济的农田测绘是中国政府部门重点关注的工作之一。农田田块是农田测绘的基本要素,从遥感影像中提取农田田块信息是当前研究的热点。然而,丘陵地区农田形状不规则、光谱特征不明显导致农田信息提取困难,该文通过研究最优的农田分割尺度来提高农田田块信息提取的精度。首先,利用各向异性扩散算子在由Sobel得到的梯度图上生成多尺度梯度影像。然后,通过信息熵差异分析得到有效尺度范围。其次,利用标记分水岭算法对农田梯度影像进行分割获得多尺度农田信息。最后,利用非监督的全局评价方法在已得的有效尺度范围内确定农田提取的最优尺度,同时确定最优的农田提取结果。对比试验结果表明,该文方法能够有效地提取丘陵地区的农田田块,精度可以达到73.06%,比Mean-shift方法提取的精度高22.48%。该研究可为中国农田测绘提供技术参考。

Hilly farmland extraction from high resolution remote sensing imagery based on optimal scale selection

[J].The growing population and accelerating urbanization have caused much illegal occupation of farmland, which seriously threat to national food security, social stability and economic development of our country. Farmland information extraction has become a hot issue in agricultural research field in the world. In addition, farmland mapping is closely related to the food security and is one of the most concerned issues of government departments. However, traditional technology of surveying and mapping is time consuming and labor costing, which is unable to adapt to the precise and effective information acquisition of farmland. The high resolution remote sensing imagery can provide more details of ground truth than low resolution imagery. However, the information mining in high resolution remote sensing imagery faces a big challenge caused by the complex ground environment. Farmland blocks in high resolution remote sensing imagery have various shapes, complicated texture and heterogeneous spectrum. The shape information is one of the most important content of farmland mapping. In this study, high resolution remote sensing imagery from QuickBird was used to precisely extract farmland in hilly area. And the method of farmland extraction combining multi-scale segmentation and optimal scale selection was put forward. Firstly, gradient image is generated by using Sobel gradient operator. In order to enhance the edge information and reduce the irrelevant information for farmland extraction, the multi-scale gradient images are filtered with anisotropic diffusion operator. Secondly, effective scale range of multi-scale gradient images is determined through the entropy difference analysis, which can reduce the amount of calculation of the multi-scale analysis in next stage. Thirdly, a marker driven watershed transform based on minima extension and minima imposition is applied to segment the multi-scale gradient images to produce multi-scale shape information of farmland with precious boundaries. Finally, the optimal scale identification for multi-scale segmentation is obtained by unsupervised segmentation evaluation method based on the global Moran'I and variance to automatically get the farmland block without manual intervention. The experimental results show that the multi-scale segmentation and optimal scale identification approach can be used to accurately discriminate farmland in hilly area. Farmland extraction accuracy of the proposed method is 73.06% which is 22.40% higher than the Mean-shift segmentation method with a better performance in farmland extraction in hilly area. The results can basically meet the requirements of drawing and revision for the large scale thematic mapping of farmland, showing that the proposed method can provide a technical assistance for the surveying and mapping of farmland.