0 引言

在SAR目标检测方面,林旭等[4]提出了一种基于自适应背景杂波模型的恒虚警率(constant false-alarm rate,CFAR)宽幅SAR图像舰船检测算法。通过背景窗口的多尺度统计方差判断目标所处的杂波环境,自适应选择对应的背景杂波分布模型; Huang等 [5]提出了一种结合目标语义特征的恒定虚警法,在检测高分辨率SAR图像目标时具有更低的虚警率; Kaplan[6]利用扩展分形(extended fractal,EF)特征检测SAR图像中的车辆目标,该特征不仅对目标背景的对比度敏感,同时也对目标尺寸敏感; 刘冬等[7]利用指数小波分形特征检测SAR图像目标,该方法对目标对比度和尺寸敏感,且考虑了目标边缘特征与区域内部平滑性特征。近年来,随着深度学习的发展,基于卷积神经网络(convolutional neural network,CNN)的SAR图像目标检测方法受到了广泛关注。Fast R-CNN[8],Faster R-CNN[9]和YOLO[10]等目标检测网络被广泛应用于对SAR图像的检测。Kang等[11]提出了结合上下文的检测方法检测SAR图像舰船目标,利用目标周围的背景信息提高检测结果的可靠性,减少了虚警; Wang等[12]使用最大稳定极值区域(maximum stability extremal region,MSER)准则进一步约束目标区域的判定; An等[13]用DRBox-v2(一种旋转边界框)取代传统矩形框标记目标,使得标记选框可以适应不同的目标朝向; 张椰等[14]将目标检测任务转化为像素分类问题,利用全卷积神经网络(fully convolutional neural network,FCN)对图像进行像素级的分类,有效避免了背景杂波的干扰,降低了虚警率。在视频SAR目标跟踪方面,Wang等[15]研究了目标的阴影对视频SAR序列中低雷达散射截面(Radar cross section,RCS)目标跟踪的积极影响; Zhang等[16]提出了一种基于CNN的阴影检测器来提取阴影信息作为定位运动目标的线索; Xu等[17]和Liang等[18]利用核化相关滤波器(kernel correlation filter,KCF)和SiamMask跟踪器对第一帧目标初始化后的阴影进行定位; Zhang等[19]采用尺度不变特征变换(scale-invariant feature transform,SIFT)和随机样本一致性(random sample consensus,RANSAC)配准算法来补偿每帧背景的变化,并采用了一种称为最大化Tallis熵的阈值分割算法,利用三帧差分法对背景差分进行阴影检测; Henke等[20-21]提出了一种基于图像统计和多目标卡尔曼滤波的SAR目标跟踪方法; Ding等[22]采用改进的基于密度的聚类算法对每一帧检测结果进行过滤,并利用设计的双向长短期记忆(bi-directional long-short term memory,Bi-LSTM)网络抑制检测中的缺失报警; Zhao等[23]提出了一种基于时空信息和基于显著性的检测机制来对抗干扰和背景杂波。

近年来,国内对该问题的研究也越来越多。何志华等[24]利用视频SAR帧图像空间域和时间域信息,经过数据配准和相干斑滤波预处理、采用基于改进差分的动目标阴影检测处理和多目标跟踪处理技术,在保证检测率的前提下尽量降低虚警率,实现了视频SAR动目标检测与跟踪; 刘雨洁等[25]融合航迹起始算法与舰船图像特征差异进行长时间间隔序贯图像间的目标匹配,根据速度和加速度设置约束波门,对舰船目标的不同特征设置不同的权值计算目标间的差异,利用差异最小原则筛选航迹,实现目标跟踪; 胡瑶[26]提出了基于改进的无锚点多目标跟踪框架,引入了注意力机制、修改了损失函数并进行了网络结构的优化,进而提升了跟踪效果。然而,现有工作对于SAR图像自身特征的挖掘尚不充分,目标跟踪受到信号强度、障碍遮挡和运动模糊等因素影响较大。这启发本文设计更好的特征表达网络和轨迹关联算法。

针对上述问题,本文提出了基于深度学习的目标检测与跟踪方法。首先,提取出目标的显著特征用于视频SAR动目标检测。由于视频SAR成像机制与可见光成像不同,视频SAR具有其特有的属性。为此,本文分析了视频SAR的统计分布特征、极化散射特征、纹理特征和几何特征等多种特征。通过实验发现,增强图像对比度、纹理均值特征、开运算特征、闭运算特征,作为模型的先验输入,能够提升检测效果。其次,设计了更适合于视频SAR检测的多尺度特征金字塔[27]和特征融合策略,使不同尺度特征之间的融合更加高效便捷。本文提出使用轻量级EfficientDet网络[28]对SAR图像进行检测,并进一步采用Bi-LSTM网络对当前帧上未检测到的目标进行预测。通过分析不同帧下所有锚点框之间的距离关系,为不同目标设置不同的轨迹信息进行轨迹关联,该轨迹优化策略显著提升了视频SAR目标的跟踪效果。

1 多通道特征图目标检测方法

在本小节中,详细介绍了提出的目标检测方法。首先,用多通道特征图构建特征集,对图像进行特征增强; 其次,在深度特征提取阶段,介绍了改进后的多尺度特征金字塔; 接下来,基于上述特征,介绍了采用的轻量EfficientDet目标检测模块; 然后,分别介绍了2种目标轨迹关联方法,即基于目标框的轨迹关联和基于Bi-LSTM的轨迹关联。

1.1 多通道特征图特征增强

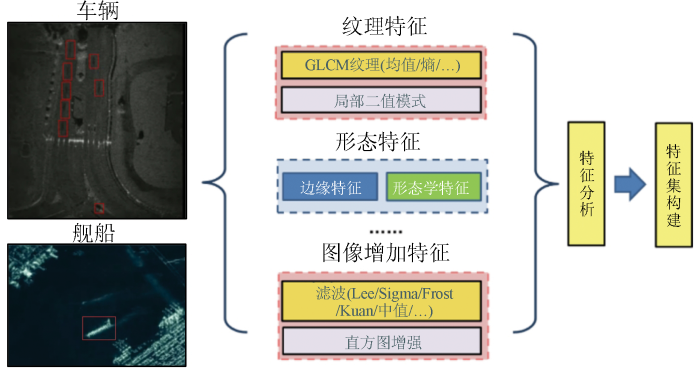

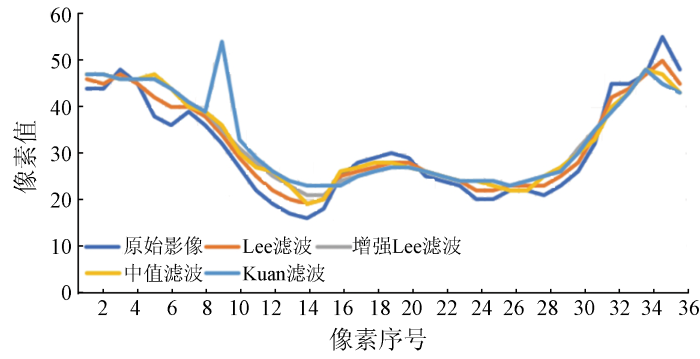

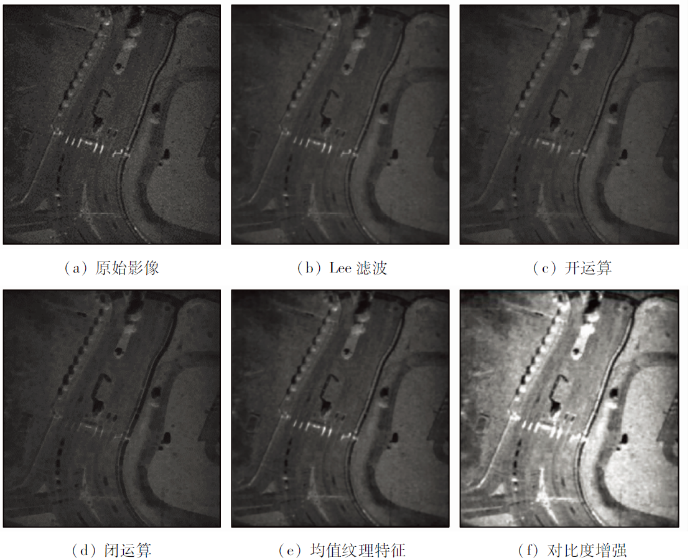

在对目标进行提取之前,进行特征集构建。特征集中的特征从2个方面来考虑: 一方面是去除图像噪声; 另一方面增强目标与周围地物的差异。对于Sandia视频SAR数据的单帧图像,在选取合适的去噪滤波后,进行特征计算。本研究选用Lee滤波去除噪声,窗口为5×5,在去除噪声后,选取4个影像特征和滤波后影像作为特征集。这4个特征分别是: 开运算、闭运算、对比度增强、纹理均值特征。其中,对比度增强采用直方图均衡化方法,纹理均值特征使用基于灰度共生矩阵(gray level co-occurrence matrix,GLCM)的纹理特征。特征集构建的流程如图1所示。

图1

1.2 改进型多尺度特征金字塔

图2

图2

EfficientNet+多尺度特征金字塔网络模型结构

Fig.2

Structure of EfficientNet and the multi-scale feature pyramid

1)自底向上。该过程由EfficientNet主干网络前馈计算而来,其每个阶段最后一层的输出构成金字塔的多个层级,层级间以2为缩放比例。

2)自上向下。由于视频SAR中有相当部分的阴影目标尺度较小,且有一定尺度差异,因而对CNN网络的尺度适应性也提出更高要求。考虑到在经典特征金字塔网络结构中,小尺度目标的识别主要依赖于金字塔低层中空间分辨率较高的特征图层,因此本文选择在经典特征金字塔网络的基础上,以多尺度特征融合的形式将高维特征图中的语义信息注入至低级特征图中,从而进一步提升网络对小尺度阴影目标的检测能力。多尺度特征融合结构如图3所示。

图3

具体而言,多尺度特征融合处理中P2和P3的特征可通过式(1)更新,即

式中: i和j分别为卷积网络和特征空间金字塔的层号索引; Pi为对应Ci的融合特征映射; Con

此外,考虑到视频SAR中的阴影目标尺度多元,除了大量小尺度目标外,还存在大尺度目标,因此,本文在P6高维特征图的基础上通过取步长为2进行下采样得到P7特征图,以在后续目标检测过程中为不同尺度目标提供特定的特征图。为了进一步确保模型效率,令金字塔具体层数与检测目标尺寸相对应。

1.3 基于轻量EfficientDet的目标检测

以多尺度特征金字塔为输入,将在各个尺度特征图上以一定步长逐像素生成多种锚点框,该框的生成过程与区域候选网络(region proposal network,RPN)类似,并针对每个锚点框完成K分类和框回归任务。

1)锚点框生成。该过程与RPN生成锚点框过程类似。为防止不同尺度目标框之间存在重叠现象且保证效率,为不同尺度特征图依次分配单一的锚点框面积超参数,以促使各特征图能在尺度上具有专一性。对于每个锚点框,若与真实标记框交并比大于0.5被视为正样本,小于0.4被视为负样本,[0.4,0.5)的锚点框则被丢弃,以使模型回归更加准确的锚点框。

2)K分类和框回归。该过程用于预测A个锚点框和类在每个空间位置存在目标的概率及与真实地表之间的偏移量。具体而言,使用若干3×3的卷积层对多尺度特征金字塔的逐像素同时进行A×K的类别预测及4A的分类回归,2个任务参数相互独立。在本研究中A取15,分类回归中的4代表中心点横纵坐标和锚点框宽高的偏移量。

在训练阶段,本研究采用多任务损失函数,包含检测框回归损失和目标检测损失,以使网络达到端到端的学习,提高分类性能,定义为:

式中: L为损失函数; Ncls和Nreg分别为目标类别和包围框的个数; i为每次小批量(mini-batch)中的第i个锚点框; Lcls为前景和后景的对数损失,pi为每一个锚点框属于目标的预测概率,

1.4 基于目标检测框的轨迹关联

以目标检测框为输入,最初通过计算上一帧与当前帧所有目标检测框的交并比来判定轨迹关联信息。然而,研究发现仅通过交并比来判定时,会出现轨迹关联不稳定、轨迹编号迅速变化的现象。通过对轨迹关联进行优化能够有效抑制轨迹信息的快速变化。轨迹关联模块如图4所示。

图4

轨迹信息初始化: 将每帧中所有正确检测框和误报检测框的中心坐标表示为q(x,y),x∈[1,M]和y∈[1,N],其中M和N表示每帧的像素大小。通过测量上一帧与当前帧每个检测框的交并比判定是否为同一轨迹,对同一轨迹的目标设置相同的轨迹关联信息,作为时序上的关联。

存储目标从起始帧到当前帧的轨迹信息,包括轨迹的编号、起始帧、持续帧数和锚点框尺寸。

每检测一帧,则通过计算交并比来判定上下2帧距离相近的检测框是否为同一目标轨迹,若当前帧检测到的与上一帧某一目标检测框交并比大于一定阈值,则判定为同一轨迹,赋予相同轨迹信息。若交并比小于一定阈值,判定为不同目标轨迹,赋予不同轨迹信息。当SAR目标比较集中时,可能当前帧存在多个目标与上一帧同一个检测框有较大的重合部分,则在其中选择交并比最大的目标作为轨迹延续。若对于上一帧的某一目标,在当前帧未能找到与其重合部分较大的检测框,说明该目标未被检测到或已离开。若当前帧存在目标未被检测到则在后面的几帧会再次出现,因此需要对这些消失的轨迹进行记录。对于所有中断的轨迹,若连续8帧未检测出能够与其连接的目标,则判定该目标已从当前视频中离开,从存储中断轨迹的字典结构中移除。

对于当前帧初始化后新出现的轨迹,与所有被记录的消失轨迹最后一帧进行判定,两两之间距离小于像素阈值且距离最短的判定为同一条轨迹。对于当前帧初始化后新出现的轨迹,若不存在消失轨迹与其距离相近,则判定为新的轨迹。真实阴影目标的运动具有连续性,若轨迹只出现了1或2帧,即长度小于3帧,则判定该轨迹不具有连续性,将其轨迹信息剔除。

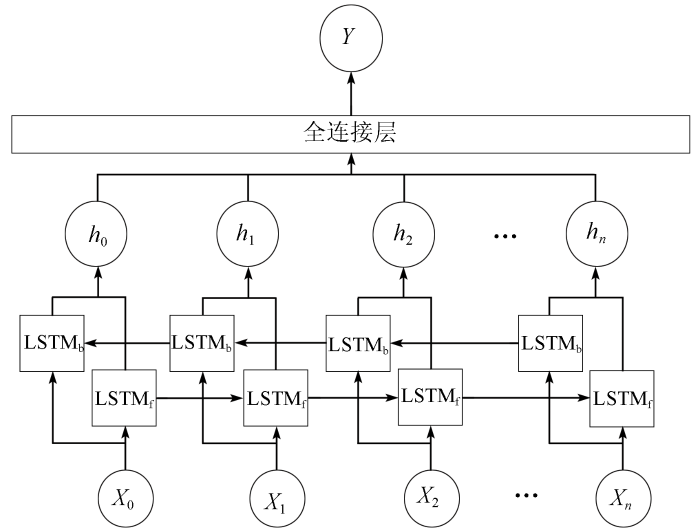

1.5 基于Bi-LSTM网络的同步目标轨迹预测

Bi-LSTM是一种双向的长短期记忆网络(long-short term memory,LSTM),它同时考虑了时序的正向信息和反向信息。该网络由一个前向时序传播层LSTMf和一个反向时序传播层LSTMb组成。通过正向与反向循环神经网络获得每个时间节点的权重ht,最后由一个全连接层合并所有权重得到输出Y。Bi-LSTM结构如图5所示。因此在本项目的框架中,采用Bi-LSTM抑制漏报,每检测一帧则对当前帧的检测框同步进行跟踪。

图5

本文使用一个包含2K+1个单元的隐藏层,每个单元由50个神经元组成,形成从第n-k帧到第n帧的传播链。而第n帧缺失的阴影目标的预测即第(K+1)个单元的输出,由前K帧到当前帧的K个单元对应K个中心点坐标并在最后通过全连接层生成缺失目标的预测坐标。在训练阶段,采用预测中心点坐标与真实中心点坐标间的欧氏距离来构建损失函数loss, 定义为:

式中: N为迭代次数;

当第m帧有轨迹消失时,根据前n帧中心点坐标值,对当前目标中心点坐标进行预测,若第m+1帧该轨迹仍未出现,则结合前一帧预测的值继续预测当前帧,连续往后预测3帧,若第m+2帧目标仍没有出现则判定该目标消不再出现。若目标出现则停止预测,若目标连续3帧未出现则表明该目标可能已经离开,不再进行预测。

2 实验

本文提出的目标跟踪方法包含检测和轨迹关联2个部分,为了验证该方法的实验效果,首先使用单张SAR图片对检测功能进行测试,然后再在Sandia视频数据上测试跟踪效果。这样做的另一个好处是利用迁移学习的技术弥补了视频SAR数据公开样本不足的缺陷。

2.1 样本集的构建

以我国国产高分三号SAR数据和Sentinel-1 SAR数据为主数据源。高分三号的成像模式是Strip-Map (UFS),Fine Strip-Map 1 (FSI),Full Polarization 1 (QPSI),Full Polarization 2(QPSII)和Fine Strip-Map 2 (FSII)。这5种成像模型的分辨率分别为3 m,5 m,8 m,25 m和10 m。Sentinel-1的成像模式是条带模式(S3和S6)和宽幅成像模式,SAR舰船目标尺寸信息见表1。共采用102景高分三号和108景Sentinel-1 SAR图像构建高分辨率SAR舰船目标深度学习样本库。这些影像拍摄时的入射角大多在20°~50°之间。目前,该深度学习样本库包含43 819舰船切片。

表1 SAR舰船目标尺寸情况

Tab.1

| 面积尺寸/像素 | 舰船目标数量/个 |

|---|---|

| 0×0~8×8 | 269 |

| 8×8~16×16 | 3 231 |

| 16×16~32×32 | 25 302 |

| 32×32~64×64 | 20 842 |

| 64×64~128×128 | 1 209 |

| 128×128~n×n | 32 |

| 合计 | 50 885 |

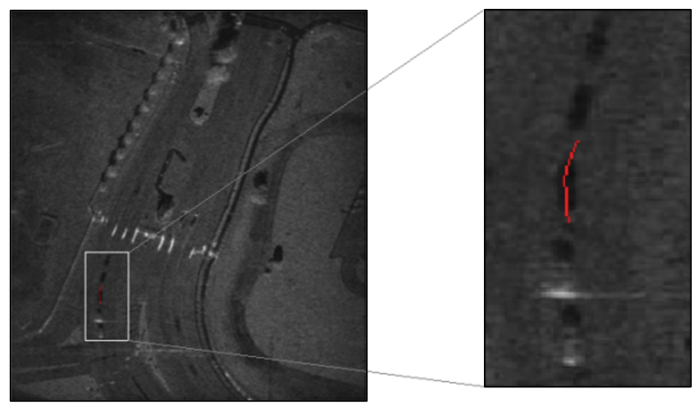

Sandia视频影像由美国桑迪亚国家实验室提供,本文选择了其中的柯特兰空军基地大门的一段影像。视频显示车辆从各个方向通过大门。沿着道路移动的阴影总是在车辆的实际物理位置。当车辆停止时,车辆的反射能量落在阴影的顶部。一旦车辆继续行驶,影子就再次可见。在屏幕上移动的线是由移动的车辆引起的多普勒频移。该段视频有效帧数为714,每帧影像分辨率为640像素×368像素,使用DarkLable对Sandia视频影像车辆标注目标框和id信息,总共标记了48条车辆轨迹,共5 020个包含时序信息的锚点框数据,最长轨迹为222帧,最短轨迹为43帧。Sandia阴影目标尺寸信息见表2。

表2 Sandia阴影目标尺寸情况

Tab.2

| 尺寸/像素 | 阴影目标数量/个 |

|---|---|

| 0×0~8×8 | 0 |

| 8×8~16×16 | 1 374 |

| 16×16~16×16 | 4 041 |

| 32×32~16×16 | 5 |

| 64×64~n×n | 0 |

| 合计 | 5 020 |

2.2 参数设置

为确保实验公正性,所有对比试验都采用同样的超参数。根据目前计算机视觉领域对于目标检测任务中CNN网络的通用方法,训练前50k次学习率为0.002,后25k为0.000 2,最后25k为0.0000 2。权重衰减和动量系数分别为0.000 1和0.9,选择的优化算法是动量优化。

鉴于遥感影像目标具有朝向随机、大纵横比的特点会导致候选区域交并比 (intersection over union, IoU)值不稳定,将正样本IoU阈值为0.5,以保证后续的目标检测有充足的正样本。对测试集的定量评估采用准确率、召回率和F1指标3个指标。

此外,针对不同的数据集,由于目标尺寸分布的不同,将构建不同的特征金字塔结构。本研究针对中科院舰船目标样本集的多尺度特征金字塔构建及锚点框参数设定如表3所示。

表3 中科院舰船目标样本集的多尺度特征金字塔构建(像素×像素)

Tab.3

| 特征金字塔层级 | 尺寸设定 |

|---|---|

| 1 | 42 |

| 2 | 82 |

| 3 | 162 |

| 4 | 322 |

| 5 | 642 |

| 6 | 1282 |

本研究针对Sandia阴影目标样本集的多尺度特征金字塔构建及锚点框参数设定如表4所示。

表4 Sandia阴影目标样本集的多尺度特征金字塔构建(像素×像素)

Tab.4

| 特征金字塔层级 | 尺寸设定 |

|---|---|

| 1 | 102 |

| 2 | 202 |

| 3 | 402 |

2.3 数据增强

图6

图7

图8

数据增强是计算机视觉领域用于增强模型鲁棒性和泛化性的重要手段,本研究主要采用平移、亮度调节(亮、暗)、随机噪声、中值滤波、水平垂直翻转、旋转(45°,90°,135°,180°,225°,270°,315°),约将整个样本库增强14倍。

2.4 中科院SAR舰船目标检测

此公开样本集主要被用于确定设计的EfficentDet较主流Faster R-CNN具有更强的适应性,并探究不同的热门特征提取网络之间的差异性。在评估时,本文设定预测概率大于0.75,IoU>0.5的目标为模型正确检测目标。本文方法及其他常用对比方法的定量评价检测结果如表5所示。

表5 目标检测定量评价结果比较

Tab.5

| 网络模型 | 准确率 | 召回率 | F1指标 |

|---|---|---|---|

| FasterR-CNN | 95.68 | 81.82 | 88.21 |

| 特征金字塔网络 | 95.70 | 86.46 | 90.85 |

| RetinaNet | 96.98 | 88.12 | 92.34 |

| 轻量EfficentDet | 98.08 | 90.23 | 93.99 |

| 多特征输入+轻量EfficentDet | 98.35 | 91.08 | 94.58 |

本研究方法在准确率、召回率和F1这3项定量指标上分别达到98.35%,91.08%和94.58%的最优精度。具体表现如图9所示,从测试集中选取多种场景切片进行目视解译,其中包含像元数量小于102的小尺度目标,包含像元数量大于1 282的大尺度目标,介于其间的中尺度目标,及复杂背景下的船舶目标(建筑物、港口等虚警目标影响)。红色框表示船舶检测结果。

图9

2.5 Sandia视频SAR阴影目标检测

通过中科院SAR舰船目标样本集的对比实验,确定了本研究设计的EfficentDet模型对复杂场景下的多尺度目标具有较好的检测性能。根据Sandia官方的说明,Sandia视频SAR影像上沿着道路移动的阴影总是在车辆的实际物理位置。基于以上结论,将此模型应用到Sandia视频SAR影像上进行阴影目标检测,并探索SAR特征增强后的多特征输入为阴影目标检测带来的促进效果,进而完成最终的视频目标检测及跟踪。与上文类似,在评估时,设定预测概率大于0.75,IoU>0.5的目标为模型正确检测目标。本文方法及其他常用对比方法的定量评价检测结果如表6所示。

表6 阴影目标检测定量评价结果比较

Tab.6

| 网络模型 | 准确率 | 召回率 | F1指标 |

|---|---|---|---|

| Faster RCNN | 90.11 | 89.65 | 89.88 |

| 特征金字塔网络 | 92.44 | 92.26 | 92.35 |

| RetinaNet | 96.99 | 94.39 | 95.67 |

| 轻量EfficentDet | 97.92 | 96.37 | 97.14 |

| 多特征输入+轻量EfficentDet | 98.85 | 97.80 | 98.32 |

本研究方法多特征输入+EfficentDet在准确率、召回率和F1这3项定量指标上分别达到98.85%,97.80%和98.32%的最优结果。具体表现如图10所示,红色框表示检测结果。

图10

图10

在2个不同时刻SAR车辆目标检测可视化结果

Fig.10

Visualization of car detection results at two timesteps

EfficientDet模型受利于多尺度特征金字塔,面对多尺度的阴影目标仍然具有较好的适应性,其泛化性能得到进一步证实; SAR特征增强的多特征输入对已经取得优异精度的模型进一步提供了帮助,实质是阴影特征得到了增强,比如轮廓更加清晰,与背景的差异更大。这较好地改善了单特征输入时,因阴影目标速度过快、目标SAR反射强度信号不明显而导致的漏检现象。此外,目标等红绿灯与灯架下方静止时,多特征输入亦能起到促进作用。

2.6 Sandia视频SAR阴影目标跟踪

设计多目标跟踪实验,用于研究跟踪模型在考虑轨迹关联信息的条件下,对多个SAR目标同步跟踪的效果。

基于Bi-LSTM网络的同步目标轨迹预测结果如图11所示,在第n帧对漏警目标进行了预测,其中蓝色为正确检测的锚点框,红色为使用Bi-LSTM网络通过前5帧对第n帧漏警目标进行预测的锚点框。从图中可以看出,引入Bi-LSTM网络带来2个优点: ①对于大部分目标而言,Bi-LSTM网络预测的结果与实际检测器检测的结果高度重合,这可以进一步用于辅助判定检测结果的正确性; ②虽然第n帧左下角有一个目标被漏检了,但是Bi-LSTM网络能正确地预测出该目标的实际位置,对检测器的错误进行了有效的补充。

图11

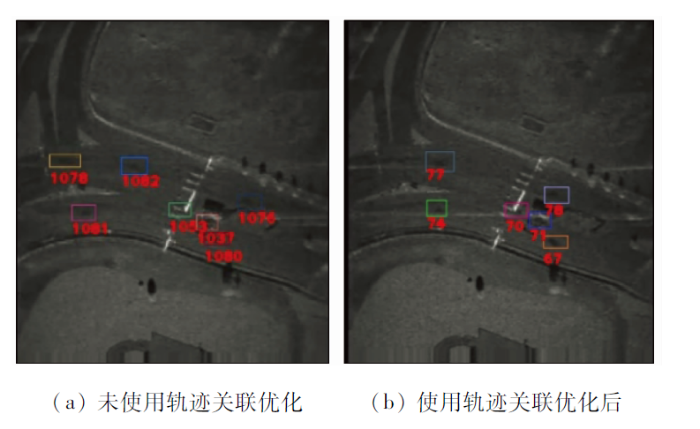

将IoU=0.5作为轨迹初始化时的判定标准,将所有帧下的目标检测与跟踪结果合并为视频,对比仅通过IoU判定轨迹关联和添加了跟踪模块后的跟踪结果,可以观察到仅通过IoU判定轨迹关联标准没有添加跟踪模块时,轨迹信息会不稳定的快速变化,总共检测到了1 092条轨迹,对轨迹信息进行优化后的目标轨迹相对稳定,不会产生过多错误的轨迹关联信息,总共检测到78条轨迹,轨迹的优化减少了大量错误的轨迹关联信息。造成这一结果的原因主要是通过引入Bi-LSTM网络,降低了目标的漏检率,减少了轨迹的中断次数,进而抑制了目标编号的错误增长。图12为轨迹关联优化前(左)和轨迹关联优化后(右)的同一帧图像。

图12

通过计算多目标跟踪精度(multiple object tracking accuracy,MOTA),识别准确率(identification prescision,IDP)识别召回率(identification recall,IDR)和识别F1指标(IDF1)这4个指标评估多目标跟踪准确度,结果如表7所示。在此仅通过IoU判定轨迹关联和通过不同跟踪模型预测轨迹关联的结果。MOTA 用于确定多目标跟踪的准确度,能体现出轨迹id的稳定性。IDP,IDR和IDF1用于体现多目标跟踪轨迹信息的正确率。IDP表示检测到的所有目标中,正确识别到且轨迹信息正确的目标所占比例。IDR表示所有真值目标中,正确识别到且轨迹信息正确的目标所占比例。IDF1是IDP和IDR加权平均得到的结果。这些指标均越大越好。

表7 多目标跟踪评价结果比较

Tab.7

| 跟踪模块 | MOTA | IDP | IDR | IDF1 |

|---|---|---|---|---|

| IoU=0.5 | 73.3 | 26.1 | 25.2 | 25.5 |

| 轨迹优化+LSTM | 90.5 | 81.9 | 80.3 | 81.1 |

| 轨迹优化+Bi-LSTM | 91.0 | 82.1 | 80.5 | 81.3 |

3 结论

本文分别采用多通道特征图对SAR图像进行特征增强,同时构建了改进型多尺度特征金字塔对不同尺寸的SAR特征进行特征融合,进一步提升了算法对于SAR图像目标特征表达的能力。在检测阶段,采用EfficientDet网络进行语义特征提取,能够提取到更深层的特征,并引入Bi-LSTM网络对目标检测产生的虚警目标进行轨迹关联优化和预测。通过在中科院SAR舰船目标样本集下的目标检测实验和美国Sandia国家实验室的SAR车辆目标样本集上的目标检测与跟踪实验,验证了本研究设计的模型在复杂场景下进行视频SAR多尺度目标检测与多目标跟踪时,能有效抑制漏检和误检,同时避免轨迹编号的错误增加,具有更好的效果。

参考文献

Developments in SAR and IFSAR systems and technologies at Sandia National Laboratories

[C]//

Video SAR high-speed processing technology based on FPGA

[C]//

视频SAR成像与动目标阴影检测技术

[J].

Focusing algorithms and moving target detection based on video SAR

[J].

一种基于自适应背景杂波模型的宽幅SAR图像CFAR舰船检测算法

[J].

New CFAR ship detection algorithm based on a daptive back-ground clutter model in wide swath SAR images

[J].

Detecting cars in VHR SAR images via semantic CFAR algorithm

[J].DOI:10.1109/LGRS.2016.2546309 URL [本文引用: 1]

Improved SAR target detection via extended fractal features

[J].DOI:10.1109/7.937460 URL [本文引用: 1]

基于指数小波分形特征的SAR图像特定目标检测

[J].

Special target detection of the SAR image via exponential wavelet fractal

[J].

Search area reduction Fast-RCNN for fast vehicle detection in large aerial imagery

[C]//

Ship detection in SAR images based on an improved Faster R-CNN

[C]//

Ship detection with SAR based on YOLO

[C]//

Contextual region-based convolutional neural network with multilayer fusion for SAR ship detection

[J].

DOI:10.3390/rs9080860

URL

[本文引用: 1]

Synthetic aperture radar (SAR) ship detection has been playing an increasingly essential role in marine monitoring in recent years. The lack of detailed information about ships in wide swath SAR imagery poses difficulty for traditional methods in exploring effective features for ship discrimination. Being capable of feature representation, deep neural networks have achieved dramatic progress in object detection recently. However, most of them suffer from the missing detection of small-sized targets, which means that few of them are able to be employed directly in SAR ship detection tasks. This paper discloses an elaborately designed deep hierarchical network, namely a contextual region-based convolutional neural network with multilayer fusion, for SAR ship detection, which is composed of a region proposal network (RPN) with high network resolution and an object detection network with contextual features. Instead of using low-resolution feature maps from a single layer for proposal generation in a RPN, the proposed method employs an intermediate layer combined with a downscaled shallow layer and an up-sampled deep layer to produce region proposals. In the object detection network, the region proposals are projected onto multiple layers with region of interest (ROI) pooling to extract the corresponding ROI features and contextual features around the ROI. After normalization and rescaling, they are subsequently concatenated into an integrated feature vector for final outputs. The proposed framework fuses the deep semantic and shallow high-resolution features, improving the detection performance for small-sized ships. The additional contextual features provide complementary information for classification and help to rule out false alarms. Experiments based on the Sentinel-1 dataset, which contains twenty-seven SAR images with 7986 labeled ships, verify that the proposed method achieves an excellent performance in SAR ship detection.

An improved Faster R-CNN based on MSER decision criterion for SAR image ship detection in harbor

[C]//

DRBox-v2:An improved detector with rotatable boxes for target detection in SAR images

[J].DOI:10.1109/TGRS.36 URL [本文引用: 1]

全卷积神经网络应用于SAR目标检测

[J].

Target detection based on fully convolutional neural network for SAR images

[J].

Preliminary research of low-RCS moving target detection based on Ka-band video SAR

[J].DOI:10.1109/LGRS.2017.2679755 URL [本文引用: 1]

Shadow tracking of moving target based on CNN for video SAR system

[C]//

A new shadow tracking method to locate the moving target in SAR imagery based on KCF

[C]//

Tracking of moving target based on SiamMask for video SAR system

[C]//

Approach to moving targets shadow detection for video SAR

[J].

Moving-target tracking in single-channel wide-beam SAR

[J].DOI:10.1109/TGRS.2012.2191561 URL [本文引用: 1]

Moving target tracking in single-and multichannel SAR

[J].DOI:10.1109/TGRS.2014.2369060 URL [本文引用: 1]

Video SAR moving target indication using deep neural network

[J].DOI:10.1109/TGRS.36 URL [本文引用: 1]

Robust shadow tracking for video SAR

[J].DOI:10.1109/LGRS.2020.2988165 URL [本文引用: 1]

一种稳健的视频SAR动目标阴影检测与跟踪处理方法

[J].

A robust moving target shadow detection and tracking method for VideoSAR

[J].

基于长时间间隔序贯SAR图像的运动舰船跟踪方法

[J].

Moving ship tracking method based on long time interval sequential SAR images

[J].

Feature pyramid networks for object detection

[C]//

EfficientDet:Scalable and efficient object detection

[C]//