0 引言

无人机载视频运动目标检测跟踪是计算机视觉领域的重要研究内容之一,已广泛应用于战场动态监测、目标侦察与打击、智能交通、灾害预警以及城市调查等军事和民用领域。无人机在获取地面目标的过程中往往存在抖动现象,同时无人机自身也在快速运动,这些因素导致了无人机视频中地面背景的不断变化,从而增加了运动目标检测跟踪的难度。

无人机视频运动目标检测跟踪是一种动态场景下的运动目标检测跟踪,是计算机视觉领域的研究重点和难点。针对动态场景下的运动目标检测跟踪,众多研究学者展开了大量的研究工作,如简单的两帧差分及其改进方法(如三帧差分)[1,2],基于区域匹配的方法[3],基于光流技术的方法[4,5,6]以及基于快速区域卷积神经网络(faster region-based convolutional neural networks,Faster R-CNN)[7]、SSD(single shot multibox detector, SSD)[8]、YOLO(you only look once, YOLO)[9]等深度学习方法。在这些方法中,帧差法及其改进方法计算效率较高,但精度较低; 基于区域匹配的方法往往需要目标的先验知识; 基于光流技术的方法计算效率较低; 基于深度学习的方法需要大量的样本来训练模型,精度较高但效率较低。在无人机视频运动目标检测跟踪方面,国内外学者也开展了大量的研究工作,任霞[10]提出了改进核相关滤波跟踪方法和改进LK光流进行无人机视频运动目标跟踪; 针对目标变形和遮挡问题,陈挺[11]提出了基于动态稀疏投影与目标外观模型、目标外观概率模型优化以及多层数据关联目标跟踪方法; 针对目标检测跟踪实时性的问题,董晶等[12]提出了基于特征匹配的运动目标检测法。在无人机视频运动目标检测跟踪的广泛应用中,运动目标检测的准确性和实时性是非常重要的一个因素,如在战场目标动态监测过程中,战场态势稍纵即逝,如不能及时发现、跟踪目标,很可能将失去战斗的意义。因此,对于在线实时的无人机视频运动目标检测跟踪,还有待更进一步的研究和完善。

针对无人机载视频运动目标检测准确性和实时性的问题,本文提出了一种基于特征的无人机载视频运动目标快速检测方法,采用ORB特征提取(oriented fast and rotated BRIEF, ORB)和渐进一致采样(progressive sample consensus, PROSAC)精匹配算法进行全局运动估计和运动补偿,然后采用帧差法和自适应形态学操作进行运动目标检测,检测精度和效率较高,能够满足实时处理需求。

1 研究方法

本文所提方法的基本思路是: 首先,对获取的视频序列影像进行直方图均衡化等亮度归一化预处理,并利用ORB算法进行特征提取,在常用匹配方法的基础上采用PROSAC精匹配剔除错误匹配; 然后,采用六参数模型根据最小二乘原理进行全局运动估计与运动补偿,将补偿后的序列影像采用帧差法进行运动目标初检测; 最后,通过形态学操作等后处理实现最终的运动目标检测。本文所提方法的处理流程如图1所示。

图1

1.1 ORB特征提取与匹配

ORB[13]特征检测算法采用改进的FAST关键特征点检测和改进的BRIEF特征描述子进行关键特征检测,具有尺度和旋转不变性,且检测效率优于传统的Harris,SIFT(scale-invariant feature transform,SIFT)以及SURF(speeded up robust features, SURF)等特征检测方法,可应用于实时特征检测场景中。

1.1.1 FAST关键特征点检测

FAST关键特征点检测[14]的基本思路是以影像中某一像素点(候选特征点)为基准,计算该候选特征点与其周围像素点(一般为16个点)的图像灰度差值,如果周围邻域内有足够多的像点满足下式的阈值要求,则认为该候选特征点为一个特征点,即

式中:

图2

1.1.2 BRIEF特征描述符

BRIEF特征描述符[15]是一种二进制描述符,其核心思想是从关键点p周围随机选取N个点对(一般为128个点对),然后计算每个点对中前一个点与后一个点的灰度差值,如果大于0,则取值为1,如果小于等于0,则取值为0。其公式为:

式中:

当计算完所有点对的T值后,生成一个128维的二进制编码,该编码即为该特征点的特征描述符。在得到特征描述符后,可用简单的汉明距离实现特征匹配。然而,常用的BRIEF特征描述符在进行特征匹配时不具备旋转不变性,造成了大量的误匹配,针对该问题,ORB方法采用具有旋转不变性的改进方法——rBRIEF特征描述符。

1.1.3 特征匹配

特征匹配的方法很多,最简单的是距离匹配法,包括汉明距离和暴力匹配器。

汉明距离匹配法是计算2个特征点特征描述符(二进制编码字符串)对应位置不同的字符个数,若相差个数越少,则距离越近,即为特征匹配点。暴力匹配器是计算某一个特征点描述符与其他所有特征点描述符之间的距离,取距离最小的特征点作为匹配点。汉明距离法和暴力匹配器方法简单,计算效率高,但是往往存在大量的错误匹配,因此需要采用一定的方法消除错误匹配。

1.2 PROSAC特征精匹配

式中β为最小距离

1.3 全局运动估计与运动补偿

无人机搭载的视频传感器的运动引起了视频序列影像的全局背景位移,视频传感器的位置和姿态的变化可以分解为传感器的平移和旋转。相应地在二维图像平面上,图像上的任一像素点

式中:

式(5)称为运动估计的六参数模型。在完成特征提取和匹配后,利用至少3个特征点对根据最小二乘原理进行模型参数解算,当解算出参数模型中的6个参数

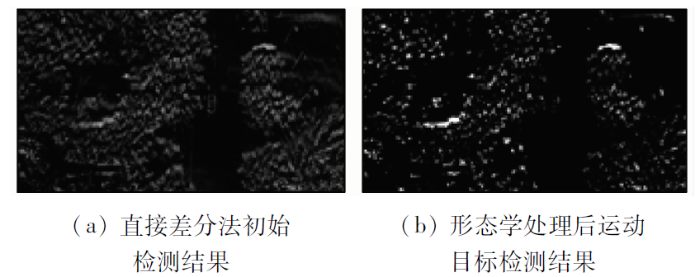

1.4 运动目标的检测

经过全局运动补偿后,消除了无人机视频序列影像背景的位移,直接采用帧差法进行运动目标的检测。设

式中:

在实际情况下,由于受光照、风以及噪声等外界因素的干扰,帧差法所得结果并不能完全消除序列影像的背景位移,往往存在背景噪声等影响。为了消除该影响,本文采用形态学滤波操作,对运动目标初始检测结果进行后处理,进而得到最终的运动目标。

2 实验与分析

采用2组真实无人机载视频数据进行实验,实验内容包括运动目标检测结果和计算效率2部分内容,计算效率实验未采用图形处理器(graphics processing unit,GPU)进行加速计算。实验硬件环境为16 G内存,i9处理器,64位操作系统,软件环境为Python3.6和OpenCV3.4.2。

2.1 实验数据

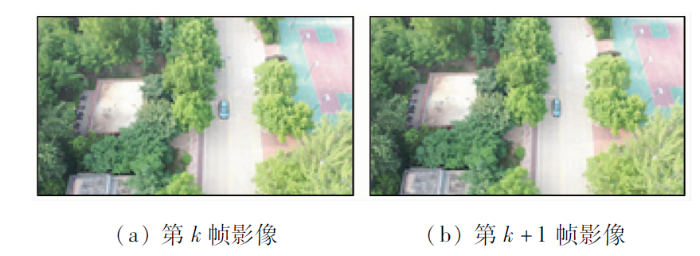

实验采用2组数据: 数据一为大疆御2商用无人机获取的地面车辆运动目标视频,视频图像大小为3 840像素×2 160像素,帧率为30帧/s,视场中树木较多,容易受光照和噪声等影响。采用连续2帧影像(图3)进行运动估计和运动目标检测实验。

图3

数据二为某型无人飞艇获取的地面车辆目标视频序列影像,图像大小为305像素×245像素,帧率为25帧/s。由于飞行高度较高,视场范围较大,运动目标较小,给运动目标检测带来一定的困难。其连续2帧原始视频序列影像如图4所示。

图4

2.2 运动目标检测实验结果与分析

图5

图6

图7

图8

图8

数据一原始影像帧差法运动目标检测结果

Fig.8

Results of moving target detection by original image frame using difference method of data 1

图9

图9

数据一本文所提方法运动目标检测结果

Fig.9

Result of moving target detection results of the proposed method of data 1

图10

图11

图12

图13

图13

数据二原始影像帧差法运动目标检测结果

Fig.13

Results of moving target detection by original image frame using difference method of data 2

图14

图14

本文所提方法运动目标检测结果

Fig.14

Result of moving target detection results of the proposed method

分析以上2组实验结果,可以得出如下结论:

2.3 运动目标检测效率实验与分析

由于SIFT和SURF算法特征检测精度较高而得到广泛应用,因此本节主要将基于ORB特征提取的运动目标检测与基于SIFT和SURF特征提取的运动目标检测计算效率进行对比分析,2组数据的实验结果如表1所示,表中数据为运行10次的平均值。

表1 运动目标检测效率

Tab.1

| 方法 | 时间 | |

|---|---|---|

| 数据一 | 数据二 | |

| SIFT+RANSAC | 132.530 | 0.078 |

| SIFT+PROSAC | 134.030 | 0.093 |

| SURF+RANSAC | 23.750 | 0.047 |

| SURF+PROSAC | 23.690 | 0.047 |

| ORB+RANSAC | 0.344 | 0.016 |

| ORB+PROSAC | 0.344 | 0.016 |

分析表1的实验结果,可以得出如下结论:

1)运动目标检测的效率与视频序列影像大小有一定关系,通常情况下: 影像尺寸越大,计算时间越长,效率越低; 影像尺寸越小,计算时间越短,效率越高。

2)基于SIFT和SURF特征提取的运动目标检测计算时间明显高于基于ORB特征提取运动目标检测方法。

3)对于帧率为30帧/s的数据一,ORB基本能够实现实时处理需求; 对于帧率为25帧/s的数据二,ORB能够较好满足实时处理需求。

综合上述实验结果,可以得出: 本文所提基于ORB特征的无人机载视频运动目标检测方法的运动目标检测效果较好,计算效率较高,通用性较强,能够满足实时处理需求。

3 结论

本文针对动态场景下无人机载视频序列影像检测精度不高、计算效率较低的问题,提出了基于ORB特征的无人机载视频运动目标检测方法。该方法首先采用直方图均衡化进行亮度归一化预处理,在此基础上采用ORB特征提取和PROSAC精匹配方法进行前后两帧影像匹配,再采用六参数模型进行视频序列影像背景的全局运动估计和运动补偿,最后采用帧差法和形态学操作进行运动目标检测。通过2组不同无人机载视频传感器获取的地面运动车辆数据进行实验,实验结果表明:

1)利用ORB特征提取后再进行PROSAC精匹配的方法,可实现相邻两帧无人机视频序列影像高精度配准。

2)本文所提方法能够实现动态场景下不同尺寸运动目标的检测,检测效果较好,算法通用性较强。

3)本文所提方法计算效率优于基于SIFT和SURF特征提取的运动目标检测方法,且计算时间基本满足无人机视频实时处理需求。

同时在本文研究过程中还存在一定不足之处: 一是未采用GPU并行计算来处理更大尺寸的无人机视频数据; 二是没有考虑运动目标的遮挡。这些问题是无人机视频运动目标检测跟踪的重点和难点内容,有待进一步研究。

参考文献

A new interframe difference algorithm for moving target detection

[C]//

基于背景和帧间差分法的运动目标提取

[J].

Moving object extraction based on background difference and frame difference method

[J].

Moving-object detection method for moving cameras by merging background subtraction and optical flow methods

[C]//

基于光流分析的无人机视频运动目标检测与跟踪

[D].

UAV video moving target detection and tracking based on optical flow analysis

[D].

基于全局运动估计补偿的目标检测算法研究

[D].

Research on target detection algorithm based on global motion estimation and compensation

[D].

基于深度卷积神经网络的运动目标检测方法

[J].

Moving object detection based on deep convolutional neural network

[J].

Faster R-CNN:Towards real-time object detection with region proposal networks

[J].DOI:10.1109/TPAMI.2016.2577031 URL [本文引用: 1]

You only look once:Unified,real-time object detection

[C]//

SSD:Single shot multi-box detector

[C]//

基于无人机视频的运动目标检测与跟踪方法研究

[D].

Research of detection and tracking based on the moving targets in UAV video

[D].

无人机对地运动目标跟踪技术研究

[D].

Moving objects tracking in aerial videos

[D].

无人机视频运动目标实时检测及跟踪

[J].

Real-time moving object detection and tracking by using UAV videos

[J],

ORB:An efficient alternative to SIFT or SURF

[C]//

Adaptive and generic corner detection based on the accelerated segment test

[C]//

BRIEF:Binary robust independent elementary features

[C]//

Random sample consensus:A paradigm for model fitting with applications to image analysis and automated cartography

[J].

Matching with PROSAC—Progressive Sample Consensus

[J].